2025最新Chatbox接入DeepSeek完全指南:三种方法轻松配置【保姆级教程】

【亲测可用】想在Chatbox中使用DeepSeek却不知如何配置?本文提供三种详细教程:硅基流动API、API易接口和Ollama本地部署,从注册到使用仅需3分钟,小白也能轻松上手!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Chatbox接入DeepSeek完全指南:三种方法轻松配置【2025最新】

{/* 封面图片 */}

随着国产大语言模型DeepSeek的崛起,越来越多的用户希望通过功能丰富的Chatbox客户端来使用这一强大模型。然而,很多人在配置过程中遇到困难,不知道如何正确连接这两个工具。

本文将为您提供三种完整的Chatbox接入DeepSeek方法,无论您是追求简单配置的小白用户,还是注重隐私的技术爱好者,都能找到适合自己的解决方案。每种方法都配有详细的步骤说明和图示,确保您能在最短时间内完成配置。

🔥 2025年3月最新更新:本文所有方法均经过实测,完全适用于DeepSeek最新版本和Chatbox最新客户端,3分钟即可完成配置!

为什么选择Chatbox + DeepSeek组合?

在开始具体配置前,我们先来了解为什么Chatbox + DeepSeek是一个值得推荐的组合:

Chatbox的优势

- 全平台支持:Windows、macOS、Linux、网页版全覆盖

- 开源免费:基础功能完全免费,源代码开放透明

- 界面友好:交互设计简洁直观,新手容易上手

- 多模型支持:可同时接入多个AI模型,一个客户端满足所有需求

- 丰富功能:支持提示词管理、历史对话、图像理解等高级功能

DeepSeek的优势

- 强大性能:在多个基准测试中表现优异,接近甚至超越部分国际模型

- 中文优化:针对中文进行了专门优化,理解和生成能力出色

- 开源可控:核心技术开源,社区活跃,持续进步

- 本地部署:支持本地部署,保护隐私,摆脱网络限制

- 多种规模:提供不同参数规模的模型版本,满足不同硬件条件

【方法一】硅基流动API:最简单稳定的接入方式

硅基流动是DeepSeek官方授权的API服务提供商,通过华为云提供稳定的模型访问服务。这是最简单、最稳定的接入方式,特别适合对技术不太了解的用户。

步骤1:注册硅基流动账号

- 访问硅基流动官网,点击右上角的"注册/登录"

- 使用手机号或邮箱完成注册流程

- 登录到您的账户

步骤2:充值账户

- 在用户中心找到"充值"选项

- 选择适合您的充值套餐(最低10元起充)

- 使用微信或支付宝完成支付

步骤3:获取API密钥

- 在左侧菜单找到"API管理"或"个人中心"

- 创建一个新的API密钥,或使用默认密钥

- 复制API密钥(以sk-开头的字符串)

步骤4:配置Chatbox

- 下载并安装最新版Chatbox

- 打开Chatbox,点击左下角的"设置"图标

- 在模型提供商中选择"硅基流动"

- 粘贴您刚才复制的API密钥

- API基础URL填写:

https://api.guiji.ai/v1 - 选择DeepSeek模型(通常是deepseek-v3)

- 点击"保存",然后测试连接

费用参考

硅基流动采用按量计费模式,DeepSeek-V3模型约0.002元/1K tokens,普通用户每月使用成本在20-100元之间,具体取决于使用量。

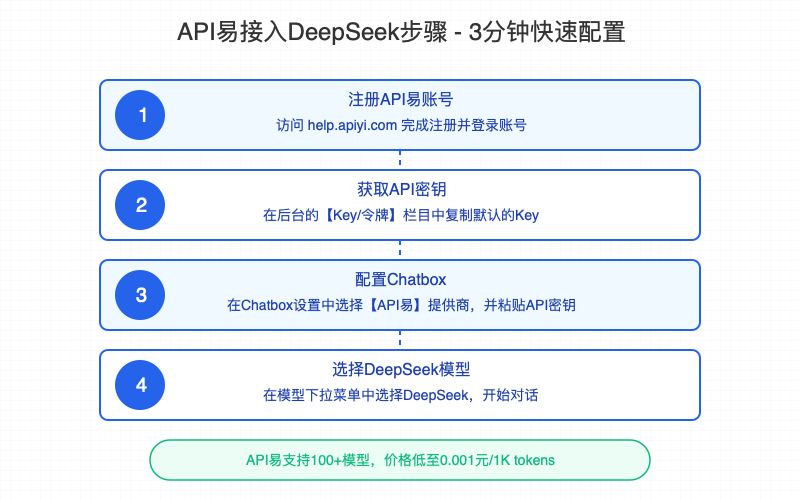

【方法二】API易接口:价格更低的选择

API易是另一个提供DeepSeek接口的第三方服务商,其特点是价格更低,同时支持100多种AI模型,是预算有限用户的理想选择。

步骤1:注册API易账号

- 访问API易官网,完成注册

- 使用邮箱或手机号验证登录

步骤2:获取API密钥

- 登录后,进入后台的【Key/令牌】栏目

- 复制默认的Key(无需新建,也不需要设置可用模型,默认支持所有模型)

步骤3:配置Chatbox

- 打开Chatbox客户端,进入设置页面

- 在模型提供商中选择"API易"

- 粘贴您的API密钥

- 保存设置

步骤4:选择DeepSeek模型

- 回到聊天界面

- 在模型选择下拉菜单中找到并选择"DeepSeek"

- 开始对话使用

费用优势

API易的价格比硅基流动更低,DeepSeek模型调用价格低至0.001元/1K tokens,同时支持100+种AI模型,一个账号可以体验多种不同的AI。

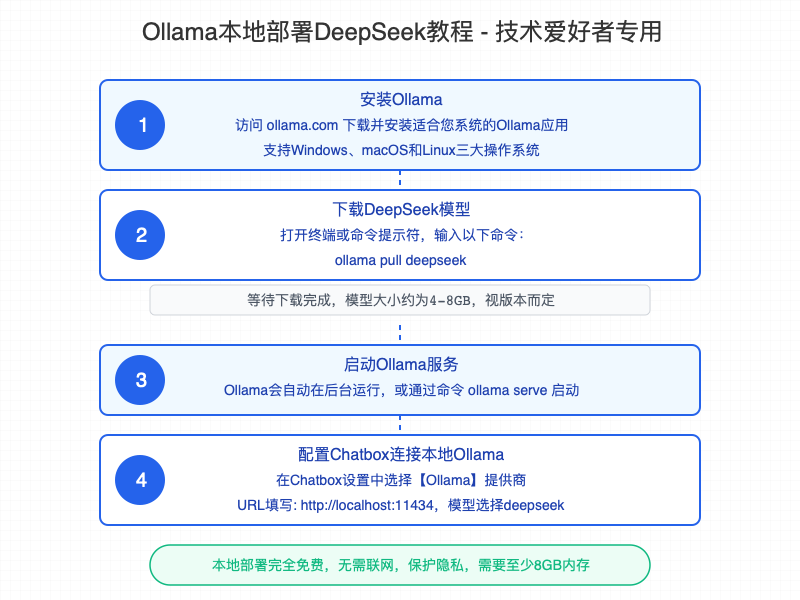

【方法三】Ollama本地部署:免费且保护隐私

如果您有一定的技术基础,并且拥有性能不错的电脑(最好有独立显卡),可以考虑使用Ollama在本地部署DeepSeek,这样可以完全免费使用,且不会将您的对话内容传输到外部服务器。

步骤1:安装Ollama

- 访问Ollama官网,下载适合您系统的安装包

- Windows、macOS和Linux均有对应版本

- 按照指引完成安装

步骤2:下载DeepSeek模型

- 安装完成后,打开终端或命令提示符

- 输入命令:

ollama pull deepseek - 等待模型下载完成(模型大小约为4-8GB,取决于具体版本)

步骤3:启动Ollama服务

- Ollama通常会自动在后台运行

- 如果没有自动运行,可以通过命令

ollama serve启动服务

步骤4:配置Chatbox连接本地Ollama

- 打开Chatbox客户端,进入设置页面

- 在模型提供商中选择"Ollama"

- 服务器URL填写:

http://localhost:11434 - 模型选择"deepseek"

- 保存并返回聊天界面开始使用

硬件要求

- 内存:最低8GB,推荐16GB或更高

- 显卡:虽然可以使用CPU运行,但拥有NVIDIA或AMD显卡会大幅提升速度

- 存储:至少10GB可用空间用于存储模型文件

优势与注意事项

本地部署的最大优势是完全免费且保护隐私,适合处理敏感信息的场景。但需要注意,本地运行的模型性能可能不如云端服务,且会占用您的计算机资源。

常见问题与解答

Q1: 三种方法中,哪一种最适合普通用户?

A: 对于大多数普通用户,推荐使用硅基流动API方法,这种方法配置简单,性能稳定,费用适中。如果您非常在意预算,可以选择API易;如果您有技术背景且重视隐私,则可以尝试Ollama本地部署。

Q2: 在Chatbox中使用DeepSeek需要什么配置?

A: Chatbox本身对电脑配置要求不高,任何能流畅运行Windows 10/11、macOS或主流Linux发行版的电脑都可以运行。如果采用API方式,只需要有稳定的网络连接;如果选择本地部署,则建议至少有16GB内存和独立显卡。

Q3: DeepSeek模型有哪些版本?它们之间有什么区别?

A: DeepSeek主要有以下几个版本:

- DeepSeek-V3: 最新通用版本,性能最强

- DeepSeek Coder: 专为编程优化的版本

- DeepSeek-R1: 轻量级版本,更适合本地部署

不同版本在模型大小、擅长任务和资源需求上有所差异,可以根据自己的使用场景选择。

Q4: 使用API方式时,如何处理"服务器繁忙"错误?

A: 遇到服务器繁忙时,可以尝试以下方法:

- 稍等片刻后重试

- 在Chatbox设置中将"超时时间"调整为更长(如30秒)

- 尝试切换到其他模型提供商

- 参考《DeepSeek服务器繁忙完全解决方案》获取更多解决方法

Q5: 本地部署DeepSeek后,能否离线使用?

A: 是的,一旦完成下载和配置,Ollama部署的DeepSeek模型可以完全离线使用,不需要联网。这也是本地部署的一大优势。

Q6: 在Chatbox中如何同时使用多个AI模型?

A: Chatbox支持配置多个模型提供商,您可以在设置中添加多个不同的API(如同时配置硅基流动和API易),然后在聊天界面上方的下拉菜单中快速切换不同的模型。

Q7: 如何判断配置是否成功?

A: 配置成功后,在Chatbox中选择DeepSeek模型,然后发送一条简单的测试消息如"你好",如果能收到合理回复,说明配置成功。大多数API提供商也提供"测试连接"按钮,可以直接测试API连接是否正常。

实用技巧:充分发挥Chatbox+DeepSeek的潜力

提示词优化

DeepSeek对中文提示词有很好的理解能力,但使用结构化的提示可以获得更好的效果:

角色:[设定DeepSeek的角色]

任务:[明确需要完成的任务]

要求:[详细的输出要求和格式]

示例:[提供一个输出示例]

多轮对话策略

DeepSeek擅长维持多轮对话的连贯性,但建议:

- 每个对话不要超过10-15轮

- 重要信息在新对话中重复提及

- 使用Chatbox的历史记录功能保存重要对话

模型选择指南

- 日常问答:使用DeepSeek-V3标准版

- 编程相关:首选DeepSeek Coder版本

- 本地部署:配置不高的设备选择DeepSeek-R1轻量版

【总结】选择最适合您的方案

Chatbox接入DeepSeek的三种方法各有优势:

- 硅基流动API:操作最简单,稳定性高,适合大多数用户

- API易接口:价格更低,支持多种模型,适合预算有限用户

- Ollama本地部署:完全免费,保护隐私,适合技术爱好者

根据您的需求和条件,选择最适合的方案。无论选择哪种方式,Chatbox + DeepSeek的组合都能为您提供强大而流畅的AI助手体验。

在使用过程中如有任何问题,欢迎在评论区留言,我们会持续更新本文以解答常见问题并跟进最新变化。

📌 实用建议:建议至少掌握两种接入方法,以便在一种方法出现问题时能够快速切换,确保您随时都能使用DeepSeek的强大功能。

祝您使用愉快!