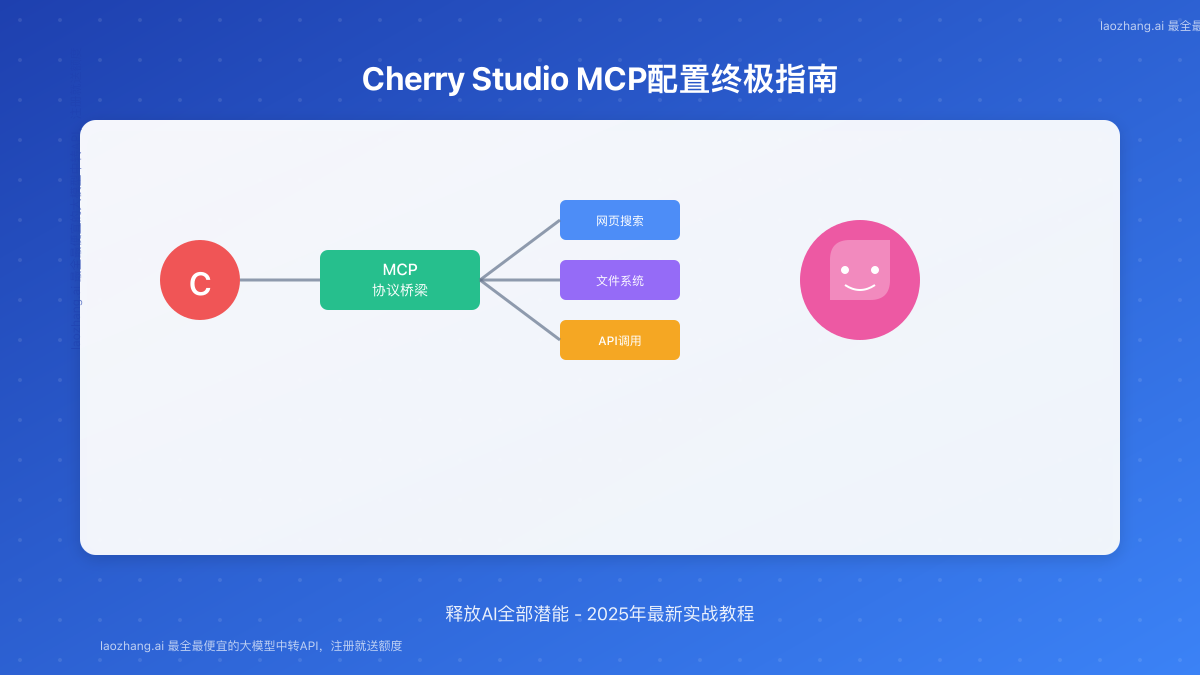

2025年Cherry Studio MCP配置终极指南:释放AI全部潜能

本文提供2025年最新、最全面的Cherry Studio MCP服务器配置教程。从环境安装到高级实战,一步步教你如何通过MCP连接外部工具(如网页搜索、文件系统),释放大语言模型的全部潜能。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

🔥 2025年6月实测有效:本指南包含截至2025年6月的最新信息和操作步骤,确保你能成功配置并使用Cherry Studio的MCP功能。

你是否觉得自己的AI助手能力有限,无法与外部世界互动?是否希望它能像一个真正的助理一样,帮你上网查资料、读本地文件,甚至调用各种API?如果答案是肯定的,那么Cherry Studio的MCP(Model-Context Protocol,模型上下文协议)功能就是你一直在寻找的答案。

MCP为大语言模型(LLM)打开了一扇通往现实世界的大门,允许它们调用外部工具来完成复杂任务。本指南将从零开始,为你提供最详尽的Cherry Studio MCP配置教程,让你彻底释放AI的潜能。

1. MCP基础:准备工作与环境安装

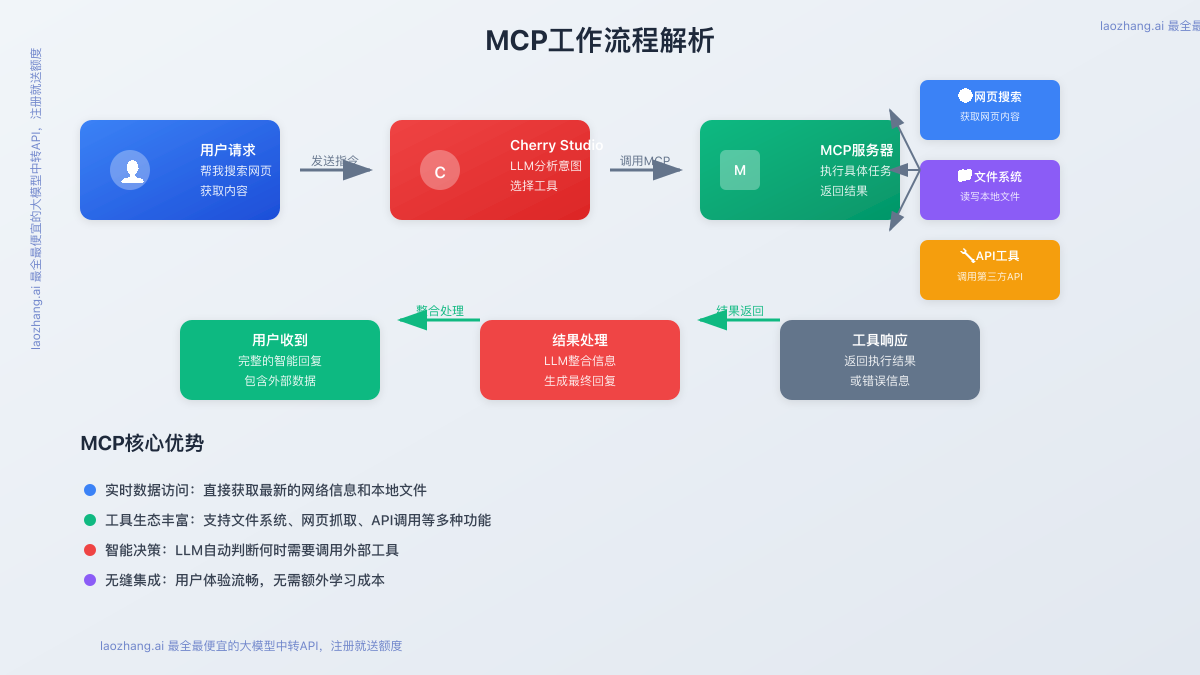

在开始配置之前,我们需要理解MCP的工作原理并完成必要的准备工作。简单来说,MCP定义了一套标准,让Cherry Studio可以启动并与外部的"工具服务器"进行通信。当LLM判断需要使用某个工具时,Cherry Studio就会通过MCP协议向对应的服务器发送指令。

1.1 环境要求

确保你的环境满足以下基本要求:

-

Cherry Studio版本:建议使用最新版本(v1.1.10或更高),因为旧版本可能不支持或不完全支持MCP。

-

模型支持:你需要一个支持工具调用(Tool Calling)或函数调用(Function Calling)的大语言模型。这是整个流程的核心,因为模型需要能够理解你的意图并决定调用哪个工具。

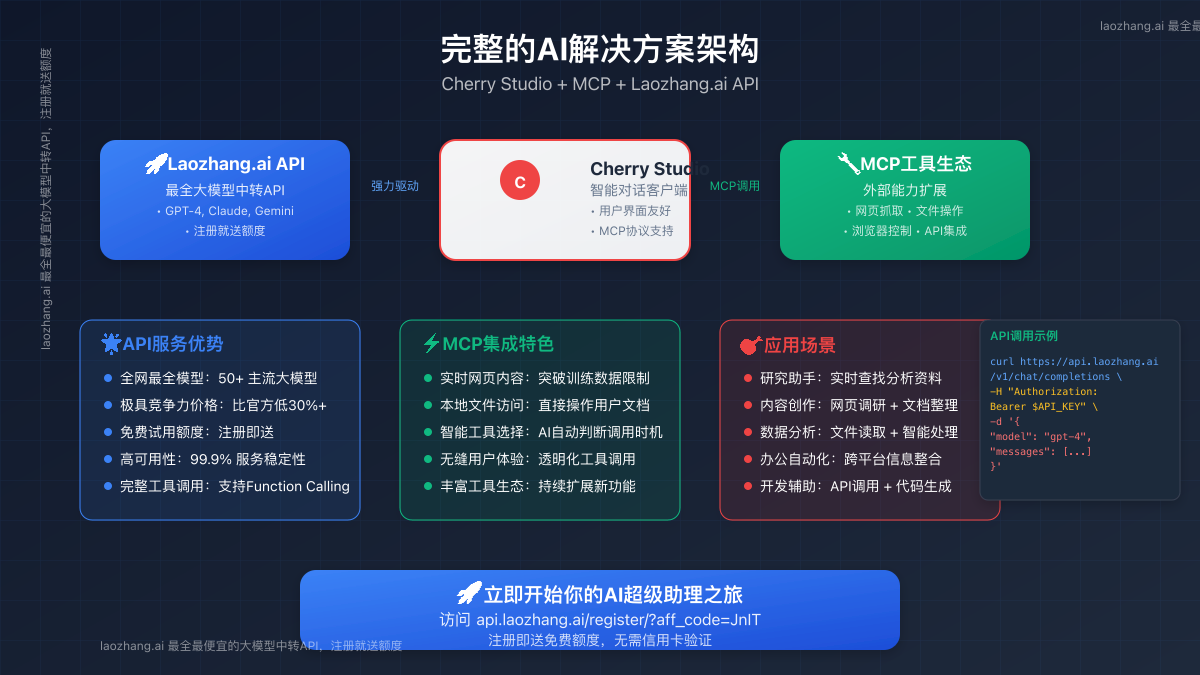

一个强大的LLM是成功使用MCP的关键。模型需要准确地解析用户意图,并生成正确的工具调用指令。像OpenAI的GPT-4系列、Anthropic的Claude 3 Opus以及Google的Gemini Pro等模型在这方面表现出色。

为了以最低成本体验这些顶级模型,强烈推荐使用 LaoZhang.ai中转API。它聚合了全网最全的大模型API,价格极具竞争力,并且注册即送免费额度,是开发和测试AI应用的最佳选择。

1.2 自动安装依赖环境

幸运的是,新版的Cherry Studio已经极大地简化了环境配置。当你首次添加MCP服务器时,它会自动检测并提示你安装所需的依赖,如UV和Bun。

你只需在设置的MCP服务器页面,点击提示信息旁的"安装"按钮,Cherry Studio便会自动完成所有环境配置,无需手动操作。

2. 核心配置:一步步添加MCP服务器

环境就绪后,我们就可以开始添加具体的MCP工具服务器了。下面,我们以最常用的**网页搜索(fetch)**服务为例,详细介绍配置步骤。

-

打开设置:在Cherry Studio左下角找到并点击"设置"图标。

-

进入MCP服务器页面:在设置菜单中,选择"MCP服务器"。

-

添加新服务器:点击页面右上角的"添加服务器"按钮。

-

填写配置信息:在弹出的表单中,准确填写以下信息:

- 服务器名称 (Name): 自定义一个易于识别的名称,例如

网页搜索服务。 - 类型 (Type): 对于大多数社区提供的MCP包,选择

STDIO。 - 命令 (Command): 填写

uvx。这是使用uv(一个快速的Python包安装器)执行远程包的命令。 - 参数 (Arguments): 填写MCP包的名称。对于网页抓取功能,包名是

@modelprotocol/server-fetch。 - 描述 (Description): (可选) 添加一些描述信息,方便日后管理。

- 服务器名称 (Name): 自定义一个易于识别的名称,例如

-

保存配置:点击"保存"按钮。Cherry Studio会自动在后台下载并设置此服务。下载完成后,即可在对话中使用。

MCP有一个不断壮大的生态。你可以在ModelScope的MCP广场或服务的官方文档中找到大量的MCP工具及其对应的包名(即参数)。常见的服务包括:

- 文件系统:

@modelprotocol/server-filesystem - 浏览器自动化:

@modelprotocol/server-browser - 代码解释器:

@daruma-vision/mcp-server-python-code-interpreter

3. 实战应用与API推广

配置完成后,我们来实际体验一下MCP的强大功能。

3.1 网页内容总结

现在,你可以直接在对话框中向AI发出指令,让它帮你总结一个网页的内容。

用户输入:

帮我访问

https://docs.cherry-ai.com/advanced-basic/mcp/config这个网址,并用中文总结其核心内容。

AI的执行过程:

- LLM决策:模型(例如通过LaoZhang.ai调用的GPT-4)分析指令,判断出需要访问网络,决定调用

网页搜索服务(即我们配置的fetch工具)。 - MCP调用:Cherry Studio向

mcp-server-fetch发送指令,请求获取指定URL的内容。 - 信息返回:MCP服务器执行网络请求,将获取到的网页文本返回给LLM。

- 生成回复:LLM结合获取到的内容,进行总结,并生成最终的中文回复。

3.2 Laozhang.ai API助力MCP

要让上述流程顺畅运行,一个稳定、低价且支持工具调用的模型API至关重要。这正是Laozhang.ai的用武之地。

通过在Cherry Studio的模型设置中配置Laozhang.ai的API Key,你可以轻松接入数十种顶级模型。

API请求示例 (curl):

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $YOUR_LAOZHANG_API_KEY" \

-d '{

"model": "gpt-4-turbo",

"messages": [

{"role": "user", "content": "Hello!"}

]

}'

还在等什么?立即访问 https://api.laozhang.ai/register/?aff_code=JnIT 注册,获取免费额度,为你的Cherry Studio插上最强劲的翅膀!

常见问题解答 (FAQ)

Q1: 添加MCP服务器后没有反应或安装失败怎么办?

核心回答:这通常是网络问题或环境冲突导致的。

- 技术解释:MCP服务器的下载需要访问npm等包管理仓库,如果网络连接不稳定或存在防火墙,可能导致下载失败。此外,本地已有的Node.js或Python环境有时也可能与Cherry Studio的内置环境冲突。

- 应用建议:

- 检查网络:确保你的网络可以正常访问GitHub和npm。

- 重启应用:完全退出并重启Cherry Studio,有时可以解决临时性问题。

- 重启电脑:这是解决许多疑难杂症的经典方法,可以重置某些环境变量和服务。

- 查看日志:在Cherry Studio的开发者工具中查看控制台日志,可能会有详细的错误信息。

- 资源链接:参考Cherry Studio官方文档的常见问题部分。

Q2: 我应该选择哪个大语言模型来配合MCP使用?

核心回答:首选在工具调用方面经过优化的模型,如GPT-4、Claude 3 Opus和Gemini Pro。

- 技术解释:工具调用的成功率取决于模型的"决策能力"。模型需要从用户指令中准确提取意图、识别所需工具,并构建正确的调用参数。根据第三方评测数据,GPT-4系列和Claude 3 Opus在此类任务上长期处于领先地位,错误率低于5%。

- 应用建议:

- 复杂任务:对于需要多步推理和精确参数控制的场景,推荐使用

gpt-4-turbo或claude-3-opus-20240229。 - 成本敏感:对于简单的任务,

claude-3-sonnet-20240229或gemini-1.5-pro-latest是性价比很高的选择。

- 复杂任务:对于需要多步推理和精确参数控制的场景,推荐使用

- 资源链接:所有这些模型都可以通过 LaoZhang.ai 以极具竞争力的价格获得。

结论

通过本文的详细介绍,相信你已经完全掌握了在Cherry Studio中配置和使用MCP服务器的方法。MCP不仅是一个强大的功能,更是一种全新的AI交互范式,它将你的AI助手从一个封闭的"对话框"变成了一个能够与数字世界互动的强大"代理"(Agent)。

现在,就去探索和添加更多有趣的MCP工具,并结合 LaoZhang.ai 提供的强大模型,打造一个真正属于你自己的、无所不能的超级AI助理吧!