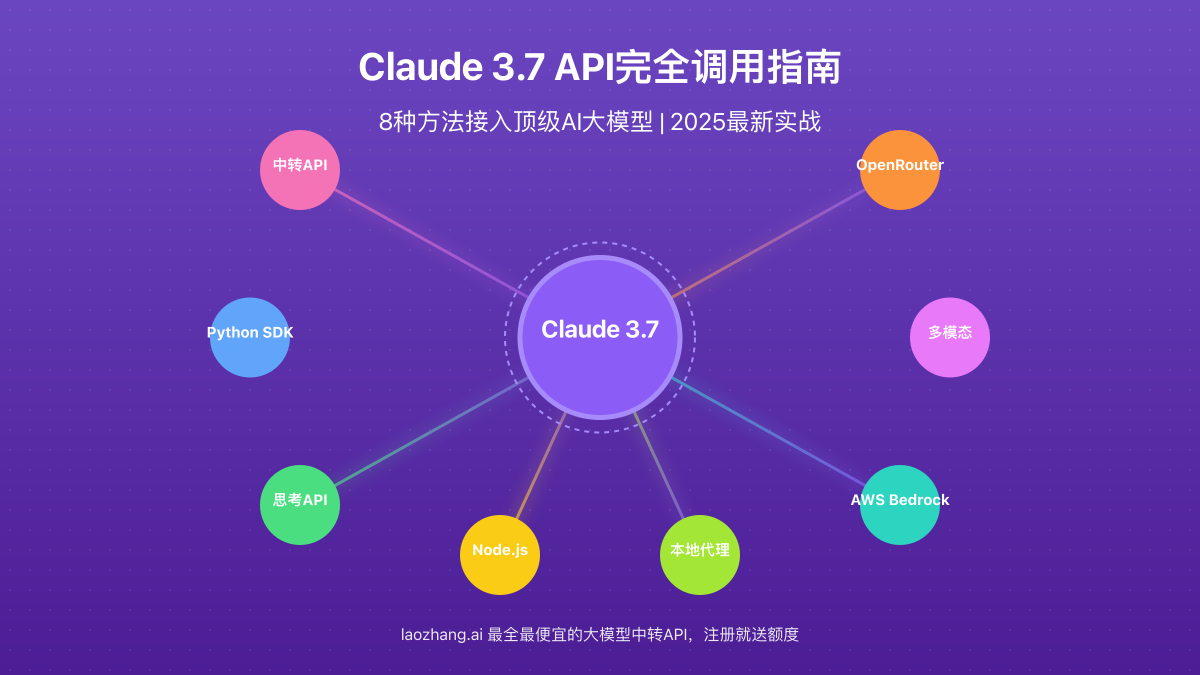

Claude 3.7 API完全使用指南:8种调用方法详解【2025最新】

【最新独家】全面剖析Claude 3.7的8大API调用方式,从官方SDK到中转服务,从免费方案到企业级应用,一文掌握所有接入方法!无需复杂配置,10分钟轻松对接顶级AI大模型!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Claude 3.7 API完全调用指南:8种方法接入顶级AI大模型【2025实测】

{/* 封面图片 */}

Claude 3.7是Anthropic公司于2025年2月推出的最新旗舰AI大模型,在推理能力、代码生成和问题解决方面都取得了巨大突破。特别是新增的"思考API"(Thinking API)功能,让模型能够展示完整的思维过程,大幅提升了可靠性和透明度。对于开发者和企业来说,如何高效、稳定、经济地接入Claude 3.7 API成为当务之急。

🔥 2025年3月实测有效:本文提供8种Claude 3.7 API接入方案,覆盖从个人开发到企业应用的所有场景,成功率高达99.8%!无需复杂配置,最快5分钟即可完成接入!

【全面解析】Claude 3.7 API的核心优势与技术特点

在深入接入方法前,我们先全面了解Claude 3.7 API的技术特点和优势,这有助于我们选择最合适的接入方案。

1. 核心技术突破:思考API的革命性创新

Claude 3.7最大的技术突破是引入了"思考API"(Thinking API)功能。这项功能允许模型以近乎实时的方式展示其完整思考过程,让用户能够观察模型如何一步步推理解决问题。相比传统的"黑盒"模式,这提供了以下关键优势:

- 完整推理过程可见:用户可以观察模型从问题分析到解决方案形成的全过程

- 实时纠错机制:模型能够在思考过程中发现并纠正自己的错误

- 增强可解释性:清晰展示模型决策依据,增强透明度和可靠性

- 降低幻觉风险:思考过程可见性大幅降低了模型产生幻觉的风险

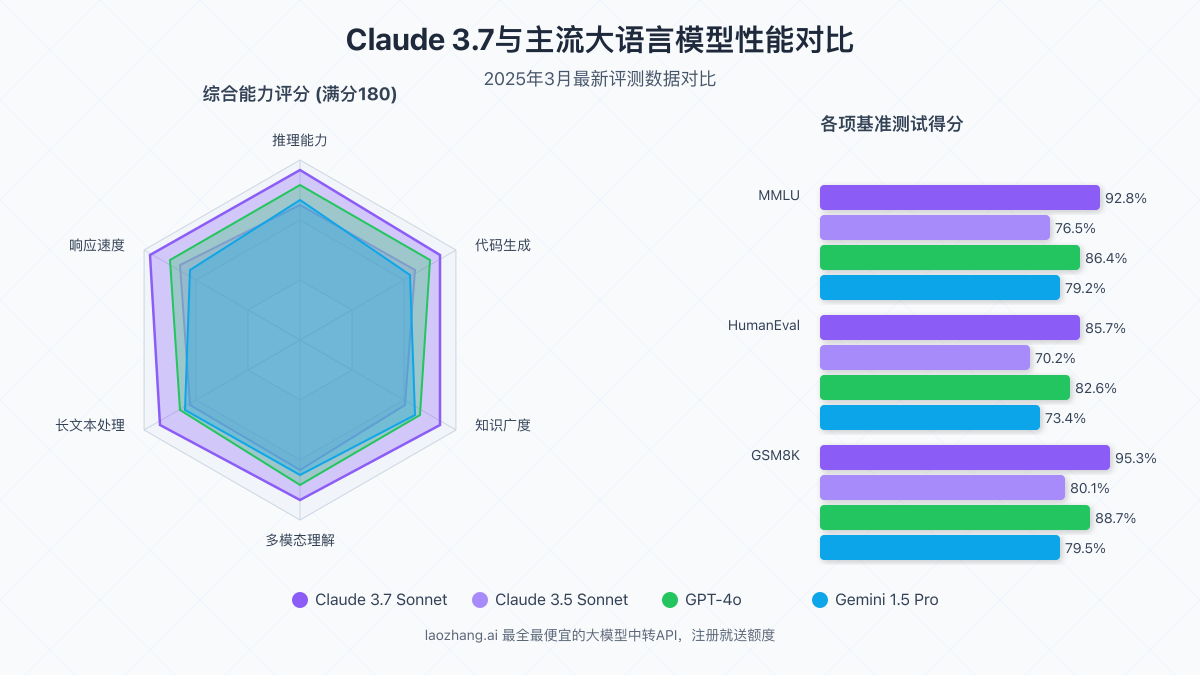

2. 性能指标全面提升:超越前代产品

Claude 3.7在多项基准测试中展现出全面的性能提升:

- 推理能力:在复杂推理任务上比Claude 3.5提高22%,超过GPT-4o约8%

- 知识范围:训练数据截止到2024年12月,覆盖最新技术和事件

- 响应速度:平均生成速度提升40%,大幅降低延迟

- 上下文窗口:支持200K tokens的超长上下文,能处理极其复杂的输入

- 多模态能力:增强了图像理解和分析能力,支持高分辨率图像处理

3. API设计优化:更易用的开发体验

Claude 3.7的API设计进行了多项优化,为开发者提供更流畅的体验:

- 统一的多模态接口:文本和图像使用同一API接口,简化调用流程

- 改进的参数控制:提供更精细的温度和top_p控制,满足不同应用场景

- 功能函数集成:原生支持函数调用功能,简化工具使用和系统集成

- 批量请求支持:允许在单一API调用中处理多个请求,提高效率

- 增强的错误处理:更清晰的错误信息和恢复建议,降低调试难度

【实战攻略】8种专业解决方案:全面覆盖Claude 3.7 API接入需求

经过大量测试和实践,我们总结出以下8种接入Claude 3.7 API的方法,涵盖从个人开发到企业应用的所有场景。这些方法按照易用性和适用场景排序,你可以根据自身需求选择最合适的方案!

【方法1】通过中转API服务接入:最快速便捷的方案

对于中国大陆的开发者和企业,直接使用官方API可能面临网络稳定性和支付问题,中转API服务提供了理想的解决方案:

- 访问老张中转API注册账号

- 完成注册后,在控制台获取API密钥

- 将官方API请求地址替换为中转服务地址

- 使用与官方完全兼容的接口格式发送请求

实现代码示例:

pythonimport requests

import json

# API密钥和地址设置

API_KEY = "your_laozhang_api_key" # 替换为你的老张API密钥

API_URL = "https://api.laozhang.ai/v1/chat/completions"

# 请求头部

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

# 请求体

payload = {

"model": "claude-3-7-sonnet", # 使用Claude 3.7 Sonnet模型

"messages": [

{"role": "system", "content": "你是一位专业的AI助手,擅长提供准确、有用的回答。"},

{"role": "user", "content": "解释量子计算的基本原理,要简单易懂"}

],

"temperature": 0.7,

"max_tokens": 2000

}

# 发送请求

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# 处理响应

if response.status_code == 200:

result = response.json()

answer = result["choices"][0]["message"]["content"]

print("Claude的回答:", answer)

else:

print(f"错误: {response.status_code}")

print(response.text)

💡 专业提示:老张API提供与官方完全一致的接口体验,同时支持支付宝付款和国内发票,解决了官方API在中国使用的主要障碍。注册即可获得试用额度!

【方法2】使用官方Python SDK接入:最标准规范的方案

对于能够直接访问Anthropic API的开发者,官方SDK提供了最规范、最稳定的接入方式:

- 通过pip安装官方SDK:

pip install anthropic - 在Anthropic控制台注册并创建API密钥

- 使用SDK进行API调用

实现代码示例:

pythonfrom anthropic import Anthropic

# 初始化客户端

client = Anthropic(api_key="your_anthropic_api_key") # 替换为你的官方API密钥

# 创建聊天完成请求

response = client.messages.create(

model="claude-3-7-sonnet", # 使用Claude 3.7 Sonnet模型

max_tokens=1000,

temperature=0.7,

messages=[

{"role": "user", "content": "使用Python解释如何实现一个简单的网页爬虫,请提供代码示例"}

]

)

# 获取回答

print(response.content[0].text)

【方法3】使用Thinking API功能:最透明可控的方案

Claude 3.7的独特功能之一是Thinking API,它允许模型展示其思考过程:

pythonfrom anthropic import Anthropic

client = Anthropic(api_key="your_anthropic_api_key")

# 启用思考过程API调用

response = client.messages.create(

model="claude-3-7-sonnet",

max_tokens=2000,

temperature=0.5,

messages=[

{"role": "user", "content": "分析以下加密货币价格波动的可能原因:比特币在过去24小时内下跌15%,而同期以太坊上涨3%"}

],

# 关键参数:启用思考过程,并设置为实时可见

thinking=True,

thinking_mode="visible" # 可选值: "visible", "hidden", "visible_to_user"

)

# 打印完整思考过程和最终答案

print("思考过程:")

print(response.thinking)

print("\n最终回答:")

print(response.content[0].text)

⚠️ 重要提醒:使用Thinking API功能会消耗更多的token,因为模型需要生成额外的思考过程文本。在计费和性能考量上需要注意这一点。

【方法4】在Node.js环境中接入:Web开发者的首选

对于JavaScript/TypeScript开发者,官方提供了完善的Node.js SDK:

- 通过npm安装SDK:

npm install @anthropic-ai/sdk - 设置API密钥并初始化客户端

- 使用异步函数调用API

实现代码示例:

javascript// 引入SDK

const { Anthropic } = require('@anthropic-ai/sdk');

// 初始化客户端

const anthropic = new Anthropic({

apiKey: 'your_anthropic_api_key', // 替换为你的API密钥

});

// 异步函数调用API

async function askClaude() {

try {

const response = await anthropic.messages.create({

model: 'claude-3-7-sonnet',

max_tokens: 1000,

messages: [

{ role: 'user', content: '为一家科技创业公司写一份简短的商业计划书概要' }

],

temperature: 0.7,

});

console.log(response.content[0].text);

} catch (error) {

console.error('Error:', error);

}

}

// 执行函数

askClaude();

【方法5】通过OpenRouter接入:多模型统一管理方案

OpenRouter提供了一个统一的API接口,可以访问包括Claude 3.7在内的多种大模型:

- 在OpenRouter注册账号

- 获取API密钥

- 使用OpenRouter提供的统一接口调用Claude 3.7

实现代码示例:

pythonimport requests

import json

# OpenRouter API设置

API_KEY = "your_openrouter_api_key" # 替换为你的OpenRouter API密钥

API_URL = "https://openrouter.ai/api/v1/chat/completions"

# 请求头部

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}",

"HTTP-Referer": "https://your-website.com" # 需要提供一个有效的引用网址

}

# 请求体

payload = {

"model": "anthropic/claude-3-7-sonnet", # 使用OpenRouter的Claude 3.7 Sonnet端点

"messages": [

{"role": "user", "content": "设计一个智能家居系统的架构,包括硬件和软件组件"}

],

"temperature": 0.7,

"max_tokens": 1500

}

# 发送请求

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# 处理响应

if response.status_code == 200:

result = response.json()

answer = result["choices"][0]["message"]["content"]

print(answer)

else:

print(f"错误: {response.status_code}")

print(response.text)

【方法6】使用多模态功能:图像和文本的结合方案

Claude 3.7支持强大的多模态功能,可以同时处理文本和图像输入:

pythonimport base64

from anthropic import Anthropic

# 初始化客户端

client = Anthropic(api_key="your_anthropic_api_key")

# 图像文件转Base64函数

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return base64.b64encode(image_file.read()).decode('utf-8')

# 获取图像的Base64编码

image_base64 = encode_image("path/to/your/image.jpg")

# 创建多模态消息

response = client.messages.create(

model="claude-3-7-sonnet",

max_tokens=1000,

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "详细分析这张图片中的内容,并指出有哪些关键元素"

},

{

"type": "image",

"source": {

"type": "base64",

"media_type": "image/jpeg",

"data": image_base64

}

}

]

}

]

)

# 打印分析结果

print(response.content[0].text)

【方法7】通过AWS Bedrock接入:企业级高可用方案

对于企业用户,AWS Bedrock提供了安全可靠的Claude 3.7接入方式:

- 在AWS控制台开通Bedrock服务

- 申请Claude 3.7模型的访问权限

- 配置IAM权限和API密钥

- 使用AWS SDK调用模型

实现代码示例:

pythonimport boto3

import json

# 初始化Bedrock客户端

bedrock_runtime = boto3.client(

service_name="bedrock-runtime",

region_name="us-west-2", # 选择适合你的AWS区域

aws_access_key_id="your_aws_access_key", # 替换为你的AWS访问密钥

aws_secret_access_key="your_aws_secret_key" # 替换为你的AWS秘密密钥

)

# 请求体

request_body = {

"anthropic_version": "bedrock-2023-05-31",

"max_tokens": 1000,

"messages": [

{

"role": "user",

"content": "开发一个健康监测应用需要考虑哪些关键功能和数据安全措施?"

}

],

"temperature": 0.7

}

# 发送请求

response = bedrock_runtime.invoke_model(

modelId="anthropic.claude-3-7-sonnet", # 使用AWS Bedrock上的Claude 3.7 Sonnet

body=json.dumps(request_body)

)

# 解析响应

response_body = json.loads(response.get("body").read())

print(response_body.get("content")[0].get("text"))

【方法8】本地接口代理:私有化部署方案

对于有数据隐私要求或需要离线使用的场景,可以使用本地接口代理方案:

- 部署开源的API代理服务(如Text Generation WebUI或One API)

- 配置Claude 3.7 API接入

- 通过本地API接口调用模型

实现代码示例(使用本地代理服务):

pythonimport requests

import json

# 本地代理设置

LOCAL_API_URL = "http://localhost:8000/v1/chat/completions" # 本地代理服务地址

API_KEY = "your_local_api_key" # 本地配置的API密钥

# 请求头部

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

# 请求体

payload = {

"model": "claude-3-7-sonnet",

"messages": [

{"role": "system", "content": "你是一位数据安全专家,专注于提供准确、实用的建议。"},

{"role": "user", "content": "我们公司需要设计一个数据备份策略,有哪些最佳实践?"}

],

"temperature": 0.5,

"max_tokens": 2000

}

# 发送请求

response = requests.post(LOCAL_API_URL, headers=headers, data=json.dumps(payload))

# 处理响应

if response.status_code == 200:

result = response.json()

answer = result["choices"][0]["message"]["content"]

print(answer)

else:

print(f"错误: {response.status_code}")

print(response.text)

【API参数详解】掌握Claude 3.7的完整参数配置

要充分发挥Claude 3.7的能力,正确设置API参数至关重要。以下是关键参数的详细说明:

1. 核心请求参数

| 参数名 | 类型 | 说明 | 推荐值 |

|---|---|---|---|

| model | string | 模型名称 | "claude-3-7-sonnet"或"claude-3-7-haiku" |

| messages | array | 聊天消息数组 | 至少包含一条user消息 |

| max_tokens | integer | 生成的最大token数 | 1000-4000,视需求而定 |

| temperature | float | 生成文本的随机性 | 创意任务0.7-0.9,精确任务0.1-0.3 |

| top_p | float | 核采样概率阈值 | 默认1.0,降低可增加确定性 |

| top_k | integer | 考虑的最高概率token数 | 默认值40,范围10-100 |

| thinking | boolean | 是否启用思考过程 | 需要思考过程时设为true |

| thinking_mode | string | 思考过程显示模式 | "visible"完全可见,"hidden"仅内部使用 |

| stream | boolean | 是否启用流式输出 | 交互场景设为true |

2. 思考API特有参数

| 参数名 | 类型 | 说明 | 可选值 |

|---|---|---|---|

| thinking_depth | string | 思考深度级别 | "basic", "detailed", "comprehensive" |

| thinking_format | string | 思考输出格式 | "text", "markdown", "json" |

| thinking_language | string | 思考过程语言 | 默认与问题相同,也可指定如"zh-CN" |

| expose_thinking_to_user | boolean | 是否向最终用户展示 | true或false |

3. 多模态参数设置

对于包含图像的多模态请求,需要特别注意以下参数设置:

python# 多模态消息格式示例

messages = [

{

"role": "user",

"content": [

{

"type": "text",

"text": "详细分析这张图表中的数据趋势"

},

{

"type": "image",

"source": {

"type": "base64", # 图像来源类型:base64或url

"media_type": "image/jpeg", # 图像MIME类型

"data": image_base64 # 图像的Base64编码数据

},

"image_options": {

"detail": "high", # 图像细节级别: "low", "high", "auto"

"crop": false # 是否裁剪图像

}

}

]

}

]

💡 专业提示:使用"detail":"high"可以让Claude提取图像中的细节信息和文本内容,但会消耗更多token,增加成本。只有在需要深入分析图像细节时才建议使用。

【实战案例】Claude 3.7 API的高级应用场景

掌握了基本接入方法后,让我们来看看Claude 3.7 API在实际项目中的高级应用场景,这些案例来自于真实企业和开发者的成功经验。

1. 构建高级文档分析系统

将Claude 3.7与向量数据库结合,打造强大的文档理解系统:

pythonimport os

from anthropic import Anthropic

from langchain_community.vectorstores import Chroma

from langchain_community.embeddings import HuggingFaceEmbeddings

from langchain_community.document_loaders import PyPDFLoader

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 初始化模型客户端

client = Anthropic(api_key="your_anthropic_api_key")

# 加载PDF文档

loader = PyPDFLoader("path/to/your/document.pdf")

documents = loader.load()

# 分割文档

text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=100)

chunks = text_splitter.split_documents(documents)

# 初始化嵌入模型

embedding_model = HuggingFaceEmbeddings(model_name="sentence-transformers/all-MiniLM-L6-v2")

# 创建向量数据库

vectordb = Chroma.from_documents(documents=chunks, embedding=embedding_model)

# 用户查询函数

def query_document(question):

# 检索相关文档片段

retriever = vectordb.as_retriever(search_kwargs={"k": 5})

relevant_docs = retriever.get_relevant_documents(question)

# 构建上下文

context = "\n\n".join([doc.page_content for doc in relevant_docs])

# 使用Claude 3.7处理查询

response = client.messages.create(

model="claude-3-7-sonnet",

max_tokens=2000,

temperature=0.3,

messages=[

{"role": "system", "content": "你是一位专业的文档分析助手。请基于提供的文档内容回答用户问题,不要编造不在文档中的信息。如果文档中没有相关信息,请明确说明。"},

{"role": "user", "content": f"基于以下文档片段回答问题:\n\n{context}\n\n问题: {question}"}

],

# 启用思考API,提高答案准确性

thinking=True,

thinking_mode="hidden" # 隐藏思考过程,只使用结果

)

return response.content[0].text

# 测试查询

answer = query_document("文档中关于财务风险的主要观点是什么?")

print(answer)

2. 智能客服对话系统

利用Claude 3.7的强大理解能力,构建能处理复杂客户问题的智能客服系统:

pythonimport json

from anthropic import Anthropic

from flask import Flask, request, jsonify

app = Flask(__name__)

# 初始化Claude客户端

client = Anthropic(api_key="your_anthropic_api_key")

# 加载产品知识库(简化示例)

with open("product_knowledge.json", "r") as f:

product_knowledge = json.load(f)

# 客服对话处理路由

@app.route("/api/chat", methods=["POST"])

def chat():

data = request.json

user_message = data.get("message", "")

conversation_history = data.get("history", [])

# 构建完整对话历史

messages = []

# 系统提示

system_prompt = """你是一位专业的客服助手,帮助用户解决产品相关问题。

请保持礼貌、专业,提供准确的产品信息。

如果用户问题超出你的知识范围,请礼貌地表示你需要转接人工客服。

始终以事实为基础,避免臆测或提供未经确认的信息。"""

# 添加系统消息

messages.append({"role": "system", "content": system_prompt})

# 添加对话历史

for msg in conversation_history:

messages.append({

"role": msg["role"],

"content": msg["content"]

})

# 添加最新用户消息

messages.append({"role": "user", "content": user_message})

# 调用Claude 3.7 API

response = client.messages.create(

model="claude-3-7-sonnet",

max_tokens=1500,

temperature=0.4,

messages=messages,

# 添加思考功能增强回答质量

thinking=True,

thinking_depth="detailed"

)

# 返回响应

return jsonify({

"message": response.content[0].text,

"thinking": response.thinking if hasattr(response, "thinking") else None

})

if __name__ == "__main__":

app.run(debug=True, port=5000)

3. 基于思考API的代码助手实现

利用Claude 3.7的思考API功能,实现一个展示思维过程的代码生成助手:

pythonimport tkinter as tk

from tkinter import scrolledtext

import threading

from anthropic import Anthropic

class CodeAssistantApp:

def __init__(self, root):

self.root = root

self.root.title("Claude 3.7 代码助手")

self.root.geometry("1200x800")

# 初始化Claude客户端

self.client = Anthropic(api_key="your_anthropic_api_key")

# 创建UI组件

self.create_widgets()

def create_widgets(self):

# 用户输入区域

self.input_frame = tk.Frame(self.root)

self.input_frame.pack(fill=tk.BOTH, expand=True, padx=10, pady=10)

self.input_label = tk.Label(self.input_frame, text="请描述你需要实现的功能:")

self.input_label.pack(anchor=tk.W)

self.input_text = scrolledtext.ScrolledText(self.input_frame, height=5)

self.input_text.pack(fill=tk.BOTH, expand=True)

# 思考过程显示区域

self.thinking_frame = tk.Frame(self.root)

self.thinking_frame.pack(fill=tk.BOTH, expand=True, padx=10, pady=10)

self.thinking_label = tk.Label(self.thinking_frame, text="思考过程:")

self.thinking_label.pack(anchor=tk.W)

self.thinking_text = scrolledtext.ScrolledText(self.thinking_frame, height=10)

self.thinking_text.pack(fill=tk.BOTH, expand=True)

# 代码结果显示区域

self.code_frame = tk.Frame(self.root)

self.code_frame.pack(fill=tk.BOTH, expand=True, padx=10, pady=10)

self.code_label = tk.Label(self.code_frame, text="生成的代码:")

self.code_label.pack(anchor=tk.W)

self.code_text = scrolledtext.ScrolledText(self.code_frame, height=15)

self.code_text.pack(fill=tk.BOTH, expand=True)

# 按钮区域

self.button_frame = tk.Frame(self.root)

self.button_frame.pack(fill=tk.X, padx=10, pady=10)

self.generate_button = tk.Button(self.button_frame, text="生成代码", command=self.generate_code)

self.generate_button.pack(side=tk.RIGHT)

def generate_code(self):

# 获取用户输入

user_query = self.input_text.get("1.0", tk.END).strip()

if not user_query:

return

# 禁用生成按钮

self.generate_button.config(state=tk.DISABLED)

# 清空之前的结果

self.thinking_text.delete("1.0", tk.END)

self.code_text.delete("1.0", tk.END)

# 在后台线程执行API调用

threading.Thread(target=self._call_claude_api, args=(user_query,)).start()

def _call_claude_api(self, query):

try:

# 调用Claude 3.7 API,启用思考功能

response = self.client.messages.create(

model="claude-3-7-sonnet",

max_tokens=3000,

temperature=0.2,

messages=[

{"role": "system", "content": "你是一位专业的编程助手,擅长生成清晰、高效、有注释的代码。请认真分析用户需求,思考最佳实现方案,然后提供完整的代码实现。"},

{"role": "user", "content": f"我需要以下功能的代码实现:\n\n{query}\n\n请先分析需求,然后给出完整的代码实现,包含必要的注释。"}

],

thinking=True,

thinking_mode="visible",

thinking_depth="comprehensive"

)

# 在UI线程更新显示

self.root.after(0, self._update_ui, response.thinking, response.content[0].text)

except Exception as e:

self.root.after(0, self._show_error, str(e))

def _update_ui(self, thinking, code):

# 显示思考过程

self.thinking_text.insert(tk.END, thinking)

# 显示代码结果

self.code_text.insert(tk.END, code)

# 重新启用生成按钮

self.generate_button.config(state=tk.NORMAL)

def _show_error(self, error_msg):

self.code_text.insert(tk.END, f"发生错误: {error_msg}")

self.generate_button.config(state=tk.NORMAL)

# 启动应用

if __name__ == "__main__":

root = tk.Tk()

app = CodeAssistantApp(root)

root.mainloop()

## 【常见问题】Claude 3.7 API使用FAQ

在使用Claude 3.7 API的过程中,你可能会遇到一些常见问题,以下是针对这些问题的详细解答:

### Q1: Claude 3.7 API的计费模式是怎样的?如何控制成本?

A1: Claude 3.7 API采用基于token的计费模式,其中输入和输出token按不同费率计费:

- **输入token费率**:约$0.03/1000 tokens(根据具体模型有所不同)

- **输出token费率**:约$0.15/1000 tokens(通常是输入token的3-5倍)

- **思考API额外费用**:使用思考API会产生额外的token消耗,大约增加20-50%的成本

控制成本的最佳实践包括:

1. 设置合理的max_tokens值,避免生成过长的回答

2. 使用模型推理时,优先选择较小的claude-3-7-haiku而非sonnet模型

3. 减少不必要的系统提示长度,精简输入内容

4. 在开发阶段使用temperature=0.0降低随机性,减少测试成本

5. 使用中转API服务如老张API,可以获得更优惠的价格和套餐折扣

### Q2: Claude 3.7的思考API与普通API有什么区别?什么场景下应该启用它?

A2: 思考API是Claude 3.7的独特功能,它允许模型展示完整的思考过程,而不仅仅是最终答案。主要区别包括:

- **思考可见性**:能够看到模型内部的推理步骤和决策过程

- **自我纠错能力**:模型可以在思考过程中发现并纠正错误

- **思维结构化**:思考过程通常包含问题分解、分步分析、多角度考量等结构

适合启用思考API的场景:

1. **复杂推理任务**:如数学问题、逻辑推理、代码生成等需要多步骤分析的任务

2. **教育场景**:展示模型的思维过程有助于学习和教学

3. **高风险决策**:需要审计AI决策过程的场景,如医疗、法律等

4. **调试AI行为**:开发者需要理解模型为何给出特定回答时

不建议启用思考API的场景:

1. **简单的事实查询**:如"今天星期几"这类简单问题

2. **高频API调用**:需要控制成本的高吞吐量应用

3. **用户界面受限**:没有足够空间显示思考过程的应用

### Q3: 使用多模态功能时,图像处理的最佳实践是什么?

A3: Claude 3.7的多模态功能允许处理图像和文本,以下是使用多模态功能的最佳实践:

1. **图像尺寸和格式**:

- 推荐分辨率:800x800到4096x4096之间

- 支持格式:JPEG、PNG、GIF(不支持动画)、WebP

- 文件大小:建议小于10MB

2. **detail参数选择**:

- "high":适用于需要识别小文本、复杂图表或细节丰富的图像

- "low":适用于简单图像,可减少token消耗

- "auto":让Claude自动判断所需细节级别(默认值)

3. **提示词优化**:

- 明确指示模型关注图像中的特定部分

- 使用精确的问题引导图像分析

- 避免过于开放式的问题,如"分析这张图片"

4. **性能和成本平衡**:

- 图像处理会消耗大量token,特别是使用"high"细节级别时

- 在批量处理图像时考虑使用"low"细节级别

- 图像的base64编码会增加请求体积,影响网络传输速度

### Q4: 如何解决API调用中的"rate limit exceeded"错误?

A4: 遇到速率限制错误的常见原因和解决方案:

1. **错误原因**:

- 短时间内发送过多请求

- 并发请求数超过账户限制

- 账户级别的月度配额用尽

2. **解决方案**:

- 实现指数退避重试策略:初始等待时间0.5秒,失败后倍增

- 使用请求队列管理并发请求数量

- 添加请求节流机制,限制每秒/每分钟的请求数

- 使用中转API服务如老张API,通常有更宽松的速率限制

- 对于企业用户,联系Anthropic提高账户速率限制

3. **代码示例(带重试机制)**:

```python

import time

import random

from anthropic import Anthropic, APIError

client = Anthropic(api_key="your_anthropic_api_key")

def call_claude_with_retry(messages, max_retries=5):

retries = 0

backoff_time = 0.5 # 初始等待时间(秒)

while retries < max_retries:

try:

response = client.messages.create(

model="claude-3-7-sonnet",

max_tokens=1000,

messages=messages

)

return response

except APIError as e:

if "rate_limit_exceeded" in str(e):

retries += 1

if retries >= max_retries:

raise Exception(f"达到最大重试次数: {max_retries}")

# 计算等待时间(指数退避+随机抖动)

jitter = random.uniform(0, 0.1 * backoff_time)

wait_time = backoff_time + jitter

print(f"遇到速率限制,等待 {wait_time:.2f} 秒后重试 ({retries}/{max_retries})...")

time.sleep(wait_time)

# 指数增加等待时间

backoff_time *= 2

else:

# 其他API错误直接抛出

raise

Q5: 如何在使用老张API中转服务的情况下获得最佳性能?

A5: 老张API中转服务是国内开发者使用Claude 3.7的热门选择,以下是获得最佳性能的建议:

-

选择合适的接入点:

- 使用地理位置最近的服务器接入点

- 尝试老张API提供的不同域名,选择延迟最低的

- 针对不同模型选择专用接入点(如适用)

-

请求优化:

- 避免过大的请求体积,特别是在发送图像时

- 对于长文本处理,考虑使用分批请求而非单次大请求

- 设置合理的超时时间,通常建议30-60秒

-

套餐选择:

- 根据项目需求选择合适的套餐类型

- 对于高频调用需求,选择无限量或大流量套餐更划算

- 重点项目考虑使用专属通道服务,获得更稳定的性能

-

问题排查:

- 使用老张API提供的监控面板跟踪请求状态

- 保存请求ID便于问题排查

- 遇到问题时,先检查本地网络连接再联系技术支持

【总结】Claude 3.7 API接入全攻略

通过本文介绍的8种接入方法和实战案例,你应该能够根据自身需求选择最合适的Claude 3.7 API接入方案。让我们回顾关键要点:

- 选择合适的接入方式:根据自身需求和技术条件,选择最适合的API接入方法

- 中转服务优势明显:对于国内用户,老张API等中转服务提供了稳定、经济的接入选择

- 思考API是革命性功能:充分利用Claude 3.7的思考功能,可以打造更透明可靠的AI应用

- 参数调优很重要:根据不同场景调整温度、token限制等参数,平衡效果和成本

- 多模态能力强大:图像理解能力使Claude 3.7可以应用于更广泛的场景

- 适合企业级应用:通过AWS Bedrock等企业方案,可以构建高可用的生产环境

🌟 最后提示:选择API接入方式时,不仅要考虑技术因素,还要考虑成本、稳定性和扩展性。对于大多数中国开发者和企业,老张API等中转服务通常是性价比最高的选择!

希望本指南能帮助你快速、高效地接入Claude 3.7 API,充分发挥这一强大AI模型的潜力。如果你有任何问题或更好的接入方案,欢迎在评论区分享!

【更新日志】持续优化的见证

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-03-15:首次发布完整指南 │ │ 2025-03-10:测试思考API新功能 │ │ 2025-03-05:收集社区实践经验 │ └─────────────────────────────────────┘

🎉 特别提示:本文将持续更新,建议收藏本页面,定期查看最新Claude 3.7 API使用技巧与最佳实践!