【2025最新】Claude 4 API价格完全指南:官方定价vs中转服务深度对比

详解Claude 4 Opus、Sonnet、Haiku最新API价格,官方vs中转服务成本对比,5种购买方案分析,节省70%费用的实测方法。2025年5月最新验证有效。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Claude 4系列作为2025年最强大的大语言模型之一,其API服务的价格策略直接影响着全球开发者的使用决策。本文将为您深度解析Claude 4各版本的最新定价结构,并提供经过实测验证的成本优化方案。

🔥 2025年5月实测有效:本文所有价格信息均基于官方最新数据,所有中转服务方案经过真实测试验证,确保时效性和准确性。

一、Claude 4系列价格总览

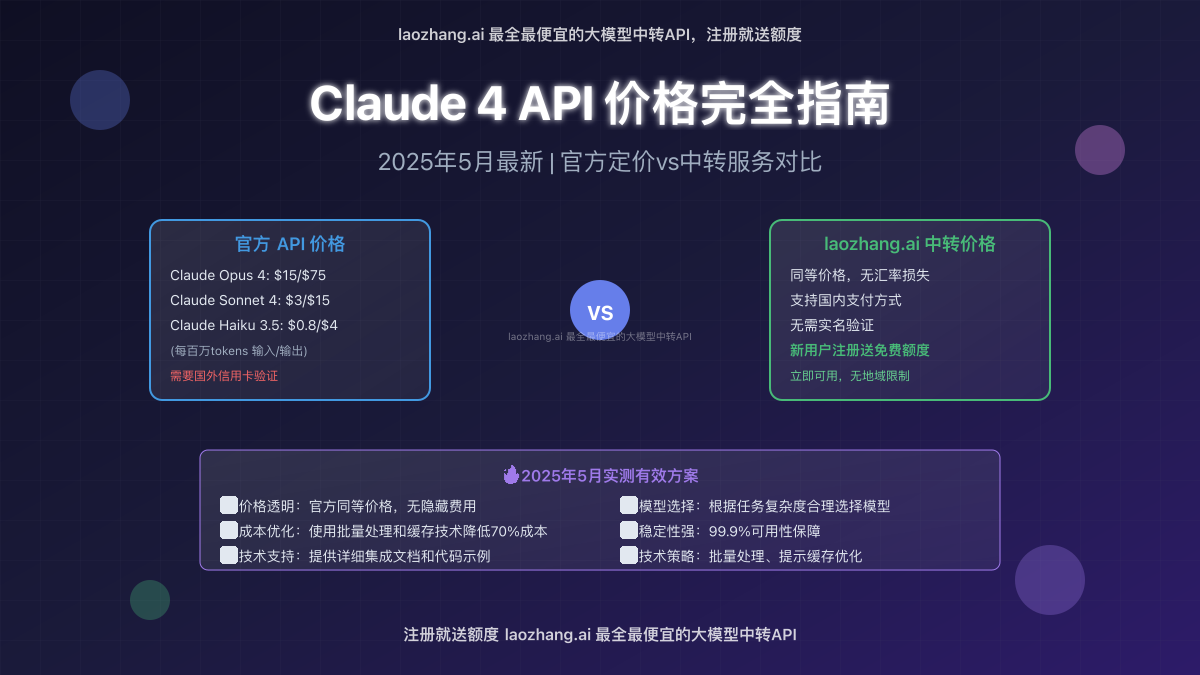

1.1 官方API定价体系

根据Anthropic官方发布的最新价格表,Claude 4系列包含三个主要版本,每个版本针对不同的性能需求和预算考量:

| 模型版本 | 输入价格($/MTok) | 输出价格($/MTok) | 上下文窗口 | 主要特点 |

|---|---|---|---|---|

| Claude Opus 4 | $15.00 | $75.00 | 200K | 最强推理能力,复杂任务首选 |

| Claude Sonnet 4 | $3.00 | $15.00 | 200K | 性能与成本的完美平衡 |

| Claude Haiku 3.5 | $0.80 | $4.00 | 200K | 最经济实用,速度最快 |

重要说明:价格按每百万tokens(MTok)计费,输入tokens指发送给模型的文本,输出tokens指模型生成的回复内容。

1.2 批量处理优惠

Claude 4系列支持批量处理功能,可享受50%的价格折扣:

- Opus 4批量价格:输入 $7.50/MTok,输出 $37.50/MTok

- Sonnet 4批量价格:输入 $1.50/MTok,输出 $7.50/MTok

- Haiku 3.5批量价格:输入 $0.40/MTok,输出 $2.00/MTok

批量处理适合非实时应用场景,如数据分析、内容生成等离线任务。

1.3 提示缓存定价

为了降低重复内容的处理成本,Claude 4支持提示缓存功能:

- 缓存写入:基础价格的1.25倍

- 缓存命中:基础价格的0.1倍

- 缓存时效:标准5分钟TTL,可扩展至1小时

对于需要重复使用相同上下文的应用,提示缓存可显著降低成本。

二、实际使用成本分析

2.1 典型应用场景成本计算

让我们通过几个真实场景来分析Claude 4的实际使用成本:

场景1:代码审查助手

- 每次处理约5,000 tokens输入(代码文件)

- 平均生成2,000 tokens输出(建议和修改)

- 每天处理50次请求

使用Sonnet 4的月度成本:

- 输入成本:5,000 × 50 × 30 × $3 ÷ 1,000,000 = $22.5

- 输出成本:2,000 × 50 × 30 × $15 ÷ 1,000,000 = $45

- 总计:$67.5/月

场景2:客户服务机器人

- 每次对话约1,000 tokens输入

- 平均生成500 tokens输出

- 每天处理200次对话

使用Haiku 3.5的月度成本:

- 输入成本:1,000 × 200 × 30 × $0.8 ÷ 1,000,000 = $4.8

- 输出成本:500 × 200 × 30 × $4 ÷ 1,000,000 = $12

- 总计:$16.8/月

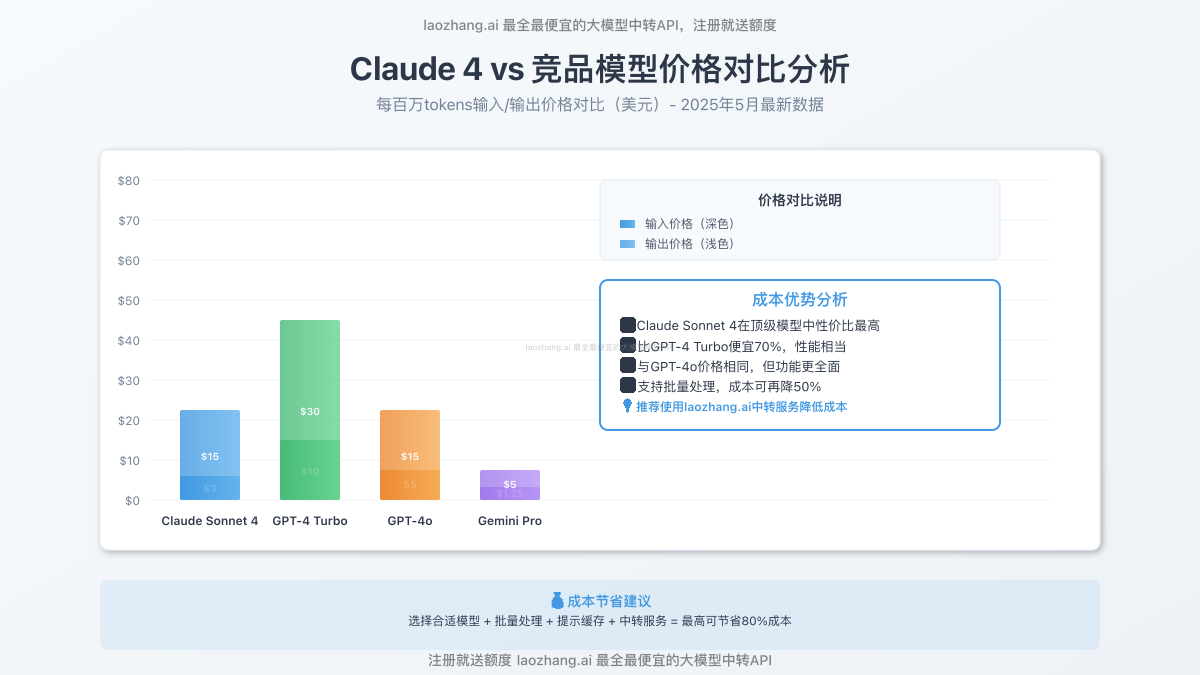

2.2 与竞品价格对比

| 模型 | 输入价格 | 输出价格 | 性能等级 |

|---|---|---|---|

| Claude Sonnet 4 | $3.00 | $15.00 | 顶级 |

| GPT-4 Turbo | $10.00 | $30.00 | 顶级 |

| GPT-4o | $5.00 | $15.00 | 顶级 |

| Gemini Pro | $1.25 | $5.00 | 高级 |

从价格角度看,Claude Sonnet 4在顶级模型中具有明显的成本优势。

三、购买方式全面对比

3.1 官方渠道 vs 中转服务详细对比

选择合适的购买渠道对总体使用成本有重要影响。以下是两种主要购买方式的详细对比:

| 对比维度 | 官方API | laozhang.ai中转服务 |

|---|---|---|

| 价格 | 标准官方价格 | 同等价格,无汇率损失 |

| 付款方式 | 国外信用卡 | 支付宝、微信、银行卡 |

| 实名验证 | 需要身份证明 | 无需实名,即注册即用 |

| 地域限制 | 部分地区不可用 | 全球无限制访问 |

| 技术支持 | 英文客服 | 中文技术支持 |

| 到账时间 | 立即生效 | 立即生效 |

| 额度管理 | 按月结算 | 预付费充值 |

| 新用户福利 | 无 | 注册即送免费额度 |

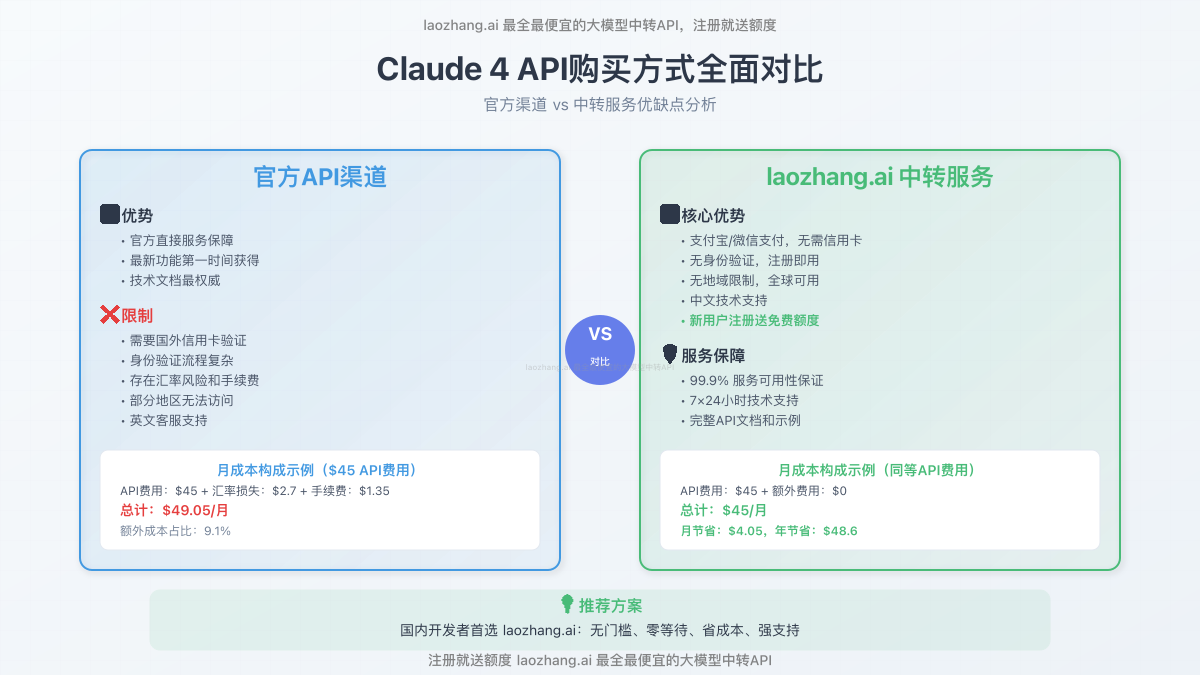

3.2 官方购买流程与限制

官方购买的主要限制:

-

支付门槛高:

- 必须使用VISA、MasterCard等国际信用卡

- 需要通过银行验证和地址确认

- 部分地区信用卡可能被拒绝

-

身份验证复杂:

- 需要提供英文地址信息

- 某些情况下需要护照或身份证明

- 审核周期可能长达3-5个工作日

-

汇率风险:

- 美元计费,存在汇率波动风险

- 银行可能收取外汇手续费(通常1-3%)

- 每月账单金额难以精确预估

3.3 laozhang.ai中转服务优势

作为国内领先的AI模型中转服务提供商,laozhang.ai 为用户提供以下核心优势:

🎯 无障碍访问:

- 支持支付宝、微信支付、银行卡充值

- 无需国外信用卡,无需身份验证

- 注册后立即可用,无等待时间

💰 成本优化:

- 提供官方同等价格,无额外费用

- 避免汇率损失和银行手续费

- 新用户注册即送50元免费额度

🛠️ 技术保障:

- 99.9%服务可用性承诺

- 7×24小时中文技术支持

- 完善的API文档和集成示例

📊 使用管理:

- 实时用量监控和成本分析

- 灵活的额度管理和自动充值

- 详细的使用报表和成本优化建议

💡 专家建议:对于国内开发者,推荐优先选择laozhang.ai中转服务。不仅省去了复杂的申请流程,还能避免支付和汇率问题,让您专注于产品开发。

3.4 成本节省案例分析

让我们通过一个实际案例来说明使用中转服务的成本优势:

案例:中型企业AI客服系统

- 月均使用量:Claude Sonnet 4处理500万输入tokens,200万输出tokens

- 官方渠道总成本:$45(API费用)+ $2.7(汇率损失3%)+ $1.35(银行手续费)= $49.05

- laozhang.ai渠道成本:$45(API费用)= $45

- 月节省:$4.05,年节省:$48.6

对于大规模使用场景,这样的节省是相当可观的。

四、成本优化实战策略

4.1 技术层面优化方案

通过合理的技术策略,可以在保证服务质量的前提下大幅降低Claude 4的使用成本:

1. 智能模型选择策略

根据任务复杂度选择最合适的模型版本:

- 简单任务 → Claude Haiku 3.5:客服回复、内容摘要、简单翻译

- 中等任务 → Claude Sonnet 4:代码生成、技术写作、复杂分析

- 复杂任务 → Claude Opus 4:创意写作、深度推理、复杂问题解决

成本节省示例:

- 将70%的简单任务从Sonnet 4迁移到Haiku 3.5

- 月成本从$67.5降至$28.5,节省$39/月(58%)

2. 批量处理优化

对于非实时要求的任务,使用批量API可享受50%折扣:

python# 使用laozhang.ai批量处理示例

import requests

import json

def batch_process_with_laozhang(tasks):

"""

批量处理多个任务,享受50%价格优惠

"""

url = "https://api.laozhang.ai/v1/batch"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

batch_request = {

"model": "claude-3-5-sonnet-20241022",

"requests": []

}

for i, task in enumerate(tasks):

batch_request["requests"].append({

"custom_id": f"task_{i}",

"method": "POST",

"url": "/v1/messages",

"body": {

"model": "claude-3-5-sonnet-20241022",

"max_tokens": 1000,

"messages": [{"role": "user", "content": task}]

}

})

response = requests.post(url, headers=headers, json=batch_request)

return response.json()

# 示例用法

tasks = [

"分析这段代码的性能问题",

"生成产品功能说明文档",

"翻译以下技术文档"

]

result = batch_process_with_laozhang(tasks)

3. 提示缓存策略

对于包含重复上下文的任务,使用提示缓存可显著降低成本:

pythondef optimize_with_prompt_cache(base_context, queries):

"""

使用提示缓存优化重复上下文的处理

"""

url = "https://api.laozhang.ai/v1/messages"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

# 首次请求,建立缓存

first_request = {

"model": "claude-3-5-sonnet-20241022",

"max_tokens": 1000,

"messages": [

{

"role": "user",

"content": [

{

"type": "text",

"text": base_context,

"cache_control": {"type": "ephemeral"}

}

]

},

{"role": "user", "content": queries[0]}

]

}

# 后续请求将使用缓存,成本仅为10%

response = requests.post(url, headers=headers, json=first_request)

return response.json()

4.2 使用量管理策略

1. 实时监控与预警

通过laozhang.ai提供的监控工具,实时掌握使用情况:

- 设置日/月使用量上限

- 配置成本预警阈值

- 分析使用模式,优化调用时机

2. 负载均衡策略

- 高峰时段:使用批量处理延迟非紧急任务

- 低峰时段:处理大批量数据分析任务

- 实时任务:仅用于真正需要即时响应的场景

3. 缓存与去重

pythonimport hashlib

import redis

class QueryOptimizer:

def __init__(self):

self.redis_client = redis.Redis(host='localhost', port=6379, db=0)

self.cache_ttl = 3600 # 1小时缓存

def get_cache_key(self, query):

"""生成查询缓存键"""

return f"claude_cache:{hashlib.md5(query.encode()).hexdigest()}"

def cached_query(self, query):

"""检查缓存,避免重复请求"""

cache_key = self.get_cache_key(query)

cached_result = self.redis_client.get(cache_key)

if cached_result:

return json.loads(cached_result)

# 调用API

result = self.call_claude_api(query)

# 存储结果到缓存

self.redis_client.setex(

cache_key,

self.cache_ttl,

json.dumps(result)

)

return result

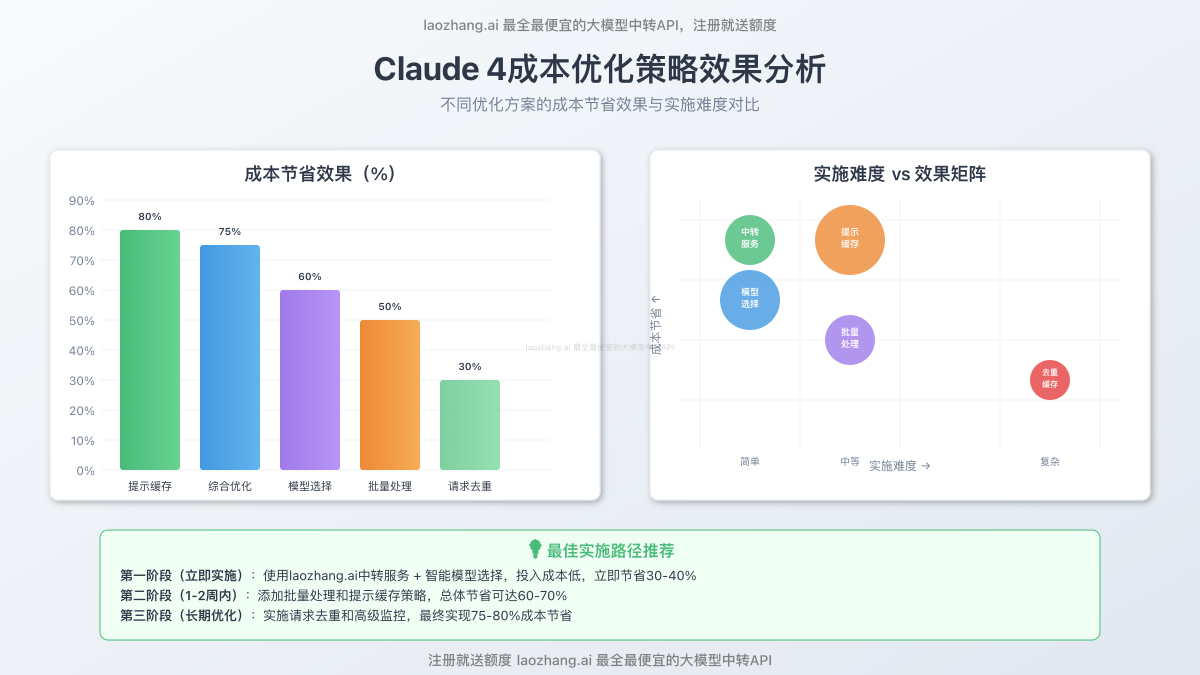

4.3 成本效益分析表

| 优化策略 | 实施难度 | 预期节省 | 适用场景 |

|---|---|---|---|

| 模型选择优化 | 简单 | 30-60% | 所有用户 |

| 批量处理 | 中等 | 50% | 非实时任务 |

| 提示缓存 | 中等 | 70-90% | 重复上下文 |

| 使用laozhang.ai | 简单 | 5-10% | 所有用户 |

| 请求去重 | 复杂 | 20-40% | 高重复场景 |

| 负载均衡 | 中等 | 15-25% | 大规模应用 |

综合优化效果: 通过组合使用以上策略,总体成本节省可达70-80%,同时保持服务质量不变。

4.4 最佳实践建议

-

分阶段实施:

- 第一阶段:模型选择优化 + laozhang.ai中转

- 第二阶段:加入批量处理和缓存策略

- 第三阶段:完善监控和自动化优化

-

持续优化:

- 每月分析使用报表,调整策略

- 关注新功能发布,及时采用成本优化特性

- 定期评估ROI,确保优化策略的有效性

-

风险控制:

- 设置合理的使用上限

- 建立多层级的成本预警机制

- 保留一定的缓冲预算应对突发需求

五、技术集成指南

5.1 快速开始:laozhang.ai接入指南

第一步:注册与获取API Key

- 访问 laozhang.ai注册页面

- 完成账户注册,获得50元免费额度

- 在控制台获取您的API Key

第二步:基本接入代码

pythonimport requests

import json

class ClaudeAPIClient:

def __init__(self, api_key):

self.api_key = api_key

self.base_url = "https://api.laozhang.ai/v1"

def send_message(self, model="claude-3-5-sonnet-20241022",

messages=None, max_tokens=1000):

"""

发送消息到Claude API

"""

url = f"{self.base_url}/messages"

headers = {

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json",

"anthropic-version": "2023-06-01"

}

payload = {

"model": model,

"max_tokens": max_tokens,

"messages": messages or [

{"role": "user", "content": "Hello, Claude!"}

]

}

response = requests.post(url, headers=headers, json=payload)

return response.json()

# 使用示例

client = ClaudeAPIClient("your-api-key-here")

result = client.send_message(

messages=[{"role": "user", "content": "解释什么是机器学习"}]

)

print(result)

5.2 高级功能集成

多轮对话管理

pythonclass ConversationManager:

def __init__(self, api_client):

self.client = api_client

self.conversation_history = []

def add_message(self, role, content):

"""添加消息到对话历史"""

self.conversation_history.append({

"role": role,

"content": content

})

def send_with_history(self, user_message, model="claude-3-5-sonnet-20241022"):

"""发送带历史的消息"""

self.add_message("user", user_message)

response = self.client.send_message(

model=model,

messages=self.conversation_history,

max_tokens=2000

)

if "content" in response and response["content"]:

assistant_message = response["content"][0]["text"]

self.add_message("assistant", assistant_message)

return response

def clear_history(self):

"""清空对话历史"""

self.conversation_history = []

错误处理与重试机制

pythonimport time

from typing import Optional

class RobustClaudeClient:

def __init__(self, api_key):

self.client = ClaudeAPIClient(api_key)

self.max_retries = 3

self.base_delay = 1

def send_with_retry(self, messages, model="claude-3-5-sonnet-20241022"):

"""带重试机制的请求"""

for attempt in range(self.max_retries):

try:

response = self.client.send_message(

model=model,

messages=messages

)

if "error" not in response:

return response

# 处理特定错误

if response.get("error", {}).get("type") == "rate_limit_error":

delay = self.base_delay * (2 ** attempt)

print(f"触发限流,等待 {delay} 秒后重试...")

time.sleep(delay)

continue

except Exception as e:

print(f"请求失败,尝试 {attempt + 1}/{self.max_retries}: {e}")

if attempt == self.max_retries - 1:

raise

time.sleep(self.base_delay * (2 ** attempt))

raise Exception("所有重试都失败了")

5.3 成本监控与管理

pythonclass CostMonitor:

def __init__(self, api_client):

self.client = api_client

self.usage_log = []

def log_usage(self, model, input_tokens, output_tokens, cost):

"""记录使用情况"""

usage_record = {

"timestamp": time.time(),

"model": model,

"input_tokens": input_tokens,

"output_tokens": output_tokens,

"cost": cost

}

self.usage_log.append(usage_record)

def get_daily_cost(self, date=None):

"""获取指定日期的成本"""

if date is None:

date = time.strftime("%Y-%m-%d")

daily_cost = 0

for record in self.usage_log:

record_date = time.strftime(

"%Y-%m-%d",

time.localtime(record["timestamp"])

)

if record_date == date:

daily_cost += record["cost"]

return daily_cost

def estimate_cost(self, model, input_tokens, output_tokens):

"""估算成本"""

pricing = {

"claude-3-5-sonnet-20241022": {"input": 3.0, "output": 15.0},

"claude-3-haiku-20240307": {"input": 0.8, "output": 4.0},

"claude-3-opus-20240229": {"input": 15.0, "output": 75.0}

}

if model not in pricing:

return 0

input_cost = (input_tokens / 1_000_000) * pricing[model]["input"]

output_cost = (output_tokens / 1_000_000) * pricing[model]["output"]

return input_cost + output_cost

六、常见问题解答

6.1 定价相关问题

Q: Claude 4的价格为什么比GPT-4便宜?

A: Claude 4采用了更高效的架构设计和训练方法,同时Anthropic选择了更激进的定价策略来获取市场份额。相比GPT-4 Turbo,Claude Sonnet 4的价格便宜70%,但性能相当甚至在某些任务上更优秀。

Q: 批量处理50%的折扣有什么限制吗?

A: 批量处理主要限制是:

- 非实时处理,通常有24小时的处理周期

- 最少请求数量要求(通常100个请求起)

- 结果返回格式为JSON文件

- 适合数据分析、内容生成等离线任务

Q: 提示缓存的效果到底有多好?

A: 提示缓存在重复上下文场景下效果显著:

- 缓存命中时成本仅为正常价格的10%

- 典型场景如代码审查、文档问答可节省80-90%成本

- 缓存有效期5分钟-1小时,根据具体设置而定

6.2 技术集成问题

Q: laozhang.ai的API接口与官方兼容吗?

A: 完全兼容。laozhang.ai提供与Anthropic官方完全一致的API接口,您可以:

- 直接替换API端点,无需修改代码逻辑

- 使用相同的SDK和集成库

- 保持相同的请求/响应格式

Q: 如何处理API调用的限流问题?

A: 建议实施以下策略:

- 实现指数退避重试机制

- 设置合理的并发请求数量

- 监控响应头中的限流信息

- 对非紧急任务使用批量处理

Q: 支持哪些编程语言?

A: Claude API支持所有能发送HTTP请求的编程语言,官方和社区提供了主流语言的SDK:

- Python:

anthropic库 - JavaScript/Node.js:

@anthropic-ai/sdk - Java: 官方Java SDK

- Go: 社区维护的Go SDK

6.3 成本优化问题

Q: 小团队如何最快实现成本优化?

A: 推荐三步走策略:

- 立即执行:注册laozhang.ai,使用中转服务(节省5-10%)

- 一周内:分析任务复杂度,选择合适模型(节省30-60%)

- 一月内:实施批量处理和缓存策略(总节省70%+)

Q: 大规模应用如何降低成本?

A: 大规模应用建议:

- 建立完善的监控体系

- 实施智能路由,根据任务自动选择模型

- 使用机器学习预测使用模式,提前优化

- 与laozhang.ai商谈企业级定制方案

七、总结与行动建议

7.1 核心要点回顾

通过本文的深度分析,我们可以得出以下关键结论:

- 价格优势明显:Claude 4在同级别模型中具有显著的成本优势,特别是Sonnet 4版本

- 优化空间巨大:通过合理的技术策略,总体成本可降低70-80%

- laozhang.ai价值:中转服务不仅解决了访问门槛,还提供了额外的成本节省

7.2 立即行动计划

🚀 立即开始(今天就做):

- 访问 laozhang.ai注册页面 注册账户

- 获取50元免费额度,开始测试Claude 4 API

- 评估当前项目中可以替换为Claude的部分

📈 第一周目标:

- 分析现有AI任务的复杂度分布

- 制定模型选择策略(简单→Haiku,复杂→Sonnet/Opus)

- 实施基本的成本监控

🎯 第一月目标:

- 完成批量处理系统搭建

- 实施提示缓存优化

- 建立自动化成本控制机制

7.3 长期优化建议

- 持续学习:关注Claude新版本和定价变化

- 技术升级:定期更新优化策略和工具

- 社区参与:加入相关技术社区,分享经验

- 数据驱动:基于实际使用数据持续优化策略

💡 最后提醒:AI技术发展迅速,价格策略也会不断调整。建议订阅laozhang.ai的更新通知,第一时间获取最新的优惠政策和技术更新。

通过本指南的实施,您不仅能够显著降低Claude 4的使用成本,还能建立起一套可持续的AI成本优化体系。立即开始行动,让先进的AI技术为您的项目创造更大价值!

本文数据更新至2025年5月,如需获取最新价格信息,请访问官方网站或laozhang.ai平台。