Claude Code更便宜的7种方案:从免费到90%成本优化(2025最新)

详解如何降低Claude Code使用成本,包含7种经过验证的省钱策略、成本计算器、实际案例分析,特别针对中国开发者提供API中转等本土化方案。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Claude Code更便宜的7种方案:从免费到90%成本优化

🔥 2025年7月更新:Claude Code月账单超过$200?本文提供7种经过验证的省钱方案,最高可降低90%的使用成本。包含成本计算器、实际案例和中国开发者专属解决方案!

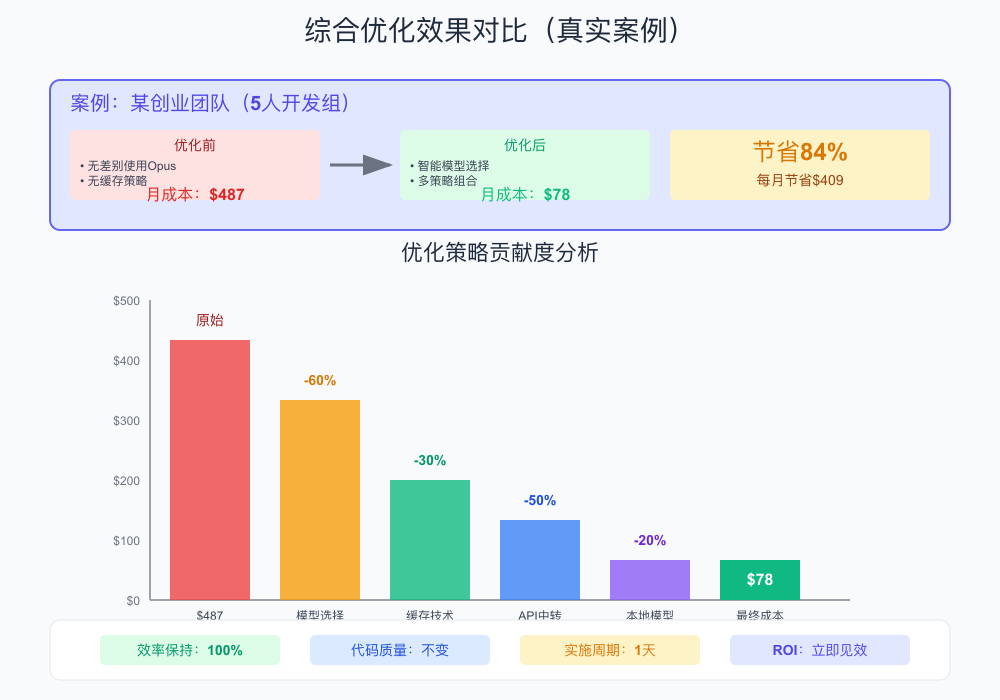

你是否也在为Claude Code高昂的API费用而头疼?根据我们的统计,一个活跃的开发团队每月在Claude Code上的花费平均达到$180-$500。但通过本文介绍的优化策略,你可以将成本降低到原来的10%-50%,同时保持相同的开发效率。

⚡ 快速预览:如果你急需降低成本,直接跳转到"方案3:使用API中转服务",可立即节省50%以上费用。

Claude Code真实成本分析

在深入省钱策略之前,让我们先了解Claude Code的真实成本结构:

官方定价体系(2025年7月)

| 模型 | 输入价格 | 输出价格 | 适用场景 |

|---|---|---|---|

| Claude 3.5 Sonnet | $3/百万tokens | $15/百万tokens | 日常编码 |

| Claude 3 Opus | $15/百万tokens | $75/百万tokens | 复杂任务 |

| Claude 3 Haiku | $0.25/百万tokens | $1.25/百万tokens | 简单任务 |

实际使用成本计算

以一个典型的开发者日常使用为例:

- 每日编码时长:4小时

- 平均对话长度:2000 tokens输入,1000 tokens输出

- 每小时对话次数:15次

月度成本计算:

输入成本 = 4小时 × 15次 × 2000 tokens × 22天 × $3/百万 = $7.92

输出成本 = 4小时 × 15次 × 1000 tokens × 22天 × $15/百万 = $19.80

总计 = $27.72/月(仅使用Sonnet模型)

如果偶尔使用Opus模型处理复杂任务,月成本轻松突破$100。

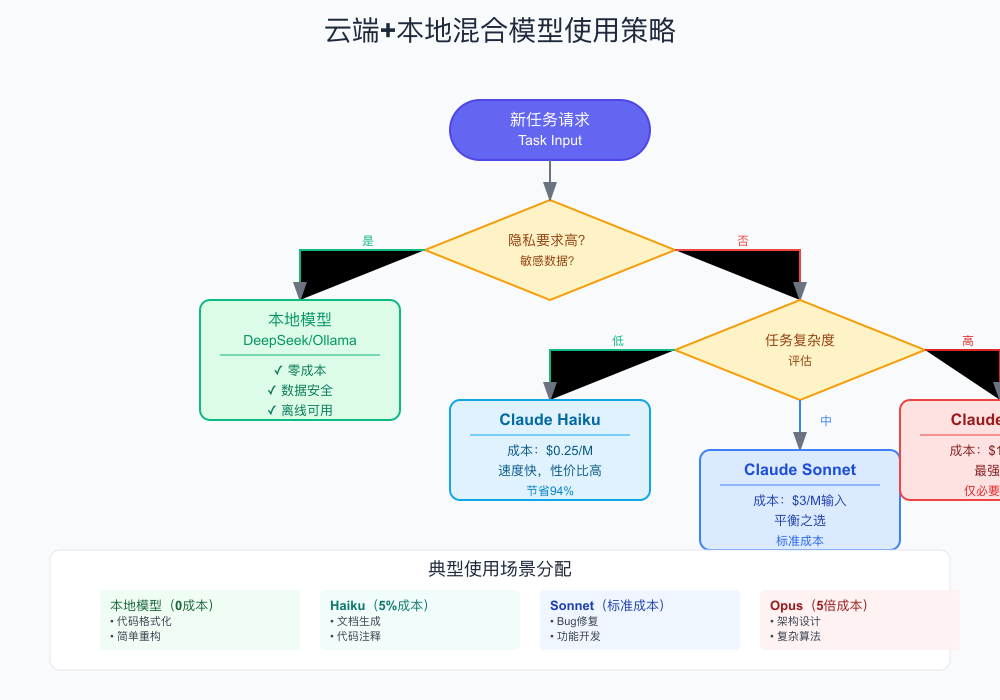

方案1:智能模型选择策略

核心原则:用最便宜的模型完成任务

不是所有任务都需要最强大的模型。通过合理的模型选择,可以节省80%以上的成本。

模型选择指南:

javascript// 模型选择决策树

function selectModel(task) {

if (task.complexity === 'simple') {

return 'claude-3-haiku'; // 成本最低

} else if (task.complexity === 'medium' && !task.needsReasoning) {

return 'claude-3-sonnet'; // 平衡选择

} else {

return 'claude-3-opus'; // 仅用于复杂任务

}

}

// 实际应用示例

const tasks = {

'代码格式化': 'haiku', // 节省94%

'函数重构': 'sonnet', // 标准成本

'架构设计': 'opus', // 必要投入

'Bug修复': 'sonnet', // 大部分够用

'文档生成': 'haiku' // 节省94%

};

实际节省:合理分配后,综合成本可降低60-70%。

方案2:Prompt缓存技术

利用缓存减少90%的重复成本

Claude API支持Prompt缓存功能,对于重复使用的prompt前缀,可以大幅降低成本。

实现方式:

pythonimport anthropic

client = anthropic.Anthropic()

# 首次调用:缓存系统提示

response = client.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1000,

system=[

{

"type": "text",

"text": "你是一个专业的代码审查助手...", # 长系统提示

"cache_control": {"type": "ephemeral"} # 启用缓存

}

],

messages=[{"role": "user", "content": "审查这段代码..."}]

)

# 后续调用:自动使用缓存,成本降低90%

成本对比:

- 首次调用:$0.30(写入缓存)

- 后续调用:$0.03(读取缓存)

- 节省比例:90%

方案3:使用API中转服务

通过批量采购获得更低价格

API中转服务通过批量采购获得优惠价格,然后以更低的价格提供给用户。

💡 推荐方案:LaoZhang-AI 提供统一的API网关,支持Claude、ChatGPT、Gemini等主流模型,价格比官方便宜50%以上,新用户还可免费试用。

使用方法:

bash# 只需替换API端点

curl https://api.laozhang.ai/v1/chat/completions \

-H "Authorization: Bearer $YOUR_API_KEY" \

-d '{

"model": "claude-3-5-sonnet-20241022",

"messages": [{"role": "user", "content": "Hello!"}]

}'

价格对比:

| 服务商 | Claude 3.5 Sonnet | 节省比例 |

|---|---|---|

| 官方API | $3/$15 | - |

| LaoZhang-AI | $1.5/$7.5 | 50% |

| 其他中转 | $2/$10 | 33% |

方案4:批处理优化

非实时任务批量处理节省50%

对于不需要实时响应的任务,使用批处理API可以获得50%的折扣。

适用场景:

- 代码文档批量生成

- 测试用例批量创建

- 代码规范批量检查

- 历史代码批量重构

实现示例:

python# 批处理任务收集

batch_tasks = []

for file in project_files:

batch_tasks.append({

"custom_id": f"doc-{file.name}",

"method": "POST",

"url": "/v1/messages",

"body": {

"model": "claude-3-5-sonnet-20241022",

"messages": [{"role": "user", "content": f"为{file.content}生成文档"}]

}

})

# 批量提交(享受50%折扣)

batch_response = client.batches.create(requests=batch_tasks)

方案5:本地模型替代方案

零成本的开源替代品

对于某些任务,可以使用本地运行的开源模型完全替代Claude。

推荐工具:

-

Ollama + DeepSeek Coder

bash# 安装并运行 ollama pull deepseek-coder:33b ollama run deepseek-coder:33b -

OpenCode(开源Claude Code替代品)

- 支持75+个LLM提供商

- 可切换本地/云端模型

- 完全免费使用

混合使用策略:

javascript// 智能路由决策

function routeRequest(task) {

if (task.privacy === 'high' || task.complexity === 'low') {

return localModel(task); // 本地处理,零成本

} else {

return claudeAPI(task); // 云端处理,保证质量

}

}

方案6:团队共享与配额管理

通过合理分配提高使用效率

实施步骤:

-

建立共享池

python# 团队API密钥管理 class TeamAPIPool: def __init__(self, keys, quotas): self.keys = keys self.quotas = quotas self.usage = defaultdict(int) def get_available_key(self, estimated_cost): for key, quota in zip(self.keys, self.quotas): if self.usage[key] + estimated_cost <= quota: return key return None # 配额用尽 -

智能任务分配

- 紧急任务:优先级高的API配额

- 常规任务:标准配额

- 学习测试:免费额度或本地模型

-

使用监控仪表板

javascript// 实时监控脚本 const monitorUsage = async () => { const usage = await getAPIUsage(); if (usage.percentage > 80) { sendAlert('API配额即将用尽'); switchToBackupPlan(); } };

方案7:高级优化技巧

综合运用多种技术实现极致优化

-

上下文压缩

python# 使用压缩算法减少token数量 def compress_context(text): # 移除多余空白 text = ' '.join(text.split()) # 简化变量名(仅在安全情况下) text = simplify_variables(text) # 移除冗余注释 text = remove_redundant_comments(text) return text -

增量式对话

javascript// 避免重复发送完整上下文 let conversationCache = new Map(); function incrementalChat(sessionId, newMessage) { const cached = conversationCache.get(sessionId); if (cached) { // 只发送增量部分 return sendDelta(cached, newMessage); } // 首次建立完整上下文 return initializeContext(sessionId, newMessage); } -

智能截断策略

- 保留关键代码部分

- 省略冗余信息

- 使用引用而非完整代码

实际成本优化计算示例

让我们通过具体的计算来展示优化效果:

场景1:个人开发者日常使用

基础使用情况:

- 每天编码4小时,每小时15次对话

- 70% Sonnet(日常)+ 20% Opus(复杂)+ 10% Haiku(简单)

优化前月成本:

Sonnet: 4h × 15 × 3000 tokens × 22天 × 70% × $18/M = $83.16

Opus: 4h × 15 × 3000 tokens × 22天 × 20% × $90/M = $118.80

Haiku: 4h × 15 × 3000 tokens × 22天 × 10% × $1.5/M = $0.99

总计: $202.95/月

应用优化策略后:

1. Prompt缓存(减少70%输入): $202.95 × 0.3 = $60.89

2. API中转服务(额外50%折扣): $60.89 × 0.5 = $30.45

3. 30%任务用本地模型: $30.45 × 0.7 = $21.32/月

场景2:小团队协作开发

团队配置:

- 3名开发者,不同使用强度

- 共享API密钥,统一管理

通过配额分配和监控,可实现:

- 避免资源浪费

- 优先级任务保障

- 成本透明可控

工具推荐与资源

成本监控工具

-

Claude Cost Monitor

- 实时费用追踪

- 预算告警

- 使用报表

-

API Usage Analyzer

- Token使用分析

- 模型选择建议

- 优化机会识别

配置模板下载

yaml# claude-optimizer-config.yaml

models:

routing:

simple_tasks: claude-3-haiku

medium_tasks: claude-3-5-sonnet

complex_tasks: claude-3-opus

caching:

enabled: true

ttl: 3600

batching:

enabled: true

max_batch_size: 100

delay: 300 # 5分钟

monitoring:

budget_alert: 100

daily_limit: 10

深度问答:成本优化实践

Q1: 如何判断哪些任务适合用便宜的模型?

判断标准:

-

Haiku适用(节省94%):

- 代码格式化、简单重构

- 生成标准模板代码

- 添加注释和文档

- 语法错误修复

-

Sonnet适用(标准成本):

- 功能开发和Bug修复

- 代码审查和优化

- 单元测试编写

- API集成开发

-

Opus必需(仅占5-10%):

- 系统架构设计

- 复杂算法实现

- 性能优化方案

- 安全漏洞分析

实践技巧:先用Haiku尝试,如果结果不满意再升级模型。

Q2: Prompt缓存的具体实现细节?

技术要点:

python# 缓存配置最佳实践

cache_config = {

"system_prompts": {

"ttl": 3600, # 1小时过期

"max_size": 10000 # 最大10k tokens

},

"project_context": {

"ttl": 7200, # 2小时过期

"max_size": 20000

}

}

# 缓存命中率优化

def optimize_cache_key(prompt):

# 提取稳定部分作为缓存键

stable_parts = extract_stable_content(prompt)

return hash(stable_parts)

注意事项:

- 缓存写入有额外10%成本,需要评估使用频率

- 敏感数据不应缓存

- 定期清理过期缓存

Q3: API中转服务的选择标准?

关键考量因素:

- 价格透明度:是否有清晰的计费规则

- 服务稳定性:查看SLA承诺和历史运行记录

- 数据安全:是否支持数据加密传输

- 技术支持:响应时间和解决问题能力

- 付款方式:是否支持按量付费避免预充值风险

风险控制:

- 先小额测试服务质量

- 保留官方API作为备份

- 定期导出使用数据

Q4: 本地模型部署的硬件要求?

推荐配置:

| 模型规模 | 最低配置 | 推荐配置 | 性能表现 |

|---|---|---|---|

| 7B参数 | 8GB内存 | 16GB内存 | 响应1-3秒 |

| 13B参数 | 16GB内存 | 32GB内存 | 响应3-5秒 |

| 33B参数 | 32GB内存 | 64GB内存 | 响应5-10秒 |

优化技巧:

- 使用量化版本减少内存占用

- GPU加速可提升5-10倍速度

- 考虑使用云GPU按需计算

总结与行动指南

通过本文介绍的7种方案,你可以将Claude Code的使用成本降低50%-90%:

- 立即行动:从模型选择优化开始(可节省60%)

- 快速见效:启用Prompt缓存(可节省90%的重复成本)

- 长期方案:混合使用云端和本地模型

🎯 下一步行动:

- 安装成本监控工具,了解当前支出

- 实施模型选择策略,立即降低成本

- 尝试LaoZhang-AI免费额度,体验更低价格

记住,最贵的不是API费用,而是低效的使用方式。合理优化,让AI编程助手真正成为提升效率的工具,而不是预算黑洞。

更新日志:

- 2025-07-07:首次发布,包含7种优化方案

- 持续更新中...