Claude Opus 4.5 vs Gemini 3深度对比:2025年最强AI模型选择指南【完整评测】

Claude Opus 4.5和Gemini 3 Pro谁更强?本文从Benchmark性能、编程能力、多模态理解、API定价等10个维度深度对比,帮助开发者做出最佳选择。含中国访问方案和代码示例。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Claude Opus 4.5 vs Gemini 3:如何选择最适合你的AI模型?

2025年11月,AI模型领域迎来了一场史无前例的巅峰对决。Google DeepMind于11月18日发布Gemini 3 Pro,宣称这是"有史以来最智能的模型"。仅仅一周后,Anthropic以Claude Opus 4.5强势回应,同样声称是"世界上最智能的模型"。两家公司几乎同时发布旗舰产品,让开发者陷入了选择困难:Claude Opus 4.5 vs Gemini 3,到底谁更强?

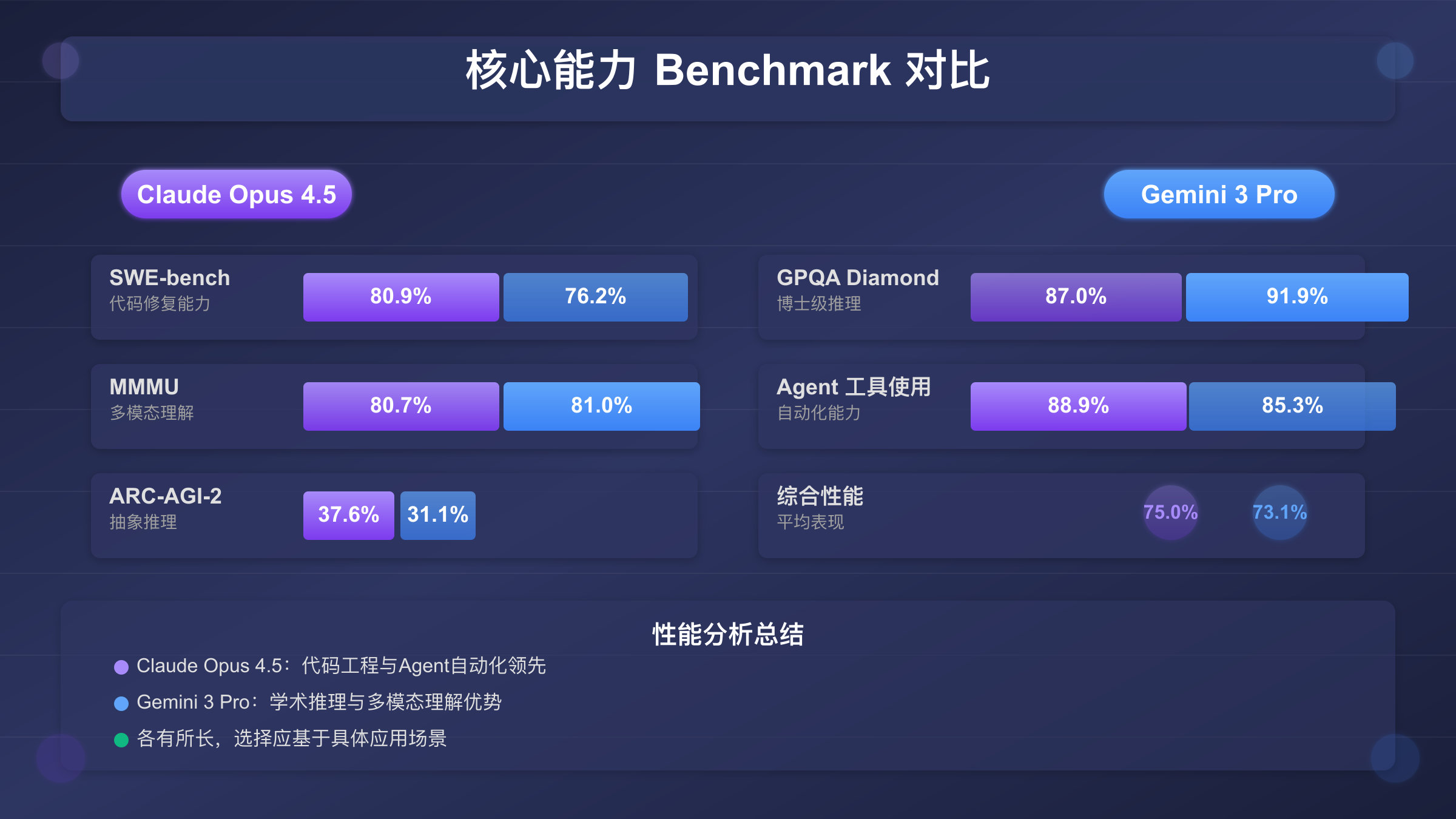

这不是一个简单的"谁更好"的问题。根据Vellum AI的独立评测,Claude Opus 4.5在SWE-bench编程测试中以80.9%的准确率登顶,比Gemini 3 Pro高出4.7个百分点。但Gemini 3 Pro在GPQA Diamond测试中达到91.9%——这是由博士生出题、博士生作答的专业科学问答基准,比Claude高出近5个百分点。两个模型的定位截然不同:Claude专注于"可靠的代码生成和Agent执行",Gemini则押注"多模态理解和超长上下文"。

本文将基于2025年11月最新版本,通过10个维度的深度对比,为你提供三个核心价值:真实Benchmark解读(不只是数据,更解释为什么)、场景化选择指南(6大应用场景的明确推荐)、中国开发者完整方案(从API访问到成本优化)。无论你是技术选型负责人、独立开发者,还是AI研究者,都能在这里找到明确答案。

基础参数全面对比

在深入分析Claude Opus 4.5 vs Gemini 3的性能差异之前,我们先从8个核心维度建立全局认知。这两款模型的发布时间仅相隔一周,但技术路线和产品定位存在根本差异。

| 对比维度 | Claude Opus 4.5 | Gemini 3 Pro | 差异分析 |

|---|---|---|---|

| 发布日期 | 2025年11月24日 | 2025年11月18日 | Anthropic反应迅速 |

| 上下文窗口 | 200K tokens | 1M tokens | Gemini 5倍优势 |

| 最大输出 | 64K tokens | 64K tokens | 持平 |

| 支持模态 | 文本+图像 | 文本+图像+视频+音频 | Gemini完全领先 |

| 输入价格 | $5/百万tokens | $2/百万tokens | Gemini 便宜60% |

| 输出价格 | $25/百万tokens | $12/百万tokens | Gemini 便宜52% |

| 知识截止 | 2025年3月 | 2025年1月 | Claude更新 |

| 主打场景 | 编程+Agent+安全 | 推理+多模态+长文档 | 定位互补 |

从这个对比表格可以得出三个关键结论:

第一,成本敏感用户应优先考虑Gemini 3 Pro。输入Token便宜60%,输出Token便宜52%,对于高频调用的应用(如智能客服、内容生成),月成本差异可达数万美元。但这只是表面数字,后文会详细分析Token效率对实际成本的影响。

第二,多模态需求必选Gemini 3 Pro。Claude Opus 4.5虽然支持图像输入,但不支持视频和音频。如果你的应用涉及视频分析、语音转录、多媒体内容处理,Gemini是唯一选择。这不是性能差距,而是能力边界的根本差异。

第三,上下文长度差异比想象中更重要。Gemini的1M tokens上下文窗口是Claude的5倍,这意味着它可以一次性处理约75万中文字符(相当于一本完整的技术书籍),而Claude的200K tokens只能处理约15万字符。对于需要分析整个代码库、处理法律合同集合、或进行跨文档知识问答的场景,这个差距是决定性的。

编程能力深度对比:谁才是真正的代码之王?

编程能力是开发者最关心的维度,也是Claude Opus 4.5和Gemini 3 Pro竞争最激烈的领域。但"编程能力"本身是一个模糊的概念——是代码生成速度?还是代码质量?还是解决复杂问题的能力?让我们通过权威Benchmark数据,结合技术原理分析,给出全面的答案。

| 测试项目 | Claude Opus 4.5 | Gemini 3 Pro | 差异 | 测试内容 |

|---|---|---|---|---|

| SWE-bench Verified | 80.9% | 76.2% | Claude +4.7% | 真实GitHub issue修复 |

| SWE-bench Multilingual | 7/8语言领先 | 5/8语言领先 | Claude优势 | 多语言代码能力 |

| Terminal-Bench | 59.3% | 54.2% | Claude +5.1% | 终端命令操作 |

| WebDev Arena | - | 1487 Elo | Gemini领先 | 前端UI开发 |

| Aider Polyglot | +10.6%提升 | 基准 | Claude优势 | 代码辅助质量 |

SWE-bench测试的真正含义:这不是简单的代码补全测试。SWE-bench要求模型理解真实的GitHub issue描述、在大型代码库中定位问题代码、生成正确的修复补丁——这更接近日常开发中的Bug修复场景。Claude Opus 4.5的80.9%准确率意味着:给它一个真实的GitHub issue,它有超过80%的概率能正确修复问题。这个成绩比Gemini 3 Pro高出4.7个百分点,在统计上是显著差异。

为什么Claude在编程上更强? 根据Anthropic官方技术文档,Claude Opus 4.5引入了"effort参数"机制——开发者可以控制模型在解决问题时投入的"思考深度"。高effort设置下,模型会进行更多内部推理步骤,而不是直接输出答案。这种机制在复杂编程任务中效果显著:根据官方数据,高effort设置下SWE-bench准确率达到80.9%,而低effort只有约75%。

但Claude的编程优势并非全面碾压。Gemini 3 Pro在前端UI开发领域表现更好,WebDev Arena以1487 Elo登顶。这是因为Gemini采用统一的多模态架构,图像和文本在同一嵌入空间处理。它能像理解文字一样理解设计稿的视觉元素——间距、对齐、颜色关系。将Figma设计稿转换为响应式代码时,Gemini的理解更精准。

实际应用建议:复杂后端开发、系统架构设计、Bug修复选择Claude Opus 4.5;前端UI开发、设计稿转代码、快速原型开发选择Gemini 3 Pro。如果你的项目同时涉及前后端,考虑混合使用两个模型。

推理与知识能力:博士级智能的较量

推理能力测试需要区分通用推理和专业领域推理两个子类别。GPQA Diamond是目前最权威的专业推理测试,由物理、化学、生物等领域的博士生出题,并由博士生作答验证——这是真正的"博士级"难度。

| 测试类别 | 测试项目 | Claude Opus 4.5 | Gemini 3 Pro | 分析 |

|---|---|---|---|---|

| 博士级推理 | GPQA Diamond | 87.0% | 91.9% | Gemini +4.9% |

| 抽象推理 | ARC-AGI-2 | 37.6% | 31.1% | Claude +6.5% |

| 数学能力 | AIME 2025 (带代码) | - | 100% | Gemini满分 |

| 综合知识 | HLE (带搜索) | 43.2% | 37.5% | Claude +5.7% |

Gemini 3 Pro在GPQA Diamond测试中达到91.9%的准确率,这意味着它在回答专业科学问题时,正确率接近博士生水平。这个优势来源于Google的训练数据优势——DeepMind能够访问Google Scholar、Google Books等海量学术资源,使Gemini在科学知识的广度和深度上具备先天优势。

但Claude Opus 4.5在抽象推理方面表现更好。ARC-AGI-2测试要求模型发现隐藏规律、进行类比推理——这更接近人类的"智能"本质,而非知识检索。Claude的37.6%准确率比Gemini高出6.5个百分点,在这类"真智能"任务上优势明显。

Gemini的Deep Think模式值得特别关注。根据Google DeepMind的技术说明,Deep Think不是简单地增加推理步骤,而是采用"并行搜索+强化学习验证"的架构。模型会生成多条推理路径,用训练好的验证器评估每条路径的可靠性,最终选择置信度最高的答案。在ARC-AGI-2测试中,开启Deep Think模式后,Gemini的准确率从31.1%提升到45.1%——提升幅度达45%。但代价是3-5倍的响应时间和Token消耗。

核心结论:如果你的应用涉及科学研究、学术问答、专业领域分析,Gemini 3 Pro的推理能力更强。如果需要模型进行创造性思考、发现隐藏规律、处理全新问题,Claude Opus 4.5的抽象推理能力更可靠。

多模态能力:架构差异决定能力边界

在多模态领域,Claude Opus 4.5和Gemini 3 Pro存在架构层面的根本差异。这不是性能高低的问题,而是能力有无的区别。

Gemini从训练阶段就是多模态原生的——视频、音频、图像、文本在同一模型中联合训练,共享相同的表示空间。这意味着Gemini可以真正"理解"不同模态之间的关系:看到一张图片时,它不需要先转换成文字描述,而是直接在内部表示上进行推理。Claude则是以文本为核心,图像理解通过视觉编码器后期集成——图像首先被转换成某种中间表示,再与文本模型结合处理。

| 多模态能力 | Claude Opus 4.5 | Gemini 3 Pro | 实际影响 |

|---|---|---|---|

| 图像理解 | 80.7% (MMMU) | 81.0% (MMMU-Pro) | 基本持平 |

| 视频理解 | ❌ 不支持 | 87.6% (Video-MMMU) | Gemini独有 |

| 音频转录 | ❌ 不支持 | ✅ 支持 | Gemini独有 |

| 最长视频 | - | 1小时 | 基于1M上下文 |

| 跨模态推理 | 较弱 | 强 | 架构差异决定 |

这种架构差异在实际应用中意味着什么?假设你需要开发一个视频内容分析系统——自动提取视频关键信息、生成摘要、检测违规内容。使用Gemini 3 Pro,你可以直接上传视频文件,模型会同时分析视觉帧和音轨,理解画面与语音的对应关系。使用Claude,你需要先用其他工具提取视频帧和音频转录,然后分别处理,最后手动整合结果——复杂度和成本都大幅增加。

同样的逻辑适用于会议记录、教育内容分析、安防监控等场景。如果你的应用涉及任何视频或音频处理需求,Gemini 3 Pro是目前唯一的顶级选择。

价格成本全面分析:真实场景计算

"价格差异大吗?"是选择Claude Opus 4.5 vs Gemini 3时最常被问的问题。官方定价只是起点,真实的月度成本取决于你的应用场景、调用量、以及一个常被忽视的因素——Token效率。

官方定价对比

| 计费项 | Claude Opus 4.5 | Gemini 3 Pro | 差异 |

|---|---|---|---|

| 输入Token | $5.00/百万 | $2.00/百万 | Gemini便宜60% |

| 输出Token | $25.00/百万 | $12.00/百万 | Gemini便宜52% |

| 长上下文(>200K) | 同价 | $4/$18/百万 | 有额外费用 |

表面上看,Gemini的价格优势是压倒性的。但Claude Opus 4.5有一个重要特性:它倾向于生成更简洁、更精准的代码,而不是冗长的解释。这意味着完成相同任务时,Claude可能消耗更少的Token。

真实场景成本计算

场景:中型开发团队的代码助手

假设你的团队每月处理500个Bug修复任务,平均每个任务需要2000个输入Token(代码上下文)和3000个输出Token(修复代码+解释):

月度Token消耗:

- 输入:500 × 2,000 = 1,000,000 tokens

- 输出:500 × 3,000 = 1,500,000 tokens

Claude Opus 4.5成本:

- 输入:1M × $5/M = $5.00

- 输出:1.5M × $25/M = $37.50

- 月总成本:$42.50

Gemini 3 Pro成本:

- 输入:1M × $2/M = $2.00

- 输出:1.5M × $12/M = $18.00

- 月总成本:$20.00

名义节省:$22.50 (53%)

但这里有一个关键假设需要验证:两个模型完成相同任务的Token消耗是否相同?根据Anthropic的内部测试,Claude在编程任务中的Token效率比其他模型高30-40%。如果我们将这个因素纳入计算:

调整后的Token消耗(Claude效率+35%):

- Claude输出:1.5M tokens

- Gemini输出:1.5M × 1.35 = 2.025M tokens

调整后成本:

- Claude:$5.00 + $37.50 = $42.50

- Gemini:$2.00 + (2.025M × $12/M) = $26.30

实际节省:$16.20 (38%)

成本结论:即使考虑Token效率差异,Gemini 3 Pro在成本上仍有约38%的优势。但对于追求代码质量、愿意为更高准确率买单的团队,Claude的性价比并不差。

Agent与自动化:可靠性决定成败

Agent系统的核心挑战不是单次响应质量,而是多步骤执行的累积可靠性。这是一个数学问题:假设每步成功率95%,执行10步后整体成功率仅为59%(0.95^10);而如果每步成功率提升到99%,10步后整体成功率达到90%(0.99^10)。3.6%的单步差距会被指数级放大。

| Agent能力 | Claude Opus 4.5 | Gemini 3 Pro | 实际影响 |

|---|---|---|---|

| 工具调用准确率 | 88.9% | 85.3% | Claude +3.6% |

| 提示注入防护 | 4.7%攻击成功率 | 12.5%攻击成功率 | Claude更安全 |

| 收敛迭代次数 | 4次 | 10次以上 | Claude更快收敛 |

Claude Opus 4.5在Agent场景下的优势来自两个方面:

第一是工具调用的准确性。88.9%的准确率意味着在复杂的多步骤任务中,每一步出错的概率更低。根据Anthropic的TAU-bench测试,Claude Opus 4.5只需要4次迭代就能达到峰值性能,而其他模型通常需要10次以上。这意味着在实际开发中,Claude能更快地收敛到正确解决方案。

第二是安全性。4.7%的提示注入攻击成功率是目前所有前沿模型中最低的。Anthropic在Constitutional AI框架下训练Claude,使其具备更强的指令遵循和拒绝能力。对于需要处理用户上传内容或外部数据源的Agent系统,这种安全性是关键。想象一个自动化客服Agent处理用户邮件——如果用户邮件中包含恶意指令试图让Agent泄露系统信息,Claude有95.3%的概率能正确拒绝,而Gemini只有87.5%。

Agent开发建议:如果你正在构建需要长期稳定运行的自动化系统——客服机器人、数据管道、CI/CD流程——Claude Opus 4.5的可靠性优势值得为之付出更高的成本。

中国开发者完整方案

由于地区限制,Claude和Gemini的官方API在中国大陆都无法直接访问。这是一个现实问题,但有成熟的解决方案。

访问现状

| 访问方式 | Claude Opus 4.5 | Gemini 3 Pro | 说明 |

|---|---|---|---|

| 官方API直连 | ❌ 不支持 | ❌ 不支持 | IP封锁 |

| 香港直连 | ❌ 不支持 | ❌ 不支持 | 同样被封 |

| AWS Bedrock | ✅ 需企业账号 | - | 企业级方案 |

| Google Vertex AI | - | ✅ 需企业账号 | 企业级方案 |

| API中转服务 | ✅ 支持 | ✅ 支持 | 最简单方案 |

对于个人开发者和中小团队,API中转服务是最实用的方案。以laozhang.ai为例,它提供OpenAI兼容格式的统一API,同时支持Claude和Gemini模型,无需VPN即可在国内直接调用。

API调用示例

使用统一API调用Claude Opus 4.5:

pythonimport requests

API_KEY = "your-api-key"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# 调用Claude Opus 4.5

response = requests.post(API_URL, headers=headers, json={

"model": "claude-opus-4-5-20251101",

"messages": [

{"role": "user", "content": "请用Python实现一个高效的LRU缓存"}

]

})

print(response.json()["choices"][0]["message"]["content"])

切换到Gemini 3 Pro只需修改模型名称:

python# 同一API,只需切换模型名

response = requests.post(API_URL, headers=headers, json={

"model": "gemini-3-pro",

"messages": [

{"role": "user", "content": "分析这段代码的性能瓶颈"}

]

})

这种统一API的优势在于:你可以根据任务类型动态选择模型——编程任务路由到Claude,多模态任务路由到Gemini——而无需维护多个账号和SDK。

决策框架:如何选择最适合你的模型

经过前面的深度分析,我们可以构建一个清晰的决策框架。选择模型不应该追求"哪个更好",而是"哪个更适合你的场景"。

按核心需求选择

| 你的核心需求 | 推荐选择 | 关键理由 |

|---|---|---|

| 复杂后端开发 | Claude Opus 4.5 | SWE-bench 80.9%,Bug修复能力最强 |

| 前端UI开发 | Gemini 3 Pro | WebDev榜首,设计稿转代码更精准 |

| 视频/音频处理 | Gemini 3 Pro | 唯一支持原生多模态的选择 |

| Agent自动化 | Claude Opus 4.5 | 工具调用88.9%,安全性最高 |

| 学术研究 | Gemini 3 Pro | GPQA 91.9%,博士级推理能力 |

| 超长文档分析 | Gemini 3 Pro | 1M上下文,可处理整本书 |

| 安全敏感场景 | Claude Opus 4.5 | 4.7%攻击成功率,业界最低 |

| 成本敏感应用 | Gemini 3 Pro | 综合成本低38-55% |

混合使用策略

对于追求最优性能的团队,建议采用混合策略。通过laozhang.ai的统一API,可以在代码中根据任务类型动态路由:

pythondef choose_model(task_type, content):

"""根据任务类型选择最优模型"""

# 编程任务 → Claude更可靠

if task_type in ["bug_fix", "code_review", "architecture"]:

return "claude-opus-4-5-20251101"

# 多模态任务 → 只能选Gemini

if task_type in ["video_analysis", "audio_transcription", "image_understanding"]:

return "gemini-3-pro"

# 超长文档 → Gemini上下文更长

if len(content) > 150000: # 约100K tokens

return "gemini-3-pro"

# 推理任务 → Gemini略强

if task_type in ["scientific_qa", "math_proof"]:

return "gemini-3-pro"

# 默认使用Claude(更可靠的通用选择)

return "claude-opus-4-5-20251101"

这种策略让你能够同时发挥两个模型的优势,而不是被迫在一个"全能但平庸"的选项中妥协。

常见问题FAQ

Q1: Claude Opus 4.5和Gemini 3 Pro哪个更智能?

这个问题没有简单答案,因为"智能"是多维度的。在博士级科学推理上,Gemini 3 Pro(91.9% GPQA Diamond)更强;在复杂编程上,Claude Opus 4.5(80.9% SWE-bench)领先;在抽象推理上,Claude(37.6% ARC-AGI-2)更强。建议根据你的主要使用场景选择,而不是追求"最智能"的标签。

Q2: 两个模型的实际成本差多少?

名义定价上,Gemini 3 Pro约为Claude的45%。但考虑Token效率后,实际差距缩小到38%左右。对于编程任务,Claude生成的代码更简洁,可能消耗更少Token。对于多模态任务,只能选Gemini,无法比较。

Q3: 中国开发者如何选择?

两个模型在中国都无法直连。推荐使用API中转服务(如laozhang.ai),支持支付宝/微信支付,无需海外信用卡。可以同时访问两个模型,根据任务灵活切换。

Q4: 哪个模型更适合Agent开发?

Claude Opus 4.5更适合。工具调用准确率更高(88.9% vs 85.3%),提示注入防护更强(4.7% vs 12.5%攻击成功率),收敛更快(4次 vs 10次迭代)。Agent的可靠性取决于多步骤的累积成功率,Claude的优势会被指数级放大。

Q5: Gemini的Deep Think模式什么时候值得开启?

Deep Think会增加3-5倍的响应时间和Token消耗。对于ARC-AGI-2类抽象问题提升可达45%,对于复杂数学证明和科学推理提升约10%。但对于日常编程、文档总结、数据提取等任务,提升可能不到2%,不值得额外成本。

总结:2025年AI模型格局

Claude Opus 4.5和Gemini 3 Pro的同期发布,标志着AI模型竞争进入新阶段。两者不是简单的"谁更好"的关系,而是针对不同场景的最优解。

选择Claude Opus 4.5,如果你的核心需求是:复杂编程任务、Agent自动化、安全敏感应用、需要高可靠性的长期运行系统。

选择Gemini 3 Pro,如果你的核心需求是:多模态处理(视频/音频)、超长文档分析、学术研究、成本敏感的高频应用。

混合使用,如果你追求最优性能:编程任务用Claude,多模态用Gemini,通过统一API实现动态路由。

无论选择哪个模型,2025年的AI工具已经足够强大,能够显著提升开发效率。关键是找到最适合你场景的那一个——或者两个都用。