DeepSeek本地化部署完全指南:从入门到精通(2025最新版)

详解如何在Windows、macOS和Linux系统上本地部署DeepSeek模型,包括Ollama方案、Docker方案和命令行部署方法,以及性能优化与问题排查

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

DeepSeek本地化部署完全指南:从入门到精通(2025最新版)

随着人工智能技术的快速发展,大型语言模型(LLM)已经成为开发者和企业提升工作效率的重要工具。DeepSeek作为新兴的开源大语言模型,凭借其优异的性能和灵活的应用场景,吸引了众多用户的关注。本文将详细介绍如何在本地环境中部署DeepSeek模型,让您能够在保证数据隐私的同时,充分发挥AI的强大能力。

一、DeepSeek模型概述与本地部署优势

DeepSeek是一系列由北京深度求索科技有限公司(DeepSeek)开发的大型语言模型家族,其中最受欢迎的是DeepSeek-R1系列,包括不同参数规模的版本(1.5B、7B、14B、32B和70B)。

1.1 为什么选择本地部署DeepSeek?

相比于使用云端API,本地部署DeepSeek具有以下显著优势:

- 数据隐私安全:敏感信息不会离开本地环境,适合处理机密数据

- 降低成本:无需支付API调用费用,长期使用更经济

- 消除网络延迟:本地推理速度更快,用户体验更流畅

- 自定义灵活:可根据具体需求进行模型参数调整和优化

- 离线使用:不依赖互联网连接,适合网络受限环境

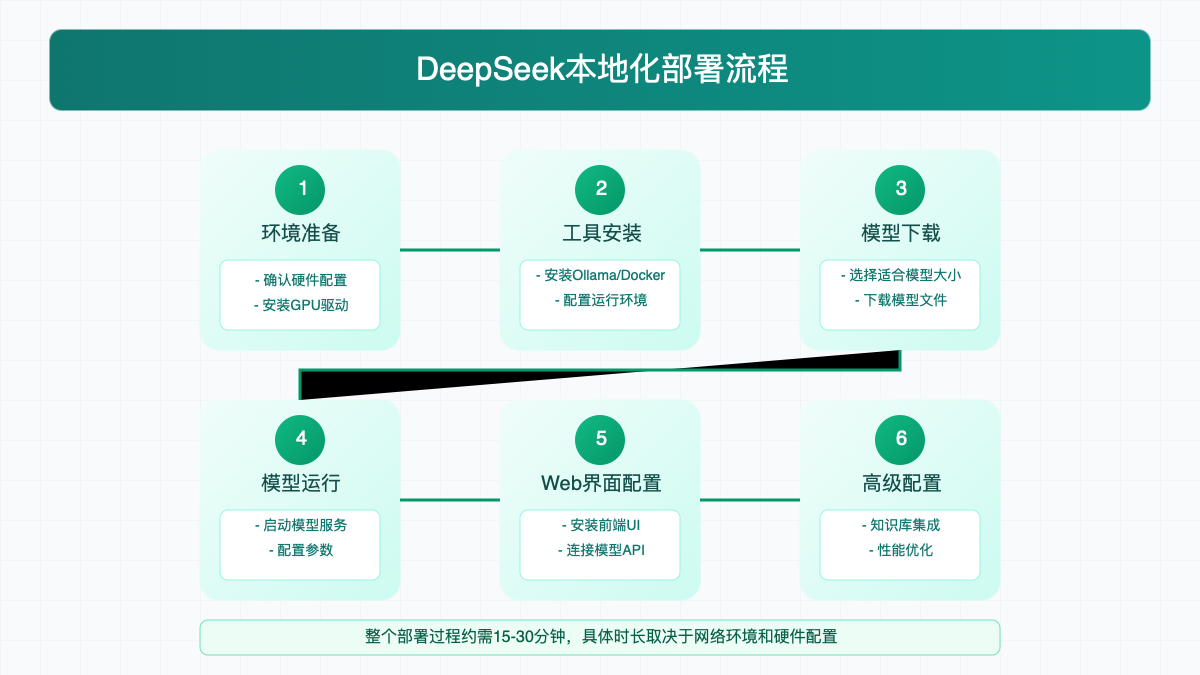

1.2 部署流程概览

本地部署DeepSeek模型的一般流程包括以下关键步骤:

- 环境准备:确认硬件配置,安装必要的驱动程序

- 工具安装:根据操作系统选择并安装合适的部署工具(Ollama、Docker等)

- 模型下载:选择适合硬件配置的模型版本并下载

- 模型运行:启动模型服务并进行基本配置

- Web界面配置:安装前端UI,实现可视化交互

- 高级配置:根据需求进行知识库集成、性能优化等操作

接下来,我们将详细介绍每个步骤的具体操作方法。

二、部署前的硬件要求与环境准备

在开始部署前,首先需要确认您的硬件配置是否满足运行DeepSeek模型的最低要求。

2.1 不同模型大小的硬件需求

DeepSeek提供多种规模的模型,以适应不同的硬件条件:

-

入门级(1.5B/7B):

- CPU:至少4核心处理器,推荐英特尔i5/AMD Ryzen 5或更高

- GPU:VRAM 6-8GB,如NVIDIA GTX 1660或RTX 3060

- 内存:最低16GB,推荐24GB以上

-

中端(14B):

- CPU:至少6核心处理器,推荐英特尔i7/AMD Ryzen 7或更高

- GPU:VRAM 12-16GB,如NVIDIA RTX 3080或RTX 4070

- 内存:最低32GB,推荐64GB以上

-

高端(32B/70B):

- CPU:至少8核心处理器,推荐英特尔i9/AMD Ryzen 9或更高

- GPU:VRAM 24-48GB或更高,如NVIDIA RTX 4090或A100/A6000

- 内存:最低64GB,推荐128GB以上(70B模型)

提示:如果您的硬件配置有限,可以使用量化版本的模型来降低硬件要求。例如,4-bit或8-bit量化后的模型可以在较低配置的硬件上运行。

2.2 操作系统环境准备

DeepSeek模型支持在Windows、macOS和Linux三大主流操作系统上部署:

Windows系统准备:

- 确保Windows 10/11已更新至最新版本

- 安装最新的NVIDIA驱动程序(对于NVIDIA显卡)

- 安装WSL2(Windows Subsystem for Linux)以获得更好的性能

- 安装Visual C++ Redistributable运行库

bash# 启用WSL2

wsl --install

macOS系统准备:

- 确保macOS版本为Monterey(12.0)或更高版本

- 对于Apple Silicon(M1/M2/M3)芯片,安装Homebrew及相关依赖

bash# 安装Homebrew

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

# 安装必要依赖

brew install cmake

Linux系统准备:

- 推荐Ubuntu 20.04/22.04或更高版本

- 安装GPU驱动和CUDA(对于NVIDIA显卡)

bash# 安装NVIDIA驱动

sudo apt update

sudo apt install -y nvidia-driver-535

# 安装CUDA工具包

sudo apt install -y cuda-toolkit-12-2

三、使用Ollama部署DeepSeek(推荐方案)

Ollama是目前最简便的DeepSeek本地部署方案,它提供了一个一站式的解决方案,适合大多数用户,特别是初学者。

3.1 安装Ollama

Ollama支持Windows、macOS和Linux三大主流平台,安装过程十分简单:

Windows安装:

- 访问Ollama官网

- 下载Windows安装包并运行

- 按照安装向导完成安装

macOS安装:

- 访问Ollama官网

- 下载macOS安装包并拖拽到Applications文件夹

- 首次启动时允许来自未知开发者的应用

Linux安装:

bash# 使用官方脚本安装

curl -fsSL https://ollama.com/install.sh | sh

3.2 使用Ollama下载并运行DeepSeek

安装完成后,打开终端(命令提示符/PowerShell/Terminal),执行以下命令下载并运行DeepSeek模型:

bash# 下载并运行DeepSeek 7B模型(推荐初次尝试)

ollama run deepseek-r1:7b

对于性能更强的电脑,您可以选择更大参数规模的模型:

bash# 运行DeepSeek 14B模型

ollama run deepseek-r1:14b

# 运行DeepSeek 32B模型

ollama run deepseek-r1:32b

如果您的硬件配置有限,可以使用量化版本:

bash# 运行量化版DeepSeek 7B模型

ollama run deepseek-r1:7b-q4_0

3.3 配置Ollama的高级参数

您可以通过修改模型参数来优化DeepSeek的运行体验:

bash# 创建自定义模型配置

cat << EOF > deepseek-config.json

{

"model": "deepseek-r1:7b",

"temperature": 0.7,

"top_p": 0.9,

"top_k": 40,

"num_ctx": 4096

}

EOF

# 创建自定义模型

ollama create deepseek-custom -f deepseek-config.json

# 运行自定义模型

ollama run deepseek-custom

常用参数说明:

- temperature:控制输出的随机性,值越低结果越确定

- top_p:控制采样范围,通常设置在0.9左右

- top_k:控制每一步考虑的词汇数量

- num_ctx:上下文窗口大小,影响模型能记住的内容长度

四、Docker部署DeepSeek(进阶方案)

对于熟悉Docker的用户,使用容器化方式部署DeepSeek提供了更高的灵活性和可移植性。

4.1 Docker环境准备

首先确保您的系统上已安装Docker:

Windows/macOS:

- 下载并安装Docker Desktop

- 启动Docker Desktop并等待服务就绪

Linux:

bash# Ubuntu/Debian安装Docker

sudo apt update

sudo apt install -y docker.io

sudo systemctl enable --now docker

# 将当前用户添加到docker组(免sudo运行)

sudo usermod -aG docker $USER

newgrp docker

4.2 使用Docker拉取并运行DeepSeek镜像

bash# 拉取DeepSeek官方Docker镜像

docker pull deepseek/deepseek-r1:7b

# 运行DeepSeek容器

docker run -d --gpus all -p 8000:8000 --name deepseek-server \

-v deepseek-data:/data deepseek/deepseek-r1:7b

4.3 Docker部署的高级配置

创建一个自定义的docker-compose.yml文件,进行更灵活的配置:

yamlversion: '3'

services:

deepseek:

image: deepseek/deepseek-r1:7b

ports:

- "8000:8000"

volumes:

- ./models:/models

- ./data:/data

environment:

- GPU_DEVICE=0

- MODEL_PATH=/models/deepseek-r1-7b

- QUANTIZATION=4bit

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: 1

capabilities: [gpu]

使用docker-compose启动服务:

bashdocker-compose up -d

五、Web界面配置与用户交互

部署完成后,您可以通过多种Web界面与DeepSeek模型进行交互。

5.1 使用Open WebUI配置前端界面

Open WebUI是一个功能强大的开源前端界面,支持多种LLM模型,包括DeepSeek:

bash# 安装Open WebUI

docker run -d -p 3000:8080 \

-v open-webui-data:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

安装完成后,在浏览器中访问http://localhost:3000,初次设置:

- 创建管理员账号

- 在设置中添加DeepSeek模型API地址(通常为

http://localhost:8000/v1) - 测试连接并保存设置

5.2 配置API访问

如果您希望在自己的应用中调用本地部署的DeepSeek模型,可以通过API方式访问:

pythonimport requests

import json

# 定义API端点

api_url = "http://localhost:8000/v1/chat/completions"

# 准备请求数据

data = {

"model": "deepseek-r1",

"messages": [

{"role": "system", "content": "你是一个有用的AI助手。"},

{"role": "user", "content": "简要介绍一下递归算法的基本原理"}

],

"temperature": 0.7

}

# 发送请求

response = requests.post(api_url, json=data)

# 解析响应

result = response.json()

print(result['choices'][0]['message']['content'])

六、高级应用:知识库集成与微调

6.1 构建个人知识库

将DeepSeek与个人知识库集成,可以显著提升其在特定领域的回答质量:

bash# 安装LlamaIndex

pip install llama-index

# 创建知识库代码示例

import os

from llama_index import VectorStoreIndex, SimpleDirectoryReader

from llama_index.llms import Ollama

# 设置环境

os.environ["OLLAMA_HOST"] = "http://localhost:11434"

# 加载文档

documents = SimpleDirectoryReader("./your_docs").load_data()

# 初始化DeepSeek模型

llm = Ollama(model="deepseek-r1")

# 创建索引

index = VectorStoreIndex.from_documents(documents, llm=llm)

# 创建查询引擎

query_engine = index.as_query_engine()

# 测试查询

response = query_engine.query("在我的文档中查找关于X的信息")

print(response)

6.2 模型微调与优化

对于有特定需求的用户,可以对DeepSeek模型进行微调:

bash# 使用LoRA方法进行微调

python -m deepseek.finetune \

--model deepseek-r1:7b \

--dataset your_dataset.jsonl \

--output-dir ./finetuned-model \

--epochs 3 \

--learning-rate 5e-5 \

--lora-rank 8

七、常见问题与故障排除

7.1 内存和显存不足

问题:运行模型时出现内存不足错误

解决方案:

- 使用较小参数规模的模型(如从32B降至7B)

- 尝试量化版本(4-bit或8-bit量化)

- 减小context长度(如从8192降至4096)

- 启用内存映射技术:

bash# Ollama中启用内存映射

ollama run deepseek-r1:7b --mmap true

7.2 模型加载缓慢

问题:首次加载模型需要很长时间

解决方案:

- 检查网络连接速度(首次下载模型文件较大)

- 确保使用SSD而非HDD存储模型文件

- 预热模型:

bash# 预热模型

echo "hello" | ollama run deepseek-r1:7b

7.3 GPU未被充分利用

问题:任务管理器/htop显示GPU使用率低

解决方案:

- 更新GPU驱动至最新版本

- 检查CUDA安装是否正确

- 确保模型配置正确引用了GPU:

bash# 确保Ollama使用GPU

CUDA_VISIBLE_DEVICES=0 ollama run deepseek-r1:7b

八、性能对比与选型建议

根据我们的测试,不同规模的DeepSeek模型在本地部署环境中的性能对比如下:

| 模型版本 | 参数规模 | 平均推理速度 | 内存/显存占用 | 适用场景 |

|---|---|---|---|---|

| DeepSeek-R1-1.5B | 15亿 | 极快(20-30词/秒) | 最低(3-4GB) | 简单问答、快速原型 |

| DeepSeek-R1-7B | 70亿 | 快(10-15词/秒) | 低(6-8GB) | 日常编程辅助、文本生成 |

| DeepSeek-R1-14B | 140亿 | 中等(5-10词/秒) | 中等(12-16GB) | 复杂推理、多轮对话 |

| DeepSeek-R1-32B | 320亿 | 较慢(3-5词/秒) | 高(24-32GB) | 专业知识问答、创意写作 |

| DeepSeek-R1-70B | 700亿 | 慢(1-3词/秒) | 极高(40GB+) | 最高质量输出、研究用途 |

选型建议:

- 个人开发者:推荐使用7B或14B量化版本,平衡性能和资源占用

- 小型团队:可考虑部署14B或32B版本,满足更复杂的应用需求

- 企业用户:根据具体应用场景和硬件条件,可选择32B或70B版本,获取最佳输出质量

九、总结与展望

DeepSeek的本地化部署为开发者和企业提供了一种强大、灵活且注重隐私的AI解决方案。通过本文详述的部署方法,您可以根据自身需求和硬件条件,选择最适合的部署方案。

随着量化技术和硬件性能的不断提升,未来本地部署大型语言模型将变得更加便捷。我们期待看到更多基于DeepSeek本地部署的创新应用出现。

后续资源

免责声明:本文内容仅供参考,部署过程中请确保遵循DeepSeek模型的使用条款。在处理敏感数据时,建议采取额外的安全措施。文中提及的硬件配置仅为建议,实际性能可能因具体环境而异。