2025年DeepSeek本地部署保姆级教程:从零开始的完整指南

【最新独家】详细讲解如何在本地电脑上部署DeepSeek大语言模型,包括环境配置、模型选择、性能优化及常见问题解决,让您的AI应用完全离线且保护隐私。无需专业知识,小白也能半小时内完成!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025年DeepSeek本地部署保姆级教程:从零开始的完整指南

在AI飞速发展的今天,越来越多的用户希望在本地部署强大的大语言模型,以获得更好的隐私保护、更低的使用成本和完全离线的使用体验。DeepSeek作为国产顶尖的大语言模型系列,其开源版本可以通过Ollama框架轻松部署在本地电脑上。本文将为您提供一份详尽的部署指南,让您即使没有深厚的技术背景,也能成功在本地运行DeepSeek模型。

为什么选择本地部署DeepSeek?

与使用在线API服务相比,本地部署DeepSeek模型具有以下几个显著优势:

- 完全离线运行:无需网络连接,随时随地使用AI助手

- 数据隐私保障:所有数据和交互都在本地计算机上处理,不会上传到云端

- 无使用次数限制:一次部署,无限制使用,没有API调用费用

- 低延迟体验:本地响应速度更快,无网络延迟

- 自定义控制:可以根据自己的需求自由调整模型参数和配置

当然,本地部署也面临一些挑战,主要是对硬件配置有较高要求,以及初始设置相对复杂。但只要按照本教程一步步操作,您一定能成功部署并享受本地AI带来的便利。

硬件需求和模型选择

在开始部署之前,首先需要了解不同DeepSeek模型的硬件需求,根据您的电脑配置选择合适的模型版本。

DeepSeek提供多个不同规模的模型以适应不同的硬件配置:

- 轻量级模型(如deepseek:chat-7b):适合普通笔记本电脑,8GB内存即可运行

- 中等规模模型(如deepseek:chat-34b):适合较强配置的电脑,建议16GB以上内存

- 高性能模型(如deepseek:R1-v3-70b):需要高端工作站或配备强显卡的电脑

- 专业编程模型(如deepseek:coder):针对代码开发优化的特殊模型

如果您的电脑配置不足以运行标准模型,可以尝试使用量化版本(模型名后缀为q4/q5/q8等),这些版本虽然精度略低,但资源占用大幅减少,保持了不错的实用性。

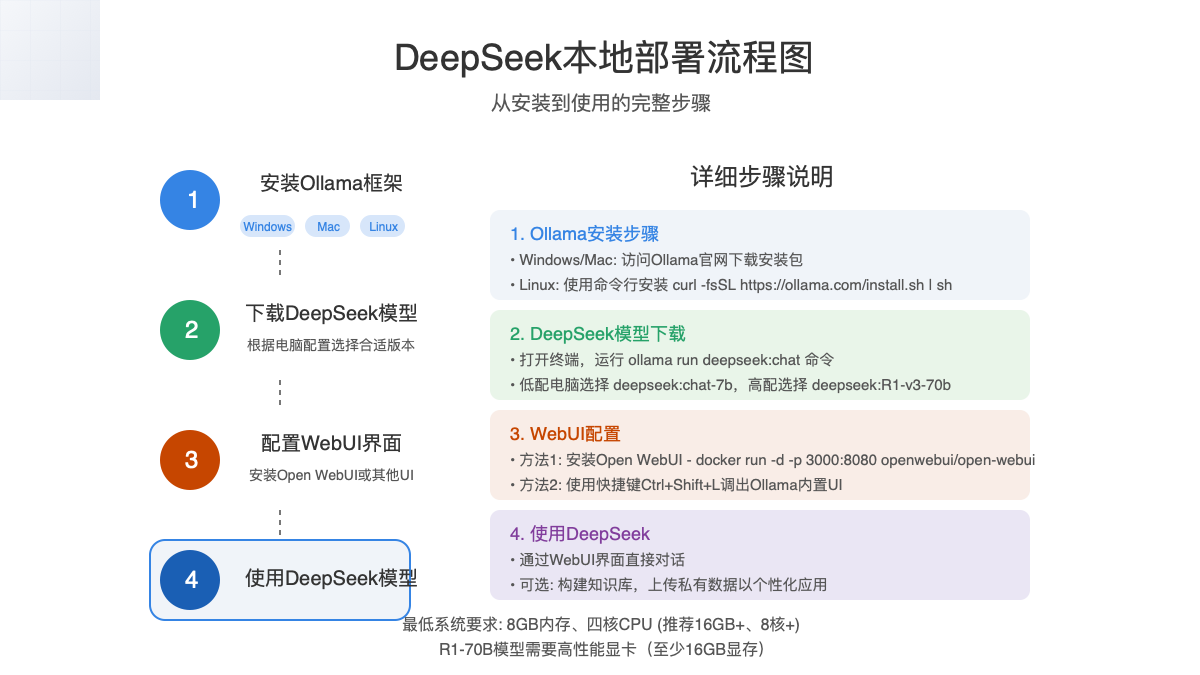

完整安装流程

本地部署DeepSeek模型的全流程分为以下四个主要步骤,让我们按顺序详细讲解:

第一步:安装Ollama框架

Ollama是一个轻量级的本地模型运行框架,支持多种操作系统,安装过程非常简单。

Windows系统安装

- 访问Ollama官网下载Windows安装包

- 双击安装包运行安装向导

- 按照提示完成安装,无需更改默认设置

- 安装完成后,Ollama会自动在系统托盘中运行

Mac系统安装

- 访问Ollama官网下载Mac安装包

- 打开下载的.dmg文件,将Ollama拖入Applications文件夹

- 首次运行时需要允许来自未知开发者的应用

- 在应用程序中找到并启动Ollama

Linux系统安装

在终端中执行以下命令:

bashcurl -fsSL https://ollama.ai/install.sh | sh

安装完成后,可以通过以下命令启动Ollama服务:

bashollama serve

第二步:下载DeepSeek模型

安装完Ollama后,接下来需要下载DeepSeek模型。为简化操作,我们可以直接使用Ollama的命令行工具进行下载。

- 打开终端或命令提示符

- 根据您的电脑配置,选择并执行以下命令之一:

bash# 轻量级模型(适合普通配置)

ollama run deepseek:chat-7b

# 中等规模模型(适合16GB+内存)

ollama run deepseek:chat-34b

# 高性能模型(需要高端配置)

ollama run deepseek:R1-v3-70b

# 代码专用模型(适合编程场景)

ollama run deepseek:coder

# 量化版本(适合低配置电脑)

ollama run deepseek:chat-7b-q4

执行命令后,Ollama会自动下载模型文件。根据模型大小和网络速度,下载过程可能需要几分钟到几十分钟不等。下载完成后,模型会自动启动。

第三步:配置WebUI界面

虽然可以通过命令行与模型交互,但使用图形界面会更加直观和方便。这里推荐两种方式:

方法1:使用Open WebUI(推荐)

Open WebUI 是一个专为Ollama开发的开源界面,功能丰富且美观。

如果您已安装Docker,可以使用以下命令快速部署:

bashdocker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always openwebui/open-webui

没有Docker的用户可以通过以下步骤安装:

- 确保已安装Node.js和npm

- 克隆项目仓库:

git clone https://github.com/open-webui/open-webui.git - 进入项目目录:

cd open-webui - 安装依赖:

npm install - 启动应用:

npm run dev

安装完成后,在浏览器中访问 http://localhost:3000 即可打开界面。

方法2:使用Ollama内置UI

从2024年末开始,Ollama提供了一个简洁的内置UI界面,可以通过以下方式访问:

- Windows/Linux:按下

Ctrl+Shift+L - Mac:按下

Command+Shift+L

或者直接在浏览器中访问 http://localhost:11434

第四步:开始使用DeepSeek模型

完成以上步骤后,您就可以开始使用本地部署的DeepSeek模型了!

在WebUI界面中:

- 选择您下载的DeepSeek模型

- 在输入框中输入您的问题或指令

- 点击发送,等待模型生成回复

高级配置和优化

模型参数调整

要获得更好的体验,可以调整以下参数:

- Temperature(温度):控制输出的随机性,值越高回答越多样,值越低回答越确定。建议对事实性问题使用低温度(0.1-0.3),创意场景使用高温度(0.7-0.9)

- Top P:与温度类似,但控制词汇选择的概率阈值

- Max Tokens:控制最大输出长度,增加此值可获得更长回答,但会消耗更多资源

性能优化技巧

- 限制同时运行的应用程序:关闭不必要的后台程序以释放内存

- 使用量化版本:如遇性能问题,尝试使用q4/q5/q8等量化版本

- 增加交换空间/虚拟内存:可帮助处理内存不足的情况

- GPU加速:如果您有支持的NVIDIA/AMD显卡,确保安装最新驱动以启用GPU加速

常见问题与解决方案

在部署和使用过程中,您可能会遇到一些常见问题。以下是解决方案:

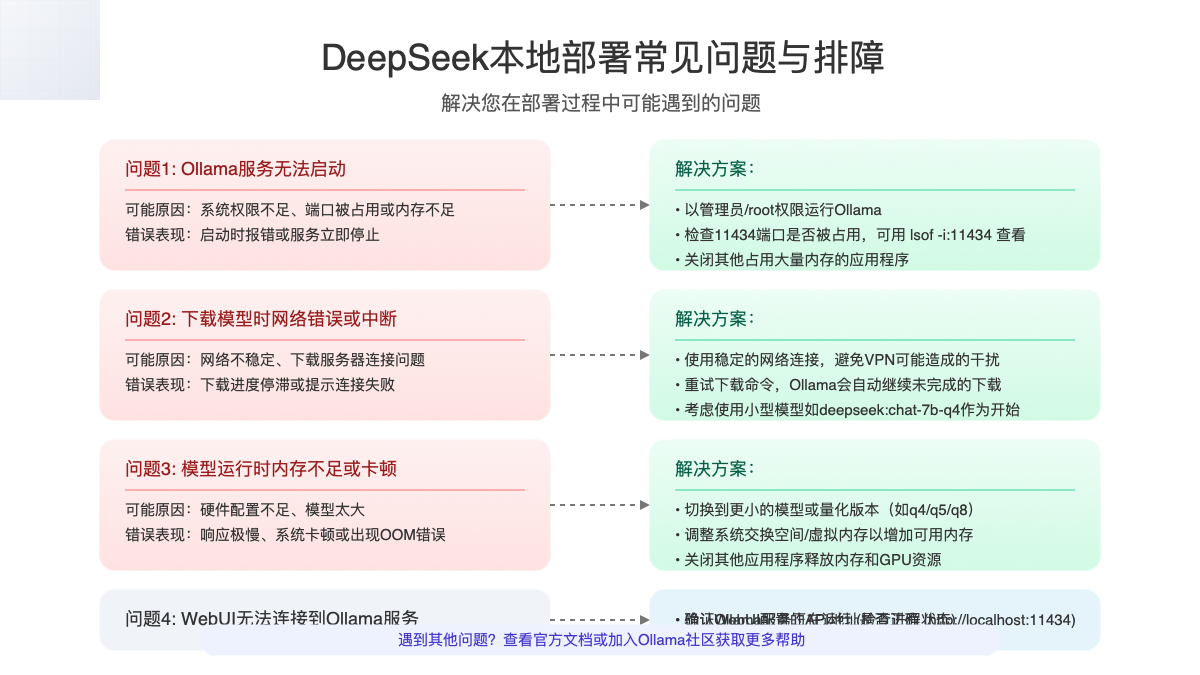

Ollama服务无法启动

可能原因:权限不足、端口被占用或内存不足 解决方案:

- 以管理员/root权限运行Ollama

- 检查11434端口是否被其他应用占用

- 关闭占用大量内存的应用程序

模型下载失败或中断

可能原因:网络不稳定、连接问题 解决方案:

- 确保使用稳定的网络连接

- 重试下载命令,Ollama会自动继续未完成的下载

- 尝试使用较小的模型版本

模型运行缓慢或卡顿

可能原因:硬件配置不足、模型太大 解决方案:

- 切换到更小的模型或量化版本

- 增加系统交换空间/虚拟内存

- 关闭其他应用程序释放资源

WebUI无法连接到Ollama

可能原因:Ollama服务未正常运行、配置错误 解决方案:

- 确认Ollama服务正在运行

- 验证WebUI配置的API地址是否正确(默认为http://localhost:11434)

实际应用场景示例

成功部署DeepSeek模型后,您可以在以下场景中充分利用它:

1. 个人知识库构建

上传个人文档,创建私人知识库,随时进行问答,不必担心敏感信息泄露。

2. 离线编程助手

使用deepseek:coder模型辅助编程,即使在没有网络的环境下也能获得代码建议和问题解答。

3. 数据分析与内容创作

分析本地数据集,生成报告和创意内容,全程保持数据安全。

4. 教育和研究应用

搭建本地AI实验环境,用于教育示范和科研探索,无需支付API费用。

总结与未来展望

通过本教程,您已经掌握了在本地部署和使用DeepSeek模型的完整技能。本地部署不仅保障了数据隐私和安全,还为您带来了无限制、低成本的AI使用体验。

随着硬件性能的不断提升和模型优化技术的进步,未来本地部署大语言模型将变得更加简单和高效。值得期待的是,DeepSeek团队也在持续优化模型,未来可能会推出更轻量级、更高性能的版本,让本地部署体验更上一层楼。

最后,我们鼓励您加入DeepSeek和Ollama的开源社区,分享您的使用经验和解决方案,共同推动本地AI技术的发展。

参考资源

本文将随技术更新持续调整,最后更新于2025年1月20日

如有问题或建议,欢迎在评论区留言