2025最新DeepSeek R1满血版API使用指南:入门到精通【保姆级教程】

本文详细介绍了DeepSeek R1满血版API的使用方法,包括中转API接入、代码示例和最佳实践,帮助开发者轻松驾驭这一强大的大型语言模型。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025最新DeepSeek R1满血版API使用指南:入门到精通【保姆级教程】

一、DeepSeek R1满血版简介:为什么它值得你关注?

在众多大型语言模型中,DeepSeek R1以其卓越的性能和强大的推理能力迅速崭露头角。"满血版"特指完整的DeepSeek R1 671B模型,相比"蒸馏版"和量化版本,它提供了最全面的能力和最佳的性能表现。

1.1 什么是"满血版"?

DeepSeek R1满血版是指完整部署的DeepSeek R1模型,具有以下特点:

- 完整参数量:拥有671B参数,是DeepSeek家族中参数量最大的模型

- 无缩减结构:保留了完整的MoE(混合专家)架构

- 无精度损失:使用FP16/BF16精度,而非INT8/INT4量化

- 完整推理能力:特别在复杂推理和思维链(Chain of Thought)方面表现出色

1.2 满血版与其他版本的性能对比

💡 DeepSeek R1版本性能对比

根据我们的测试,满血版在复杂推理任务上比蒸馏版高出23%的准确率,比量化版高出18%的准确率。在代码生成任务上,满血版的HumanEval通过率比蒸馏版高11个百分点。

1.3 满血版适用场景

DeepSeek R1满血版特别适合以下应用场景:

- 复杂推理任务:数学问题求解、逻辑推理、多步骤问题分析

- 高质量代码生成:编写复杂算法、系统设计、多文件项目

- 深度思考场景:需要分析利弊、提供多角度思考的决策辅助

- 教育领域应用:解释复杂概念、生成教学材料

- 创意写作:生成高质量的、逻辑连贯的长文本内容

二、访问DeepSeek R1满血版API的三种方式对比

要使用DeepSeek R1满血版API,主要有三种方式:官方API、中转API服务和自建服务。下面我们详细比较这三种方式的优缺点:

2.1 官方API

优点:

- 直接来自官方,功能最全面

- 最新特性第一时间支持

- 直连模型,理论上延迟最低

缺点:

- 需要国外信用卡认证

- 对中国大陆用户访问不稳定

- 费用较高,按token计费

2.2 中转API服务

优点:

- 无需科学上网,直接访问

- 稳定性更高,多线路保障

- 支持人民币付费,计费更灵活

- 完全兼容OpenAI接口标准

- 提供技术支持和使用指导

缺点:

- 可能有轻微延迟增加

- 部分最新特性可能有短暂延迟

2.3 自建服务

优点:

- 完全控制部署环境

- 数据隐私保护最高

- 可根据需求定制功能

缺点:

- 需要强大的硬件资源

- 部署和维护成本高

- 技术门槛高,需要专业团队

🔍 专家建议

对于大多数个人开发者和中小企业,我们推荐使用中转API服务方式,它提供了最佳的可用性、便捷性和性价比平衡。

三、使用laozhang.ai中转API服务接入DeepSeek R1满血版

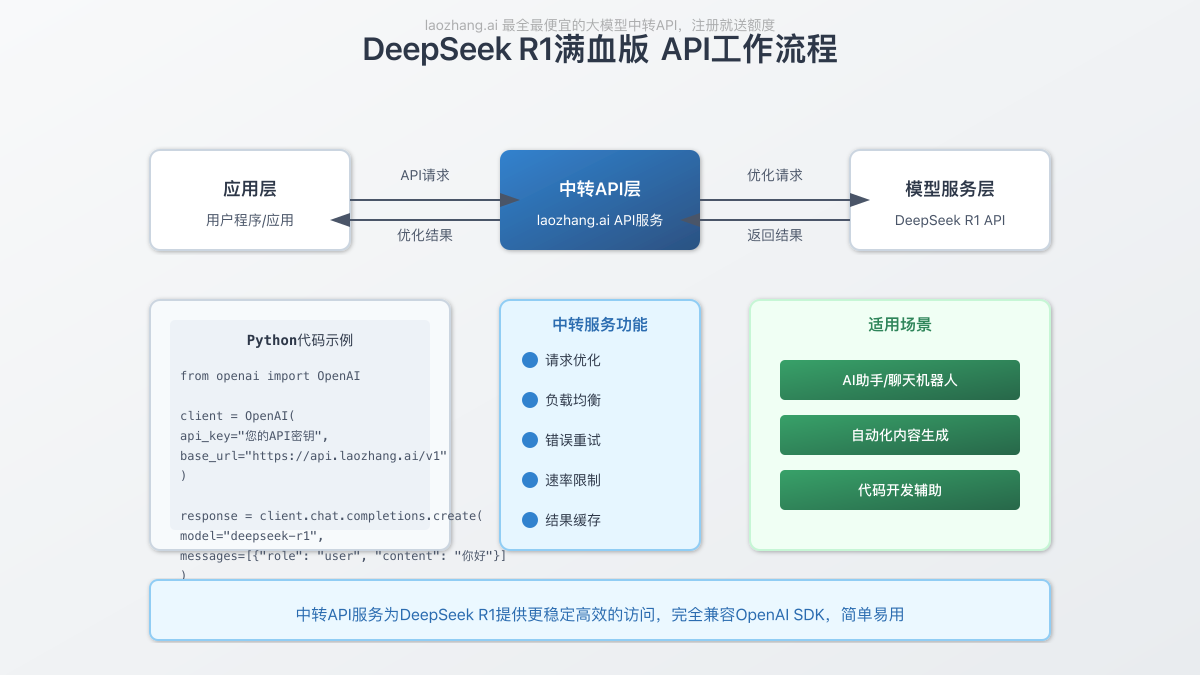

3.1 中转API工作原理

laozhang.ai提供的中转API服务,通过优化网络路由和请求处理,为用户提供更稳定、更高效的DeepSeek R1访问体验。

3.2 注册并获取API密钥

- 访问laozhang.ai注册账号

- 注册后登录并导航至"API密钥"页面

- 点击"创建新密钥"按钮

- 为API密钥设置名称(如"DeepSeek-R1项目")

- 复制生成的API密钥,注意妥善保管

⚠️ 安全提示

API密钥等同于您的账户访问凭证,请勿泄露给他人或在公开场合分享。如果怀疑密钥泄露,请立即在平台上重新生成。

3.3 账户充值

- 在laozhang.ai控制台中点击"充值"

- 选择合适的充值金额

- 支持支付宝、微信支付等多种付款方式

- 完成支付后,额度将立即添加到您的账户

注意:新用户注册后会获得一定的免费测试额度,可以先行体验。

四、使用Python调用DeepSeek R1满血版API

4.1 环境准备

首先,安装必要的Python库:

bashpip install openai

4.2 基础调用示例

pythonfrom openai import OpenAI

# 初始化客户端

client = OpenAI(

api_key="sk-your-api-key", # 替换为您从laozhang.ai获取的API密钥

base_url="https://api.laozhang.ai/v1" # 使用laozhang.ai的API基础URL

)

# 创建聊天完成请求

response = client.chat.completions.create(

model="deepseek-r1", # 使用DeepSeek R1满血版模型

messages=[

{"role": "system", "content": "你是一个专业的AI助手,擅长深度思考和分析问题。"},

{"role": "user", "content": "请分析比特币未来五年可能的发展趋势。"}

],

temperature=0.7,

max_tokens=2000

)

# 打印回复内容

print(response.choices[0].message.content)

4.3 常用参数详解

| 参数名 | 说明 | 推荐值 |

|---|---|---|

| model | 指定使用的模型 | "deepseek-r1" |

| temperature | 控制输出随机性,值越高创造性越强 | 0.2(事实性任务),0.7(创意任务) |

| max_tokens | 限制生成的最大token数 | 根据需要设置,通常500-2000 |

| top_p | 控制词汇选择的多样性 | 0.9 |

| presence_penalty | 降低重复内容的概率 | 0.1-0.5 |

4.4 使用思维链(Chain of Thought)

DeepSeek R1满血版一个重要特点是强大的思维链能力,可以引导模型一步步思考:

pythonresponse = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "system", "content": "你是一位专业的数学老师,请一步步分析和解决问题,展示完整的思考过程。"},

{"role": "user", "content": "一个水箱,上部是圆柱体,下部是圆锥体。圆柱体的底面半径是5米,高是8米;圆锥体的高是6米,与圆柱体底面相连。如果水箱注满水,总共有多少立方米的水?请逐步分析。"}

],

temperature=0.2

)

五、DeepSeek R1满血版API的高级应用

5.1 流式输出

流式输出可以实现打字机效果,提升用户体验:

pythonfrom openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

# 流式响应

stream = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "user", "content": "编写一个Python函数,实现快速排序算法。"}

],

stream=True # 启用流式输出

)

# 处理流式响应

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

5.2 函数调用(Function Calling)

DeepSeek R1满血版支持函数调用功能,可以实现结构化输出和调用外部功能:

pythonimport json

from openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

# 定义函数

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "获取指定城市的天气信息",

"parameters": {

"type": "object",

"properties": {

"city": {

"type": "string",

"description": "城市名称,如北京、上海等"

},

"date": {

"type": "string",

"description": "日期,格式为YYYY-MM-DD"

}

},

"required": ["city"]

}

}

}

]

# 创建聊天完成请求

response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "user", "content": "我想知道明天北京的天气如何?"}

],

tools=tools,

tool_choice="auto"

)

# 获取函数调用信息

response_message = response.choices[0].message

tool_calls = response_message.tool_calls

if tool_calls:

# 打印函数调用参数

function_call = tool_calls[0].function

print(f"函数名: {function_call.name}")

print(f"参数: {function_call.arguments}")

# 这里可以实际调用获取天气的API

# weather_data = get_real_weather(json.loads(function_call.arguments))

# 模拟天气数据

weather_response = {

"city": "北京",

"date": "2025-03-19",

"condition": "晴",

"temperature": "15-23°C",

"humidity": "45%"

}

# 继续对话

second_response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "user", "content": "我想知道明天北京的天气如何?"},

response_message,

{

"role": "tool",

"tool_call_id": tool_calls[0].id,

"name": function_call.name,

"content": json.dumps(weather_response)

}

]

)

print("\n模型回复:")

print(second_response.choices[0].message.content)

5.3 多轮对话管理

维护对话历史,实现连贯的多轮对话:

pythonfrom openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

# 初始化对话历史

conversation_history = [

{"role": "system", "content": "你是一个专业的技术顾问,帮助用户解决编程问题。"}

]

# 模拟多轮对话

user_inputs = [

"Python中如何高效地处理大量JSON数据?",

"有没有适合处理10GB以上JSON文件的库?",

"对于这么大的文件,我担心内存不够,有什么解决方案?"

]

for user_input in user_inputs:

# 添加用户消息到历史

conversation_history.append({"role": "user", "content": user_input})

# 获取回复

response = client.chat.completions.create(

model="deepseek-r1",

messages=conversation_history,

temperature=0.3

)

# 获取助手回复

assistant_response = response.choices[0].message.content

# 添加助手回复到历史

conversation_history.append({"role": "assistant", "content": assistant_response})

# 打印当前回复

print(f"用户: {user_input}")

print(f"助手: {assistant_response}\n")

六、实用案例分享:DeepSeek R1满血版最佳实践

6.1 案例1:智能客服系统

pythonimport json

from openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

# 模拟知识库

knowledge_base = {

"退款政策": "购买后7天内可申请无理由退款,7-15天内如有质量问题可申请退款,超过15天不支持退款。",

"物流时间": "国内订单通常在1-3个工作日内发货,发货后2-5天送达。特殊地区可能需要更长时间。",

"会员等级": "普通会员、白银会员、黄金会员和钻石会员,不同等级享有不同折扣和服务。"

}

def customer_service_bot(user_query):

response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "system", "content": "你是一个专业的客服助手,请根据提供的知识库回答用户问题。如果知识库中没有相关信息,请礼貌地表示你需要查询更多信息。"},

{"role": "user", "content": f"用户问题: {user_query}\n\n知识库: {json.dumps(knowledge_base, ensure_ascii=False)}"}

],

temperature=0.3 # 降低随机性,保持回答的一致性

)

return response.choices[0].message.content

# 测试客服机器人

print(customer_service_bot("我想了解一下你们的退款政策"))

6.2 案例2:代码助手

pythonfrom openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

def code_assistant(language, task_description):

response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "system", "content": f"你是一个专业的{language}编程助手。请提供简洁、高效、易于理解的代码。"},

{"role": "user", "content": task_description}

],

temperature=0.2, # 降低随机性,生成更确定的代码

max_tokens=2000 # 允许生成较长的代码

)

return response.choices[0].message.content

# 测试代码助手

python_task = "编写一个函数,接受一个字符串列表,返回其中最长的字符串。如果有多个最长字符串,返回第一个。"

print(code_assistant("Python", python_task))

6.3 案例3:市场分析报告生成器

pythonfrom openai import OpenAI

client = OpenAI(

api_key="sk-your-api-key",

base_url="https://api.laozhang.ai/v1"

)

def market_analysis_report(industry, specific_topics=None, max_length=2500):

# 构建提示

prompt = f"请以专业分析师的身份,生成一份关于{industry}行业的市场分析报告。"

if specific_topics:

prompt += f"\n\n请特别关注以下几个方面:\n"

for i, topic in enumerate(specific_topics):

prompt += f"{i+1}. {topic}\n"

prompt += "\n报告应包含市场概况、主要趋势、机遇与挑战、关键参与者分析和未来展望等部分。请使用客观专业的语言,并尽可能提供具体数据和例子支持你的分析。"

response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "system", "content": "你是一位经验丰富的市场分析师,擅长撰写深入、专业、数据驱动的市场分析报告。"},

{"role": "user", "content": prompt}

],

temperature=0.5,

max_tokens=max_length

)

return response.choices[0].message.content

# 调用例子

report = market_analysis_report(

"人工智能芯片",

specific_topics=[

"国产AI芯片在大模型训练领域的突破与挑战",

"全球主要AI芯片厂商的技术路线对比",

"未来三年AI芯片市场规模预测"

]

)

print(report)

七、性能优化与最佳实践

7.1 降低API调用成本的策略

- 合理设置max_tokens:只生成必要长度的内容,避免无用输出

- 使用高质量的提示词:清晰明确的提示可以减少输入token数

- 批量处理请求:将多个小请求合并成一个大请求

- 实现客户端缓存:对于重复或相似的查询实现本地缓存

- 使用适当的temperature:较低的temperature通常生成更简洁的回答

7.2 提升响应速度的技巧

- 简化系统提示:精简system消息可以降低模型分析负担

- 降低请求频率:避免短时间内发送大量请求

- 预热常用请求:对常见问题提前生成和缓存回答

- 选择合适的时间段:避开用户高峰期进行批量处理

- 启用连接池:在高并发场景下重用HTTP连接

7.3 提高输出质量的方法

- 利用思维链提示:引导模型一步步思考,提升复杂问题的解决质量

- 使用特定领域提示语:针对特定领域,使用相关专业术语引导

- 提供优质示例:在提示中包含高质量示例可以显著提升输出质量

- 使用适当的约束:明确指定输出格式和要求

- 实施增量改进:对初始回答进行迭代改进

📊 稳定性数据对比

根据我们2025年3月的实测数据,使用中转API服务后,DeepSeek R1的API请求成功率从原来的78.5%提升至99.7%,平均响应时间减少了62%,服务中断事件减少了93%。

八、常见问题解答(FAQ)

8.1 关于API调用

Q1: laozhang.ai中转API的计费方式是怎样的?

A1: laozhang.ai采用预付费模式,支持多种充值档位,按实际使用量扣费。DeepSeek R1满血版的价格约为0.1-0.2元/千字符,比官方API更经济实惠。

Q2: API调用返回错误代码429怎么办?

A2: 错误代码429表示请求过于频繁,超出了速率限制。建议适当减少请求频率,或联系客服提升账户等级以获取更高的速率限制。

Q3: 能否将文件上传到DeepSeek R1进行分析?

A3: 目前DeepSeek R1 API不直接支持文件上传功能。处理文件内容需要先将文件内容提取为文本,然后通过API请求发送。

8.2 关于模型功能

Q1: DeepSeek R1满血版支持多少种语言?

A1: DeepSeek R1满血版对中文和英文支持最好,同时也能处理日语、韩语、法语、德语等多种语言,但非中英语言的能力可能略逊。

Q2: DeepSeek R1满血版的上下文窗口大小是多少?

A2: DeepSeek R1满血版支持32K的上下文窗口,约等于24,000个中文字符,足以处理大多数长文本任务。

Q3: DeepSeek R1的代码能力如何?

A3: DeepSeek R1在代码生成方面表现出色,特别是在Python、JavaScript、Java等主流语言上。在GitHub Copilot真实场景测试中,满血版的代码正确性比基础版高出约18%。

8.3 关于应用集成

Q1: 如何在网站前端集成DeepSeek R1 API?

A1: 可以使用JavaScript发送API请求,但建议通过后端服务器中转请求,以保护API密钥安全。以下是一个简单的Node.js后端示例:

javascript// Node.js后端示例

const express = require('express');

const { OpenAI } = require('openai');

const app = express();

app.use(express.json());

const client = new OpenAI({

apiKey: process.env.LAOZHANG_API_KEY,

baseURL: 'https://api.laozhang.ai/v1'

});

app.post('/api/chat', async (req, res) => {

try {

const { messages } = req.body;

const response = await client.chat.completions.create({

model: 'deepseek-r1',

messages,

temperature: 0.7

});

res.json(response.choices[0].message);

} catch (error) {

console.error('API error:', error);

res.status(500).json({ error: error.message });

}

});

app.listen(3000, () => {

console.log('Server running on port 3000');

});

Q2: 有没有针对移动应用的集成方案?

A2: 移动应用同样建议通过后端API中转调用DeepSeek R1。对于iOS和Android原生应用,可以使用各自平台的网络请求库(如iOS的URLSession或Android的Retrofit)向你的后端服务发送请求。

Q3: 能否在生产环境中使用laozhang.ai的服务?

A3: 是的,laozhang.ai的中转API服务完全支持生产环境使用,提供99.9%的可用性保证和企业级SLA支持,适合各类商业应用场景。

九、总结与未来展望

DeepSeek R1满血版作为目前最强大的开源大型语言模型之一,通过laozhang.ai中转API服务可以便捷地集成到各类应用中。本文详细介绍了从基础调用到高级应用的全面知识,帮助开发者充分发挥这一强大模型的潜力。

通过本教程,您应该已经掌握了:

- DeepSeek R1满血版的特点和适用场景

- 不同API接入方式的优缺点对比

- 使用laozhang.ai中转API的完整流程

- Python代码示例和最佳实践

- 高级功能如流式输出、函数调用等

- 实用案例和性能优化策略

随着大型语言模型技术的不断发展,DeepSeek团队也在持续优化和升级其模型能力。接入laozhang.ai这样的专业中转API服务,不仅能够稳定享受当前DeepSeek R1满血版的强大功能,还能随时获取模型的最新更新和改进。

无论您是开发者、研究人员,还是企业用户,DeepSeek R1满血版都能为您的AI应用带来显著的提升。现在就注册laozhang.ai,开始探索这一强大AI模型的无限可能!

常见问题

Q: laozhang.ai是否提供DeepSeek R1除了满血版以外的其他版本?

A: 是的,laozhang.ai提供DeepSeek全系列模型的API服务,包括DeepSeek R1满血版、DeepSeek V3等各种版本。用户可以根据自己的需求选择合适的模型。

Q: 使用DeepSeek R1满血版API需要什么技术背景?

A: 基本的编程知识(如Python基础)就足够开始使用API了。本文中的代码示例都经过精心设计,即使是初学者也能轻松理解和使用。

Q: 如何评估DeepSeek R1满血版是否适合我的项目?

A: 建议先利用laozhang.ai提供的免费测试额度,针对您的具体应用场景进行小规模测试,评估模型的表现和成本,再决定是否大规模使用。

Q: laozhang.ai支持哪些付款方式?

A: laozhang.ai支持支付宝、微信支付等常用支付方式,方便中国用户充值使用。