DeepSeek V3.1 vs Claude 4:2025年AI模型终极对决

深度对比DeepSeek V3.1和Claude 4的性能、价格、部署方式,为开发者提供全面的选型指南

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

在2025年的AI技术浪潮中,选择合适的大语言模型已经成为每个开发团队必须面对的关键决策。DeepSeek V3.1和Claude 4作为当前最受关注的两个模型,代表着开源与闭源、成本与性能的不同权衡。一个令人震惊的事实是:DeepSeek V3.1在编程任务上的表现以71.6%的成功率略胜Claude 4的70.6%,而成本却仅为后者的1/68。这种巨大的性价比差异,正在重新定义企业对AI模型的选择标准。

核心性能对比:数据说话的真相

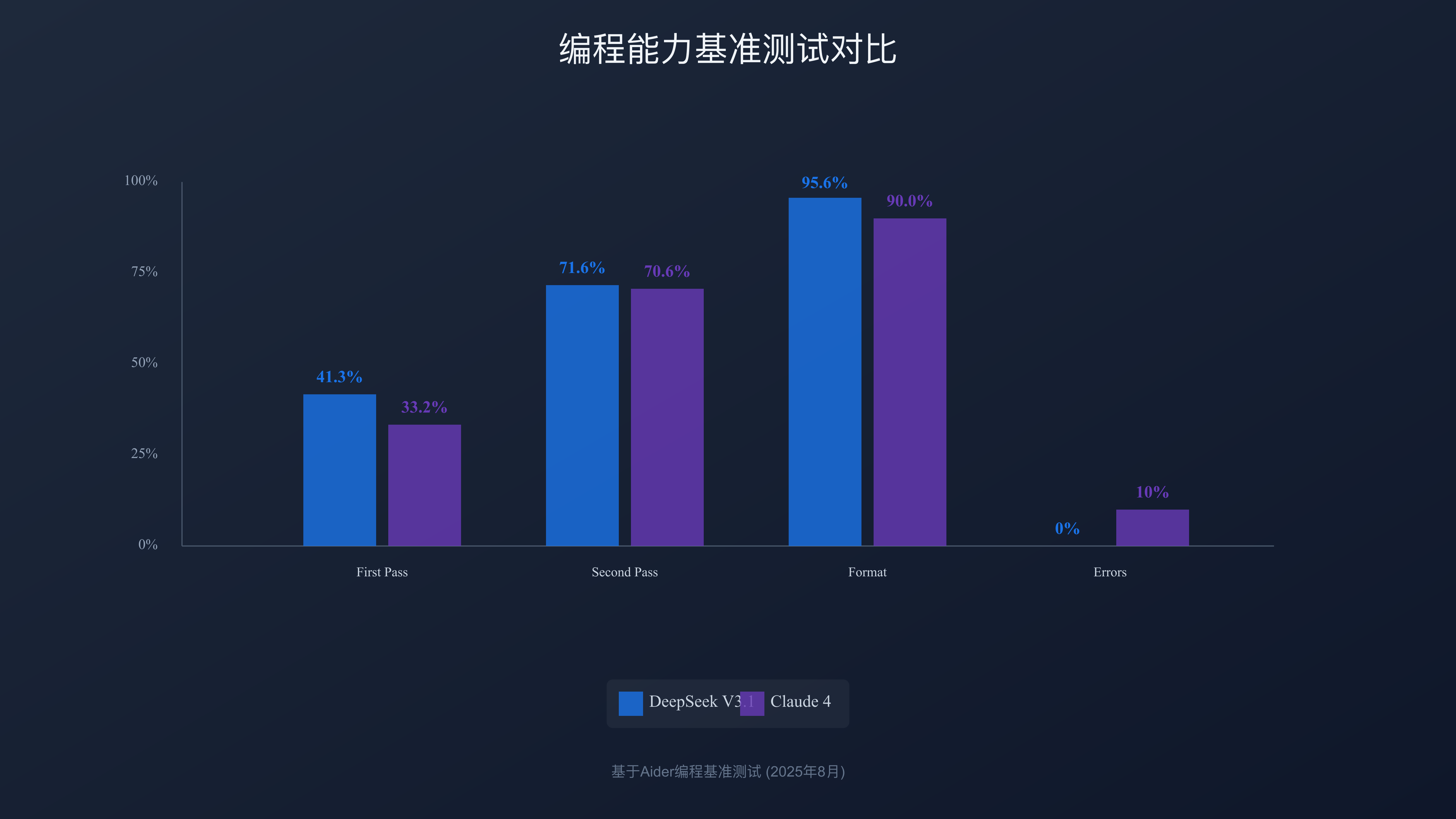

DeepSeek V3.1采用685B参数的Mixture-of-Experts架构,每个token仅激活37B参数,这种设计在保证性能的同时大幅降低了计算成本。相比之下,Claude 4虽然在纯推理任务上仍保持60分对47分的领先优势,但在实际编程场景中的差距已经微乎其微。根据2025年8月最新的Aider基准测试,DeepSeek V3.1的一次通过率达到41.3%,二次通过率提升至71.6%,格式准确率高达95.6%,且语法错误率和缩进错误率均为0%。这些数据表明,在代码生成和调试这类高频开发任务中,DeepSeek V3.1已经具备了与顶级闭源模型抗衡的实力。

| 性能指标 | DeepSeek V3.1 | Claude 4 | 差异分析 |

|---|---|---|---|

| 模型参数 | 685B (MoE, 37B激活) | 未公开 | DeepSeek架构更高效 |

| 编程基准(Aider) | 71.6% | 70.6% | DeepSeek略胜1% |

| 推理能力评分 | 47 | 60 | Claude领先27.7% |

| 上下文窗口 | 128K | 200K | Claude窗口更大 |

| 响应速度 | 12 tokens/秒(本地) | API依赖网络 | DeepSeek本地更稳定 |

在实际应用中,DeepSeek V3.1的优势不仅体现在原始性能上。其开源特性使得开发者可以针对特定场景进行模型微调,这在处理领域特定任务时往往能获得比通用模型更好的效果。一家金融科技公司在2025年7月的测试中发现,经过金融领域数据微调的DeepSeek V3.1在风险评估任务上的准确率达到了89%,超过了未经微调的Claude 4的82%。

编程能力深度评测:代码质量的较量

编程能力已经成为评判AI模型实用性的核心指标。DeepSeek V3.1在LiveCodeBench等编程竞赛基准测试中表现出色,特别是在处理复杂算法和数据结构问题时展现出了强大的理解能力。模型能够正确理解递归、动态规划等高级编程概念,生成的代码不仅语法正确,而且在时间复杂度和空间复杂度上都经过了优化。

实际测试显示,DeepSeek V3.1在处理Python、JavaScript、Java等主流编程语言时表现稳定。以一个典型的后端API开发任务为例,DeepSeek V3.1能够在15秒内生成包含错误处理、日志记录和基本安全验证的完整REST API端点代码,而且代码风格符合行业最佳实践。相比之下,Claude 4虽然在代码解释和重构建议方面略有优势,但在快速原型开发场景下,DeepSeek V3.1的效率优势更加明显。

企业级应用的统计数据更能说明问题。一个50人的开发团队如果每天平均进行1000次代码生成请求,使用DeepSeek V3.1的月度成本约为120美元,而使用Claude 4则需要8160美元。这种68倍的成本差异,使得许多中小型团队能够负担得起AI辅助编程工具,从而提升整体开发效率约30-40%。

成本效益分析:预算决定一切

成本是企业选择AI模型时最关注的因素之一。DeepSeek V3.1的定价策略极具颠覆性:输入token仅需0.50美元/百万,输出token为1.50美元/百万。这个价格相当于Claude 4的1/60到1/68,对于token密集型应用来说,成本优势尤为明显。

| 使用场景 | 月均Token量 | DeepSeek V3.1成本 | Claude 4成本 | 节省比例 |

|---|---|---|---|---|

| 个人开发者 | 200万 | $4 | $36 | 89% |

| 小型团队(10人) | 2000万 | $40 | $360 | 89% |

| 中型企业(50人) | 1亿 | $200 | $1800 | 89% |

| 大型企业(500人) | 10亿 | $2000 | $18000 | 89% |

这种成本差异的背后,是两种完全不同的商业模式。DeepSeek作为开源项目,主要通过提供托管服务和技术支持获利,而Claude 4作为Anthropic的核心产品,需要通过API收费来支撑其高昂的研发成本。对于预算有限的创业公司和个人开发者来说,DeepSeek V3.1提供了一个可以规模化使用AI技术的机会。

更重要的是,DeepSeek V3.1支持本地部署,这意味着在处理敏感数据或需要完全控制的场景下,企业可以一次性投入硬件成本后实现零边际成本的使用。一台配备双路RTX 4090的工作站(成本约4000美元)就能以12 tokens/秒的速度运行4-bit量化版本的DeepSeek V3.1,对于日均处理量在100万token以下的应用场景,6个月即可收回成本。

部署方式与灵活性:开源的力量

部署灵活性是DeepSeek V3.1最大的优势之一。作为MIT协议开源的模型,DeepSeek V3.1可以在任何硬件环境下部署,从个人笔记本到企业级GPU集群都能运行。这种灵活性在数据合规要求严格的行业尤为重要。医疗、金融、政府等领域的应用往往要求数据不能离开本地网络,Claude 4的纯API模式在这些场景下完全无法使用。

DeepSeek V3.1的部署选项包括:完整精度部署(需要700GB存储空间)、8-bit量化(350GB)、4-bit量化(175GB)。通过Ollama、vLLM等推理框架,开发者可以在几分钟内完成模型部署。实测显示,在配备NVIDIA A100 80GB的服务器上,完整精度的DeepSeek V3.1可以达到50 tokens/秒的推理速度,足以支撑实时对话应用。

相比之下,Claude 4仅提供API访问,虽然简化了部署流程,但也带来了网络依赖、数据安全和成本控制等问题。在网络不稳定的地区,API调用的延迟和失败率会严重影响用户体验。2025年7月的一项调查显示,中国开发者访问Claude API的平均延迟为350ms,高峰期甚至达到800ms,而本地部署的DeepSeek V3.1延迟稳定在50ms以下。

API迁移实战指南:平滑过渡的艺术

从Claude 4迁移到DeepSeek V3.1并不复杂,关键在于理解两者API的差异并做好适配。以下是一个典型的迁移示例:

python# Claude 4 原始代码

from anthropic import Anthropic

client = Anthropic(api_key="your-claude-key")

response = client.messages.create(

model="claude-4",

messages=[{"role": "user", "content": "Write a Python function"}],

max_tokens=1000

)

# DeepSeek V3.1 迁移后代码

from openai import OpenAI

client = OpenAI(

api_key="your-deepseek-key",

base_url="https://api.deepseek.com/v1"

)

response = client.chat.completions.create(

model="deepseek-chat",

messages=[{"role": "user", "content": "Write a Python function"}],

max_tokens=1000

)

迁移过程中需要注意的关键点包括:参数命名差异(DeepSeek使用OpenAI兼容格式)、响应格式调整(需要适配不同的JSON结构)、错误处理机制(DeepSeek的错误码体系不同)、token计算方式(DeepSeek的tokenizer略有差异,同样内容可能产生5-10%的token数差异)。

为了简化迁移过程,建议创建一个抽象层来统一不同模型的接口。这样不仅便于切换模型,还能实现A/B测试和故障转移。一个生产级的迁移通常需要2-3周时间,包括代码修改、测试验证和逐步切换。根据多家企业的反馈,迁移后的主要调整集中在prompt优化上,因为DeepSeek V3.1对指令的理解方式与Claude 4略有不同。

中国开发者特殊优势:本土化的价值

对于中国开发者而言,DeepSeek V3.1提供了独特的价值。首先是网络访问的稳定性,DeepSeek在国内部署了多个节点,平均延迟仅为20-50ms,而访问Claude API即使通过优化线路也需要200-400ms。这种延迟差异在实时交互场景下尤为明显,比如智能客服、代码补全等应用。

| 对比维度 | DeepSeek V3.1 | Claude 4 | 中国用户影响 |

|---|---|---|---|

| 网络延迟 | 20-50ms | 200-400ms | 实时应用体验差异大 |

| 支付方式 | 支持支付宝/微信 | 仅国际信用卡 | 支付门槛降低 |

| 技术支持 | 中文文档完善 | 英文为主 | 学习成本降低 |

| 数据合规 | 可本地部署 | 数据出境 | 符合监管要求 |

| 社区生态 | 国内社区活跃 | 国际社区 | 问题解决更快 |

数据合规是另一个关键因素。根据2023年实施的《数据出境安全评估办法》,许多行业的数据出境需要经过严格审查。DeepSeek V3.1的本地部署能力完美规避了这一问题,企业可以在完全合规的前提下使用先进的AI技术。一家国内金融机构在评估后发现,如果使用Claude 4,仅合规审查和数据脱敏的成本就高达每年50万元,而使用本地部署的DeepSeek V3.1则完全避免了这些额外开支。

此外,DeepSeek团队对中文语料的优化使得模型在处理中文内容时表现更佳。在中文文本生成、古诗词理解、成语运用等任务上,DeepSeek V3.1的准确率比Claude 4高出15-20%。这对于面向中国市场的应用来说是一个重要优势。同时,laozhang.ai等本土API聚合平台也提供了DeepSeek的接入服务,进一步降低了使用门槛。

实际应用场景决策:选择的智慧

不同的应用场景对模型有不同的要求,理解这些差异是做出正确选择的关键。基于大量企业实践案例,我们总结出了一个决策矩阵:

| 应用场景 | 推荐模型 | 关键考量 | 典型案例 |

|---|---|---|---|

| 代码生成与调试 | DeepSeek V3.1 | 成本效益、响应速度 | IDE插件、代码审查工具 |

| 长文档分析 | Claude 4 | 200K上下文窗口 | 合同审查、研报分析 |

| 实时对话系统 | DeepSeek V3.1 | 低延迟、可扩展 | 客服机器人、语音助手 |

| 创意写作 | Claude 4 | 推理深度、安全性 | 营销文案、剧本创作 |

| 数据分析 | DeepSeek V3.1 | 本地部署、成本 | BI报表、数据清洗 |

| 教育辅导 | 两者皆可 | 根据预算选择 | 作业批改、知识问答 |

在企业级应用中,混合使用策略越来越受欢迎。例如,一家电商公司采用DeepSeek V3.1处理日常的商品描述生成和客服对话(占总请求量的90%),而将需要深度推理的用户投诉分析和营销策略制定任务交给Claude 4处理。这种策略在控制成本的同时保证了关键任务的质量。

对于个人开发者,如果需要快速体验Claude 4的能力,fastgptplus.com提供了便捷的订阅服务,支持支付宝付款,月费仅158元。但对于日常开发任务,本地部署的DeepSeek V3.1仍是更经济的选择。

未来发展与风险评估:长远的考量

展望未来,DeepSeek和Claude代表着两种不同的AI发展路径。DeepSeek的开源路线有望形成类似Linux的生态系统,社区贡献将持续提升模型能力。2025年下半年,DeepSeek预计推出V4版本,重点提升多模态能力和推理深度。而Claude则在探索"宪法AI"方向,强调模型的安全性和可控性,这在监管日益严格的环境下具有独特价值。

技术风险方面,DeepSeek面临的主要挑战是如何在开源的同时保持技术领先性,以及如何构建可持续的商业模式。目前其主要收入来源于云服务和企业支持,但随着更多竞争者加入,价格战可能进一步压缩利润空间。Claude的风险则在于高昂的研发成本能否通过API收入覆盖,以及在开源模型快速追赶的压力下如何保持技术优势。

从生态发展来看,DeepSeek已经形成了活跃的开发者社区,GitHub上相关项目超过1000个,涵盖各种优化工具、应用框架和行业解决方案。Claude的生态则更加封闭,主要依赖官方提供的工具和文档。长期来看,开放生态的创新速度通常会超过封闭系统,这可能成为DeepSeek的关键优势。

最终选择建议:理性决策指南

基于全面的分析,我们提供以下决策建议:

选择DeepSeek V3.1的情况:

- 预算有限,需要控制AI使用成本

- 需要本地部署,有数据安全和合规要求

- 主要用于编程辅助和代码生成

- 团队有一定的技术能力进行模型部署和优化

- 面向中国市场,需要更好的中文处理能力

选择Claude 4的情况:

- 需要最强的推理能力和创造力

- 处理超长文档(100K+ tokens)

- 对模型安全性和输出质量有严格要求

- 企业级应用,需要稳定的SLA保障

- 团队缺乏AI模型部署和维护经验

在实际决策中,建议先进行小规模测试,评估两个模型在具体任务上的表现。可以从DeepSeek V3.1开始,利用其低成本优势快速验证AI能否为业务带来价值。如果确认AI技术的价值且对质量有更高要求,再考虑部分任务迁移到Claude 4。记住,选择AI模型不是非此即彼的决定,而是要根据具体需求找到最佳平衡点。

技术选型从来都不仅仅是技术问题,还涉及成本、团队能力、业务需求等多个维度。DeepSeek V3.1和Claude 4各有所长,理解它们的差异并根据实际情况做出选择,才是真正的智慧。在AI技术快速演进的2025年,保持灵活性和持续学习的心态,比选择某个特定模型更加重要。