2025年最全DeepSeek WebUI部署指南:本地大模型应用实战

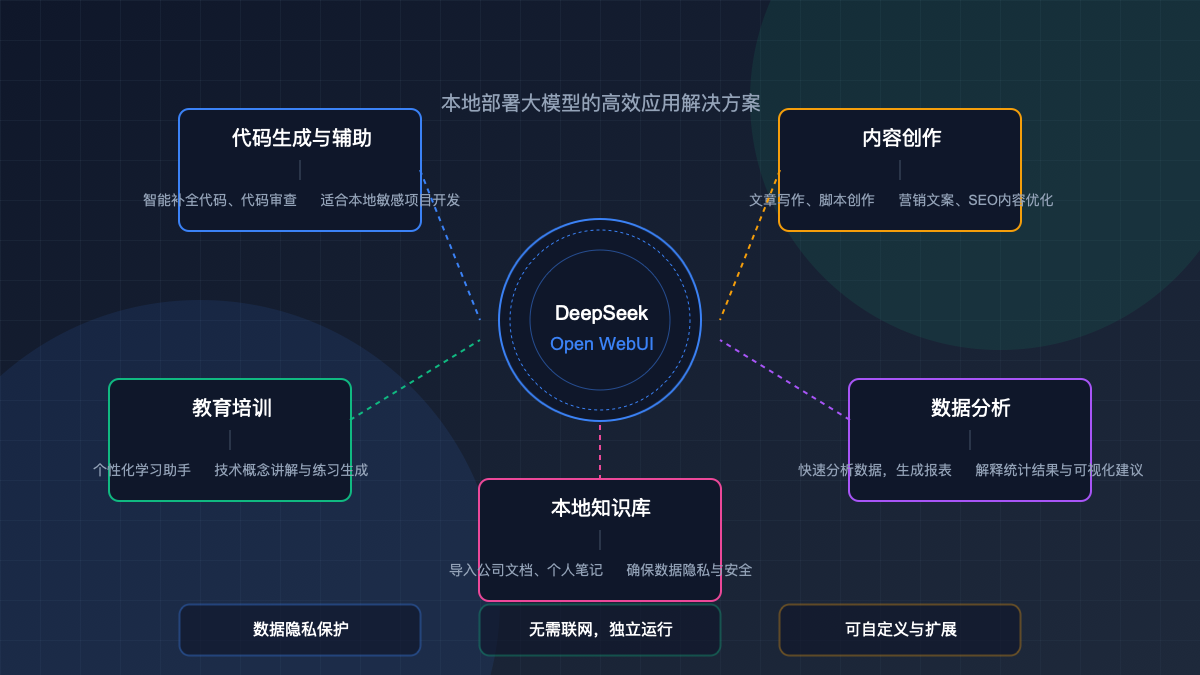

从零开始搭建DeepSeek R1私有化环境,配置Open WebUI打造专属AI应用。完整指南:通过Ollama安装DeepSeek R1模型,配置Open WebUI实现本地大模型部署,提供代码开发、内容创作、数据分析等多场景应用方案,保障数据安全与隐私。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025年最全DeepSeek WebUI部署指南:本地大模型应用实战

更新提示:本文于2025年3月21日更新,包含了DeepSeek最新版本的部署方法和Open WebUI的最新配置选项。

随着大模型技术的迅速发展,越来越多的企业和个人开始关注如何将这些强大的AI能力本地化部署,以保护数据隐私、降低使用成本,并实现定制化应用。在众多大模型中,由深度求索(DeepSeek)开源的DeepSeek R1以其出色的推理能力和相对较低的资源需求,成为本地部署的理想选择。

本文将带你一步步完成DeepSeek R1模型的本地部署,并通过Open WebUI搭建友好的交互界面,使你能够以类似ChatGPT的方式与模型进行交互,同时享受隐私保护和无限制使用的优势。

为什么选择本地部署DeepSeek + Open WebUI?

在深入技术细节前,我们先来看看为什么本地部署DeepSeek并配置WebUI是值得考虑的选择:

如上图所示,相比于调用云端API,本地部署DeepSeek模型具有显著优势:

- 数据隐私保障 - 所有数据和交互都保留在本地,不会上传至任何第三方服务器

- 无需网络连接 - 部署完成后可完全离线使用,不依赖互联网连接

- 长期使用成本低 - 一次性硬件投入后,无需按Token付费,可无限制使用

- 模型可定制化 - 可根据需求调整参数或进行微调,满足特定场景需求

- 响应速度稳定 - 不受网络波动影响,响应速度取决于本地硬件性能

当然,本地部署也存在需要较高硬件配置的限制,但随着消费级显卡性能的提升和量化技术的发展,这一门槛正在不断降低。

本地部署DeepSeek的硬件要求

在开始部署前,确保你的硬件满足以下基本要求:

最低配置

- CPU: 6核心以上处理器

- RAM: 16GB内存

- GPU: 至少8GB显存(适合运行7B量化模型)

- 存储: 50GB可用空间

- 操作系统: Windows 10/11, macOS, Linux

推荐配置

- CPU: 8核心高性能处理器

- RAM: 32GB内存

- GPU: NVIDIA RTX 3080或同等性能,16GB显存

- 存储: 100GB SSD可用空间

- 操作系统: Windows 10/11, macOS, Linux

高性能配置

- CPU: 12核心以上高性能处理器

- RAM: 64GB以上内存

- GPU: NVIDIA RTX 4090或同等性能,24GB显存

- 存储: 200GB NVMe SSD可用空间

- 操作系统: Windows 10/11, macOS, Linux

注意:如果你使用的是MacBook等搭载Apple Silicon处理器的设备,可以利用Metal支持在GPU上运行量化后的DeepSeek模型,但性能可能不如专业NVIDIA显卡。

DeepSeek WebUI部署流程

整个部署过程可分为以下几个主要步骤:

下面我们将详细介绍每一步的具体操作。

1. 安装Ollama

Ollama是一个开源的大模型运行工具,可以简化本地模型的安装和管理。首先,我们需要在系统上安装Ollama:

步骤1:下载并安装Ollama

访问Ollama官网,下载适用于你操作系统的安装包。

步骤2:对于Windows用户

运行下载的安装程序,按照向导完成安装。

步骤3:对于macOS用户

将下载的.dmg文件拖放到Applications文件夹中。

步骤4:对于Linux用户

bashcurl -fsSL https://ollama.com/install.sh | sh

步骤5:验证安装

打开终端或命令提示符,输入以下命令确认Ollama已正确安装:

bashollama --version

2. 下载DeepSeek模型

安装完Ollama后,我们可以通过简单的命令拉取DeepSeek模型:

bash# 下载DeepSeek R1 7B Instruct量化版本

ollama pull deepseek-coder:7b-instruct-q4_0

# 或者下载DeepSeek R1 33B Chat量化版本(需要更多显存)

ollama pull deepseek:33b-chat-q4_0

提示:模型下载可能需要一段时间,取决于你的网络速度。7B模型约3-4GB,33B模型约15-16GB。

你也可以根据需要选择其他规格的DeepSeek模型,Ollama支持多种不同大小和专长的DeepSeek变体:

| 模型名称 | 大小 | 最低显存要求 | 特点 |

|---|---|---|---|

| deepseek-coder:7b-instruct-q4_0 | 约4GB | 8GB | 代码生成专精,量化版本 |

| deepseek:7b-chat-q4_0 | 约4GB | 8GB | 通用对话,量化版本 |

| deepseek:33b-chat-q4_0 | 约16GB | 20GB | 更高理解能力,量化版本 |

3. 安装Docker

Open WebUI基于Docker运行,因此我们需要先安装Docker:

Windows安装

- 访问Docker Desktop官网下载Windows版本

- 双击安装文件运行

- 按照向导完成安装(可能需要启用WSL2)

- 安装完成后重启电脑

macOS安装

- 访问Docker Desktop官网下载macOS版本

- 将下载的.dmg文件拖放到Applications文件夹

- 打开Docker应用并授予必要权限

- 等待Docker初始化完成

Linux安装

bash# Ubuntu/Debian

sudo apt update

sudo apt install docker.io docker-compose

sudo systemctl enable --now docker

# 将当前用户添加到docker组(免sudo运行docker)

sudo usermod -aG docker $USER

# 注销并重新登录使更改生效

安装完成后,验证Docker是否正常运行:

bashdocker --version

4. 部署Open WebUI

Open WebUI是一个功能丰富的开源界面,可用于与Ollama模型进行交互。使用Docker部署非常简单:

bash# 使用Docker启动Open WebUI

docker run -d --name open-webui -p 3000:8080 \

-v open-webui:/app/backend/data \

--restart always \

ghcr.io/open-webui/open-webui:latest

提示:上述命令将Open WebUI容器映射到本地3000端口。如果该端口已被占用,可以更改为其他端口,如8080:8080。

5. 配置Open WebUI连接Ollama

启动Open WebUI后,我们需要将其连接到Ollama:

步骤1:打开Web界面

在浏览器中访问:http://localhost:3000

步骤2:创建帐户

首次使用需要创建一个本地帐户(数据仅存储在本地)

步骤3:添加Ollama连接

- 在设置中选择"模型提供商"

- 选择Ollama并配置连接URL

- 本地Ollama通常为:http://localhost:11434/api

- Docker环境可能需要使用:http://host.docker.internal:11434/api

- 点击"保存设置"

步骤4:验证连接

返回主界面,此时应能看到已安装的DeepSeek模型

6. 优化DeepSeek使用体验

完成基本配置后,可以对DeepSeek模型进行进一步优化:

在Open WebUI中,你可以调整多项参数来优化模型表现:

- 温度(Temperature):控制输出的随机性,建议代码生成设置低值(0.1-0.3),创意写作设置高值(0.7-0.9)

- Top P:在0.8-0.95之间调整,控制模型词汇选择的多样性

- 最大标记数:根据需要的回答长度设置,较长的上下文需要更高的值

- 上下文窗口大小:影响模型能够"记住"的对话历史长度

- 批处理大小:较大值可加速生成但需要更多显存

DeepSeek WebUI应用场景

本地部署的DeepSeek WebUI可以应用于多种场景:

代码开发辅助

DeepSeek R1在代码开发方面表现出色,可用于:

- 智能代码补全和生成

- 代码重构和优化建议

- 调试和错误分析

- 技术文档生成

示例提示词:

分析这段代码的性能问题并提供优化建议:

```python

def find_duplicates(arr):

duplicates = []

for i in range(len(arr)):

for j in range(i+1, len(arr)):

if arr[i] == arr[j] and arr[i] not in duplicates:

duplicates.append(arr[i])

return duplicates

### 内容创作与编辑

对于内容创作者,DeepSeek可以提供:

- 文章写作和结构建议

- 内容润色和修改

- 多语言翻译

- SEO优化建议

### 教育培训应用

在教育领域,本地部署的DeepSeek可用于:

- 个性化学习助手

- 知识点讲解和示例生成

- 练习题生成与评估

- 学习材料总结

### 数据分析助手

对于数据分析工作,DeepSeek可以:

- 协助编写数据处理脚本

- 提供可视化建议

- 解释统计结果

- 生成分析报告

### 本地知识库构建

结合其他工具,你可以将DeepSeek与本地文档集成:

- 导入公司内部文档

- 建立个人知识管理系统

- 创建专业领域问答助手

- 实现离线文档检索与摘要

## 本地部署常见问题解决

在部署和使用过程中,可能会遇到一些常见问题,以下是解决方案:

> **⚠️ 显存不足错误**: 如遇到CUDA Out of Memory错误,请尝试使用更小的模型或增加量化级别(如从q4_K_M切换到q4_0)。

### 模型加载速度慢

- 确保使用SSD存储模型文件

- 检查是否有其他程序占用GPU资源

- 尝试使用更小的模型变体

### Open WebUI无法连接Ollama

- 确认Ollama服务正在运行:`ps aux | grep ollama`

- 检查防火墙设置是否阻止了本地端口通信

- Docker环境中使用正确的网络地址:`http://host.docker.internal:11434/api`

### 模型回答质量不佳

- 调整温度和Top P参数以获得更好的结果

- 尝试提供更明确和结构化的提示

- 考虑切换到更大规格的模型(如从7B升级到33B)

### 系统资源占用过高

- 限制模型的并行请求数

- 调整批处理大小(batch size)

- 关闭不必要的后台程序

- 设置context length为实际需要的值

## 高级配置与定制

对于进阶用户,这里提供一些高级配置选项:

### 自定义Modelfile

你可以创建自定义的Modelfile来调整DeepSeek的行为:

```bash

# 创建Modelfile

cat > Modelfile << EOF

FROM deepseek:33b-chat-q4_0

PARAMETER temperature 0.2

PARAMETER top_p 0.9

PARAMETER stop "User:"

PARAMETER stop "Assistant:"

SYSTEM 你是一位专业的技术顾问,擅长解答编程和技术问题,回答简洁专业。

EOF

# 创建自定义模型

ollama create tech-advisor -f Modelfile

与其他工具集成

DeepSeek可以与多种其他工具集成:

- RAG系统:结合向量数据库如Chroma或Milvus实现本地知识库

- 本地编程环境:通过API与VSCode或JetBrains IDE集成

- 自动化流程:使用Ollama API构建自定义工作流

模型微调

对于特定领域应用,可以考虑对DeepSeek模型进行微调:

- 收集领域专业数据(如特定行业文档、代码等)

- 使用开源工具如LLaMA-Factory进行LoRA微调

- 将微调后的模型转换为Ollama支持的格式

- 通过自定义Modelfile加载微调模型

结论

通过Ollama部署DeepSeek模型并配置Open WebUI,我们可以在本地构建一个功能强大的AI助手,既保护数据隐私安全,又能享受大模型带来的智能体验。随着硬件性能的不断提升和模型效率的持续优化,这种本地部署方案将变得越来越实用和普及。

无论是个人开发者还是企业用户,本地部署DeepSeek都能提供一个安全、可控、经济的AI应用环境,让AI技术真正为我们所用,而不必过分担忧数据安全和使用成本问题。

资源链接:

如果你在部署过程中遇到任何问题,或有其他DeepSeek应用场景的需求,欢迎在评论区留言讨论!