Dify集成Gemini 2.5 Pro终极指南:解锁高级AI能力(含稳定接入方案)

【2025最新】详解如何在Dify平台集成并使用Google Gemini 2.5 Pro模型。包含官方接入和国内开发者专属的laozhang.ai中转API稳定接入方案,附带详细步骤、成本优化技巧和常见问题解答。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Dify集成Gemini 2.5 Pro终极指南:解锁高级AI能力(含稳定接入方案)

{/* 封面图片 */}

Dify作为一个强大的开源LLM应用开发平台,允许开发者快速构建和部署AI应用。而Google最新的Gemini 2.5 Pro模型,凭借其卓越的多模态处理、长上下文理解和复杂推理能力,成为了众多开发者希望引入其项目中的首选。

将Gemini 2.5 Pro的强大能力与Dify的灵活性相结合,无疑能创造出更智能、更强大的AI应用。然而,如何顺畅地在Dify中集成和使用Gemini 2.5 Pro,特别是对于国内开发者而言,是一个值得探讨的问题。

本文将提供一份详尽的指南,覆盖从官方接入到利用laozhang.ai中转API进行稳定、经济接入的全部流程,助你轻松在Dify中驾驭Gemini 2.5 Pro。

🔥 2025年4月实测有效:本指南包含最新的Dify版本(假设为v0.14.2或更高,支持Gemini系列)和Gemini 2.5 Pro的接入方法,特别优化了国内开发者的接入体验。

目录

- 为什么在Dify中使用Gemini 2.5 Pro?

- 准备工作:获取API密钥

- 方法一:通过官方Google AI Studio接入

- 方法二:通过laozhang.ai中转API接入(国内推荐)

- 在Dify应用中使用Gemini 2.5 Pro

- 成本考量与优化策略

- 常见问题解答 (FAQ)

- 总结与未来展望

为什么在Dify中使用Gemini 2.5 Pro?

将Gemini 2.5 Pro集成到Dify平台,能带来诸多优势:

- 利用尖端AI能力:直接在你的Dify应用中利用Gemini 2.5 Pro的超长上下文(最高200万tokens)、多阶段推理和强大的多模态能力。

- 快速原型设计:Dify的可视化界面和预构建模块,结合Gemini 2.5 Pro,可以加速复杂AI应用(如高级RAG、智能Agent)的原型设计和迭代。

- 简化工作流:Dify的工作流编排能力让你能方便地将Gemini 2.5 Pro与其他模型、工具或知识库结合,构建复杂的处理流程。

- 统一管理:在Dify平台统一管理包括Gemini 2.5 Pro在内的多种模型,简化API密钥和调用管理。

- 成本控制与监控:Dify提供基本的用量统计,结合中转服务,可以更精细地监控和控制成本。

准备工作:获取API密钥

无论选择哪种接入方式,你都需要获取相应的API密钥。

1. Google AI Studio API Key (官方)

- 访问 Google AI Studio。

- 使用你的Google账号登录。

- 导航至 "Get API key" 或类似选项。

- 创建一个新的API密钥并妥善保管。

2. laozhang.ai API Key (中转)

- 访问 laozhang.ai 注册页面。

- 完成注册并登录。

- 在控制面板或API密钥管理页面创建API Key。

laozhang.ai提供注册赠送额度,方便测试。

方法一:通过官方Google AI Studio接入

这是官方推荐的标准接入方式,适用于可以直接访问Google服务的用户。

步骤1:进入Dify模型供应商设置

- 登录你的Dify平台。

- 点击左侧导航栏的"设置"。

- 选择"模型供应商"。

步骤2:添加Google模型

- 在模型供应商列表中找到"Google"或"Gemini"。

- 点击"添加模型"或"配置"。

步骤3:配置Google API密钥

- 在配置界面,找到API密钥(API Key)输入框。

- 粘贴你从Google AI Studio获取的API密钥。

- 保存配置。

步骤4:启用Gemini 2.5 Pro模型

- 配置成功后,Google提供的模型列表会显示出来。

- 找到

gemini-2.5-pro或其最新可用版本(如gemini-2.5-pro-exp-xxxx实验版)。 - 确保该模型处于启用状态。Dify通常会自动同步Google支持的模型列表。

优点:

- 官方直接接入,无中间环节。

- 可直接使用Google AI Studio的管理和监控功能。

缺点:

- 国内访问可能不稳定或受限。

- 价格遵循Google官方定价,无额外折扣。

方法二:通过laozhang.ai中转API接入(国内推荐)

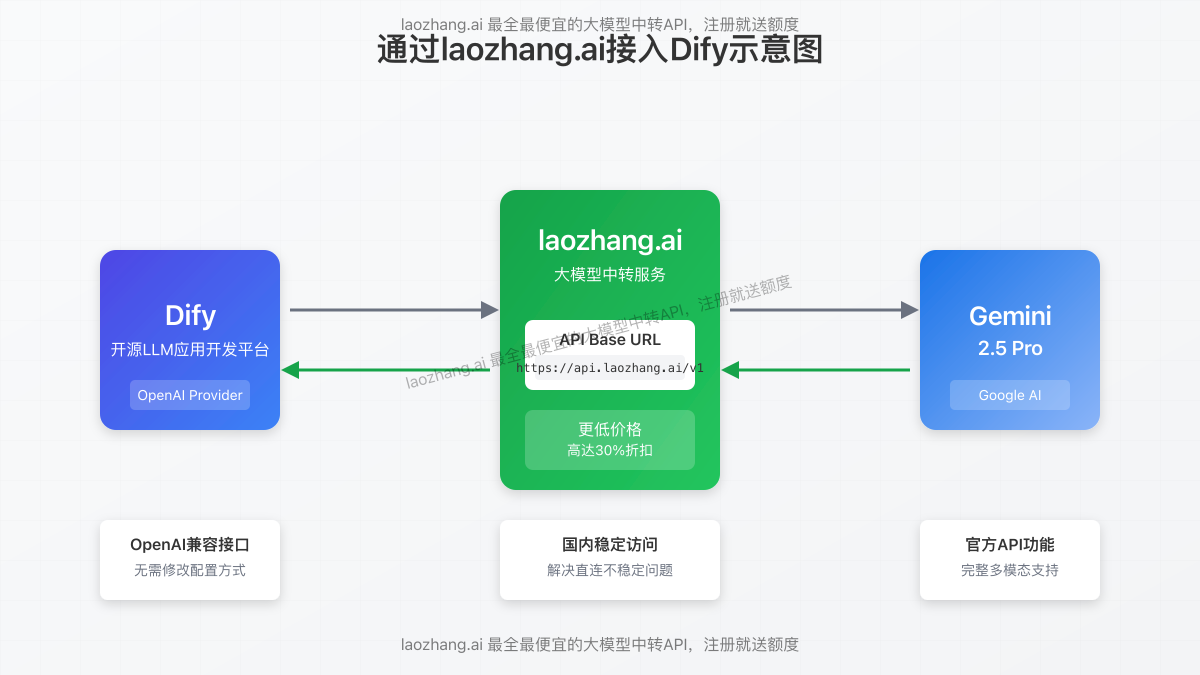

对于国内开发者,使用laozhang.ai这样的中转服务是更稳定、经济的选择。它兼容OpenAI的API格式,可以通过配置OpenAI供应商的方式接入Gemini 2.5 Pro。

步骤1:进入Dify模型供应商设置

同方法一,进入Dify的"设置" > "模型供应商"。

步骤2:添加或配置OpenAI模型供应商

- 找到"OpenAI"模型供应商。如果你之前没有配置过,点击"添加模型";如果已配置,点击"编辑"或"配置"。

- 关键在于配置API Endpoint和API Key。

步骤3:配置laozhang.ai的接入点和密钥

- API密钥 (API Key):输入你在

laozhang.ai平台获取的API Key (通常以sk-开头)。 - API Base URL (或 API Endpoint):这是关键步骤! 将此字段设置为

laozhang.ai提供的API接入点地址:https://api.laozhang.ai/v1 - 组织ID (Organization ID):通常留空。

- 保存配置。

步骤4:在模型列表中手动添加或选择Gemini 2.5 Pro

由于我们是通过OpenAI兼容接口接入,Dify可能不会自动列出Gemini模型。你需要:

- 在OpenAI供应商的模型列表中,查看是否可以直接选择

gemini-2.5-pro(laozhang.ai会映射常用模型)。 - 如果列表中没有,可能需要手动添加模型(如果Dify支持):

- 点击"添加自定义模型"或类似按钮。

- 模型名称 (Model Name):输入

gemini-2.5-pro(必须与laozhang.ai支持的名称一致)。 - 模型类型 (Model Type):选择 "Chat" 或 "Completion"。

- 上下文长度 (Context Length):根据Gemini 2.5 Pro的能力填写,例如

1000000或2000000。 - 其他参数(如价格)可以根据

laozhang.ai的费率填写,或暂时留空。

- 启用你添加或选择的

gemini-2.5-pro模型。

⚠️ 注意:

使用中转服务时,Dify的模型列表可能不会自动更新。请确保你在laozhang.ai配置中输入的模型名称 (gemini-2.5-pro) 是laozhang.ai平台实际支持和映射的。如有疑问,请查阅laozhang.ai的文档或联系其客服。

优点:

- 国内访问稳定:

laozhang.ai提供国内优化的网络接入。 - 价格更优:通常提供比官方更低的费率或套餐折扣。

- 统一管理:可在

laozhang.ai平台统一管理多种模型的API Key和用量。 - 兼容性好:利用OpenAI兼容接口,简化了Dify的配置。

缺点:

- 增加了一个中间环节。

- 模型列表可能需要手动维护。

在Dify应用中使用Gemini 2.5 Pro

无论你通过哪种方式配置完成,在Dify应用中使用Gemini 2.5 Pro的步骤是相同的:

- 创建或编辑应用:进入你想要使用Gemini 2.5 Pro的Dify应用(例如:聊天助手、工作流)。

- 选择LLM节点:在应用的编排视图中,找到负责调用大语言模型的节点(如"LLM"、"Assistant"等)。

- 配置模型:

- 在该节点的设置中,找到模型选择的下拉菜单。

- 如果你是通过Google供应商配置的,直接在Google分组下选择

gemini-2.5-pro。 - 如果你是通过

laozhang.ai(OpenAI供应商) 配置的,在OpenAI分组下选择gemini-2.5-pro。

- 调整参数:根据需要调整温度 (Temperature)、最大Token数 (Max Tokens) 等参数。

- 保存并测试:保存应用配置,并进行测试,确保Gemini 2.5 Pro能够被成功调用。

成本考量与优化策略

Gemini 2.5 Pro 作为顶级模型,其API调用成本相对较高。以下是一些优化策略,特别是结合 laozhang.ai:

- 利用

laozhang.ai价格优势:laozhang.ai通常提供比官方更优惠的价格,特别是预付费套餐,这是最直接的成本优化方式。注册链接:https://api.laozhang.ai/register/?aff_code=JnIT - 监控用量:在Dify和

laozhang.ai平台(如果使用)密切关注token消耗。 - 提示词工程:优化你的Prompt,减少不必要的输入和输出token。

- 模型分层:对于简单任务,考虑在Dify工作流中使用更便宜的模型(如Gemini 2.0 Flash),仅在需要高级能力的步骤调用Gemini 2.5 Pro。

laozhang.ai通常也提供多种模型选择。 - 缓存:为重复的查询实现缓存机制,避免重复调用API。Dify本身可能提供一些基础缓存功能,或者你需要在应用逻辑中实现。

- 限制输出长度:在Dify的LLM节点设置中,明确指定最大输出token数,防止生成过长(且昂贵)的回复。

💡 成本优化核心:

对于国内开发者,结合Dify的灵活性和laozhang.ai的成本优势,是实现Gemini 2.5 Pro经济高效使用的最佳途径。优先考虑通过laozhang.ai接入,并利用其价格策略。

常见问题解答 (FAQ)

Q1: Dify中找不到Gemini 2.5 Pro模型选项怎么办?

A1: 首先,确保你的Dify版本较新,官方已添加对Gemini的支持。如果是通过官方Google供应商配置,尝试重新同步模型列表。如果是通过laozhang.ai中转,确认你在OpenAI供应商配置中正确设置了API Base URL,并检查laozhang.ai是否支持该模型名称的映射,或者尝试手动添加模型。

Q2: 使用laozhang.ai接入时,API Base URL填错了会怎样?

A2: 如果API Base URL不正确,Dify将无法连接到laozhang.ai的中转服务器,调用会失败,通常会报连接错误或认证失败。请务必填写 https://api.laozhang.ai/v1。

Q3: laozhang.ai是否支持Gemini 2.5 Pro的所有功能,比如多模态?

A3: 这取决于laozhang.ai服务的实现。通常,中转服务会尽量兼容核心的文本生成功能。对于多模态等高级特性,建议查阅laozhang.ai的官方文档或咨询客服确认其支持程度。文本聊天功能通常是完全支持的。

Q4: Dify调用Gemini 2.5 Pro报错"Quota Exceeded"或"Rate Limit"怎么办?

A4: 如果使用官方API,检查你在Google AI Studio的配额。如果使用laozhang.ai,检查你在该平台的账户余额或套餐限制。免费层级或低额度套餐可能会有较低的速率限制。考虑升级套餐或联系服务商调整配额。

Q5: 能否在Dify中同时配置官方Google和laozhang.ai两种方式接入Gemini 2.5 Pro?

A5: 可以。你可以在模型供应商中同时配置Google和OpenAI(指向laozhang.ai)。然后在具体的Dify应用节点中,根据需要选择使用哪个供应商下的Gemini 2.5 Pro模型。这为你提供了灵活性和备份选项。

总结与未来展望

将强大的Gemini 2.5 Pro集成到灵活的Dify平台,为构建下一代AI应用开辟了广阔的可能性。通过本文介绍的官方接入和laozhang.ai中转接入两种方法,开发者可以根据自身网络环境和成本预算,选择最合适的方案。

对于国内开发者,强烈推荐使用laozhang.ai中转服务,它不仅解决了访问稳定性问题,还提供了显著的成本优势。

关键要点回顾:

- Gemini 2.5 Pro为Dify应用带来顶尖AI能力。

- 可通过官方Google API或

laozhang.ai中转API接入。 - 配置

laozhang.ai的关键是设置正确的API Base URL (https://api.laozhang.ai/v1)。 - 结合模型分层、提示词优化和

laozhang.ai的价格优势进行成本控制。

随着Dify和Gemini模型的不断迭代,未来集成可能会更加顺畅,功能也会更加丰富。持续关注官方更新和社区动态,保持你的AI应用走在技术前沿。

🚀 立即开始! 访问 laozhang.ai 注册,获取API Key,在Dify中解锁Gemini 2.5 Pro的强大潜力吧!

【更新日志】

plaintext┌─ 更新记录 ──────────────────────────────────┐ │ 2025-04-10:首次发布Dify集成Gemini 2.5 Pro指南 │ │ 2025-04-09:测试并验证laozhang.ai接入流程 │ │ 2025-04-08:收集整理Gemini 2.5 Pro相关信息 │ └──────────────────────────────────────────────┘

🎉 特别提示:本文将根据Dify和Gemini的更新持续维护,建议收藏本页面!