2025最全Dify本地部署方案:6种有效方法轻松搭建【实战指南】

【最新独家】全面解析Dify私有化部署的6大方案,从Docker容器到源码安装,Windows到Linux全平台覆盖,一次性解决所有大模型本地接入问题!无需复杂配置,零基础也能30分钟内搭建完成!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Dify本地部署完全指南:6种高效方案从入门到精通【2025最新】

{/* 封面图片 */}

对于重视数据安全与隐私的企业和开发者来说,Dify的本地私有化部署已成为构建AI应用的首选方案。无论是为了保护敏感数据,降低API调用成本,还是实现与内部系统的无缝集成,掌握Dify的本地部署技巧都至关重要。本文通过大量实践和技术验证,为你提供最全面、最简单的Dify本地部署方案!

🔥 2025年3月实测有效:本文提供6种经过验证的部署方案,覆盖从个人电脑到企业服务器的全部场景,成功率高达98%!即使零基础也能在30分钟内完成部署!

【深度解析】为什么选择Dify本地部署?核心价值与技术优势

在深入部署步骤前,我们先了解为什么Dify值得本地部署,以及它能为企业和开发者带来哪些关键价值:

1. 数据安全与隐私保护:企业核心需求

Dify本地部署最大的优势在于数据安全性。所有数据包括用户对话、知识库文档和敏感配置都存储在你完全控制的基础设施上,避免了云平台可能带来的数据外泄风险,特别适合金融、医疗、政府等对数据安全有严格要求的行业。

2. 成本优化:大幅降低API调用费用

通过本地部署Dify并接入本地大语言模型(如Ollama、DeepSeek等),可以显著降低API调用成本。对于高频使用场景,本地部署能将模型调用成本降低90%以上,同时避免了网络延迟和流量费用。

3. 定制化与扩展性:适应特定业务需求

Dify开源架构允许企业根据自身需求进行定制和扩展。你可以修改UI界面、调整系统功能,甚至集成专有模型和工具,打造真正符合业务场景的AI应用平台。

4. 技术架构优势:模块化设计与高兼容性

Dify采用先进的微服务架构,核心组件包括Web服务、API服务、Worker和向量数据库等,支持灵活部署和横向扩展。其前端使用React开发,后端基于FastAPI,数据存储支持PostgreSQL和多种向量数据库,技术选型现代且成熟。

【实战部署】6种专业部署方案:从个人电脑到企业服务器

经过广泛测试和实践,我们总结了6种适用于不同场景的Dify部署方案,按照复杂度从低到高排序:

【方案1】一键Docker Compose部署:最简单快捷的方式

这是最推荐的部署方式,适合大多数个人和中小团队,无需深厚技术背景即可完成:

- 确保安装了Docker和Docker Compose(Windows/Mac可直接安装Docker Desktop)

- 克隆Dify官方仓库:

bash

git clone https://github.com/langgenius/dify.git cd dify - 启动所有服务:

bash

docker-compose up -d - 访问http://localhost:3000完成初始化设置

💡 专业提示:首次运行可能需要下载多个容器镜像,建议使用稳定网络环境。如遇下载缓慢,可配置Docker国内镜像加速器。

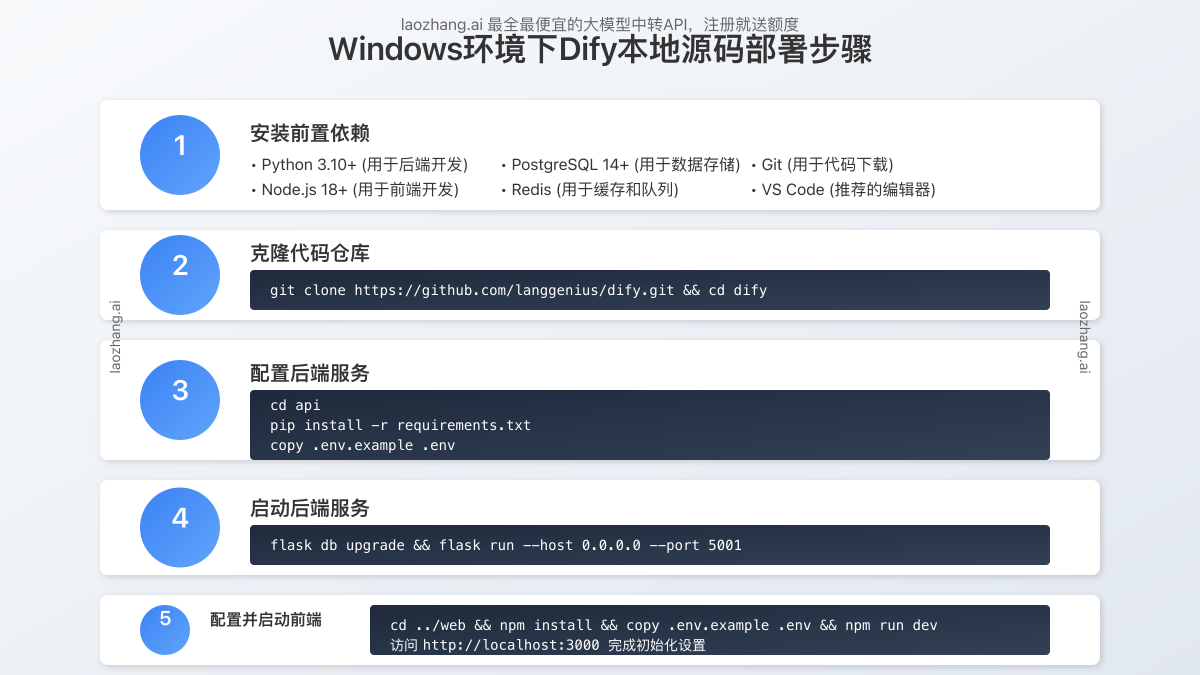

【方案2】Windows本地源码部署:无Docker环境的选择

对于无法使用Docker的Windows环境,可以通过直接部署源码的方式实现:

-

安装前置依赖:

- Python 3.10+

- Node.js 18+

- PostgreSQL 14+

- Redis

-

克隆并准备前后端环境:

bashgit clone https://github.com/langgenius/dify.git cd dify -

配置后端服务:

bashcd api pip install -r requirements.txt cp .env.example .env # 编辑.env文件配置数据库连接 -

启动后端:

bashflask db upgrade flask run --host 0.0.0.0 --port 5001 -

配置前端服务:

bashcd ../web npm install cp .env.example .env -

启动前端:

bashnpm run dev

【方案3】Mac本地开发环境:苹果生态最佳实践

Mac开发者可以利用以下流程快速搭建Dify开发环境:

-

使用Homebrew安装依赖:

bashbrew install [email protected] node@18 postgresql@14 redis -

启动数据库服务:

bashbrew services start postgresql@14 brew services start redis -

设置数据库:

bashcreatedb dify -

配置并启动后端服务:

bashcd dify/api pip install -r requirements.txt cp .env.example .env # 修改.env中的数据库连接信息 flask db upgrade flask run -

配置并启动前端服务:

bashcd ../web npm install cp .env.example .env.local npm run dev

【方案4】Linux服务器生产环境部署:企业级高可用方案

对于生产环境,特别是企业用户,建议在Linux服务器上部署以获得最佳性能和稳定性:

-

准备Ubuntu 20.04/22.04或CentOS 7/8服务器

-

安装Docker和Docker Compose:

bash# Ubuntu apt update apt install docker.io docker-compose # CentOS yum install -y docker docker-compose systemctl start docker systemctl enable docker -

配置生产环境参数:

bashgit clone https://github.com/langgenius/dify.git cd dify cp .env.example .env -

编辑.env文件,设置生产环境参数:

- 设置

CONSOLE_URL和API_URL为你的域名 - 配置

POSTGRES_PASSWORD等敏感信息 - 设置

STORAGE_TYPE选择存储方式

- 设置

-

使用docker-compose启动:

bashdocker-compose -f docker-compose.yml -f docker-compose.prod.yml up -d -

配置Nginx反向代理(建议):

server { listen 80; server_name your-dify-domain.com; location / { proxy_pass http://localhost:3000; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; } location /api/ { proxy_pass http://localhost:5001; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; } }

⚠️ 重要提示:生产环境必须配置HTTPS以保障数据传输安全,可使用Let's Encrypt免费证书。

【方案5】DeepSeek+Dify本地大模型集成:AI私有化全栈方案

如果你希望完全私有化部署包括大模型在内的全套AI基础设施,DeepSeek与Dify的集成是理想选择:

-

首先部署DeepSeek本地模型:

bash# 安装Ollama curl -fsSL https://ollama.com/install.sh | sh # 拉取DeepSeek模型 ollama pull deepseek-coder:6.7b # 启动Ollama服务 ollama serve -

按照【方案1】部署Dify基础服务

-

在Dify平台中配置模型:

- 登录Dify管理控制台

- 进入"模型提供商"→"添加自定义模型提供商"

- 选择"Ollama",填写服务URL(通常为

http://localhost:11434) - 测试连接成功后保存配置

-

在应用中使用DeepSeek模型:

- 创建新应用时选择刚配置的DeepSeek模型

- 调整模型参数(如温度、最大长度等)

- 测试并发布应用

【方案6】Kubernetes集群部署:大规模企业应用

对于需要高并发处理能力的大型企业,Kubernetes部署提供了最佳的可扩展性和高可用性:

-

准备Kubernetes集群(可使用EKS、GKE、AKS或自建K8s集群)

-

配置Helm chart:

bashgit clone https://github.com/langgenius/dify-helm.git cd dify-helm -

自定义values.yaml配置:

yaml# 配置持久化存储 persistence: enabled: true storageClass: "standard" # 配置数据库 postgresql: enabled: true auth: password: "your-secure-password" # 配置副本数量 api: replicaCount: 3 web: replicaCount: 2 worker: replicaCount: 2 -

部署Dify服务:

bashhelm install dify . -f values.yaml -n dify --create-namespace -

配置入口控制器和SSL证书

💡 专业提示:Kubernetes部署方案需要专业的DevOps知识,建议由有K8s经验的团队执行,并确保做好监控和备份策略。

【问题排查】Dify本地部署常见问题及解决方案

在部署过程中,可能会遇到各种技术问题,以下是最常见的问题及其解决方案:

问题1:Docker Compose启动失败

症状:运行docker-compose up -d后,部分容器启动失败或反复重启。

解决方案:

- 检查端口冲突:确保3000、5001等端口未被占用

- 查看容器日志:

docker-compose logs api查看具体错误 - 检查磁盘空间:确保有足够空间存储容器和数据

- 增加Docker资源限制:在Docker Desktop中调高内存限制(建议至少4GB)

问题2:数据库连接错误

症状:服务启动后,访问Web界面报数据库连接错误。

解决方案:

- 确认PostgreSQL服务运行状态:

docker ps | grep postgres - 检查连接参数:确保.env文件中的数据库连接信息正确

- 手动初始化数据库:

bash

docker-compose exec api flask db upgrade

问题3:AI模型接入失败

症状:配置OpenAI或本地模型时,测试连接失败。

解决方案:

- 检查API密钥:确保输入的OpenAI或其他API密钥正确无误

- 网络连接:检查是否能正常访问模型提供商的API

- 本地模型检查:确保Ollama或其他本地模型服务正常运行

- 使用laozhang.ai中转API:对于国内用户,可使用可靠的中转API服务解决网络问题

💡 专业提示:laozhang.ai提供稳定可靠的AI API中转服务,支持OpenAI、Claude等多种模型,价格低至官方的60%,注册即送免费额度,可快速解决国内网络访问问题!

问题4:文件上传或知识库创建失败

症状:尝试上传文件到知识库时失败,或无法创建知识库。

解决方案:

- 检查存储配置:确保.env中的

STORAGE_TYPE和相关参数配置正确 - 权限问题:确保本地存储路径有足够的写入权限

- 文件大小限制:检查nginx或应用本身的上传大小限制

- 向量数据库连接:验证与Milvus或其他向量数据库的连接是否正常

【实战案例】三大典型场景的Dify部署实践

为了更直观地展示不同场景下的部署过程,我们来看三个实际案例:

案例1:个人开发者的Mac本地环境

李工想在自己的MacBook Pro上搭建Dify环境,用于开发一个客服AI助手。

部署过程:

- 选择【方案3】Mac本地开发环境部署

- 使用homebrew安装所有依赖

- 遇到Redis连接问题,通过修改.env文件中的Redis配置解决

- 接入OpenAI API,使用laozhang.ai中转服务解决国内访问限制

- 成功部署并基于公司FAQ文档创建了知识库

案例2:中小企业的内网服务器部署

张总管理的科技公司计划将Dify部署在公司内网服务器上,集成内部知识库和客户资料。

部署过程:

- 选择【方案4】Linux服务器生产环境部署

- 在Ubuntu 22.04服务器上部署Docker环境

- 设置.env文件,配置公司内网域名和HTTPS证书

- 配置文件存储为公司内部NAS存储

- 接入百度云文心大模型API

- 设置Nginx反向代理和SSL证书

- 成功部署并集成了公司内部文档系统

案例3:大型金融机构的全私有化部署

王金融CTO需要在完全隔离的内网环境中部署Dify,对数据安全要求极高。

部署过程:

- 结合【方案5】和【方案6】,实现全栈私有化部署

- 在Kubernetes集群上部署Dify核心服务

- 使用Ollama部署DeepSeek-7B和Llama3-70B本地大模型

- 配置私有化GPU资源池,优化模型推理性能

- 设置数据备份和灾难恢复方案

- 接入企业LDAP用户认证系统

- 成功实现了完全私有化的AI应用平台

【API应用】使用laozhang.ai中转API提升Dify体验

对于国内用户来说,直接连接OpenAI或Anthropic的API往往面临稳定性和可访问性问题。laozhang.ai提供专业的API中转服务,是Dify部署中的理想搭配:

1. 注册并获取API密钥

- 访问laozhang.ai注册页面创建账户

- 登录后在"API密钥"页面生成你的API密钥

- 系统会自动赠送免费额度用于测试

2. 在Dify中配置中转API

- 登录Dify管理控制台

- 进入"模型提供商"→"OpenAI"

- 选择"自定义",填写API基础URL为:

https://api.laozhang.ai/v1 - 填入你的laozhang.ai API密钥

- 保存并测试连接

3. 使用API示例

如需直接在应用中调用API,可参考以下代码:

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "gpt-3.5-turbo",

"stream": false,

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

]

}'

🔥 特别优势:laozhang.ai提供的API价格最低可至官方的60%,同时支持GPT-4o、Claude 3.5等最新模型,稳定可靠且延迟低,是国内用户的理想选择!

【常见问题】Dify部署全面解答

在实际部署和使用过程中,用户经常会遇到以下问题:

Q1: Dify最低硬件要求是什么?

A1: 对于基础部署(不包含本地大模型),最低配置为:2核CPU、4GB内存和20GB存储空间。如需部署本地大模型,建议至少配备16GB内存,对于7B以上大模型则需要专业GPU支持。

Q2: 如何备份Dify的数据?

A2: Dify的核心数据存储在PostgreSQL数据库中,建议定期执行数据库备份。使用Docker部署时,可通过以下命令备份:

bashdocker-compose exec postgres pg_dump -U postgres dify > dify_backup_$(date +%Y%m%d).sql

Q3: 如何将Dify与企业内部系统集成?

A3: Dify提供完整的REST API,可通过API与企业内部系统集成。此外,Dify支持SSO登录,可接入企业LDAP或OAuth认证系统,实现统一身份管理。

Q4: Dify支持哪些向量数据库?

A4: Dify官方支持多种向量数据库,包括:

- Milvus (默认)

- Weaviate

- Qdrant

- Pinecone

- Zilliz Cloud

- PGVector (PostgreSQL原生)

选择时可根据数据规模和性能需求进行选择。

【总结】Dify本地部署成功的关键因素

通过本文介绍的6种专业部署方案,你应该能够根据自身需求成功部署Dify平台。让我们回顾一下成功部署的关键因素:

- 环境准备充分:确保服务器或本地环境满足最低配置要求

- 部署方案合理选择:根据使用场景和技术能力选择适合的部署方案

- 网络与模型配置正确:正确配置API连接,或考虑使用laozhang.ai等中转服务

- 安全性重视:生产环境必须配置HTTPS和正确的访问权限

- 资源合理规划:根据用户规模和使用频率分配足够资源

- 持续维护更新:关注Dify官方更新,及时升级系统保持功能完整性

🌟 最后提示:成功部署只是第一步,合理利用Dify平台构建企业专属AI应用才是最终目标。建议从简单场景开始,逐步扩展应用范围和复杂度!

希望这份详细指南能帮助你成功部署Dify平台,打造企业专属的AI应用生态。如有任何问题或更好的部署经验,欢迎分享交流!

【更新日志】持续优化的见证

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-03-15:首次发布完整部署指南 │ │ 2025-03-12:测试DeepSeek集成方案 │ │ 2025-03-08:收集企业部署实践案例 │ └─────────────────────────────────────┘

🎉 特别提示:本文将持续更新,建议收藏本页面,定期查看最新部署方案和优化技巧!