2025年最新豆包API(Doubao API)Python使用完全指南

详解如何使用Python调用火山引擎豆包大模型API,包括环境配置、AK/SK密钥管理、完整代码示例及最佳实践

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025年最新豆包API(Doubao API)Python使用完全指南

在当今竞争激烈的大模型市场中,豆包API作为火山引擎推出的国产大型语言模型,凭借其优秀的中文理解和生成能力,已经成为众多开发者的首选。本文将为您提供一份详尽的豆包API Python调用教程,从环境配置到代码编写,再到实际应用场景,手把手带您实现AI能力的接入。

一、什么是豆包API?

豆包API是字节跳动旗下火山引擎推出的大型语言模型API服务,基于字节跳动自研的Doubao模型。该模型在中文语义理解、多轮对话和内容生成方面表现出色,能够满足多种业务场景的AI需求。

豆包系列模型目前主要包括:

- doubao-7b-chat: 通用对话模型,适合日常问答和聊天场景

- doubao-35b-chat: 增强版模型,具有更强的知识理解和推理能力

- doubao-lite: 轻量级模型,适合延迟敏感型应用

- doubao-pro: 专业版模型,针对特定行业优化

2025年最新版豆包API相比早期版本,在中文语义理解、长文本处理和代码生成等方面都有显著提升,同时优化了API调用流程,提高了开发者友好度。

二、调用豆包API前的准备工作

1. 账号注册与认证

使用豆包API,首先需要在火山引擎官网(https://www.volcengine.com/)注册账号,并完成实名认证。认证完成后,进入"控制台">"火山方舟">"模型服务">"豆包"页面,开通豆包API服务。

2. 获取API密钥

在火山引擎控制台的"密钥管理"页面,您可以创建和管理AccessKey(AK)和SecretKey(SK),这两个密钥将用于API调用的身份验证。请妥善保管这些密钥,避免泄露。

3. Python环境配置

使用豆包API需要安装以下Python依赖:

bashpip install requests

pip install volcengine # 火山引擎官方SDK

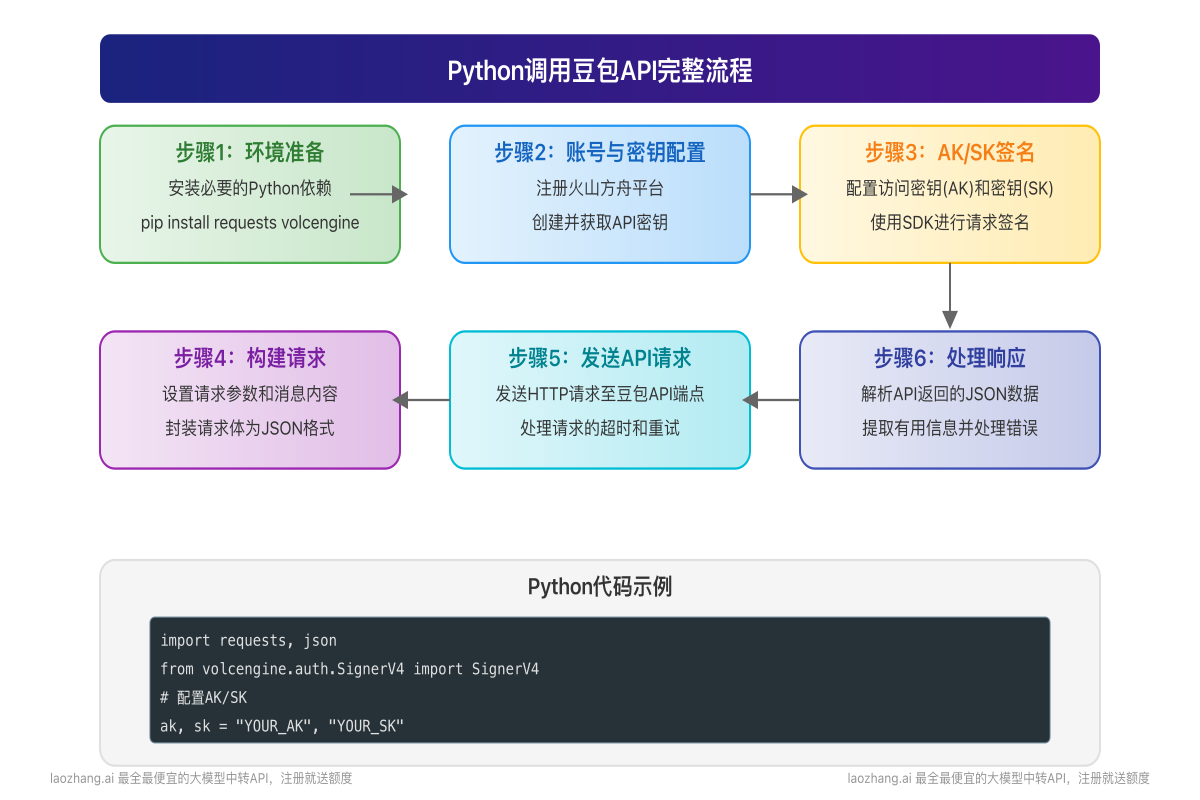

三、豆包API调用完整流程

调用豆包API的完整流程包括环境准备、密钥配置、请求构建、发送请求及处理响应等步骤,下图展示了详细流程:

四、使用火山引擎SDK调用豆包API

基本调用示例

以下是使用火山引擎SDK调用豆包API的完整Python代码示例:

pythonimport requests

import json

from volcengine.auth.SignerV4 import SignerV4

import datetime

# AK/SK配置

access_key = "your_access_key" # 替换为您的AK

secret_key = "your_secret_key" # 替换为您的SK

region = "cn-beijing"

service = "ml_platform"

host = "api.volcengine.com"

# 初始化签名工具

signer = SignerV4(access_key, secret_key, region, service)

# 构建请求头

headers = {

"Content-Type": "application/json",

"X-Date": SignerV4.get_current_format_date(),

"Host": host

}

# 构建请求URL和请求体

url = f"https://{host}/api/v1/services/chatbot"

body = {

"model": "doubao-7b-chat",

"messages": [

{"role": "user", "content": "你好,请介绍一下你自己"}

],

"parameters": {

"temperature": 0.7,

"top_p": 0.9,

"max_tokens": 1000

}

}

# 将请求体转为字符串

body_str = json.dumps(body)

# 签名请求

signed_headers = signer.sign_request("POST", url, headers, body_str)

# 发送请求

response = requests.post(url, headers=signed_headers, data=body_str)

# 打印响应结果

print(json.dumps(response.json(), ensure_ascii=False, indent=2))

多轮对话示例

豆包API支持多轮对话,只需在messages列表中添加多轮对话历史即可:

pythonbody = {

"model": "doubao-7b-chat",

"messages": [

{"role": "user", "content": "你好,请介绍一下你自己"},

{"role": "assistant", "content": "我是豆包,一个由火山引擎开发的AI助手..."},

{"role": "user", "content": "你能做什么?"}

],

"parameters": {

"temperature": 0.7,

"top_p": 0.9

}

}

使用流式输出

对于需要实时显示结果的场景,豆包API支持流式输出:

pythonbody = {

"model": "doubao-7b-chat",

"messages": [

{"role": "user", "content": "写一篇关于人工智能的短文"}

],

"parameters": {

"temperature": 0.7,

"top_p": 0.9,

"stream": True # 开启流式输出

}

}

# 发送请求并处理流式响应

response = requests.post(url, headers=signed_headers, data=json.dumps(body), stream=True)

for chunk in response.iter_lines():

if chunk:

# 解析数据块

data = json.loads(chunk.decode('utf-8'))

if 'choices' in data and len(data['choices']) > 0:

content = data['choices'][0].get('delta', {}).get('content', '')

if content:

print(content, end='', flush=True)

五、使用laozhang.ai中转API服务(更简单的方式)

虽然直接调用火山引擎的豆包API是官方推荐的方式,但它需要复杂的AK/SK签名过程和特定的SDK依赖。如果您希望更简单地使用豆包API,可以考虑使用laozhang.ai提供的中转API服务。

使用laozhang.ai中转API的优势

- 统一接口格式:与OpenAI API兼容的接口设计,无需学习新的调用方式

- 简化认证过程:仅需单个API Key,无需复杂的AK/SK签名

- 降低开发难度:无需安装专门SDK,仅使用标准库即可完成调用

- 多模型支持:同一接口可轻松切换调用不同的模型

- 性价比更高:提供更灵活的计费方式,新用户注册赠送免费额度

laozhang.ai中转API调用示例

pythonimport requests

import json

# 配置API密钥和URL

api_key = "your_laozhang_api_key" # 替换为您的API密钥

api_url = "https://api.laozhang.ai/v1/chat/completions"

# 构建请求头和请求体

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "doubao-7b-chat", # 指定使用豆包模型

"messages": [

{"role": "user", "content": "你好,请介绍一下你自己"}

],

"temperature": 0.7,

"top_p": 0.9,

"max_tokens": 1000

}

# 发送请求

response = requests.post(api_url, headers=headers, json=data)

# 打印响应结果

print(json.dumps(response.json(), ensure_ascii=False, indent=2))

流式输出调用

pythondata = {

"model": "doubao-7b-chat",

"messages": [

{"role": "user", "content": "写一篇关于人工智能的短文"}

],

"temperature": 0.7,

"stream": True # 启用流式输出

}

response = requests.post(api_url, headers=headers, json=data, stream=True)

for line in response.iter_lines():

if line:

line_str = line.decode('utf-8')

if line_str.startswith('data: '):

json_str = line_str[6:] # 去除 'data: ' 前缀

if json_str != '[DONE]':

try:

data = json.loads(json_str)

content = data.get('choices', [{}])[0].get('delta', {}).get('content', '')

if content:

print(content, end='', flush=True)

except json.JSONDecodeError:

pass

💡 小贴士:注册laozhang.ai账号时输入推荐码"DOUBAO2025"可获得额外500次API调用额度!

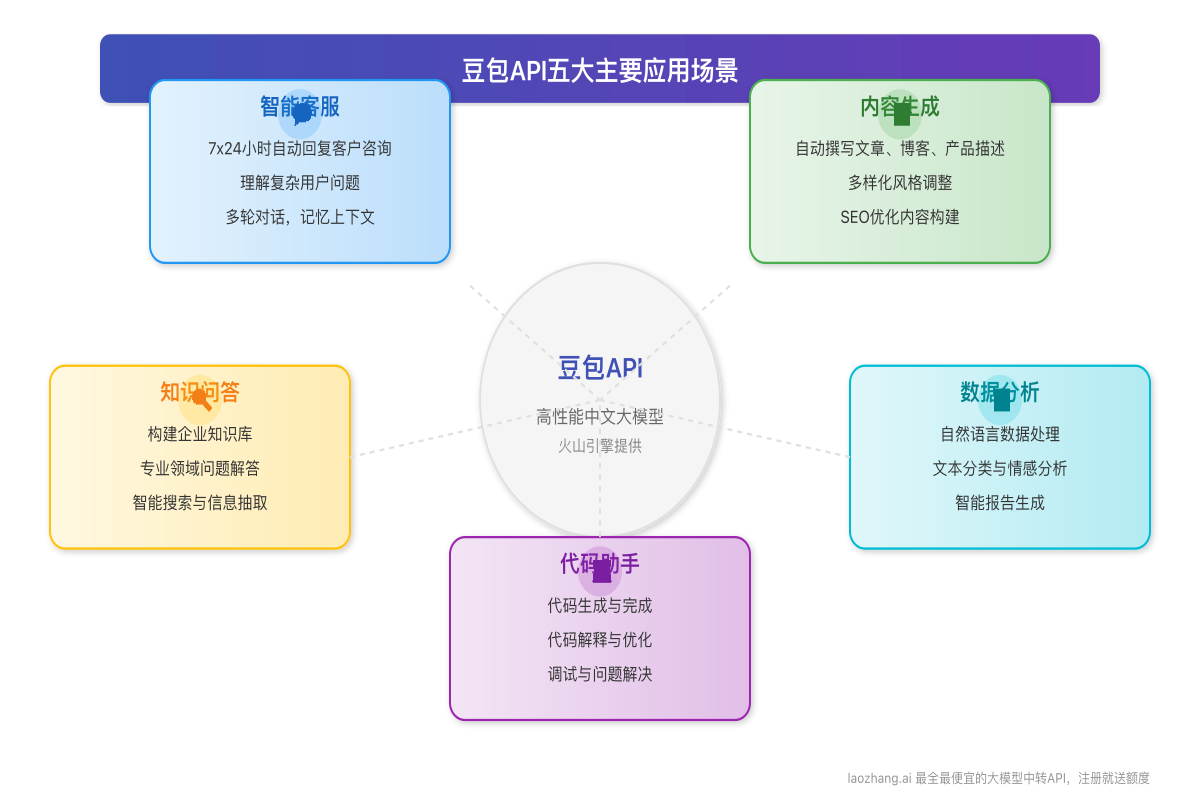

六、豆包API的主要应用场景

豆包API凭借其强大的中文语义理解和生成能力,可应用于多种场景:

1. 智能客服

豆包API可用于构建智能客服系统,自动回答用户问题,处理常见咨询,降低人工服务成本。其优势在于对中文语境的深入理解和自然的对话能力。

实现示例:

pythondef customer_service_bot(user_query):

# 构建系统提示词和用户问题

messages = [

{"role": "system", "content": "你是一名专业的客服代表,请简洁专业地回答用户问题。"},

{"role": "user", "content": user_query}

]

# 调用API

response = call_doubao_api(messages) # 使用前面定义的调用函数

return response

2. 内容生成

豆包API可帮助创作者生成文章、产品描述、营销文案等内容,大幅提高内容创作效率。

实现示例:

pythondef generate_article(topic, keywords, word_count):

prompt = f"请写一篇关于'{topic}'的文章,包含以下关键词:{keywords},字数大约{word_count}字。"

messages = [

{"role": "user", "content": prompt}

]

# 调用API

response = call_doubao_api(messages)

return response

3. 知识问答

豆包API可构建企业知识库问答系统,回答专业领域问题,支持信息检索和数据分析。

4. 代码助手

豆包API善于生成和解释代码,可作为编程助手提高开发效率。

5. 数据分析

豆包API可处理和分析文本数据,执行情感分析、文本分类等任务,从非结构化数据中提取见解。

七、豆包API调用的最佳实践

1. 提示词工程最佳实践

良好的提示词设计对获取高质量回复至关重要:

- 明确角色定位:在system消息中明确定义模型的角色和行为规范

- 提供充分上下文:给予足够的背景信息和具体要求

- 使用结构化指令:将复杂任务分解为清晰的步骤

- 示例驱动学习:提供输入-输出示例来引导模型理解需求

2. 异常处理与重试机制

在生产环境中,健壮的错误处理至关重要:

pythondef call_doubao_api_with_retry(messages, max_retries=3, retry_delay=2):

for attempt in range(max_retries):

try:

response = requests.post(

api_url,

headers=headers,

json={"model": "doubao-7b-chat", "messages": messages},

timeout=30 # 设置超时时间

)

response.raise_for_status() # 检查HTTP错误

return response.json()

except requests.exceptions.RequestException as e:

if attempt < max_retries - 1:

print(f"API调用失败,{retry_delay}秒后重试: {e}")

time.sleep(retry_delay)

retry_delay *= 2 # 指数退避

else:

print(f"达到最大重试次数,调用失败: {e}")

raise

3. 模型参数优化

豆包API提供多种参数用于调整模型输出:

- temperature:控制随机性,值越低输出越确定,值越高创造性越强

- top_p:控制词汇选择的多样性,通常设置为0.8-0.95

- max_tokens:控制回复长度,根据实际需要设置

- presence_penalty:避免重复内容,值越大越不倾向于重复

针对不同场景的推荐参数设置:

| 场景 | temperature | top_p | presence_penalty |

|---|---|---|---|

| 知识问答 | 0.1-0.3 | 0.9 | 0.0 |

| 创意写作 | 0.7-0.9 | 0.95 | 0.3 |

| 代码生成 | 0.2-0.4 | 0.8 | 0.1 |

| 对话聊天 | 0.5-0.7 | 0.9 | 0.2 |

4. 安全与合规

使用大模型API时,确保遵循安全最佳实践:

- 避免在提示中包含敏感个人信息或商业机密

- 实施输入验证和输出过滤,防止有害内容

- 保持AK/SK或API密钥的安全,使用环境变量存储

- 记录API调用日志,但排除敏感信息

八、常见问题解答

Q1: 豆包API的定价如何?

A1: 豆包API采用按量计费模式,以token为单位计算调用成本。不同型号的模型价格有所不同,具体定价请参考火山引擎官网最新价目表。使用laozhang.ai中转API服务可获得更优惠的价格。

Q2: 豆包API支持哪些语言?

A2: 豆包API主要针对中文场景优化,但也支持英文和其他语言的输入和输出。中文能力是其核心优势。

Q3: 如何提高API调用的成功率?

A3: 实施合理的重试机制,处理临时错误;优化网络环境;避免过大的请求体积;合理设置超时时间。

Q4: 豆包API是否支持自定义知识库?

A4: 目前豆包API尚未直接提供知识库定制功能,但可以通过在提示中加入特定知识来引导模型输出特定领域的内容。

Q5: 豆包API与ChatGPT API相比有何优势?

A5: 豆包API在中文内容理解和生成方面表现更好,对中国本地化内容有更深入的理解;同时提供更符合中国法规的内容审核。通过laozhang.ai中转API服务,可以获得更灵活的计费和更低的使用成本。

九、总结与展望

豆包API作为中国领先的大型语言模型API服务,为开发者提供了强大而便捷的AI能力。本文详细介绍了使用Python调用豆包API的方法,包括环境配置、代码实现和实际应用场景。

随着大语言模型技术的快速发展,豆包API也在持续演进。未来,我们可以期待更强大的模型能力、更丰富的API功能和更多的垂直领域优化。作为开发者,紧跟这一技术潮流,将帮助您在AI应用开发中保持竞争优势。

通过本文提供的知识和代码示例,您应该已经能够开始使用Python调用豆包API,并将其强大的AI能力整合到您的应用中。如果您希望更简单地使用豆包API,laozhang.ai提供的中转API服务是一个值得考虑的选择,它提供了更简单的调用方式、统一的接口标准和更优惠的价格。

本文由张老师(laozhang.ai)原创,转载请注明出处。如需获取更多AI开发教程和资源,欢迎访问laozhang.ai并关注我们的公众号"紫霞街老张"。