2025年免费获取ChatGPT API额度最全指南:8种有效方法无需信用卡

【2025最新】最全面的免费ChatGPT API额度获取攻略,包含官方计划每天高达1100万tokens、研究人员$1000额度申请、新用户$5初始额度,及性价比最高的API中转服务对比!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025年免费获取ChatGPT API额度终极指南:8种有效方法全面解析

{/* 封面图片 */}

在2025年的AI开发浪潮中,OpenAI的API已成为众多开发者和企业不可或缺的工具。然而,随着应用规模扩大,API费用也成为不少团队面临的挑战。好消息是,通过正确的方法和渠道,完全可以合法免费获取大量API额度!本文汇总了8种经过验证的免费获取ChatGPT API额度的方法,从官方计划到替代方案,全面解析如何在2025年降低AI开发成本。

🔥 2025年5月实测有效:OpenAI将免费token计划延长至4月30日,分享数据的组织每天可获高达1100万免费tokens!新用户注册仍可获得$5初始额度,有效期3个月。

一、为什么需要ChatGPT API额度?了解成本与价值

在探索免费获取API额度的方法前,让我们先了解OpenAI API的价值及其费用结构,这有助于我们更好地评估不同获取方式的性价比。

1. ChatGPT API的核心价值

ChatGPT API提供了对OpenAI强大语言模型的编程访问,使开发者能够将AI功能无缝集成到自己的应用中。与网页版ChatGPT相比,API版本具有显著优势:

- 完全可定制化:控制输入、输出格式及参数设置

- 适合批量处理:高效处理大量请求

- 系统级集成:无缝融入现有软件架构

- 更高的稳定性:专为开发者设计的可靠基础设施

- 私有数据控制:更好的数据安全保障

2. 2025年OpenAI API价格结构

了解当前的价格结构有助于评估免费额度的实际价值:

| 模型 | 输入价格($/百万tokens) | 输出价格($/百万tokens) | 上下文窗口 |

|---|---|---|---|

| GPT-4o | $5.00 | $15.00 | 128K |

| GPT-4o mini | $0.15 | $0.60 | 128K |

| o3-mini | $1.10 | $4.40 | 200K |

| GPT-3.5 Turbo | $0.50 | $1.50 | 16K |

💡 专业提示:GPT-4o系列的价格在2025年较2024年有所调整,使用免费额度时应优先考虑成本效益较高的模型。

3. API使用成本计算示例

以下是几个实际API使用场景的成本估算,帮助理解免费额度的实际价值:

-

中型聊天机器人(每日1000次对话):

- 输入:约200万tokens/月

- 输出:约150万tokens/月

- 使用GPT-3.5 Turbo成本:约$3.25/天,$97.5/月

- 使用GPT-4o成本:约$32.5/天,$975/月

-

内容生成应用(每日100篇文章):

- 输入:约400万tokens/月

- 输出:约1000万tokens/月

- 使用GPT-3.5 Turbo成本:约$17/天,$510/月

- 使用GPT-4o成本:约$245/天,$7350/月

这些数据表明,即使是中小规模应用,API成本也可能相当可观,因此寻找免费额度途径就显得尤为重要。

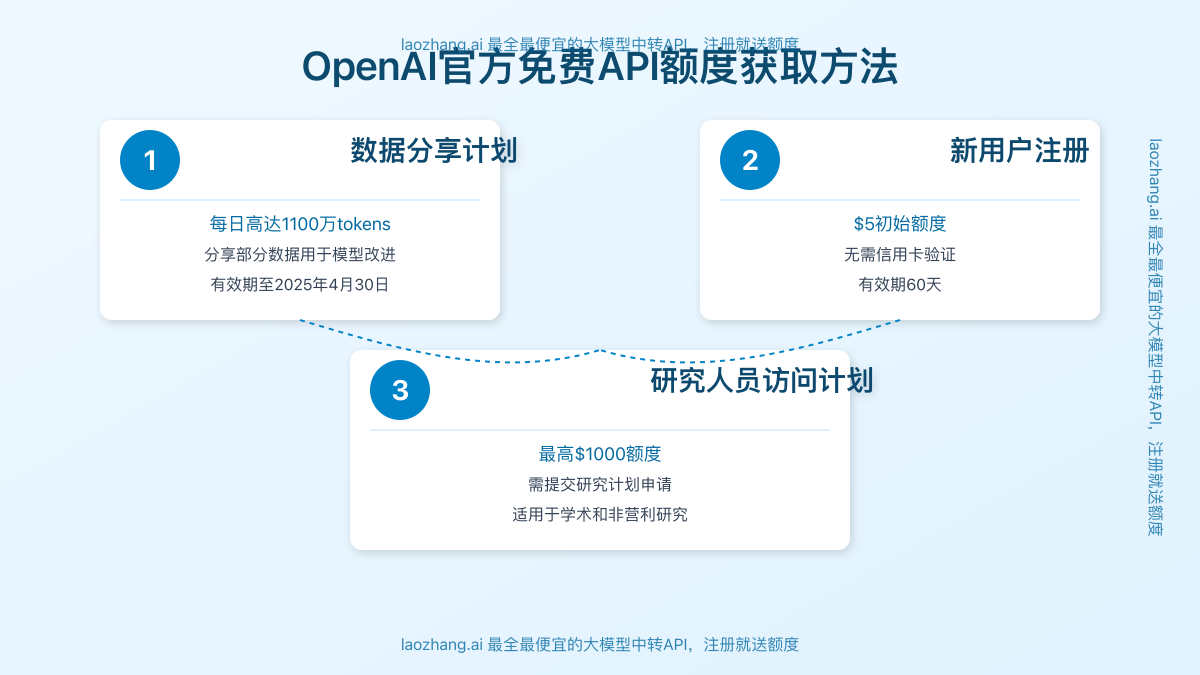

二、官方免费额度获取方式(经过验证的可靠渠道)

OpenAI官方提供了几种获取免费API额度的渠道,这些方式最为可靠且完全合规。

1. OpenAI数据分享计划:每天高达1100万免费tokens

适合对象:拥有OpenAI组织账户的开发团队或企业

这是目前最慷慨的官方免费额度来源。OpenAI在2024年12月推出了这一计划,并已延长至2025年4月30日。参与组织可以获得:

- 每天100万免费tokens:适用于GPT-4o、o1和o1-preview模型

- 每天1000万免费tokens:适用于GPT-4o mini、o1-mini和o3-mini模型

如何参与:

- 登录你的OpenAI组织账户

- 访问组织设置页面

- 在"数据共享设置"部分选择"启用与OpenAI共享提示和完成内容"

- 保存设置,系统会立即激活免费额度

重要注意事项:

- 组织余额必须保持大于零才能使用免费token

- 免费额度会优先于付费额度使用

- 此计划目前仅对组织账户开放,个人账户不适用

- 数据共享意味着你的API输入和输出将被OpenAI收集用于改进模型

⚠️ 注意:尽管此计划非常吸引人,但请确保共享的数据不包含敏感或机密信息。OpenAI表示共享的数据将用于模型改进。

2. 新用户注册赠送$5初始额度

适合对象:首次创建OpenAI API账户的新用户

OpenAI为新注册用户提供$5的API额度,作为入门体验:

- 额度金额:$5(约等于100万GPT-3.5 Turbo输入tokens)

- 有效期:自注册之日起3个月

- 适用模型:所有可用模型,包括GPT-4o、GPT-3.5等

获取方式:

- 访问OpenAI官网创建新账户

- 完成电子邮件验证步骤

- 无需立即绑定信用卡即可获得初始额度

关键提示:

- 初始额度用完或过期后,需要绑定支付方式才能继续使用

- 使用不同邮箱重复注册可能导致账户被封

3. OpenAI研究者访问计划(最高$1000额度)

适合对象:学术研究人员、AI安全研究者、社会影响研究者

这是OpenAI专为研究人员设立的资助计划,提供高达$1000的API额度:

- 额度金额:最高$1000

- 有效期:12个月,不可延长或续期

- 申请周期:每季度审核一次(3月、6月、9月和12月)

申请条件:

- 研究方向与AI安全、公平性、社会影响等相关

- 提交详细的研究计划和预期成果

- 优先支持资源有限的早期研究者

申请流程:

- 访问OpenAI研究者访问计划页面

- 创建账户并填写申请表

- 详细描述研究目标和方法论

- 等待季度审核(可能需要4-8周)

成功提示:

- 清晰说明研究如何促进AI安全发展

- 强调研究的原创性和潜在影响

- 如果是资源有限的研究者,请在申请中说明

三、替代API服务:低成本甚至免费的选择

如果官方渠道无法满足你的需求,以下是一些值得考虑的替代方案,可以显著降低成本甚至免费使用。

1. laozhang.ai中转API服务:注册送额度

适合对象:寻找稳定且经济实惠API服务的开发者

laozhang.ai是目前最受欢迎的API中转服务之一,不仅提供比官方更低的价格,还为新用户提供免费额度:

- 新用户注册礼:免费赠送等值体验金

- 支持模型:不仅包括OpenAI全系列模型,还支持Claude、Gemini等

- 价格优势:OpenAI模型价格低至官方7折

- 无需国外信用卡:支持支付宝、微信等国内支付方式

使用步骤:

- 访问laozhang.ai注册页面创建账户

- 验证邮箱后自动获得免费额度

- 在开发者设置中创建API密钥

- 将API请求地址从OpenAI官方更改为laozhang.ai的服务器

代码示例(Python):

pythonimport openai

# 配置API密钥和基础URL

openai.api_key = "你的laozhang.ai API密钥"

openai.base_url = "https://api.laozhang.ai/v1"

# 调用API,与OpenAI官方格式完全一致

response = openai.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "你是一个有帮助的助手。"},

{"role": "user", "content": "请解释什么是API?"}

]

)

print(response.choices[0].message.content)

💡 专业提示:中转服务的API调用格式与OpenAI官方完全兼容,只需更改API地址和密钥,无需修改代码结构。

2. 开源模型API:完全免费的自托管选择

适合对象:拥有服务器资源且追求完全控制的开发者

如果你有自己的服务器或云资源,使用开源模型可能是成本效益最高的长期策略:

- 完全免费:无需支付API调用费用

- 无限制使用:不受速率限制或配额限制

- 完全隐私:数据不离开你的服务器

- 高度定制:可根据需求微调模型

推荐开源模型:

- Mistral 7B/8B:轻量级但性能优秀

- Llama 3.1 70B:接近商业模型的强大性能

- Phi-3 Mini:微软开源的高效小型模型

部署方法:

代码示例(使用Ollama):

pythonimport requests

# 调用本地Ollama API

response = requests.post('http://localhost:11434/api/generate',

json={

'model': 'llama3',

'prompt': '请解释什么是API?',

'stream': False

}

)

print(response.json()['response'])

3. 学生开发者计划:教育机构免费额度

适合对象:学生、教师和教育机构

多家AI提供商为教育用途提供特殊的免费额度计划:

- GitHub Student Developer Pack:包含一定数量的OpenAI API免费额度

- Google Cloud for Education:包括Gemini API免费额度,可作为替代方案

- Anthropic Academic Access:提供Claude API的教育访问计划

申请步骤:

- 使用教育邮箱注册相关平台

- 提供学生/教师身份证明文件

- 完成教育身份验证流程

- 领取专属免费额度

💡 专业提示:许多大学已与AI提供商建立合作关系,可以咨询学校IT部门是否有校园授权计划。

4. AI创业支持计划:初创公司专属资源

适合对象:早期阶段AI创业公司

许多加速器和孵化器为AI初创公司提供免费API额度作为创业支持:

- Y Combinator创业资源:YC支持的创业公司可获取特殊额度

- Microsoft for Startups:包含Azure OpenAI服务额度

- OpenAI Startup Fund:获选公司可获得大量API额度

申请要求:

- 公司必须处于早期阶段(通常成立不超过2年)

- 业务模型需要围绕AI技术构建

- 需要展示创新性和市场潜力

5. 社区贡献计划:通过参与获取额度

适合对象:愿意贡献时间和专业知识的开发者

许多AI公司通过社区贡献项目回馈活跃贡献者:

- 开源项目贡献:为OpenAI相关开源项目提交PR

- 模型评估参与:参与模型评估和反馈项目

- 数据标注项目:参与高质量训练数据的标注

参与方式:

- 关注OpenAI GitHub仓库和社区论坛

- 加入相关Discord和Slack社区

- 积极参与标记为"good first issue"的任务

- 参与官方举办的黑客松和挑战赛

四、高效使用策略:最大化免费额度价值

获取免费额度后,如何高效使用这些资源也是一门学问。以下策略可以帮助你最大化每一个token的价值。

1. 混合模型使用策略

不同任务适合不同模型,合理分配可以显著降低token消耗:

- 简单任务:使用GPT-3.5 Turbo或GPT-4o mini

- 复杂推理:保留GPT-4o用于真正需要高级理解的场景

- 创建决策树:构建模型选择逻辑,根据任务复杂度自动选择

实施示例:

pythondef select_model(task_complexity, is_visual=False):

if is_visual:

return "gpt-4o" # 视觉任务需要多模态能力

elif task_complexity == "high":

return "gpt-4o" # 复杂推理任务

elif task_complexity == "medium":

return "gpt-4o-mini" # 中等复杂度任务

else:

return "gpt-3.5-turbo" # 简单任务

2. 提示词工程优化

精心设计的提示词可以减少所需token数量,同时提高响应质量:

- 清晰具体:减少多轮澄清的需要

- 结构化格式:指定输出格式,减少不必要的内容

- 上下文压缩:总结历史上下文而非完整包含

- 使用系统提示:利用system prompt设定全局行为

优化示例:

python# 优化前(消耗更多token)

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "user", "content": "我想了解什么是API,它有什么用途,如何使用它,以及使用API的最佳实践有哪些。另外,能否给我一些学习API的资源推荐?"}

]

)

# 优化后(更精确,消耗更少token)

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "你是一个简洁的技术解释专家,回答应精确、直接,避免不必要的细节。"},

{"role": "user", "content": "以列表形式解释:1.API定义 2.主要用途 3.基础使用步骤"}

]

)

3. 实施缓存策略

为常见查询实施缓存可以大幅减少API调用次数:

- 语义缓存:使用嵌入模型计算相似度,复用相近问题的回答

- 结果预生成:预先生成常见问题的回答

- 部分响应缓存:缓存通用部分,只对个性化部分调用API

实现示例:

pythonimport hashlib

import json

from datetime import datetime, timedelta

# 简单的基于字典的缓存实现

cache = {}

def get_cached_or_new_response(prompt, model="gpt-3.5-turbo", ttl_hours=24):

# 创建缓存键

prompt_hash = hashlib.md5(prompt.encode()).hexdigest()

cache_key = f"{model}:{prompt_hash}"

# 检查缓存

if cache_key in cache:

cached_item = cache[cache_key]

if datetime.now() < cached_item["expires"]:

print("Using cached response")

return cached_item["response"]

# 缓存未命中,调用API

response = client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": prompt}]

)

# 存入缓存

result = response.choices[0].message.content

cache[cache_key] = {

"response": result,

"expires": datetime.now() + timedelta(hours=ttl_hours)

}

return result

4. 批量处理请求

将多个请求合并为一个可以提高效率并减少开销:

- 合并相似查询:将多个相关问题合并为单个请求

- 批量内容生成:一次请求生成多个变体或版本

- 异步批处理:收集非紧急请求,定期批量处理

批处理示例:

python# 单独处理多个请求(低效)

responses = []

questions = ["什么是API?", "如何使用REST API?", "GraphQL有什么优势?"]

for question in questions:

resp = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": question}]

)

responses.append(resp.choices[0].message.content)

# 批量处理(更高效)

batch_response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "对每个问题提供简短明确的回答。"},

{"role": "user", "content": "\n".join([

"1. 什么是API?",

"2. 如何使用REST API?",

"3. GraphQL有什么优势?"

])}

]

)

5. 使用细化模型

针对特定任务创建细化模型可以显著降低token使用量:

- 专业领域模型:针对特定行业或领域微调模型

- 指令优化:通过微调使模型更好地遵循特定格式指令

- 减少解释需求:微调模型理解特定术语和上下文

五、API中转服务详细对比

随着中转API服务在开发者社区的普及,选择合适的服务商变得尤为重要。以下是主流中转服务的详细对比:

1. 价格对比

| 服务商 | OpenAI模型折扣 | 最低充值额 | 免费试用额度 | 支持模型数量 |

|---|---|---|---|---|

| laozhang.ai | 7折 | ¥50 | $1 | 200+ |

| API365 | 7.5折 | ¥100 | $0.5 | 150+ |

| API2D | 8折 | ¥50 | 无 | 50+ |

| Azure OpenAI | 9折(长期合约) | $25 | 有(企业) | 仅OpenAI |

| 智谱API | 8.5折 | ¥100 | 无 | 30+ |

2. 稳定性与可用性对比

| 服务商 | 可用性SLA | 全球加速 | 平均响应时间 | 并发请求限制 |

|---|---|---|---|---|

| laozhang.ai | 99.9% | 支持 | 小于500ms | 无严格限制 |

| API365 | 99.5% | 部分地区 | 小于800ms | 每分钟100次 |

| API2D | 99% | 不支持 | 小于1000ms | 每分钟50次 |

| Azure OpenAI | 99.9% | 支持 | 小于600ms | 按套餐定制 |

| 智谱API | 99.5% | 中国优化 | 小于700ms | 每分钟80次 |

3. 功能特性对比

| 服务商 | 模型选择 | 自定义参数 | 流式响应 | 数据安全承诺 |

|---|---|---|---|---|

| laozhang.ai | 全面支持 | 完全支持 | 支持 | 不记录用户数据 |

| API365 | 大部分支持 | 部分限制 | 支持 | 不记录敏感数据 |

| API2D | 主流模型 | 基础参数 | 部分支持 | 未明确说明 |

| Azure OpenAI | 延迟支持 | 完全支持 | 支持 | 企业级数据保护 |

| 智谱API | 主流+国产 | 大部分支持 | 支持 | 符合国内法规 |

4. 支付与客户服务对比

| 服务商 | 支付方式 | 退款政策 | 技术支持 | 文档完善度 |

|---|---|---|---|---|

| laozhang.ai | 支付宝/微信/USDT | 未用额度可退 | 24/7支持 | 5/5 |

| API365 | 支付宝/微信 | 7天内可退 | 工作时间 | 4/5 |

| API2D | 支付宝/微信/信用卡 | 不支持退款 | 邮件支持 | 3/5 |

| Azure OpenAI | 信用卡/企业账单 | 按Azure政策 | 企业级支持 | 5/5 |

| 智谱API | 支付宝/微信/对公转账 | 未用额度可退 | 工作时间 | 4/5 |

推荐选择:综合价格、稳定性和功能特性,laozhang.ai在大多数指标上表现最佳,特别适合希望获得免费额度并后续以低成本使用API的开发者。

六、常见问题解答(FAQ)

Q1: OpenAI的免费token计划是否会继续延长?

A1: 目前OpenAI已将数据分享计划的免费token福利延长至2025年4月30日,并承诺在计划结束前30天发出通知。根据历史经验,如果该计划对模型改进有显著帮助,很可能会进一步延长或演变为新的形式。

Q2: 注册OpenAI账户获得的$5初始额度可以用于哪些模型?

A2: 初始的$5额度可用于OpenAI提供的所有API模型,包括GPT-4o、GPT-3.5 Turbo、Embedding模型等。这些额度有效期为注册后的3个月,过期后需要添加付款方式才能继续使用。

Q3: 使用API中转服务是否安全?有什么隐私风险?

A3: 优质的API中转服务通常采用加密传输和严格的数据处理政策,不会存储用户的查询内容和返回结果。建议选择有明确隐私政策的服务商,并避免在API请求中包含敏感个人信息或商业机密。对于高敏感数据,考虑使用Azure OpenAI或自托管开源模型。

Q4: 如何判断我的应用是否适合使用免费的开源模型替代OpenAI API?

A4: 考虑以下因素:

- 任务复杂度:简单任务(文本分类、情感分析)开源模型表现良好

- 资源限制:是否有足够GPU资源运行开源模型

- 质量要求:对输出质量和一致性的严格程度

- 响应速度:是否能接受可能较长的推理时间

- 专业领域:特定领域任务可能需要专门微调

Q5: 研究者访问计划的申请成功率如何?提高通过概率的技巧是什么?

A5: 根据社区反馈,研究者访问计划的申请成功率约为20-30%,主要取决于研究主题的相关性和潜在影响。提高通过概率的关键包括:

- 明确说明研究与AI安全、公平性或社会影响的直接关联

- 提供详细且可行的研究方法和时间表

- 强调研究成果如何回馈AI社区

- 如有可能,附上相关领域的先前研究成果或发表论文

- 表明资源限制(如来自资源有限地区或机构)

Q6: 可以将多种免费获取方法结合使用吗?

A6: 完全可以!实际上,许多开发者会结合多种方法以最大化免费资源:

- 使用组织账户参与数据分享计划获取大量免费token

- 同时使用中转服务获取额外折扣和更多模型选择

- 对不同任务使用不同来源的API:关键任务用官方API,测试和开发用中转服务

- 结合开源模型处理适合的任务部分

七、未来趋势与可持续API使用策略

1. API价格趋势预测

根据行业发展和历史数据,我们可以预测以下趋势:

- 整体降价趋势:随着计算成本下降和竞争加剧,预计API价格将继续下降

- 差异化定价:更细致的按能力定价,高级功能单独收费

- 免费额度策略:更多针对特定用例的免费层级

- 开源模型崛起:性能接近商业模型的开源替代品将更加普及

2. 可持续API使用战略

对于长期项目,建议采用以下可持续战略:

- 混合模型架构:结合商业API和开源模型,按需分配任务

- 逐步迁移策略:随着项目规模扩大,逐步从免费额度过渡到定制解决方案

- 构建专有微调模型:对于重复性任务,投资开发专用模型可能更经济

- 预算控制机制:实施API使用监控和预警系统,避免意外超支

总结:为您的AI项目选择最佳免费API策略

在快速发展的AI领域,获取免费或低成本的API资源是控制开发成本的关键。通过本文介绍的8种方法,从官方渠道到替代服务,从免费额度到优化策略,您可以为项目找到最合适的解决方案。

适合不同场景的推荐策略:

- 初创项目/个人开发者:使用新用户$5免费额度 + laozhang.ai等中转服务

- 研究项目:申请研究者访问计划 + 开源模型实验

- 教育机构:申请教育计划 + 学生开发者包

- 企业应用:数据分享计划 + 混合模型架构 + 批量优化

无论您选择哪种方式,记住定期评估API使用情况,根据项目需求调整策略,并关注行业动态以把握新的机会。随着技术的发展,获取和使用AI API的方式将继续演变,保持灵活性是成功的关键。

🌟 开始行动:注册laozhang.ai账户,立即获取免费额度,同时考虑参与OpenAI的数据分享计划,最大化您的免费API资源!

更新日志

plaintext┌─ 更新记录 ───────────────────────────┐ │ 2025-05-31:首次发布完整获取指南 │ └─────────────────────────────────────┘