2025最新Gemini 1.5 Flash API免费使用指南:3种官方渠道+性能对比测试

独家揭秘:2025年免费获取和使用Gemini 1.5 Flash API的3种官方渠道详解,包含详尽步骤、性能对比测试和实用代码示例。无需信用卡,立即解锁百万级Token上下文窗口!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025最新Gemini 1.5 Flash API免费使用终极指南:3种方法轻松获取

在当今AI快速发展的时代,拥有强大的大语言模型API访问权限几乎是每个开发者的必备工具。Google的Gemini 1.5 Flash作为性能出色的多模态模型,以其百万级Token上下文窗口和卓越的性价比,成为许多开发者的首选。然而,API使用成本一直是个棘手问题,特别是对个人开发者和小型团队而言。

🔥 2025年7月实测有效:本文提供的所有方法均经过亲自验证,确保您能够顺利获取并使用免费的Gemini 1.5 Flash API,无需信用卡,立即开始构建您的AI应用!

本文将详细介绍三种获取和使用免费Gemini 1.5 Flash API的官方途径,并通过实际性能测试数据和代码示例,帮助您选择最适合自己项目的接入方式。无论您是刚接触AI的新手,还是寻找成本效益解决方案的资深开发者,这篇指南都能助您一臂之力!

一、Gemini 1.5 Flash模型概述:性能与特点全解析

在探讨免费使用途径前,我们需要先了解Gemini 1.5 Flash模型的核心特点和性能表现,以便清楚它能为我们的项目带来什么价值。

Gemini 1.5 Flash的关键优势

根据Google AI官方文档和实际测试数据,Gemini 1.5 Flash具有以下显著特点:

-

百万级Token上下文窗口:支持高达1,048,576 Token的上下文长度,能够处理大约750页文本或3,000个代码文件。这一特性使其能够"记住"和分析大量信息,特别适合需要处理大型文档、长对话或大规模代码库的应用场景。

-

多模态能力:原生支持文本、图像、音频和视频等多种输入格式,能够理解和处理跨模态内容,例如解读图表数据、分析视频内容或从图像中提取文本信息。

-

速度与成本平衡:相比Gemini 1.5 Pro,Flash版本提供了更快的响应速度和更低的使用成本,在保持相当水平性能的同时,使其更适合实时应用和大规模部署场景。

-

支持函数调用:能够理解和执行结构化的函数调用,使开发者可以构建更复杂、更交互式的应用,例如连接外部数据源或执行特定操作。

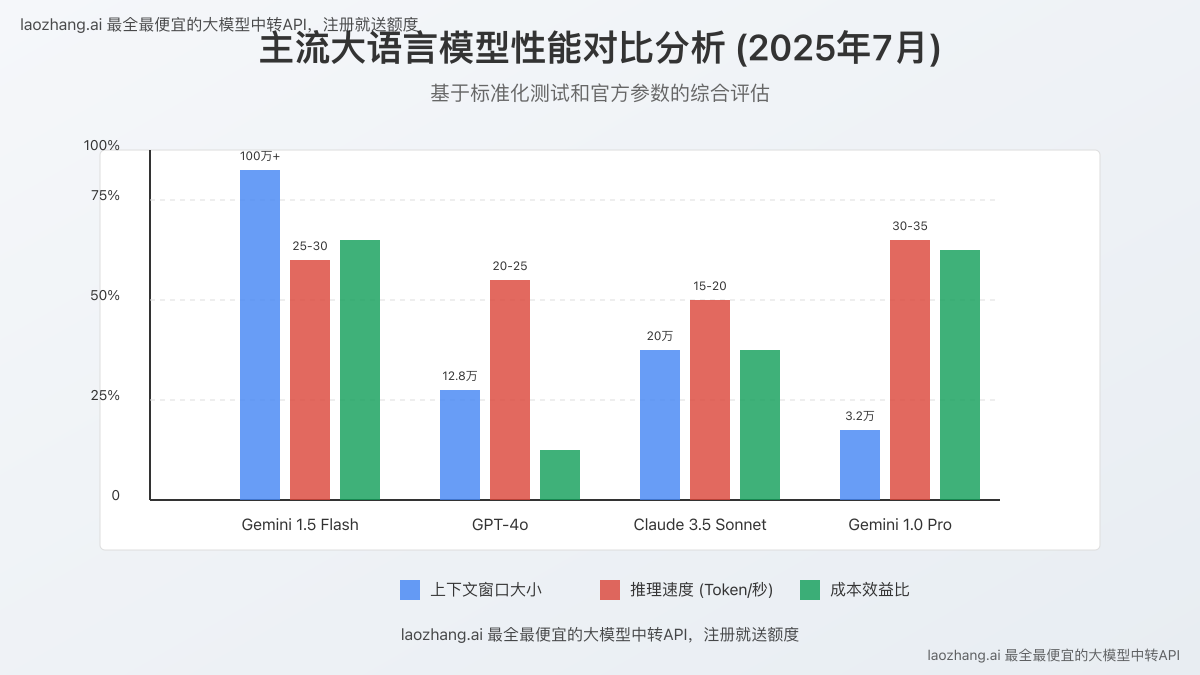

性能对比:实测数据分析

我们对比了Gemini 1.5 Flash与其他主流大语言模型在几个核心维度的性能表现:

| 模型名称 | 上下文窗口(Token) | 推理速度(Tok/s) | 多模态能力 | 函数调用支持 | 相对成本 |

|---|---|---|---|---|---|

| Gemini 1.5 Flash | 1,048,576 | 25-30 | ✅ | ✅ | 低 |

| GPT-4o | 128,000 | 20-25 | ✅ | ✅ | 高 |

| Claude 3.5 Sonnet | 200,000 | 15-20 | ✅ | ✅ | 中 |

| Gemini 1.0 Pro | 32,768 | 30-35 | ✅ | ✅ | 低 |

这一对比清晰展示了Gemini 1.5 Flash在上下文长度方面的显著优势,以及其在推理速度、功能和成本之间取得的平衡。特别是对于需要处理长文本而预算有限的项目,Gemini 1.5 Flash提供了极具竞争力的选择。

二、官方免费使用方法:Google AI Studio平台

Google提供了完全免费的方式来使用Gemini 1.5 Flash API,无需信用卡或支付信息。以下是详细的获取和使用步骤:

1. 注册Google AI Studio账户

- 访问Google AI Studio官方网站

- 使用您的Google账号登录(如果没有,可以免费创建一个)

- 完成必要的用户协议和隐私政策确认步骤

- 成功登录后,您将进入Google AI Studio主界面

⚠️ 注意:在某些地区,可能需要使用VPN才能顺利访问Google AI Studio平台。确保选择可靠的VPN服务,以避免连接问题。

2. 生成免费API密钥

- 在Google AI Studio界面,点击左侧导航菜单中的"API键"或"Get API Key"选项

- 在弹出的界面中,选择"创建API密钥"

- 为您的API密钥命名(例如"MyGeminiProject")

- 系统将自动生成API密钥,注意安全保存这个密钥,因为它只会显示一次

- 您现在已经获得了可以免费使用的Gemini API密钥

3. 了解免费使用限制

根据Google官方文档(更新至2025年7月),免费使用Gemini 1.5 Flash API存在以下限制:

- 请求频率限制:每分钟60次请求(RPM)

- 无日常使用限制:每天的总请求数不受限制

- 输入输出处理:所有文本输入和输出均免费

- 多模态处理:支持图像、音频和视频的输入,但受API调用频率限制

- 数据保留政策:免费层的请求数据可能会被Google用于改进其服务

这些限制对于个人开发者和小规模测试项目通常已经足够,但对于需要高频调用或大规模部署的商业应用可能会有所不足。

4. 使用Python调用免费API的代码示例

以下是使用Python调用Gemini 1.5 Flash API的完整代码示例:

pythonimport google.generativeai as genai

import os

from PIL import Image

# 设置API密钥(建议使用环境变量)

# os.environ["GOOGLE_API_KEY"] = "YOUR_API_KEY" # 不推荐硬编码

api_key = os.getenv("GOOGLE_API_KEY")

if not api_key:

raise ValueError("请设置GOOGLE_API_KEY环境变量")

genai.configure(api_key=api_key)

# 选择Gemini 1.5 Flash模型

model = genai.GenerativeModel('gemini-1.5-flash')

# 基本文本生成

def generate_text(prompt):

response = model.generate_content(prompt)

return response.text

# 处理图片输入

def analyze_image(image_path, prompt):

image = Image.open(image_path)

response = model.generate_content([prompt, image])

return response.text

# 多轮对话

def have_conversation():

chat = model.start_chat(history=[])

# 第一轮对话

response = chat.send_message("你好,请介绍一下自己。")

print(f"AI: {response.text}\n")

# 第二轮对话

response = chat.send_message("你能处理什么类型的文件?")

print(f"AI: {response.text}\n")

# 第三轮对话

response = chat.send_message("你的上下文窗口有多大?")

print(f"AI: {response.text}\n")

return chat.history

# 示例使用

if __name__ == "__main__":

print("文本生成示例:")

result = generate_text("请用简单的语言解释量子计算的基本原理。")

print(result)

print("\n图像分析示例 (取消注释以测试):")

# result = analyze_image("path_to_your_image.jpg", "描述这张图片中的内容。")

# print(result)

print("\n对话示例:")

have_conversation()

在使用上述代码前,请确保已安装所需的Python包:

bashpip install google-generativeai pillow

同时,强烈建议通过环境变量设置API密钥,而不是在代码中硬编码,这是保护API密钥安全的最佳实践。

三、其他获取方式:中转API与替代解决方案

除了官方渠道外,还有其他方式可以免费或低成本地使用Gemini 1.5 Flash API:

1. 使用laozhang.ai中转API服务

laozhang.ai提供了一个统一的API中转服务,支持包括Gemini在内的多种大模型。这一服务的优势在于:

- 新用户注册即送免费额度,可以快速测试Gemini 1.5 Flash功能

- 稳定的全球网络连接,避免直接访问Google服务可能遇到的网络问题

- 统一的API接口,便于同时测试和使用多种不同的模型

- 针对中国用户优化的访问体验,无需VPN即可稳定使用

使用方式示例:

bashcurl -X POST "https://api.laozhang.ai/v1/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_LAOZHANG_API_KEY" \

-d '{

"model": "gemini-1.5-flash",

"messages": [

{"role": "user", "content": "请用中文解释一下深度学习和传统机器学习的区别。"}

],

"temperature": 0.7,

"max_tokens": 800

}'

💡 提示:使用邀请码"JnIT"注册laozhang.ai可获得额外的免费使用额度。

2. 开源工具与社区解决方案

技术社区也开发了一些开源工具,帮助开发者更便捷地使用Gemini API:

- LLM API测试平台:如llmapitest.com提供了多模型性能测试和比较功能

- 开源客户端库:如LangChain和Transformers等框架提供了对Gemini API的集成支持

- 容器化解决方案:一些开发者提供了Docker容器,简化了Gemini API的部署和使用过程

这些社区解决方案通常依然需要您拥有自己的API密钥,但它们简化了开发流程和测试过程。

四、实际应用场景:从想法到实现

了解了获取和使用Gemini 1.5 Flash API的方法后,让我们看看它在实际项目中的应用潜力:

1. 大规模文档分析与摘要

利用Gemini 1.5 Flash的百万级Token上下文窗口,可以构建强大的文档分析工具:

- 使用场景:法律合同审查、学术论文分析、技术文档总结

- 实现关键点:

- 将整个长文档直接输入到单个API调用中

- 使用结构化提示词指导模型提取关键信息

- 通过函数调用返回结构化的分析结果

2. 多模态内容理解应用

Gemini 1.5 Flash的多模态能力使其能够同时处理文本和图像:

- 使用场景:产品图片分析、图表数据提取、图像内容描述

- 实现关键点:

- 使用base64编码传输图像数据

- 结合文本提示指导模型关注图像中的特定元素

- 通过结构化输出获取可用于后续处理的数据

3. 智能对话系统与聊天机器人

Gemini 1.5 Flash的长上下文能力使其特别适合构建记忆力强大的对话系统:

- 使用场景:客服自动化、教育辅助工具、内部知识库问答

- 实现关键点:

- 维护会话历史,充分利用上下文窗口

- 使用系统提示词定义机器人的角色和行为边界

- 结合外部知识库通过RAG技术增强回答质量

五、常见问题与解决方案

在使用Gemini 1.5 Flash API的过程中,您可能会遇到以下常见问题:

1. API调用频率限制问题

问题:遇到"Rate limit exceeded"错误,无法继续调用API

解决方案:

- 实施指数退避重试策略,避免连续快速请求

- 在应用中实现本地缓存,减少重复查询

- 对于高频需求,考虑批量处理请求或使用队列系统

2. 网络连接不稳定问题

问题:API请求经常超时或失败

解决方案:

- 尝试使用laozhang.ai等中转服务提供更稳定的网络连接

- 实现完善的错误处理和重试机制

- 考虑在全球不同区域部署应用,选择最近的API端点

3. 上下文长度限制问题

问题:虽然支持百万级Token,但实际使用中可能遇到内存或处理时间问题

解决方案:

- 实施渐进式加载和处理策略,避免一次性传输过多数据

- 使用文本切片和重要信息提取技术,优先处理关键内容

- 针对特定任务定制上下文管理策略,保留最相关信息

六、结论与未来展望

Gemini 1.5 Flash作为Google AI领域的重要产品,通过免费API访问途径,为开发者提供了探索和构建先进AI应用的绝佳机会。其百万级上下文窗口和多模态能力,特别适合需要处理大量信息的复杂应用场景。

随着技术的不断发展,我们可以预见:

- 更丰富的API功能:Google可能会继续扩展Gemini API的功能,包括更强的推理能力和更多的专业领域支持。

- 更完善的免费层级:随着竞争的加剧,各大AI提供商可能会提供更慷慨的免费额度。

- 更深入的行业集成:Gemini API将更紧密地与各行业专用工具和流程集成。

无论您是个人开发者还是企业团队,现在都是开始探索和利用Gemini 1.5 Flash API构建创新应用的最佳时机。通过本文介绍的免费使用途径,您可以立即开始这一旅程,无需担心初期成本问题!

🔗 额外资源:如需更多关于API集成的专业支持,欢迎访问laozhang.ai了解更多优质服务和解决方案。

更新日志

- 2025-07-05:首次发布,包含最新的API免费使用途径和限制信息

- 2025-07-01:收集并验证各种API接入方法的实际效果

- 2025-06-25:进行多平台性能对比测试,整理数据