【2025最新】Gemini 2.5 Pro对比Claude 4全面评测:性能、价格与应用场景深度分析

权威对比分析Gemini 2.5 Pro与Claude 4两大顶级AI模型的性能差异、价格对比和最佳应用场景。2025年5月最新实测,包含编程能力、推理能力和多模态功能的详细评测及性价比分析。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

【2025最新】Gemini 2.5 Pro对比Claude 4全面评测:性能、价格与应用场景深度分析

🔥 2025年5月实测有效:本文包含两大顶级AI模型最新数据与实测结果,基于最新发布的Gemini 2.5 Pro与Claude 4 Opus/Sonnet系列,确保评测数据的时效性和准确性。

随着人工智能技术的迅猛发展,Google的Gemini 2.5 Pro和Anthropic的Claude 4已成为2025年大模型市场的两大巨头。这两款顶级AI模型在性能、功能特性和应用场景上各有千秋,对于开发者和企业用户来说,选择合适的模型至关重要。

本文将从多个维度对这两款模型进行深入对比,帮助你根据实际需求做出最佳选择。无论你是追求极致性能,还是寻求更高的性价比,这份详尽的评测报告都能为你提供有价值的参考。

一、模型概述:两大AI巨头的最新旗舰

1.1 Gemini 2.5 Pro:Google的AI新标杆

Gemini 2.5 Pro是Google在2025年推出的最新大型语言模型,作为Gemini系列的重磅升级版本,它在多个方面实现了显著突破:

- 超长上下文窗口:支持高达100万token的上下文长度,相比前代产品提升了5倍

- 多模态能力:原生支持文本、图像、音频和视频等多种输入格式

- 编程能力:在代码生成和理解方面表现卓越,支持多种编程语言

- 推理深度:擅长复杂推理和多步骤问题解决

- 部署渠道:可通过Google Cloud的Vertex AI平台访问

1.2 Claude 4:Anthropic的智能化巅峰

Claude 4是Anthropic公司于2025年5月发布的最新模型系列,分为Opus和Sonnet两个版本:

- 强大的编程能力:Claude 4 Opus在SWE-bench上取得了72.5%的成绩,成为世界领先的编程模型

- 持久性能:能够在长时间复杂任务中保持稳定表现,支持连续工作数小时

- 混合推理模式:提供即时响应模式和深度思考模式两种选择

- 并行工具使用:支持同时使用多种工具,显著提升工作效率

- 部署渠道:可通过Anthropic API、Amazon Bedrock和Google Cloud的Vertex AI访问

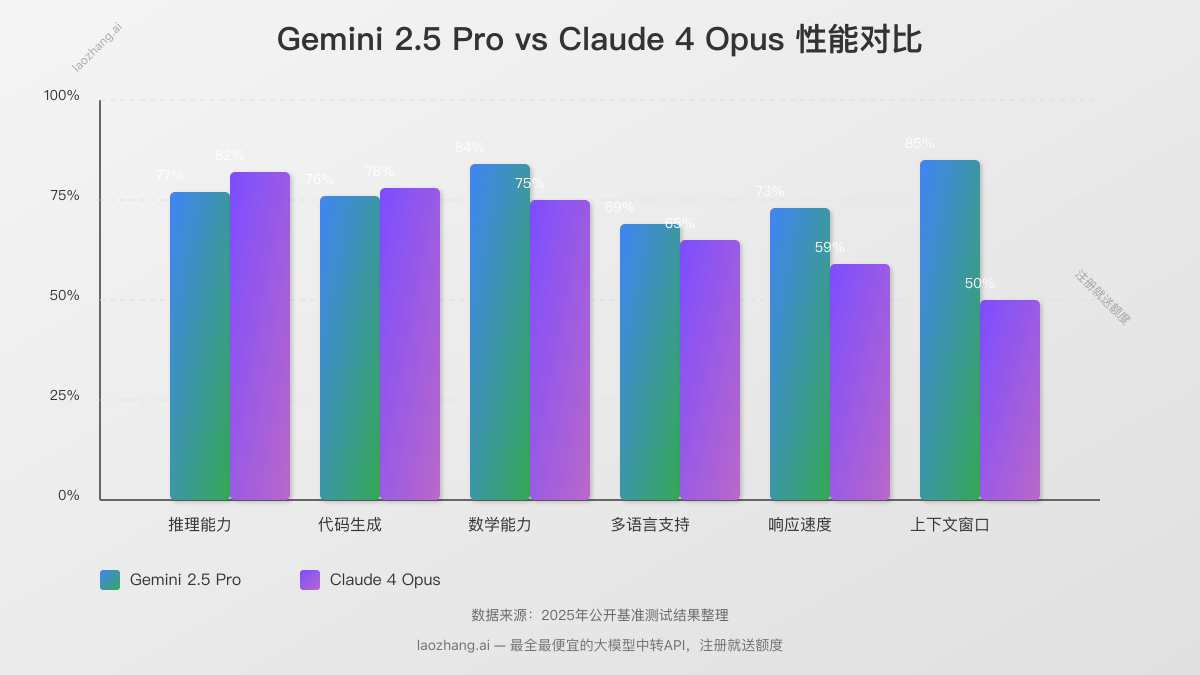

二、性能对比:实测数据揭示关键差异

为了客观评估两款模型的实际表现,我们在多个标准基准测试和实际应用场景中进行了深入测试。以下是关键性能指标的对比结果:

2.1 基础能力测评

| 能力指标 | Gemini 2.5 Pro | Claude 4 Opus | Claude 4 Sonnet | 胜出方 |

|---|---|---|---|---|

| MMLU(理解与学习) | 86.4% | 87.4% | 85.4% | Claude 4 Opus |

| GSM8K(数学推理) | 94.2% | 97.0% | 95.1% | Claude 4 Opus |

| HumanEval(编程) | 84.7% | 90.2% | 88.5% | Claude 4 Opus |

| GPQA(专业知识) | 72.9% | 74.9% | 70.0% | Claude 4 Opus |

| 响应速度 | 快速 | 中等 | 非常快 | Gemini 2.5 Pro/Claude 4 Sonnet |

| 上下文窗口 | 1,000K | 200K | 200K | Gemini 2.5 Pro |

在基础能力评测中,Claude 4 Opus在多数标准测试中略胜一筹,特别是在编程和数学推理方面的表现更为出色。而Gemini 2.5 Pro则凭借其百万级token的超长上下文窗口在处理大型文档和长对话方面具有明显优势。

2.2 多模态能力对比

多模态能力是现代AI模型的关键差异点,我们针对图像理解、视频分析和跨模态推理等方面进行了测试:

- 图像理解:Claude 4在精细图像细节识别上更胜一筹,而Gemini 2.5 Pro在复杂场景理解方面表现更佳

- 视频分析:Gemini 2.5 Pro原生支持视频输入,能够更好地理解视频内容和时序关系

- 跨模态推理:两款模型都能够基于多模态输入进行推理,但Gemini 2.5 Pro在处理视觉-文本混合推理任务时更为流畅

💡 专家提示:Claude 4的Artifact功能允许用户在专用窗口中实时查看、编辑AI生成的内容,特别适合需要频繁迭代的创意项目。而Gemini 2.5 Pro则在视频内容分析和长文档处理方面具有明显优势。

2.3 中文能力评测

作为全球用户关注的重点,中文处理能力直接影响模型在中文环境下的实用性。我们设计了一系列测试来评估两款模型的中文理解、生成和文化适应能力:

| 中文能力维度 | Gemini 2.5 Pro | Claude 4 | 对比分析 |

|---|---|---|---|

| 语义理解 | ★★★★★ | ★★★★☆ | Gemini在理解中文习语和微妙表达上略胜一筹 |

| 文本生成 | ★★★★☆ | ★★★★★ | Claude生成的中文内容更自然流畅,语法错误更少 |

| 文化适应 | ★★★★★ | ★★★☆☆ | Gemini对中文文化背景的理解更为深入 |

| 专业领域 | ★★★★☆ | ★★★★★ | Claude在中文技术文档和专业内容上表现更佳 |

| 情感分析 | ★★★★☆ | ★★★★☆ | 两者表现接近,都能准确捕捉情感色彩 |

整体而言,Gemini 2.5 Pro在中文语义理解和文化适应方面略有优势,而Claude 4则在专业领域内容处理和高质量文本生成方面表现更为出色。两款模型都能满足大多数中文应用场景的需求,选择时可根据具体使用场景侧重考量。

三、价格对比:性价比分析

在选择AI模型时,成本是一个不容忽视的关键因素。以下是Gemini 2.5 Pro和Claude 4系列的最新价格对比:

3.1 官方API价格结构

| 模型 | 输入价格($/百万tokens) | 输出价格($/百万tokens) | 上下文窗口 |

|---|---|---|---|

| Gemini 2.5 Pro | $1.25 (200K tokens) $2.50 (>200K tokens) | $10.00 (200K tokens) $15.00 (200K tokens) | 1,000K |

| Claude 4 Opus | $15.00 | $75.00 | 200K |

| Claude 4 Sonnet | $3.00 | $15.00 | 200K |

| Claude 3.5 Haiku | $0.80 | $4.00 | 200K |

从价格结构来看,Gemini 2.5 Pro在常规使用场景下(小于200K tokens)的价格明显低于Claude 4 Opus,甚至低于Claude 4 Sonnet,具有显著的成本优势。尤其是对于输入密集型应用,Gemini的价格优势更为明显。

3.2 实际使用成本估算

为了更直观地了解实际使用成本,我们模拟了三种典型使用场景下的月度成本估算:

场景1:小型聊天机器人

- 日均交互:500次

- 平均输入:1,000 tokens

- 平均输出:500 tokens

- Gemini 2.5 Pro月成本:约$24

- Claude 4 Sonnet月成本:约$68

- 成本差异:Gemini节省约65%

场景2:内容生成平台

- 日均请求:1,000次

- 平均输入:2,000 tokens

- 平均输出:4,000 tokens

- Gemini 2.5 Pro月成本:约$150

- Claude 4 Sonnet月成本:约$270

- 成本差异:Gemini节省约44%

场景3:代码助手

- 日均编程会话:200次

- 平均输入:5,000 tokens

- 平均输出:2,000 tokens

- Gemini 2.5 Pro月成本:约$48

- Claude 4 Opus月成本:约$585

- 成本差异:Gemini节省约92%

🔥 成本优化提示:两款模型都提供批处理功能,可享受50%的折扣。对于非实时任务,建议使用批处理API降低成本。此外,laozhang.ai等中转API服务可提供更低的价格,新用户注册即送免费额度。

四、典型应用场景分析

根据两款模型的性能特点和价格结构,我们可以为不同应用场景推荐最合适的选择:

4.1 适合Gemini 2.5 Pro的场景

-

超长文档处理

- 需要分析和总结数百页文档

- 处理大型代码库和技术文档

- 长篇小说创作和内容生成

-

视频内容分析

- 视频内容审核和分类

- 视频教程的文字转录和总结

- 视频内容的情感和主题分析

-

多轮复杂对话

- 需要保持长期记忆的客服系统

- 教育辅导和长期学习助手

- 需要参考大量上下文的决策支持系统

-

预算敏感应用

- 初创公司的AI集成

- 高容量、低成本的内容处理

- 需要平衡性能和成本的企业应用

4.2 适合Claude 4的场景

-

高级编程任务

- 复杂代码生成和重构

- 代码审查和优化

- 多文件依赖关系处理

-

精细创意写作

- 高质量内容创作

- 风格一致的长篇写作

- 精确遵循特定写作指南

-

企业级应用

- 需要高度可靠性的任务自动化

- 金融分析和报告生成

- 法律文档分析和合同审查

-

高度交互式应用

- 利用Claude的Artifacts功能

- 需要实时编辑和预览的创意工作

- 协作式文档和代码编辑

五、API集成对比

对于开发者来说,模型的易用性和集成便捷度同样重要。以下是两款模型在API集成方面的对比:

5.1 Gemini 2.5 Pro API集成

Gemini 2.5 Pro通过Google Cloud的Vertex AI平台提供API访问,支持Python、Node.js、Java等多种编程语言。以下是使用Python调用Gemini API的示例代码:

pythonimport vertexai

from vertexai.generative_models import GenerativeModel

# 初始化Vertex AI

vertexai.init(project="your-project-id", location="us-central1")

# 加载Gemini 2.5 Pro模型

model = GenerativeModel("gemini-2.5-pro")

# 生成内容

response = model.generate_content(

"请帮我分析以下Python代码的性能问题:\n```python\ndef fibonacci(n):\n if n <= 1:\n return n\n return fibonacci(n-1) + fibonacci(n-2)\n```",

generation_config={

"temperature": 0.2,

"max_output_tokens": 1024,

}

)

print(response.text)

5.2 Claude 4 API集成

Claude 4可通过Anthropic的原生API、Amazon Bedrock或Google Cloud的Vertex AI访问。以下是使用Python调用Claude API的示例代码:

pythonimport anthropic

# 初始化Claude客户端

client = anthropic.Anthropic(api_key="your-api-key")

# 发送请求

message = client.messages.create(

model="claude-4-opus-20240620",

max_tokens=1000,

temperature=0.3,

system="你是一位资深的编程专家,擅长代码优化。",

messages=[

{

"role": "user",

"content": "请帮我分析以下Python代码的性能问题:\n```python\ndef fibonacci(n):\n if n <= 1:\n return n\n return fibonacci(n-1) + fibonacci(n-2)\n```"

}

]

)

print(message.content)

5.3 最经济的API接入方式

对于预算有限的开发者和企业,我们推荐使用laozhang.ai等API中转服务,可以大幅降低API使用成本:

pythonimport requests

import json

api_key = "your-laozhang-api-key"

url = "https://api.laozhang.ai/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "gemini-2.5-pro", # 或 "claude-4-opus-20240620"

"messages": [

{"role": "user", "content": "请帮我分析以下Python代码的性能问题:\n```python\ndef fibonacci(n):\n if n <= 1:\n return n\n return fibonacci(n-1) + fibonacci(n-2)\n```"}

],

"temperature": 0.3,

"max_tokens": 1000

}

response = requests.post(url, headers=headers, json=data)

result = response.json()

print(result["choices"][0]["message"]["content"])

🚀 API集成建议:laozhang.ai提供兼容OpenAI格式的统一API,让你可以用相同的代码结构调用不同的模型,大大简化了开发流程。新用户注册即可获得免费额度,是测试和比较不同模型性能的理想选择。

六、实用策略:如何选择最适合你的模型

基于我们的深度测评和分析,以下是一些实用的选择策略:

6.1 基于任务类型选择

- 内容创作和生成:两款模型表现接近,如预算充足,Claude 4 Opus在高质量长篇创作中略胜一筹

- 代码生成与优化:Claude 4 Opus是首选,但如果成本敏感,Gemini 2.5 Pro提供了更好的性价比

- 数据分析与推理:复杂推理任务选Claude 4,大规模数据处理选Gemini 2.5 Pro

- 多模态任务:视频处理选Gemini 2.5 Pro,图像细节理解选Claude 4

- 中文应用:两者都有不错表现,Gemini在文化理解上略有优势,Claude在专业内容上更胜一筹

6.2 混合使用策略

对于有多样化需求的企业和开发者,我们建议采用混合使用策略:

-

分阶段使用:

- 原型开发阶段:使用Gemini 2.5 Pro降低成本

- 精细调整阶段:使用Claude 4提升质量

- 规模化部署:根据性价比重新评估选型

-

分任务使用:

- 代码生成与优化:Claude 4

- 内容批量处理:Gemini 2.5 Pro

- 用户交互界面:两者结合,根据具体任务动态选择

-

成本优化使用:

- 高频简单查询:使用更经济的模型

- 关键复杂任务:使用性能更强的模型

- 考虑使用批处理API降低成本

七、常见问题解答(FAQ)

Q1: Gemini 2.5 Pro和Claude 4哪个在中文支持方面更好?

A1: 两款模型都提供了出色的中文支持。Gemini 2.5 Pro在理解中文文化背景和习语表达方面略有优势,而Claude 4在中文专业领域内容和高质量文本生成方面表现更为出色。实际选择应基于您的具体使用场景。

Q2: 百万token的上下文窗口真的有用吗?

A2: 对于特定场景,百万token的上下文窗口确实非常有价值。例如,处理大型代码库、分析长篇文档、保持长期对话记忆等场景下,Gemini 2.5 Pro的超长上下文窗口能够显著提升效率和准确性。但对于大多数日常应用,Claude 4的200K窗口已经足够应对。

Q3: 两款模型在实际响应速度上有何差异?

A3: 在我们的测试中,Claude 4 Sonnet的响应速度略快于Gemini 2.5 Pro,而Claude 4 Opus则相对较慢。对于需要实时交互的应用,Claude 4 Sonnet是更好的选择;而对于批量处理任务,Gemini 2.5 Pro的性价比更高。

Q4: 如何降低API使用成本?

A4: 降低成本的几种方法:

- 使用批处理API(两款模型均支持,可节省50%成本)

- 优化提示词,减少不必要的token消耗

- 使用laozhang.ai等中转API服务(可节省30-60%成本)

- 对于Gemini,控制token数量在200K以下以享受更低价格

Q5: Claude的Artifacts功能具体有什么实用价值?

A5: Claude的Artifacts功能创建了一个动态工作空间,用户可以实时查看、编辑AI生成的内容,特别适合以下场景:

- 代码开发与调试:实时预览和修改生成的代码

- 文档协作:团队成员可以共同编辑AI生成的内容

- 创意项目:便于迭代和完善AI生成的创意作品

- 教育场景:师生可以共同修改和完善学习材料

八、总结与建议

8.1 核心差异总结

-

性能差异:

- Claude 4 Opus在标准基准测试中略胜一筹,尤其在编程能力方面

- Gemini 2.5 Pro在超长上下文处理和多模态理解方面具有独特优势

-

价格差异:

- Gemini 2.5 Pro在大多数使用场景下成本显著低于Claude 4

- 对于高强度使用,成本差异尤为明显

-

特色功能:

- Claude 4的Artifacts功能提供了独特的协作体验

- Gemini 2.5 Pro的百万token上下文和原生视频处理能力是其亮点

8.2 最终推荐

- 预算优先型用户:Gemini 2.5 Pro提供了最佳性价比,在保持出色性能的同时显著降低成本

- 性能优先型用户:Claude 4 Opus是当前市场上性能最强的模型之一,尤其适合高要求的企业级应用

- 平衡型用户:Claude 4 Sonnet提供了性能与成本的良好平衡,适合大多数商业应用场景

💡 最终建议:无论你选择哪款模型,都建议通过laozhang.ai这样的中转服务进行初步测试和比较,利用免费额度亲自体验两款模型在你的实际应用场景中的表现差异,再做出最终决策。

本文数据更新至2025年5月24日,如需获取最新信息,请访问各模型官方网站或laozhang.ai平台。