【2025实测】国内使用Gemini API完全指南:免代理直连方案

最新实测有效的国内使用Gemini API方案,包括Cloudflare反向代理、API中转服务和Docker部署三种方法,推荐使用LaoZhang.ai中转API获得最稳定的体验和价格优势。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

【2025实测】国内使用Gemini API完全指南:免代理直连方案

{/* 封面图片 */}

🔥 2025年5月实测有效:本文提供三种国内访问Gemini API的可靠方案,从免费的Cloudflare Workers方法到稳定的API中转服务,均已验证可用。推荐使用LaoZhang.ai中转服务获得最佳性价比,注册即送免费体验额度!

引言:为什么国内无法直接使用Gemini API

Google的Gemini系列模型凭借其强大的多模态能力和出色的代码生成能力,已成为全球领先的大语言模型之一。然而,由于众所周知的原因,中国大陆用户面临两个主要障碍:

- 地区限制:Gemini API仅对特定区域开放,中国大陆不在支持地区列表中

- 网络访问问题:即使有API密钥,也无法直接连接到Google的API终端点

本文提供了2025年最新经过验证的三种解决方案,让国内开发者和企业能够顺畅使用Gemini API的强大功能,而无需考虑繁琐的网络问题。

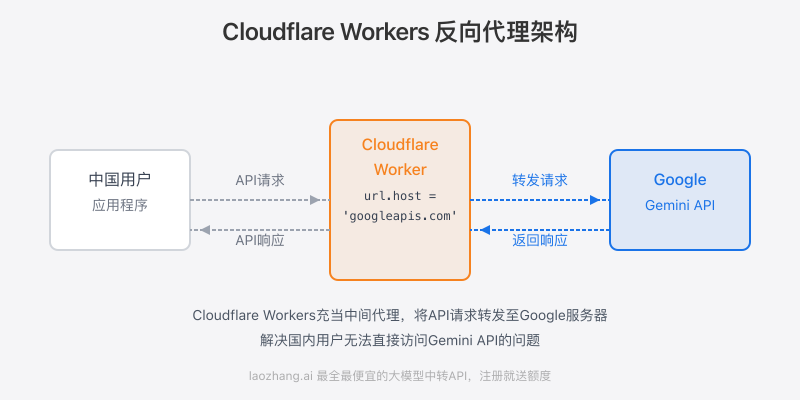

方案一:使用Cloudflare Workers搭建反向代理(免费方案)

这是一种完全免费的解决方案,适合个人开发者和小型项目使用。通过Cloudflare Workers的边缘计算能力,我们可以创建一个反向代理,绕过地区限制。

前置条件

- 一个Cloudflare账号

- 一个已经添加到Cloudflare的域名(可以是免费的二级域名)

- 有效的Gemini API密钥(需要通过非中国大陆IP申请)

步骤1:申请Gemini API密钥

首先,你需要使用非中国大陆IP访问Google AI Studio网站申请API密钥:

- 访问Google AI Studio

- 登录你的Google账号

- 导航到API密钥页面

- 创建一个新的API密钥

- 保存密钥信息(请妥善保管,密钥仅显示一次)

步骤2:创建Cloudflare Worker

- 登录你的Cloudflare账号,进入Dashboard

- 在左侧导航栏选择"Workers & Pages"

- 点击"创建应用程序"

- 选择"创建Worker"

- 为你的Worker命名(例如"gemini-proxy")

- 点击"部署"按钮

- 部署完成后,点击"编辑代码"

步骤3:配置Worker代码

删除Worker编辑器中的默认代码,粘贴以下代码:

javascriptexport default {

async fetch(request, env) {

const url = new URL(request.url);

url.host = 'generativelanguage.googleapis.com';

return fetch(new Request(url, request));

}

}

这段代码的作用是将所有请求转发到Google的Gemini API端点,同时保留原始请求的所有头信息和正文内容。

点击右上角的"保存并部署"按钮完成配置。

步骤4:添加自定义域

由于Cloudflare Workers的默认域名(*.workers.dev)在中国大陆可能无法访问,我们需要为Worker添加一个自定义域名:

- 在Worker详情页面,切换到"触发器"选项卡

- 点击"添加自定义域"按钮

- 输入你想要使用的域名(必须是已添加到Cloudflare的域名,例如

api.yourdomain.com) - 点击"添加"按钮

完成后,你可以通过https://你的自定义域名/v1/models/gemini-pro:generateContent来访问Gemini API。

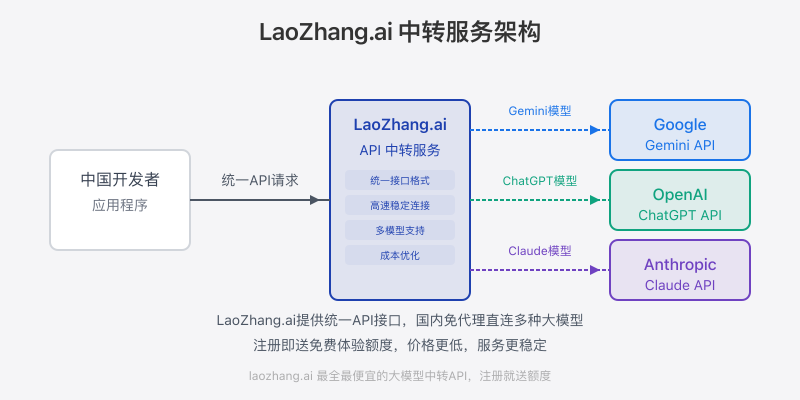

方案二:使用LaoZhang.ai API中转服务(推荐方案)

虽然Cloudflare Worker方案免费且易于部署,但它有一些限制:

- 每天有10万次请求的限制

- 可能存在延迟和不稳定性

- 需要自行维护和监控

- 缺乏专业的技术支持

为了获得更稳定、更专业的体验,强烈推荐使用LaoZhang.ai提供的API中转服务。

为什么选择LaoZhang.ai中转服务

- 最全模型支持 - 不仅支持Gemini全系列模型,还支持Claude、ChatGPT等多种大模型

- 最低价格保证 - 比原生API成本更低,提供最具竞争力的价格

- 国内直连 - 专为中国用户优化的网络架构,稳定可靠

- 免费试用 - 注册即送体验额度,无需信用卡

- 专业技术支持 - 提供7×24小时技术支持

- 标准化接口 - 兼容OpenAI接口格式,迁移成本极低

注册并获取API密钥

- 访问LaoZhang.ai注册账号

- 完成邮箱验证

- 登录账号并导航至API密钥页面

- 创建一个新的API密钥

- 复制并保存API密钥

使用示例

LaoZhang.ai的API接口与OpenAI完全兼容,只需将API地址修改为LaoZhang.ai的地址,并在模型参数中指定Gemini模型即可。

cURL示例

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 你的API密钥" \

-d '{

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": "你好,给我介绍一下中国的长城。"}

]

}'

Python示例

pythonimport requests

API_KEY = "你的API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

def chat_with_gemini(prompt):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": prompt}

]

}

response = requests.post(API_URL, headers=headers, json=data)

return response.json()["choices"][0]["message"]["content"]

# 使用示例

result = chat_with_gemini("请给我推荐五本科幻小说及其简介。")

print(result)

JavaScript/Node.js示例

javascriptasync function chatWithGemini(prompt) {

const response = await fetch('https://api.laozhang.ai/v1/chat/completions', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': `Bearer ${API_KEY}`

},

body: JSON.stringify({

model: 'gemini-pro',

messages: [

{role: 'system', content: '你是一位有用的AI助手。'},

{role: 'user', content: prompt}

]

})

});

const data = await response.json();

return data.choices[0].message.content;

}

// 使用示例

chatWithGemini('请分析中国经济在2025年的发展趋势。')

.then(result => console.log(result))

.catch(error => console.error('Error:', error));

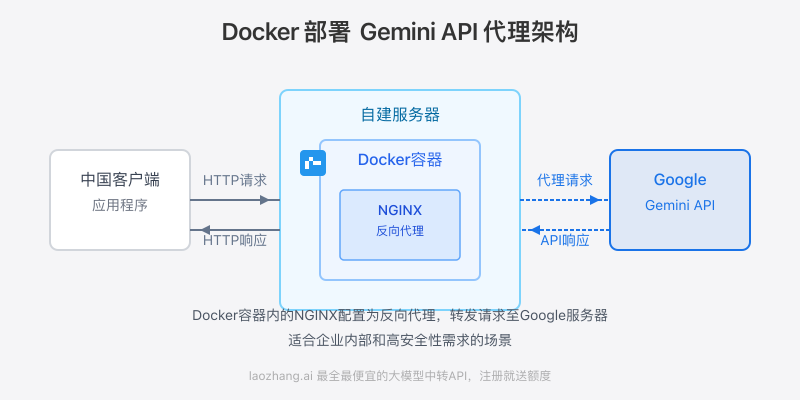

方案三:使用Docker部署自建API代理

对于企业用户或需要完全控制的开发者,可以考虑使用Docker自建API代理服务。这种方法提供了最大的灵活性和安全性,适合在私有网络中部署。

前置条件

- 一台可以访问外网的服务器(国内或国外)

- 已安装Docker和Docker Compose

- 有效的Gemini API密钥

步骤1:创建Docker配置文件

创建一个新的目录,并在其中创建以下文件:

docker-compose.yml:

yamlversion: '3'

services:

gemini-proxy:

image: nginx:alpine

container_name: gemini-proxy

ports:

- "8080:80"

volumes:

- ./nginx.conf:/etc/nginx/nginx.conf

restart: always

nginx.conf:

nginxevents { worker_connections 1024; } http { server { listen 80; location / { proxy_pass https://generativelanguage.googleapis.com/; proxy_ssl_server_name on; proxy_set_header Host generativelanguage.googleapis.com; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; proxy_connect_timeout 10s; proxy_read_timeout 60s; proxy_send_timeout 60s; proxy_buffering off; } } }

步骤2:启动Docker容器

在创建的目录中执行以下命令启动代理服务:

bashdocker-compose up -d

步骤3:测试代理服务

使用curl测试代理服务是否正常工作:

bashcurl http://localhost:8080/v1/models/gemini-pro:generateContent \

-H "Content-Type: application/json" \

-d '{

"contents": [

{

"parts": [

{"text": "Hello, Gemini!"}

]

}

],

"key": "你的API密钥"

}'

如果返回正常的JSON响应,说明代理服务已成功部署。

各方案对比与选择建议

| 方案 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| Cloudflare Workers | 免费、部署简单、无需服务器 | 每日请求限制、不稳定性、需自行维护 | 个人开发者、测试项目、低频使用 |

| LaoZhang.ai API中转 | 稳定可靠、多模型支持、价格优势、专业支持 | 有一定成本(虽然很低) | 生产环境、企业应用、稳定性要求高的场景 |

| Docker自建代理 | 完全控制、私有部署、无第三方依赖 | 需要服务器、配置复杂、维护成本高 | 企业内网、高安全要求、特殊定制需求 |

选择建议

- 初学者或预算有限:从Cloudflare Workers方案开始,零成本体验

- 开发者或中小企业:推荐使用LaoZhang.ai中转服务,平衡成本和稳定性

- 大型企业或特殊场景:考虑Docker自建方案或LaoZhang.ai的企业级解决方案

实际应用案例:构建中文知识问答系统

下面通过一个实际案例,展示如何使用Gemini API(通过LaoZhang.ai中转)构建一个中文知识问答系统。

步骤1:准备工作

安装必要的库:

bashpip install requests streamlit

步骤2:创建问答系统核心代码

创建app.py文件:

pythonimport streamlit as st

import requests

import json

# 配置API信息

API_KEY = "你的LaoZhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

# 设置页面

st.set_page_config(page_title="中文知识问答系统", page_icon="🧠")

st.title("基于Gemini的中文知识问答系统")

# 初始化聊天历史

if "messages" not in st.session_state:

st.session_state.messages = []

# 显示聊天历史

for message in st.session_state.messages:

with st.chat_message(message["role"]):

st.markdown(message["content"])

# 用户输入

if prompt := st.chat_input("请输入您的问题"):

# 添加用户消息到历史

st.session_state.messages.append({"role": "user", "content": prompt})

with st.chat_message("user"):

st.markdown(prompt)

# 调用API

with st.chat_message("assistant"):

with st.spinner("思考中..."):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一个专注于提供准确信息的中文知识助手。回答要详细、准确,并尽可能提供相关背景信息。"},

*st.session_state.messages

]

}

response = requests.post(API_URL, headers=headers, json=data)

result = response.json()["choices"][0]["message"]["content"]

# 显示回复

st.markdown(result)

# 添加助手回复到历史

st.session_state.messages.append({"role": "assistant", "content": result})

步骤3:运行应用

bashstreamlit run app.py

通过这个简单的应用,用户可以用中文向Gemini模型提问并获得详细回答,完全不受地区限制的影响。

常见问题与解答

Gemini API在中国大陆是否合法使用?

提供生成式AI服务在中国需要遵守《生成式人工智能服务管理暂行办法》。使用Gemini API进行开发测试是可以的,但如果要面向中国用户提供基于该API的服务,建议咨询法律专业人士,确保合规。

为什么推荐LaoZhang.ai而不是直接使用Cloudflare Workers?

Cloudflare Workers虽然免费,但存在请求限制、稳定性问题和维护成本。LaoZhang.ai提供专业的中转服务,解决了这些问题,同时提供更低的价格和更好的用户体验。对于任何正式项目,稳定性和可靠性都是首要考虑因素。

Gemini API有哪些模型可以使用?

通过LaoZhang.ai,你可以访问Gemini的所有模型,包括:

- gemini-pro:适用于文本生成任务

- gemini-pro-vision:支持图像理解的多模态模型

- gemini-1.5-pro:最新的综合能力更强的模型

- gemini-1.5-flash:性能与价格平衡的模型

如何处理API请求失败或超时问题?

在生产环境中使用API时,应当实现以下机制:

- 错误重试机制

- 超时控制

- 备用服务

- 请求限流

- 监控告警

LaoZhang.ai的API中转服务在设计时考虑了这些问题,提供了更高的可靠性和稳定性。

总结与展望

随着AI技术的快速发展,获取和使用全球领先的模型能力变得越来越重要。本文介绍的三种方案为中国开发者和企业提供了可行的Gemini API使用途径,从免费的Cloudflare Workers方案到专业的LaoZhang.ai中转服务,再到自建Docker代理,可以根据不同需求选择最适合的解决方案。

特别推荐LaoZhang.ai的API中转服务,它提供了最佳的性价比和用户体验,是大多数用户的理想选择。立即注册,获取免费体验额度,开启AI开发之旅!

未来,随着国际合作的深入和技术的进步,我们有理由相信,AI技术的全球共享将变得更加便捷,为人类创造更多价值。

参考资料

注:本文内容仅供技术交流和学习使用,使用第三方服务时请遵守相关服务条款和法律法规。