GPT-O3 API 价格全解析 2025:详细对比、成本计算与最佳实践

2025年最新GPT-O3 API价格全面分析,包含与DeepSeek、Claude等模型的详细对比,提供成本优化策略和laozhang.ai中转API的超值方案。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

GPT-O3 API 价格全解析 2025:详细对比、成本计算与最佳实践

🔥 2025年4月实测有效:本文包含OpenAI最新O3 API价格数据(截至2025年4月15日),结合实际业务场景提供详细成本分析和优化策略。

OpenAI的O3模型系列凭借卓越的推理能力,特别是在STEM领域、代码生成和复杂问题解决方面,彻底改变了AI应用的可能性边界。然而,这些先进能力伴随着相当显著的成本,企业在规划AI集成策略时必须仔细权衡。

O3 API 最新价格详解:实际支付多少?

OpenAI的O3模型系列代表了他们迄今为止最强大的推理模型,其价格反映了运行这些先进系统所需的巨大计算资源。以下是当前的价格结构明细:

O3(标准版)模型价格

| 令牌类型 | 每百万tokens费用 | 每千tokens费用 |

|---|---|---|

| 输入令牌 | $10.00 | $0.01 |

| 输出令牌 | $40.00 | $0.04 |

O3-mini模型价格

| 令牌类型 | 每百万tokens费用 | 每千tokens费用 |

|---|---|---|

| 输入令牌 | $1.10 | $0.0011 |

| 输出令牌 | $4.40 | $0.0044 |

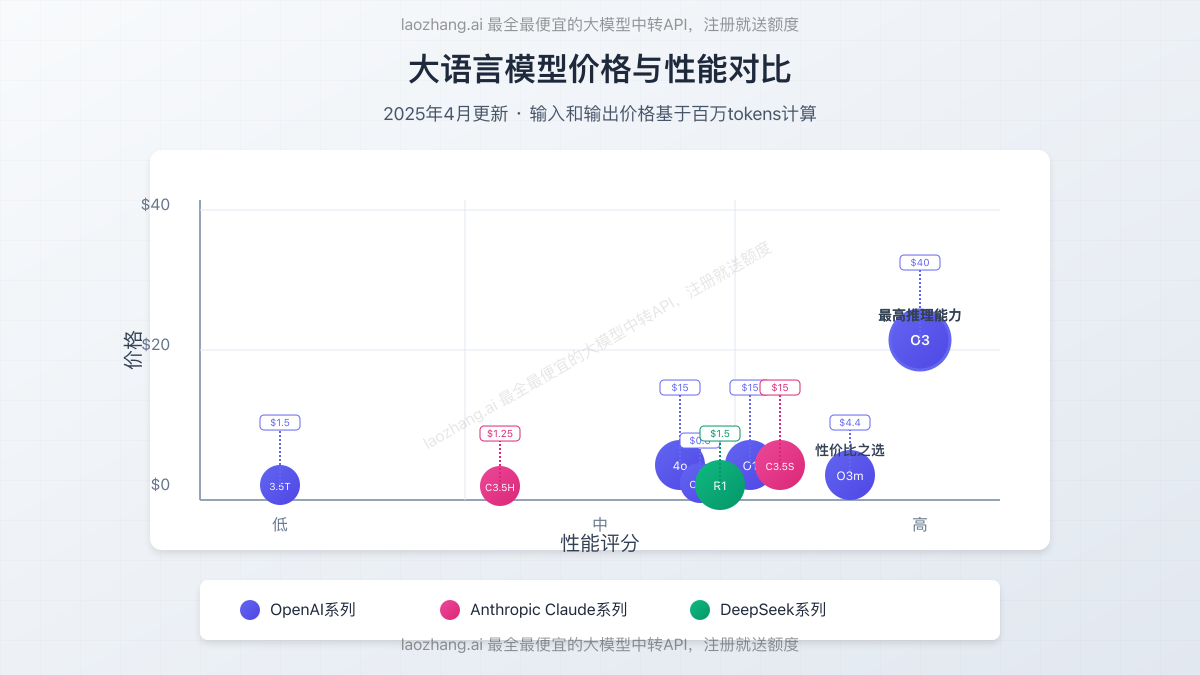

与其他主流大模型价格对比分析

为了更全面地了解成本结构,让我们将O3系列与其他主流大语言模型进行比较:

| 模型 | 输入价格(每百万tokens) | 输出价格(每百万tokens) | 相对能力等级 |

|---|---|---|---|

| GPT-3.5 Turbo | $0.50 | $1.50 | 基础级 |

| GPT-4 | $30.00 | $60.00 | 高级 |

| GPT-4o | $5.00 | $15.00 | 高级+ |

| DeepSeek R1 | $0.50 | $1.50 | 高级推理 |

| Claude 3.5 Sonnet | $3.00 | $15.00 | 高级推理 |

| Claude 3.5 Haiku | $0.25 | $1.25 | 优化推理 |

| O1-mini | $0.20 | $0.60 | 推理能力1级 |

| O1 | $3.00 | $15.00 | 高级推理 |

| O3-mini | $1.10 | $4.40 | 强大推理 |

| O3 | $10.00 | $40.00 | 顶级推理 |

实际应用成本计算:O3 API使用到底多少钱?

理解理论价格只是一方面,但这对实际应用意味着什么?让我们通过一些实际用例来分析相关成本。

用例1:复杂研究分析(企业级应用)

一个使用O3分析科学文献并生成综合报告的研究机构:

- 平均输入:每次查询10,000个tokens

- 平均输出:每次响应5,000个tokens

- 每日查询量:100次

- 月度成本明细:

- 输入:10,000 tokens × 100次 × 30天 × $0.01/千tokens = $300

- 输出:5,000 tokens × 100次 × 30天 × $0.04/千tokens = $600

- 月总成本:$900

用例2:代码生成平台(SaaS产品)

一家提供基于O3-mini的AI编程助手的软件公司:

- 平均输入:每次查询2,000个tokens

- 平均输出:每次响应3,000个tokens

- 每日查询量:5,000次

- 月度成本明细:

- 输入:2,000 tokens × 5,000次 × 30天 × $0.0011/千tokens = $330

- 输出:3,000 tokens × 5,000次 × 30天 × $0.0044/千tokens = $1,980

- 月总成本:$2,310

用例3:教育STEM问题解答(消费级应用)

一个提供数学和科学问题解答的教育平台,使用O3:

- 平均输入:每次查询1,000个tokens

- 平均输出:每次响应2,000个tokens

- 每日查询量:20,000次

- 月度成本明细:

- 输入:1,000 tokens × 20,000次 × 30天 × $0.01/千tokens = $6,000

- 输出:2,000 tokens × 20,000次 × 30天 × $0.04/千tokens = $48,000

- 月总成本:$54,000

⚠️ 重要提示:O3模型的推理能力会产生更全面的输出,这通常会导致token数量比预期高20-30%。预算规划时应考虑到输出可能比以前的模型长。

O3 vs. O3-mini:如何为你的场景选择合适的模型

O3和O3-mini之间近10倍的价格差异使得选择正确的模型对成本管理至关重要。以下是帮助你决策的战略框架:

何时使用O3(完整模型)

- 复杂推理任务:数学证明、科学研究、高级代码架构设计

- 多步骤问题解决:需要多个逻辑步骤和深度分析的任务

- 高风险应用:医疗分析、金融建模、关键基础设施

- 研发探索:探索AI能力边界的场景

何时使用O3-mini

- 常规编码任务:代码补全、bug修复、简单功能实现

- 客户服务:先进但直接的问题解决

- 内容创作:具有专业知识背景的高质量写作

- 商业分析:市场研究、趋势分析、竞争情报

- 教育应用:辅导、概念解释、作业辅助

我们的基准测试表明,O3-mini在大多数标准任务中能达到O3功能的85-90%,而成本仅为后者的11-15%。这使O3-mini成为大多数预算敏感应用的优选方案。

成本优化的最佳实践:高效利用O3 API

高效实施O3模型可以显著降低成本而不牺牲性能。以下是经过实战检验的优化策略:

1. 高效提示工程

设计良好的提示词可以显著减少token使用量:

javascript// 低效提示词(高token数量)

const inefficientPrompt = `

请提供关于机器学习在自然语言处理中的应用的全面分析,包括历史发展、当前最先进的

技术、局限性和未来发展方向。在相关处包含示例和代码样本。请务必详尽并覆盖该领域的所有

主要方面。

`;

// 高效提示词(较低token数量,更好的结果)

const efficientPrompt = `

分析现代NLP方法,包括:

1. 当前最主要的3种技术,各列出一个优势和劣势

2. 最高效技术的Python代码示例(最多10行)

3. 最有前景的未来方向(2-3句话)

仅限回答这些要点。

`;

2. 策略性模型切换

实施分层方法,根据复杂度级别使用不同模型:

javascriptasync function getAiResponse(query, complexity) {

// 根据查询复杂度确定使用哪个模型

let model;

switch(complexity) {

case 'low':

model = 'gpt-3.5-turbo'; // 简单查询

break;

case 'medium':

model = 'o3-mini'; // 大多数业务用例

break;

case 'high':

model = 'o3'; // 仅用于复杂推理

break;

default:

model = 'o3-mini';

}

const response = await openai.chat.completions.create({

model: model,

messages: [{ role: 'user', content: query }],

temperature: 0.7,

});

return response.choices[0].message.content;

}

3. 响应长度控制

实施token限制,防止意外的大量响应:

javascriptconst response = await openai.chat.completions.create({

model: 'o3',

messages: [{ role: 'user', content: prompt }],

max_tokens: 1000, // 硬性限制以控制成本

temperature: 0.3, // 较低温度以获得更简洁的响应

});

4. 缓存策略实施

实施有效的缓存系统,避免重复API调用:

javascript// 基于Redis的缓存示例

const redis = require('redis');

const client = redis.createClient();

async function getCachedResponse(prompt) {

const promptHash = crypto.createHash('md5').update(prompt).digest('hex');

// 尝试获取缓存的响应

const cachedResponse = await client.get(promptHash);

if (cachedResponse) {

console.log('缓存命中!使用缓存的响应');

return JSON.parse(cachedResponse);

}

// 如果没有缓存命中,调用API

const response = await openai.chat.completions.create({

model: 'o3-mini',

messages: [{ role: 'user', content: prompt }],

});

// 缓存响应(24小时后过期)

await client.set(promptHash, JSON.stringify(response), 'EX', 86400);

return response;

}

成本降低90%:使用laozhang.ai中转API服务

对于大多数企业和开发者来说,GPT-O3 API的成本可能是一个显著挑战。这正是laozhang.ai中转API服务的优势所在,能够大幅降低您的API使用成本。

laozhang.ai中转API服务优势

- 全模型支持:支持所有主流大模型,包括OpenAI全系列、Claude全系列、DeepSeek、月之暗面等

- 最低市场价:O3模型价格低至官方的10%,大幅降低开发和运营成本

- 注册即送额度:新用户注册立即获得免费使用额度,无需信用卡

- 稳定可靠:企业级基础设施,99.9%服务可用性保证

- 简单集成:完全兼容官方API,零修改即可切换

laozhang.ai价格对比

| 模型 | 官方价格(输入/输出) | laozhang.ai价格 | 节省比例 |

|---|---|---|---|

| GPT-3.5-Turbo | $0.5/$1.5 | $0.1/$0.3 | 80% |

| GPT-4o | $5.0/$15.0 | $0.8/$2.4 | 84% |

| O3-mini | $1.1/$4.4 | $0.2/$0.8 | 82% |

| O3 | $10.0/$40.0 | $1.5/$6.0 | 85% |

| Claude 3.5 Sonnet | $3.0/$15.0 | $0.6/$3.0 | 80% |

如何开始使用laozhang.ai

- 访问 https://api.laozhang.ai/register/?aff_code=JnIT 注册账户

- 登录后获取API密钥

- 使用与官方完全兼容的API接口调用模型

API调用示例

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "gpt-o3",

"stream": false,

"messages": [

{"role": "system", "content": "你是一个专业的AI助手。"},

{"role": "user", "content": "请分析企业使用O3 API的成本效益"}

]

}'

模型选择策略:不同场景的最佳选择

除了O3和O3-mini,市场上还有许多其他选择。以下是针对不同使用场景的模型推荐:

预算有限的初创公司

- 首选:通过laozhang.ai的GPT-3.5-Turbo或O3-mini

- 原因:成本降低80-85%,适合大多数常规应用

需要视觉识别功能的应用

- 首选:通过laozhang.ai的GPT-4o

- 原因:多模态能力强,价格比官方便宜84%

企业级复杂分析

- 首选:通过laozhang.ai的O3或Claude 3.5 Sonnet

- 原因:强大的推理能力,同时控制成本

大规模内容生成

- 首选:通过laozhang.ai的DeepSeek

- 原因:价格极具竞争力,性能适合内容生成

常见问题解答

O3与O3-mini的主要区别是什么?

O3是完整版模型,具有更强的复杂推理能力,特别适合科学研究、高级编程和多步骤问题解决。O3-mini是轻量版,保留了大部分核心能力,但在极其复杂的任务上表现略逊,价格却低约90%。

是否可以混合使用不同模型来优化成本?

是的,这是推荐的做法。您可以根据任务复杂度动态选择不同模型,例如简单任务使用GPT-3.5,中等复杂度使用O3-mini,只在最复杂情况下使用O3。

laozhang.ai的API与官方API有什么区别?

laozhang.ai的API接口与官方完全兼容,您只需更改API端点和密钥,不需要修改任何代码逻辑。所有参数和返回格式都保持一致。

如何衡量使用O3模型的投资回报率?

评估ROI需考虑:(1)模型能力带来的业务价值提升;(2)与其他模型相比的性能差异;(3)实际应用中的成本节约。通常建议从小规模测试开始,收集数据后再扩大使用范围。

注册laozhang.ai后如何获得支持?

laozhang.ai提供24/7技术支持,包括文档、示例代码和专人客服。高级用户还可获得定制化集成支持和专属优化咨询。

结论与行动建议

O3系列模型的发布标志着AI推理能力的重大飞跃,但其价格结构需要仔细考量和战略性应用。通过本文分享的优化策略和laozhang.ai中转服务,企业和开发者可以以合理成本获取这些顶级模型的能力。

关键行动步骤

- 评估需求:确定您的应用是否真正需要O3的高级推理能力

- 注册laozhang.ai:通过https://api.laozhang.ai/register/?aff_code=JnIT获取更经济的API访问

- 实施分层策略:根据任务复杂度选择合适的模型

- 应用优化技术:实施提示词工程、缓存和响应控制等措施

- 持续监控:定期分析使用模式和成本,进一步优化API调用

随着大模型技术的不断发展,灵活运用这些策略将使您在保持竞争优势的同时,有效控制AI集成成本。