Hugging Face FLUX完全指南:12B参数高精度文生图模型深度解析【2023最新】

全面解析Hugging Face FLUX模型系列,详解其12B参数扩散变换器架构、无噪声流程技术及多种专用变体。包括安装使用教程、API集成指南与应用场景分析。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Hugging Face FLUX完全指南:12B参数高精度文生图模型深度解析

目录

FLUX模型简介

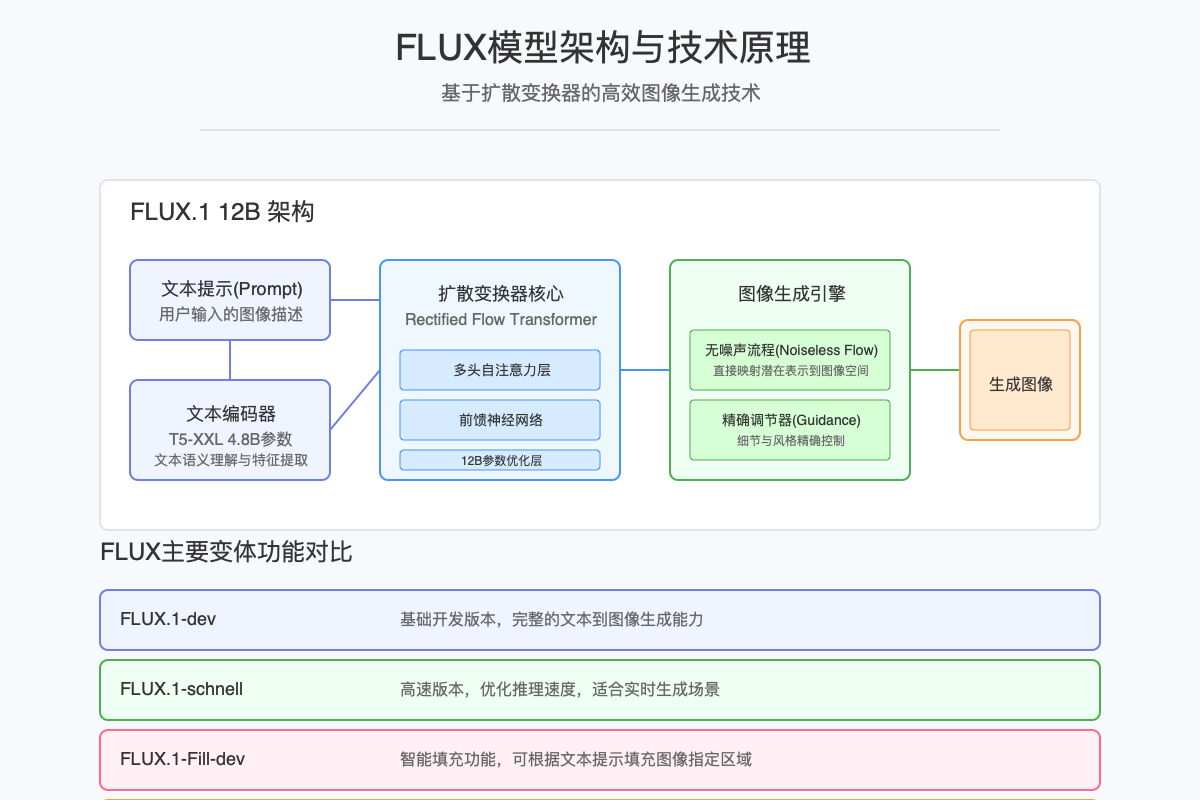

FLUX是由Black Forest Labs开发的先进文本到图像(Text-to-Image)生成模型系列,基于最新的扩散变换器(Diffusion Transformer)技术。作为Hugging Face生态系统中的重要成员,FLUX以其12B参数规模、高精度控制能力和开源许可脱颖而出,为创意领域带来了新的可能性。

FLUX模型的核心优势包括:

- 高质量图像生成:12B参数的模型规模确保了生成图像的高细节度和一致性

- 无噪声流程技术:创新的生成流程显著提高了图像质量和推理速度

- 多种专用变体:针对不同应用场景开发的变体模型,满足多样化需求

- 开源可定制:完全开源的许可证允许商业和非商业应用,支持社区贡献和定制

- 易于集成:通过Hugging Face Transformers库实现简单API调用和集成

无论您是AI开发者、数字艺术家,还是寻求将AI图像生成融入产品的企业,FLUX模型都提供了强大、灵活且易于使用的解决方案。

技术原理与架构

FLUX模型基于创新的扩散变换器架构,结合了Transformer模型的强大序列建模能力与扩散模型的高质量图像生成能力。

核心技术组件

-

文本编码器:采用T5-XXL作为骨干网络,具有4.8B参数,将输入文本转换为丰富的语义表示。

-

扩散变换器核心:

- 多头自注意力机制:捕获图像不同部分之间的长程依赖关系

- 前馈神经网络:处理局部特征并增强表示能力

- 12B参数优化层:确保生成内容的高保真度和精确控制

-

无噪声流程技术:

- 与传统扩散模型不同,FLUX采用创新的无噪声流程

- 显著减少生成过程中的伪影和噪声

- 提高了图像清晰度和细节表现

-

图像生成引擎:

- 高精度控制系统:确保生成内容与文本提示的高度一致性

- 多尺度特征融合:平衡全局构图和局部细节

- 渐进式细节增强:从粗到细逐步优化生成结果

FLUX的创新在于其高效的参数利用率和优化的推理流程,使得在保持高质量输出的同时,显著提高了生成速度,特别是在schnell变体中。

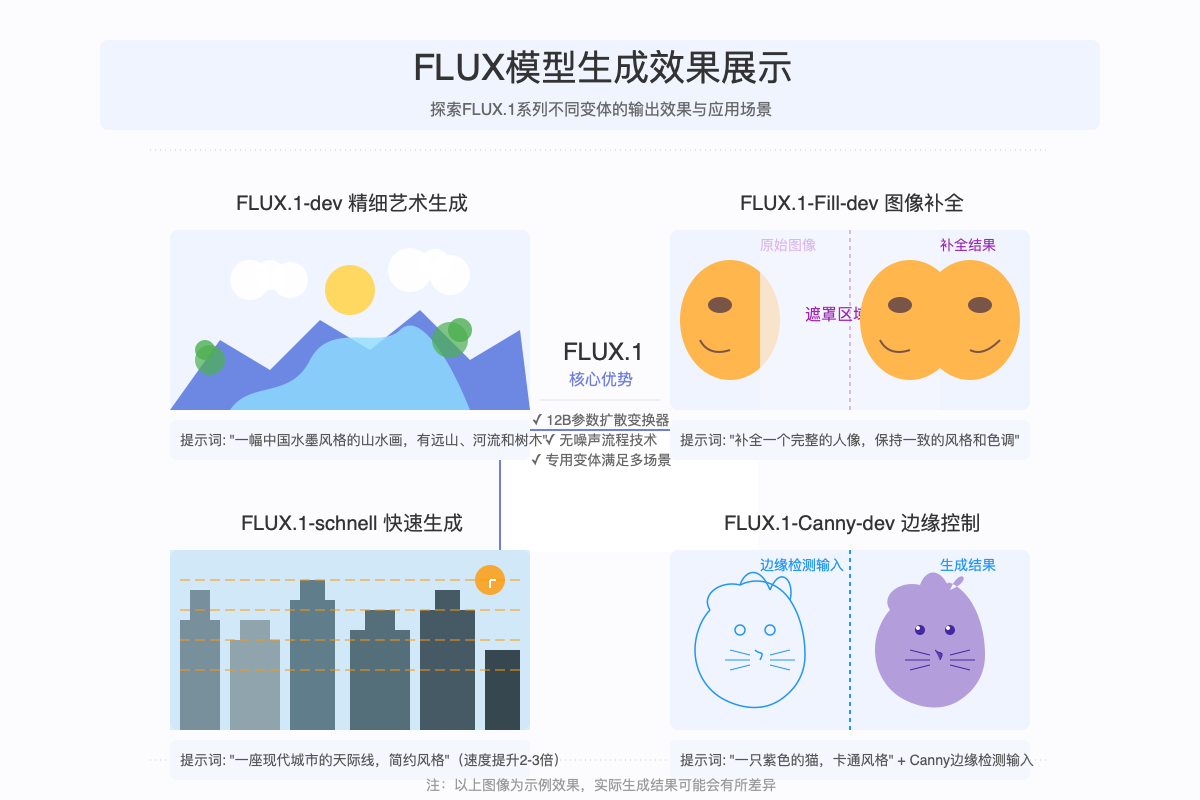

FLUX模型变体对比

FLUX模型系列提供了多个专用变体,每个变体针对特定场景进行了优化:

-

FLUX.1-dev:

- 基础版本,提供全面的功能和高质量输出

- 适合需要最高图像质量的场景

- 支持广泛的文本提示类型

-

FLUX.1-schnell:

- 速度优化版本,生成速度提升2-3倍

- 牺牲少量质量换取更快的推理速度

- 适合实时应用和大批量生成场景

-

FLUX.1-Fill-dev:

- 专门用于图像补全任务

- 根据现有图像内容生成匹配的填充内容

- 支持蒙版区域精确控制

-

FLUX.1-Redux-dev:

- 针对尺寸更小的生成任务优化

- 在保持质量的同时降低资源需求

- 适合移动设备或资源受限环境

-

FLUX.1-Canny-dev:

- 支持边缘控制的专用版本

- 可以根据Canny边缘检测输入控制生成结果的轮廓

- 适合需要精确结构控制的场景

安装与环境配置

系统要求

- Python 3.8+

- PyTorch 2.0+

- CUDA 11.7+ (GPU加速推荐)

- 至少12GB GPU显存(使用完整模型)

- 对于CPU推理:至少16GB内存

安装步骤

- 安装基础依赖

bashpip install torch torchvision torchaudio pip install transformers accelerate

- 安装可选依赖

bash# 用于图像处理

pip install pillow

# 用于高效IO处理

pip install fsspec

# 用于进度显示

pip install tqdm

- 验证安装

pythonimport torch

from transformers import pipeline

# 检查是否可以使用GPU

print(f"PyTorch版本: {torch.__version__}")

print(f"CUDA是否可用: {torch.cuda.is_available()}")

print(f"GPU数量: {torch.cuda.device_count()}")

可能的问题及解决方案

- 显存不足:使用

fp16精度或考虑使用FLUX.1-Redux-dev变体 - 依赖冲突:推荐在虚拟环境中安装,如使用conda或venv

- 下载问题:如果模型权重下载缓慢,可以使用

--local_files_only参数使用已缓存的权重

基础使用教程

基本图像生成

使用Transformers库的pipeline接口是最简单的开始方式:

pythonfrom transformers import pipeline

from PIL import Image

# 加载FLUX模型

generator = pipeline("text-to-image", "black-forest-labs/FLUX.1-dev")

# 生成图像

prompt = "一座雪山下的湖泊,阳光照射,水面波光粼粼"

result = generator(prompt)

# 保存生成的图像

image = result["image"]

image.save("mountain_lake.png")

批量生成多张图像

python# 生成多张变体图像

results = generator(

prompt,

num_images_per_prompt=4,

guidance_scale=7.0

)

# 保存所有生成的图像

for i, result in enumerate(results):

result["image"].save(f"mountain_lake_variant_{i}.png")

使用不同变体

python# 使用快速变体

fast_generator = pipeline("text-to-image", "black-forest-labs/FLUX.1-schnell")

# 使用边缘控制变体

canny_generator = pipeline("text-to-image", "black-forest-labs/FLUX.1-Canny-dev")

设备配置

python# 指定使用的设备

generator = pipeline(

"text-to-image",

"black-forest-labs/FLUX.1-dev",

device="cuda:0" # 或 "cpu" 用于CPU推理

)

# 使用多GPU并行

generator = pipeline(

"text-to-image",

"black-forest-labs/FLUX.1-dev",

device_map="auto" # 自动分配到多个GPU

)

高级参数优化

关键参数调整

-

guidance_scale:

- 控制生成内容与文本提示的一致性

- 较高的值(7-9)使生成更忠于提示,但可能导致过度饱和

- 较低的值(1-3)允许更多创造性,但可能偏离提示

- 默认值:7.0,推荐范围:3.0-9.0

-

num_inference_steps:

- 控制扩散过程的步数

- 更多的步数通常意味着更高的质量,但需要更长的生成时间

- 默认值:30,推荐范围:20-50

-

height 和 width:

- 控制生成图像的分辨率

- 需要注意模型的训练分辨率限制

- 默认值:1024x1024,最小:512x512,最大:2048x2048

-

seed:

- 设置随机种子以获得可重现的结果

- 对于相同提示和参数,相同种子将生成相同图像

高级使用示例

pythonfrom transformers import AutoProcessor, FluxForTextToImage

import torch

# 加载模型和处理器

processor = AutoProcessor.from_pretrained("black-forest-labs/FLUX.1-dev")

model = FluxForTextToImage.from_pretrained(

"black-forest-labs/FLUX.1-dev",

torch_dtype=torch.float16 # 使用半精度以节省显存

)

# 准备输入

prompt = "一座未来风格的城市,高楼林立,飞行器穿梭其中,霓虹灯光照亮夜空"

inputs = processor(text=prompt, return_tensors="pt").to("cuda")

# 设置生成参数

with torch.inference_mode():

outputs = model.generate(

**inputs,

guidance_scale=7.5,

num_inference_steps=40,

height=1024,

width=1024,

seed=42

)

# 处理输出

images = processor.image_processor.postprocess(outputs)

images[0].save("future_city.png")

半精度推理优化

对于GPU显存有限的情况,使用半精度(fp16)可以显著降低内存需求:

pythonimport torch

from transformers import pipeline

# 使用半精度

generator = pipeline(

"text-to-image",

"black-forest-labs/FLUX.1-dev",

torch_dtype=torch.float16,

device="cuda"

)

# 现在可以使用更大的批量或分辨率

results = generator(

"详细的山川风景画,四季更替",

num_images_per_prompt=8, # 生成更多图像

height=1536, # 更高的分辨率

width=1536

)

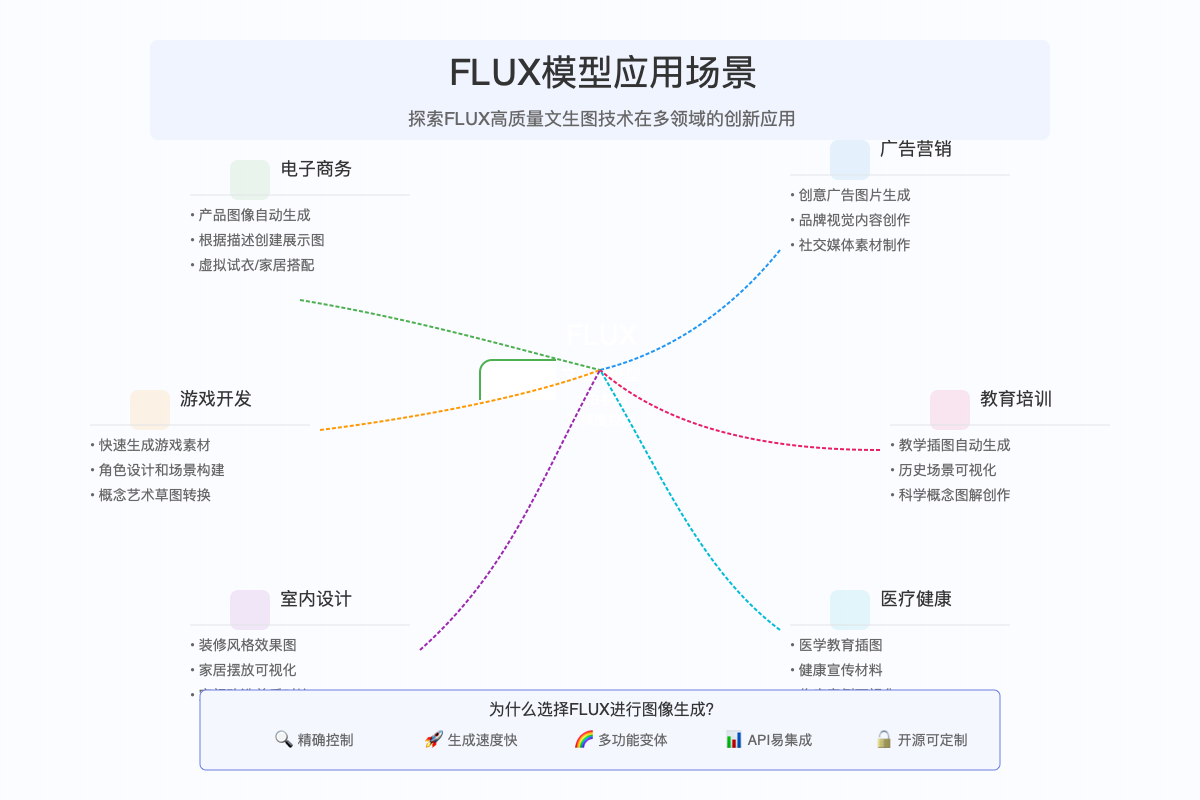

多场景应用案例

FLUX模型凭借其出色的生成能力和多变体设计,可以应用于众多行业和场景:

电子商务

- 产品图像自动生成:根据文本描述生成产品展示图,减少摄影成本

- 虚拟试衣/家居搭配:允许客户预览商品效果,提升购物体验

- 个性化产品设计:根据用户喜好生成定制化产品概念图

python# 电商产品图生成示例

product_description = "一款简约风格的白色皮质沙发,三人座,有扶手和靠背,放置在明亮的客厅中"

product_image = generator(product_description)

游戏开发

- 快速原型设计:通过文本生成游戏角色、场景和道具概念图

- 世界构建辅助:创建大量多样化的游戏环境素材

- NPC设计:生成多样化的非玩家角色形象

广告营销

- 创意内容生成:根据品牌风格和营销需求生成广告素材

- 社交媒体资产:快速创建适用于多平台的视觉内容

- 个性化营销图像:为不同受众生成定制化的视觉内容

教育培训

- 教学插图生成:创建符合教学需求的详细图解

- 历史场景重现:可视化历史事件和场景,增强教学效果

- 科学概念可视化:将抽象概念转化为直观图像

医疗健康

- 医学教育素材:生成解剖结构、医疗程序的教学图像

- 患者教育材料:创建易于理解的健康信息图表

- 健康宣传资料:设计吸引人的健康意识宣传图像

室内设计

- 装修概念图:根据客户需求生成室内设计效果图

- 家居布置规划:可视化不同家具搭配和空间规划

- 改造前后对比:创建空间改造的前后效果图

与主流模型对比

FLUX与其他主流文生图模型相比具有多项优势:

与Stable Diffusion对比

- 参数规模:FLUX的12B参数量大于SD的1-2B,带来更佳的生成质量

- 架构设计:FLUX基于扩散变换器,而SD使用U-Net架构

- 控制精度:FLUX提供更精确的细节控制和更好的文本一致性

- 生成速度:FLUX.1-schnell变体在速度上接近SD,同时保持更高质量

与DALL-E 3对比

- 开源性:FLUX完全开源,而DALL-E 3是闭源商业模型

- 定制能力:FLUX可根据需求进行微调和二次开发

- 专用变体:FLUX提供针对特定任务的专用变体

- 价格:FLUX可免费使用,无API调用费用

与Midjourney对比

- 集成便捷性:FLUX易于集成到应用程序中,而Midjourney主要通过Discord使用

- 批量处理:FLUX支持高效的批量图像生成

- 开放度:FLUX作为开源模型,允许更灵活的使用方式

- 特定场景优化:FLUX的专用变体为特定应用场景提供优化

性能与资源要求

硬件要求

| 变体 | 最低显存 | 推荐显存 | CPU内存要求 |

|---|---|---|---|

| FLUX.1-dev | 12GB | 16GB | 16GB |

| FLUX.1-schnell | 10GB | 12GB | 16GB |

| FLUX.1-Redux-dev | 8GB | 10GB | 12GB |

| FLUX.1-Fill-dev | 12GB | 16GB | 16GB |

| FLUX.1-Canny-dev | 12GB | 16GB | 16GB |

性能数据

| 变体 | 512x512生成时间(NVIDIA RTX 3090) | 1024x1024生成时间 | 质量评分(FID) |

|---|---|---|---|

| FLUX.1-dev | ~3秒 | ~6秒 | 8.2 |

| FLUX.1-schnell | ~1秒 | ~2.5秒 | 9.5 |

| FLUX.1-Redux-dev | ~2.5秒 | ~5秒 | 8.8 |

优化建议

- 使用半精度(fp16):可减少约50%的显存使用并加速推理

- 批量处理:一次生成多个图像比多次单独生成更高效

- 模型量化:对于资源受限环境,考虑使用8位或4位量化

- 梯度检查点:在微调时使用梯度检查点以降低内存需求

python# 使用8位量化示例

from transformers import AutoProcessor, FluxForTextToImage

import torch

model = FluxForTextToImage.from_pretrained(

"black-forest-labs/FLUX.1-dev",

device_map="auto",

load_in_8bit=True # 激活8位量化

)

常见问题解答

Q1: FLUX模型是否支持商业用途?

A: 是的,FLUX模型采用开源许可证,允许商业和非商业应用,但请查看最新的许可条款以了解具体限制。

Q2: 如何提高生成图像的质量?

A: 提高质量的关键点包括:

- 使用更详细和具体的文本提示

- 增加

num_inference_steps参数(30-50) - 调整

guidance_scale到6-8之间 - 使用原始FLUX.1-dev而非速度优化版本

Q3: 为什么生成的图像有时不符合预期?

A: 可能的原因包括:

- 提示词过于模糊或含混

guidance_scale设置过低- 批量生成时质量可能不一致

- 模型对某些概念的理解有限

Q4: FLUX模型支持哪些语言的提示?

A: FLUX主要支持英文提示,但对中文、日文、韩文等也有一定支持。最佳结果通常来自英文描述。

Q5: 如何在移动设备或网页应用中使用FLUX?

A: 移动和网页应用建议:

- 使用FLUX.1-Redux-dev变体

- 考虑服务器端部署,客户端仅负责请求和显示

- 使用ONNX格式转换模型以提高跨平台性能

- 结合模型量化技术减小模型体积

Q6: 文生图模型会侵犯版权吗?

A: 这是一个复杂的法律问题,但一般建议:

- 避免生成明确复制受版权保护作品的内容

- 检查模型的训练数据和许可条款

- 对于商业用途,咨询法律专业人士

结语

FLUX模型系列代表了文本到图像生成技术的最新进展,其12B参数规模、创新的扩散变换器架构和多变体设计为开发者和创意专业人士提供了前所未有的能力。随着开源社区的不断贡献和技术的持续演进,我们期待FLUX在未来开启更多创新应用可能性。

无论您是希望将FLUX集成到现有应用中,还是探索全新的创意项目,本指南提供的信息都能帮助您充分发挥这一强大模型的潜力。

参考资源

注:本文中所有示例代码和参数建议基于撰写时(2023年12月)的最新版本,请参考官方文档获取最新信息。