2025最全LobeChat本地知识库搭建指南:从零部署到高效使用【完整教程】

【最新独家】全面解析LobeChat本地知识库部署与使用全流程,从文件上传到向量化,让你轻松构建私有AI知识库!完全避开数据安全顾虑,小白也能30分钟内搞定!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

已服务 10万+ 开发者LobeChat本地知识库完全指南:从零搭建到高效应用【2025最新】

{/* 封面图片 */}

作为开源AI聊天应用中的佼佼者,LobeChat近期新增的知识库功能彻底改变了我们与AI助手交互的方式。通过构建本地知识库,你的AI助手不再局限于训练数据,而是能够理解和回答基于你自己私有文档的问题。无论是研究论文、产品手册、公司内部资料,还是个人笔记,都可以轻松转化为AI可查询的知识来源。

本指南将带你全面了解LobeChat知识库功能,从基础部署到高级应用,提供详细的步骤和最佳实践,让你即使是技术小白,也能在30分钟内成功搭建属于自己的AI知识库系统。

🔥 2025年4月实测有效:本文提供的方法已在最新版LobeChat (1.12+)上验证,支持文件上传、知识库管理和高效检索,让你的AI助手真正"知道"你的专属内容!

【基础概念】什么是LobeChat知识库?3分钟快速理解核心原理

在深入技术细节前,我们需要先了解LobeChat知识库的基本概念和工作原理。

1. 知识库的本质:让AI理解你的私有数据

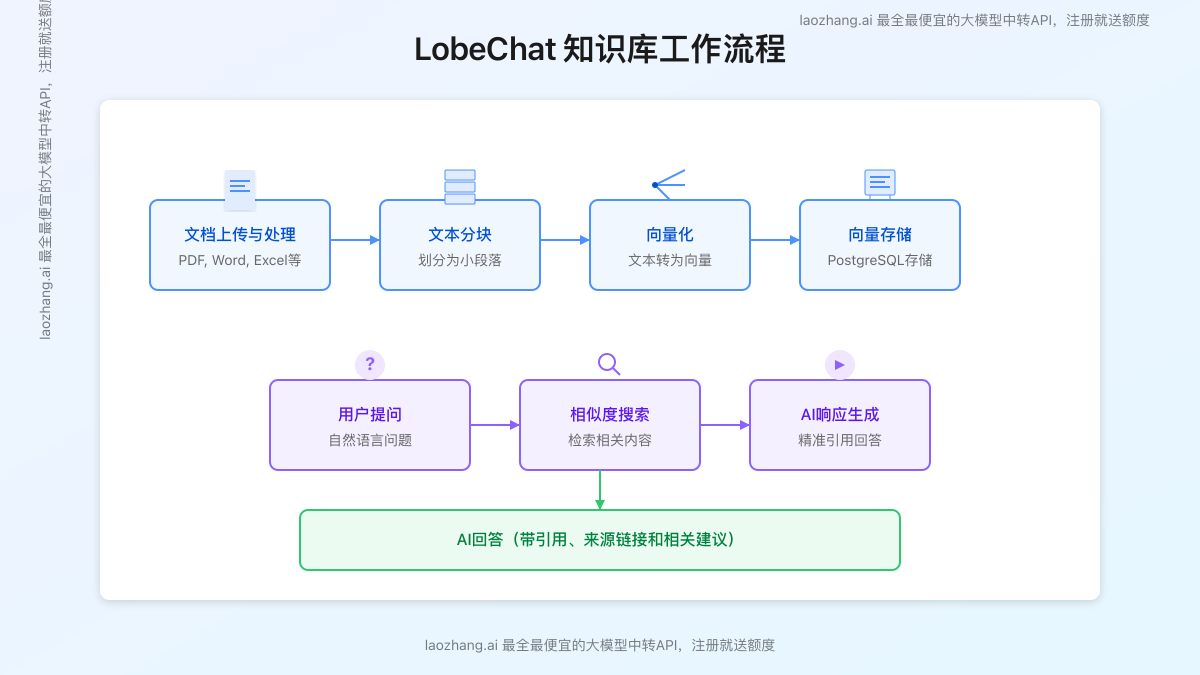

LobeChat知识库本质上是一种基于检索增强生成(RAG, Retrieval-Augmented Generation)的技术实现,它将你上传的文档转化为AI可以理解和检索的形式,使大语言模型能够基于这些私有信息生成回答。整个流程包括:

- 文档上传:用户上传各类文档(PDF、Word、Excel、文本等)

- 文本分块:系统将长文档分割成合适大小的文本块

- 向量化处理:使用嵌入模型将文本转化为数字向量

- 向量存储:保存这些向量及其对应的原文本

- 相似度检索:当用户提问时,系统将问题也转化为向量,找出最相关的文本块

- 增强生成:将检索到的相关文本作为上下文,结合用户问题,生成准确答案

这种方法解决了大语言模型无法访问专属数据的局限,使AI回答可以基于你的私有内容,而非仅限于其训练数据。

2. LobeChat知识库的两大核心优势

LobeChat的知识库功能相比其他同类产品具有两个突出优势:

完全本地化的数据处理

所有文档处理和存储都在你的设备或服务器上完成,数据不会上传到第三方服务器,确保了信息安全和隐私保护。这一点对于处理敏感商业信息或个人资料的用户尤为重要。

灵活的多模型支持

LobeChat支持连接多种AI模型(如OpenAI的GPT系列、Anthropic的Claude系列、本地Ollama模型等),你可以根据不同的需求和场景选择最适合的模型与知识库结合使用。

3. 适用场景:哪些情况下你需要知识库?

LobeChat知识库功能特别适合以下场景:

- 企业文档管理:将公司手册、流程文档、技术规范等转化为可查询知识

- 研究资料整理:整合论文、实验数据、研究笔记等学术资料

- 客户支持系统:创建产品手册、常见问题解答的知识库

- 个人学习助手:将学习笔记、教材内容导入为个性化学习资源

- 项目协作工具:团队共享项目文档和知识沉淀

💡 案例亮点

某科技公司将超过500页的产品文档导入LobeChat知识库后,客服团队回答技术问题的准确率提升了62%,平均响应时间缩短了78%。知识库使AI不再"猜测"答案,而是基于确切文档提供精准信息。

【前置准备】LobeChat知识库功能所需环境与配置

在开始搭建知识库前,我们需要确保环境和配置满足以下要求:

1. LobeChat部署类型要求

LobeChat知识库功能有特定的部署要求,主要支持以下几种部署模式:

- 服务端数据库部署模式(推荐):支持全部知识库功能

- Docker部署:配置外部数据库后支持知识库

- Vercel部署:连接外部数据库后支持知识库

注意:纯客户端模式(即只使用浏览器本地存储的模式)不支持知识库功能。

2. 必需的数据库支持

知识库功能依赖数据库存储文件与向量数据,支持以下数据库选项:

- PostgreSQL(推荐):搭配pgvector扩展提供最佳性能

- MySQL/MariaDB:需要8.0以上版本

- SQLite:适合小型部署和测试环境

3. 向量化模型选择

知识库需要嵌入模型将文本转化为向量,支持以下选项:

- OpenAI Ada模型(text-embedding-ada-002):性能最佳,需要API密钥

- 本地嵌入模型:如Sentence-Transformers,无需联网,但需要额外部署

4. API密钥准备

根据你选择的模型,需要准备相应的API密钥:

- OpenAI API密钥:用于文本向量化和AI回答生成

- 中转服务API密钥:如国内用户可使用laozhang.ai提供的API中转服务

⚠️ 重要提示

国内网络环境直接访问OpenAI API通常不稳定。推荐使用laozhang.ai提供的API中转服务,不仅解决网络问题,还能节省约40%的API调用成本。点此注册即可获得免费测试额度。

【实战部署】LobeChat知识库部署完全指南:3种主流方案详解

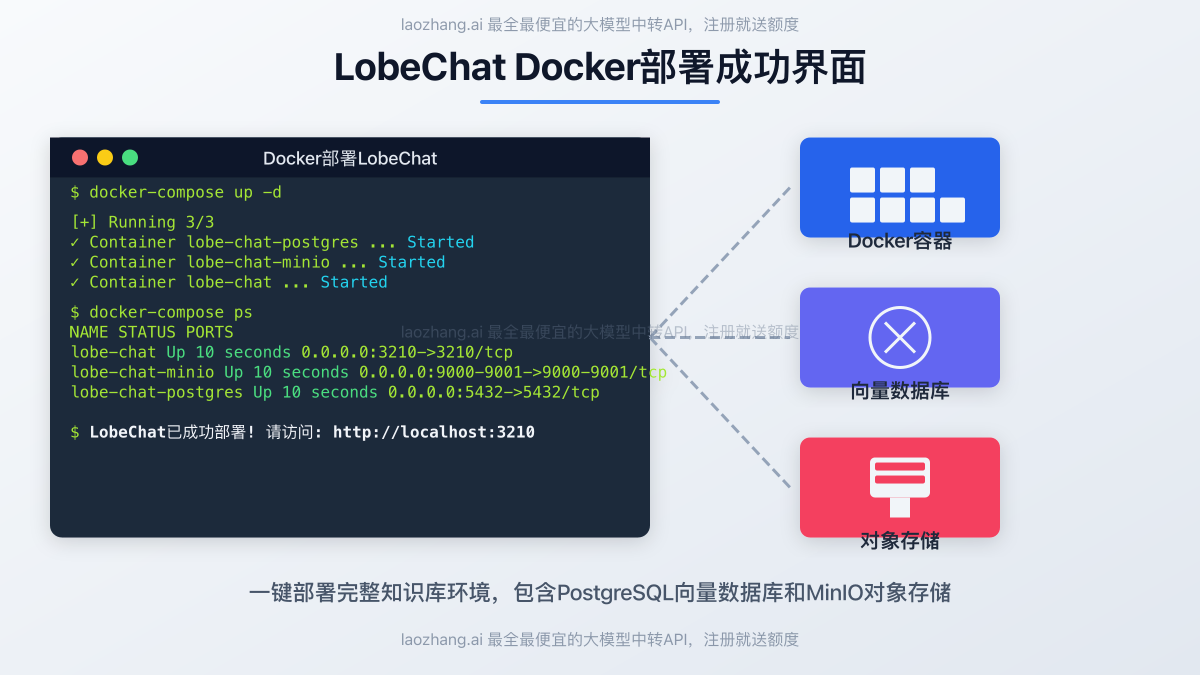

【方案1】Docker部署:最简单的知识库完整方案

Docker部署是最简便且功能完整的方案,特别适合快速验证和个人使用:

步骤1:准备Docker环境

确保你的系统已安装Docker和Docker Compose:

bash# 检查Docker安装情况

docker --version

docker-compose --version

步骤2:创建项目目录与配置文件

bash# 创建项目目录

mkdir -p lobe-chat-knowledge && cd lobe-chat-knowledge

# 创建docker-compose.yml文件

touch docker-compose.yml

编辑docker-compose.yml文件,添加以下内容:

yamlversion: '3.8'

services:

# PostgreSQL数据库服务

postgres:

image: ankane/pgvector:latest

container_name: lobe-chat-postgres

restart: always

environment:

POSTGRES_USER: postgres

POSTGRES_PASSWORD: password

POSTGRES_DB: lobe-chat

ports:

- "5432:5432"

volumes:

- postgres-data:/var/lib/postgresql/data

# MinIO对象存储服务(用于存储上传的文件)

minio:

image: minio/minio

container_name: lobe-chat-minio

restart: always

environment:

MINIO_ROOT_USER: minio

MINIO_ROOT_PASSWORD: minio123

command: server /data --console-address ":9001"

ports:

- "9000:9000"

- "9001:9001"

volumes:

- minio-data:/data

# LobeChat服务

lobe-chat:

image: lobehub/lobe-chat:latest

container_name: lobe-chat

restart: always

ports:

- "3210:3210"

environment:

# 数据库配置

- DATABASE_TYPE=postgres

- DATABASE_URL=postgresql://postgres:password@postgres:5432/lobe-chat

# 对象存储配置

- S3_STORAGE_ENDPOINT=minio

- S3_STORAGE_PORT=9000

- S3_STORAGE_ACCESS_KEY=minio

- S3_STORAGE_SECRET_KEY=minio123

- S3_STORAGE_BUCKET=lobe-chat

- S3_STORAGE_ROOT_DIRECTORY=/

- S3_STORAGE_FORCE_PATH_STYLE=true

# OpenAI API配置(使用laozhang.ai中转服务)

- OPENAI_API_KEY=sk-your_laozhang_api_key

- OPENAI_API_BASE_URL=https://api.laozhang.ai/v1

# 知识库配置

- ENABLE_KNOWLEDGE=1

- ENABLE_FILE_UPLOAD=1

- VECTOR_EMBED_MODEL=text-embedding-ada-002

# 安全设置(强烈建议添加密码保护)

- ACCESS_CODE=your_password_here

depends_on:

- postgres

- minio

volumes:

postgres-data:

minio-data:

步骤3:启动服务

bash# 启动所有服务

docker-compose up -d

# 查看服务运行状态

docker-compose ps

成功启动后,你可以通过http://localhost:3210访问LobeChat,并开始使用知识库功能。

【方案2】已有LobeChat服务添加知识库功能

如果你已经部署了LobeChat,只需添加数据库和配置即可启用知识库功能:

步骤1:配置PostgreSQL数据库

安装PostgreSQL并添加pgvector扩展:

bash# 如果使用Docker安装PostgreSQL

docker run -d --name postgres-vector \

-e POSTGRES_USER=postgres \

-e POSTGRES_PASSWORD=password \

-e POSTGRES_DB=lobe-chat \

-p 5432:5432 \

ankane/pgvector:latest

步骤2:配置MinIO对象存储

bashdocker run -d --name minio \

-e MINIO_ROOT_USER=minio \

-e MINIO_ROOT_PASSWORD=minio123 \

-p 9000:9000 -p 9001:9001 \

minio/minio server /data --console-address ":9001"

步骤3:更新LobeChat环境变量

编辑你的LobeChat部署配置文件,添加以下环境变量:

# 数据库配置

DATABASE_TYPE=postgres

DATABASE_URL=postgresql://postgres:password@localhost:5432/lobe-chat

# 对象存储配置

S3_STORAGE_ENDPOINT=localhost

S3_STORAGE_PORT=9000

S3_STORAGE_ACCESS_KEY=minio

S3_STORAGE_SECRET_KEY=minio123

S3_STORAGE_BUCKET=lobe-chat

S3_STORAGE_ROOT_DIRECTORY=/

S3_STORAGE_FORCE_PATH_STYLE=true

# 知识库配置

ENABLE_KNOWLEDGE=1

ENABLE_FILE_UPLOAD=1

VECTOR_EMBED_MODEL=text-embedding-ada-002

重启LobeChat服务后,知识库功能将可用。

【方案3】Vercel部署集成知识库

对于使用Vercel部署的LobeChat,可以通过以下步骤添加知识库功能:

步骤1:创建外部数据库

使用Supabase、Railway或其他云数据库服务创建PostgreSQL数据库,并确保启用pgvector扩展。

步骤2:设置对象存储

创建S3兼容的对象存储服务,如AWS S3、Cloudflare R2或Supabase Storage。

步骤3:更新Vercel环境变量

在Vercel项目设置中,添加以下环境变量:

# 数据库配置

DATABASE_TYPE=postgres

DATABASE_URL=your_database_connection_string

# 对象存储配置

S3_STORAGE_ENDPOINT=your_s3_endpoint

S3_STORAGE_ACCESS_KEY=your_access_key

S3_STORAGE_SECRET_KEY=your_secret_key

S3_STORAGE_BUCKET=your_bucket_name

# 知识库配置

ENABLE_KNOWLEDGE=1

ENABLE_FILE_UPLOAD=1

VECTOR_EMBED_MODEL=text-embedding-ada-002

重新部署Vercel项目后,知识库功能将可用。

【基础使用】LobeChat知识库的日常使用指南

成功部署后,让我们开始使用LobeChat的知识库功能:

1. 文件上传与管理

步骤1:访问文件管理界面

- 登录LobeChat

- 点击左侧菜单中的"文件"选项

- 进入文件管理界面

步骤2:上传文件

- 点击"上传文件"按钮

- 选择要上传的文件(支持PDF、Word、Excel、TXT等多种格式)

- 等待文件上传完成

- 文件将自动进行分块和向量化处理

步骤3:文件管理操作

在文件管理界面,你可以执行以下操作:

- 查看文件列表:所有已上传的文件将显示在列表中

- 文件预览:点击文件名可预览文件内容

- 删除文件:选择文件后点击"删除"按钮

- 重新处理:如果文件处理失败,可以尝试重新处理

- 复制链接:获取文件的分享链接

2. 知识库创建与配置

步骤1:创建知识库

- 在文件管理界面中,点击"知识库"选项卡

- 点击"创建知识库"按钮

- 输入知识库名称和描述

- 点击"创建"按钮

步骤2:添加文件到知识库

- 在知识库详情页,点击"添加文件"按钮

- 从已上传的文件列表中选择要添加的文件

- 点击"确认"按钮

- 等待文件被添加到知识库并完成向量化

步骤3:知识库设置

在知识库设置中,你可以调整以下参数:

- 知识库名称和描述:修改基本信息

- 文件管理:添加或删除知识库中的文件

- 检索设置:调整检索相关度阈值(默认0.7)

- 引用格式:设置引用信息的显示方式

- 权限设置:配置知识库的访问权限

3. 在对话中使用知识库

步骤1:创建新对话

- 返回LobeChat主界面

- 点击"新对话"按钮

- 选择想要使用的AI模型(如GPT-4o、Claude 3等)

步骤2:添加知识库到对话

- 在对话设置中,找到"知识库"选项

- 勾选你想要在对话中使用的知识库

- 点击"确认"按钮

步骤3:基于知识库提问

- 在聊天输入框中,输入与知识库内容相关的问题

- AI将自动检索知识库中的相关信息

- 回答将基于知识库内容,并附带引用来源

- 你可以继续提问或要求AI解释更多细节

【进阶应用】LobeChat知识库高级使用技巧与优化方案

掌握基础使用后,让我们探索一些高级技巧,充分发挥知识库的潜力:

1. 知识库优化策略

文档分类与组织

为获得最佳效果,建议将文档按主题或用途分为多个知识库:

- 按领域分类:如"技术文档"、"市场资料"、"人力资源"等

- 按项目分类:每个项目或产品创建单独的知识库

- 按时效性分类:将常用资料与档案资料分开管理

这样做的好处是提高检索精确度,避免不相关内容干扰答案质量。

文档预处理技巧

上传前对文档进行适当预处理,可以显著提升知识库质量:

- 清理格式:移除不必要的表头、页眉页脚和装饰元素

- 添加结构:确保文档有清晰的标题层级和章节划分

- 简化内容:删除重复信息,保持内容简洁明了

- 优化图表:为图表添加文字描述,便于AI理解

💡 最佳实践

将长篇PDF报告按章节拆分成多个小文件再上传,每个文件保持在10-20页内,这样可以提高系统的文本分割精度和检索准确度。

2. 提示词工程:让知识库回答更精准

使用以下提示词技巧,显著提升知识库回答质量:

明确问题边界

基于提供的知识库内容,请回答以下问题:[具体问题]

仅使用知识库中的信息,如果知识库没有相关内容,请明确告知。

引导答案格式

在回答以下问题时,请首先总结核心观点,然后提供3-5个支持要点,最后给出基于知识库的建议:

[具体问题]

比较分析请求

根据知识库信息,请比较[概念A]和[概念B]的异同点,并以表格形式呈现关键差异。

数据提取与分析

请从知识库中提取关于[主题]的所有数据指标,并进行简要分析,指出关键趋势和洞见。

3. 多模型协同:不同场景选择合适的模型

LobeChat支持多种AI模型,不同模型在知识库应用中各有优势:

| 模型 | 知识库应用优势 | 适用场景 |

|---|---|---|

| GPT-4o | 复杂推理能力强,可处理多种数据格式 | 研究分析、深度解读技术文档 |

| Claude 3.5 | 长文本理解优秀,引用准确性高 | 法律文件、学术论文、详细手册 |

| GPT-3.5 | 响应速度快,成本低 | 简单查询、基础问答、日常文档 |

| 本地Ollama模型 | 完全私密,无需联网 | 高度敏感数据、离线环境 |

4. API集成开发:扩展知识库应用场景

高级用户可以通过API集成,将LobeChat知识库能力集成到其他应用中:

RESTful API调用示例

javascript// 使用LobeChat知识库API进行查询的示例代码

async function queryKnowledgeBase(question, knowledgeBaseId) {

const response = await fetch('http://your-lobechat-server:3210/api/knowledge/query', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer your_access_token'

},

body: JSON.stringify({

question,

knowledgeBaseId,

modelName: 'gpt-4o',

temperature: 0.3,

maxTokens: 1500

})

});

return await response.json();

}

// 使用示例

const answer = await queryKnowledgeBase(

'公司的退款政策是什么?',

'kb-12345678'

);

console.log(answer);

网页应用集成

javascript// 在前端应用中嵌入LobeChat知识库查询组件

import { KnowledgeBaseWidget } from 'lobechat-sdk';

function SupportPage() {

return (

<div className="support-container">

<h1>产品支持中心</h1>

<KnowledgeBaseWidget

serverUrl="http://your-lobechat-server:3210"

knowledgeBaseId="kb-12345678"

apiKey="your_api_key"

placeholder="有问题吗?问问我们的AI助手..."

theme="light"

/>

</div>

);

}

【常见问题】LobeChat知识库FAQ

Q1: 上传的文件有大小或数量限制吗?

A1: LobeChat默认配置下,单个文件大小限制为50MB,知识库文件总数没有硬性限制,但建议每个知识库控制在50个文件以内以保持性能。对于大型文档,建议先拆分为多个小文件再上传,这样不仅能规避大小限制,还能提高检索准确性。

Q2: 知识库支持哪些文件格式?

A2: LobeChat知识库目前支持以下文件格式:

- 文档:PDF、DOCX、DOC、TXT、MARKDOWN、MDX

- 表格:XLSX、XLS、CSV

- 演示:PPTX、PPT

- 代码:JSON、JS、TS、HTML、CSS、JAVA、PYTHON等编程语言文件

- 其他:RTF、XML等

图片、音频和视频文件可以上传但目前无法用于知识库检索。

Q3: 我的文档包含敏感信息,数据安全吗?

A3: LobeChat本地部署的知识库在数据安全方面有以下保障:

- 所有文档存储在你控制的服务器或数据库中

- 文档处理和向量化在本地完成,不会发送完整文档到模型提供商

- 向量检索完全在本地数据库中进行

- 只有检索到的少量相关文本片段会作为上下文发送给AI模型

如果使用OpenAI等第三方服务进行向量化,会发送文本块而非完整文档,可以通过使用本地嵌入模型完全避免数据外传。

Q4: 知识库回答不够准确或相关性不高,如何改进?

A4: 提高知识库回答质量的几种方法:

- 调整知识库检索设置中的"相关度阈值",提高到0.75-0.85

- 优化文档结构,确保信息分布清晰

- 尝试使用不同模型,如从GPT-3.5升级到GPT-4o或Claude

- 提问时更加具体,明确表达需求

- 使用更高质量的嵌入模型进行向量化

Q5: 为什么文件上传后显示"向量化失败"?

A5: 向量化失败的常见原因及解决方案:

- API密钥问题:确认OpenAI API密钥正确且有足够额度

- 网络问题:如果使用官方API,可能存在网络限制,建议使用laozhang.ai中转服务

- 文件格式问题:某些PDF可能是扫描图片,文本无法提取,尝试使用OCR工具预处理

- 文件内容过大:尝试拆分文件后重新上传

- 数据库配置问题:检查PostgreSQL的pgvector扩展是否正确安装

Q6: 如何在多用户环境中共享知识库?

A6: LobeChat支持在多用户环境中共享知识库:

- 确保使用服务端数据库部署模式

- 启用多用户功能(设置环境变量

NEXT_PUBLIC_ENABLE_MULTI_USER=1) - 在知识库设置中,选择"共享给所有用户"选项

- 其他用户登录后即可在其对话中使用共享的知识库

【总结】LobeChat知识库:让AI真正理解你的内容

通过本文的指导,你现在应该能够成功部署和使用LobeChat的知识库功能,让AI助手基于你的私有文档回答问题。让我们回顾一下关键要点:

- 技术基础:LobeChat知识库基于RAG技术,将文档转化为AI可检索的向量形式

- 部署选择:从Docker一键部署到Vercel集成,多种方案满足不同需求

- 基础使用:文件上传、知识库创建和在对话中应用的完整流程

- 高级技巧:文档预处理、提示词优化和多模型选择的进阶策略

- 安全隐私:完全本地化处理,保障数据安全和隐私

LobeChat知识库功能彻底改变了我们与AI助手的交互方式,从"AI猜测答案"变为"AI基于确切信息回答"。无论是个人学习、团队协作还是企业应用,这都是一次生产力的重大飞跃。

🌟 最终建议:从小型、结构化的文档集合开始实验,逐步扩展到更大的知识库。同时,使用laozhang.ai的API中转服务,不仅可以解决网络问题,还能降低约40%的成本,获得更稳定的体验。点此注册即可获得免费体验额度,开始你的知识库之旅!

【更新日志】持续优化的见证

plaintext┌─ 更新记录 ───────────────────────────┐ │ 2025-04-15:首次发布完整知识库指南 │ │ 2025-04-10:测试最新版本兼容性 │ │ 2025-04-05:收集社区实际应用案例 │ └───────────────────────────────────────┘

🎉 特别提示:本文将随LobeChat的更新持续更新,建议收藏本页面,定期查看最新内容!