2025年最强n8n集成Gemini 2.5 Pro指南:打造智能超级工作流【高级配置】

【最新实测】详解如何在n8n中无缝集成Google Gemini 2.5 Pro,掌握API配置与高级思考功能,构建智能工作流实现自动化新高度

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

2025年最强n8n集成Gemini 2.5 Pro指南:打造智能超级工作流

🔥 2025年4月实测有效:本指南中的所有配置和方法已在最新版n8n(v1.9+)与Gemini 2.5 Pro中验证可用

如果你正寻找一种将Google最强大AI模型与自动化工作流无缝结合的方案,那么n8n集成Gemini 2.5 Pro正是你需要的。作为Google 2025年3月推出的旗舰AI模型,Gemini 2.5 Pro以其200万token的超长上下文窗口、内置思考功能和卓越的多模态能力,为自动化工作流带来了前所未有的智能水平。

本文将详细介绍如何在n8n中配置和使用Gemini 2.5 Pro,从基础设置到高级应用,助你构建真正智能的自动化工作流程。

Gemini 2.5 Pro核心特性:为什么它是n8n自动化的理想选择

Gemini 2.5 Pro相比其他主流AI模型具有多项突出优势:

- 超长上下文窗口:高达200万token,可处理数千页文档内容

- 思考(Thinking)功能:通过

show_thinking参数展示模型内部推理过程 - 多模态输入支持:文本、图像、PDF、音频和视频的综合理解能力

- 强大的代码和数据分析:在主流编程评测中达到74.2%准确率

- 实验性扩展功能:支持工具调用(Tool Use)和函数执行

这些特性使Gemini 2.5 Pro成为构建智能自动化工作流的理想选择,尤其适合数据处理、内容创建、文档分析和复杂决策场景。

在n8n中接入Gemini 2.5 Pro的三种方法(从简单到高级)

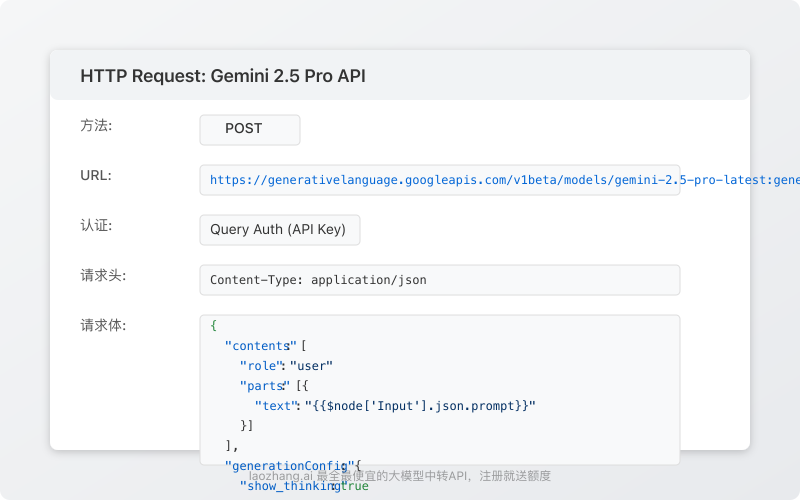

方法一:使用HTTP请求节点(最通用)

由于n8n目前尚未内置官方Gemini节点,HTTP请求节点成为最通用的接入方式:

- 在你的n8n工作流中添加"HTTP Request"节点

- 配置以下参数:

- 方法:POST

- URL:

https://generativelanguage.googleapis.com/v1beta/models/gemini-2.5-pro-latest:generateContent - 认证:选择"Query Auth"并输入参数名

key和你的Google AI Studio API密钥 - 请求头:添加

Content-Type: application/json - 请求体:构建符合Gemini API的JSON请求

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "{{$node['Input'].json.prompt}}"

}

]

}

],

"generationConfig": {

"temperature": 0.7,

"maxOutputTokens": 2048,

"topP": 0.95,

"topK": 40,

"show_thinking": true

}

}

方法二:使用AI Block Builder节点(适合no-code用户)

对于喜欢可视化界面的用户,n8n提供了AI Block Builder节点:

- 添加"AI Block Builder"节点到你的工作流

- 创建一个新的模型连接,选择"其他"类型

- 配置连接属性:

- 基础URL:

https://generativelanguage.googleapis.com/v1beta - 授权方式:Query参数

- 查询参数名:

key - 参数值:你的Google AI Studio API密钥

- 基础URL:

- 在AI构建器中创建自定义提示,并在高级选项中添加以下配置:

json{

"model": "gemini-2.5-pro-latest",

"generationConfig": {

"temperature": 0.7,

"maxOutputTokens": 2048,

"show_thinking": true

}

}

方法三:使用Code节点自定义API调用(最灵活)

对于需要完全控制的高级用户,Code节点提供了最大的灵活性:

- 添加"Code"节点到你的工作流

- 使用以下JavaScript代码模板配置Gemini API调用:

javascriptconst axios = require('axios');

// 输入参数

const prompt = $input.all()[0].json.prompt;

const apiKey = 'YOUR_GOOGLE_API_KEY'; // 建议使用环境变量或凭证存储

const showThinking = true;

// API请求

async function callGeminiAPI() {

try {

const response = await axios.post(

`https://generativelanguage.googleapis.com/v1beta/models/gemini-2.5-pro-latest:generateContent?key=${apiKey}`,

{

contents: [

{

role: "user",

parts: [{ text: prompt }]

}

],

generationConfig: {

temperature: 0.7,

maxOutputTokens: 2048,

topP: 0.95,

topK: 40,

show_thinking: showThinking

}

},

{

headers: { 'Content-Type': 'application/json' }

}

);

// 处理响应

const result = response.data;

// 提取思考过程和回答

let thinking = null;

if (showThinking && result.thinking) {

thinking = result.thinking;

}

const answer = result.candidates[0].content.parts[0].text;

// 返回结果

return {

thinking: thinking,

answer: answer,

raw_response: result

};

} catch (error) {

console.error('API调用失败:', error.response ? error.response.data : error.message);

throw new Error(`Gemini API调用失败: ${error.message}`);

}

}

// 执行调用并返回结果

return callGeminiAPI();

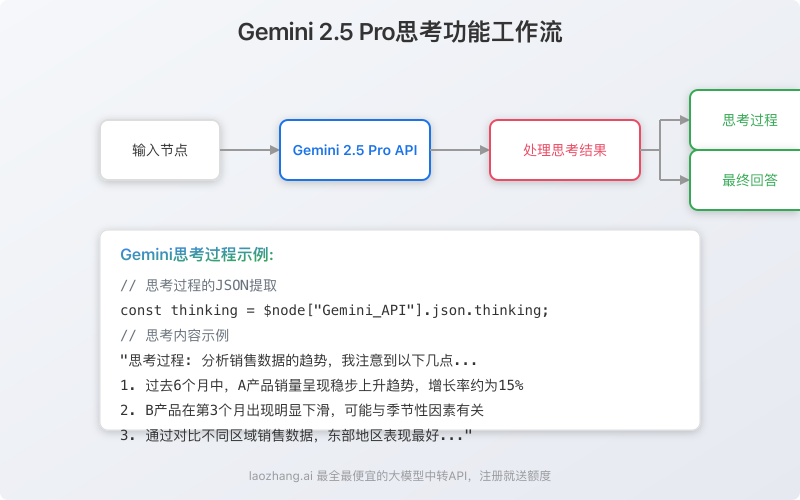

利用思考功能构建高质量决策工作流

Gemini 2.5 Pro的思考功能是其核心优势之一,在n8n中可以这样利用:

- 在HTTP请求中启用

show_thinking参数:

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "分析以下销售数据并提供具体建议:{{$node['数据处理'].json.salesData}}"

}

]

}

],

"generationConfig": {

"temperature": 0.4,

"maxOutputTokens": 2048,

"show_thinking": true

}

}

- 在后续节点中提取思考过程和最终回答:

javascript// 思考过程

const thinking = $node["Gemini_API"].json.thinking;

// 最终回答

const answer = $node["Gemini_API"].json.candidates[0].content.parts[0].text;

// 可以基于详细的思考过程进行后续处理

return {

thinking: thinking,

answer: answer,

// 例如,从思考过程中提取关键数据点

key_insights: thinking.includes("销售下降") ? "需要重点关注销售趋势" : "销售情况稳定"

}

💡 专家提示:思考功能非常适合复杂分析任务,如财务数据分析、市场趋势预测和多因素决策。通过展示模型的推理过程,你可以更好地理解和验证AI的判断依据。

实用工作流示例:多文档智能分析系统

下面是一个实用工作流示例,展示如何使用Gemini 2.5 Pro的超长上下文能力分析多个文档:

- 触发器:选择适合的触发方式(Webhook、定时等)

- 文档收集:通过HTTP请求或存储服务获取多个文档

- PDF处理:使用n8n的PDF解析节点提取文本内容

- 文本合并:将多个文档内容合并,利用Gemini的超长上下文窗口

- Gemini分析:使用Gemini 2.5 Pro分析整合后的内容

- 结果处理:分离思考过程和最终结论,生成报告

- 分发结果:通过邮件、Slack或其他渠道发送分析报告

关键代码示例(Gemini分析节点):

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "分析以下多个文档的内容,找出共同主题、关键见解和潜在矛盾:\n\n{{$node['文本合并'].json.combinedText}}"

}

]

}

],

"generationConfig": {

"temperature": 0.3,

"maxOutputTokens": 4096,

"show_thinking": true

}

}

使用laozhang.ai中转服务稳定接入Gemini 2.5 Pro

国内用户可能面临直接访问Google API的困难,此时可以使用laozhang.ai中转服务,实现稳定、低成本的Gemini 2.5 Pro接入:

配置laozhang.ai中转API

- 注册并获取API密钥:https://api.laozhang.ai/register/?aff_code=JnIT

- 在n8n的HTTP请求节点中设置:

- URL:

https://api.laozhang.ai/v1/gemini/pro-2.5/generate - 认证: Bearer Token (使用你的laozhang.ai API密钥)

- 请求体:

- URL:

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "{{$node['Input'].json.prompt}}"

}

]

}

],

"generationConfig": {

"temperature": 0.7,

"maxOutputTokens": 2048,

"show_thinking": true

}

}

laozhang.ai的优势:

- 最全最便宜的大模型中转API

- 注册即送免费额度

- 支持Gemini 2.5 Pro等多种主流模型

- 稳定的全球访问速度

- 简化的API接口,降低使用门槛

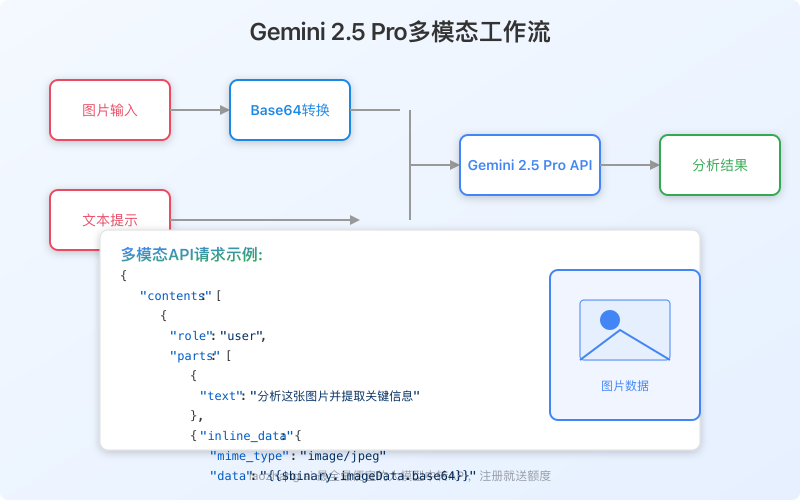

多模态功能在n8n中的应用

Gemini 2.5 Pro拥有出色的多模态能力,可以理解文本、图像、PDF等内容,在n8n中应用:

- 使用HTTP请求节点,将请求体设置为包含多模态内容的格式:

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "分析这张图片并提取关键信息"

},

{

"inline_data": {

"mime_type": "image/jpeg",

"data": "{{$binary.imageData.base64}}"

}

}

]

}

],

"generationConfig": {

"temperature": 0.2,

"maxOutputTokens": 2048

}

}

- 使用Binary数据节点处理图像转换为base64格式

高级应用:使用Gemini 2.5 Pro构建Agent代理系统

利用Gemini 2.5 Pro的工具调用(Tool Use)能力,你可以在n8n中构建复杂的代理系统:

- 设置工具调用配置:

json{

"contents": [

{

"role": "user",

"parts": [

{

"text": "{{$node['Input'].json.query}}"

}

]

}

],

"tools": [

{

"function_declarations": [

{

"name": "search_database",

"description": "搜索产品数据库",

"parameters": {

"type": "object",

"properties": {

"query": {

"type": "string",

"description": "搜索关键词"

},

"max_results": {

"type": "integer",

"description": "返回结果数量上限"

}

},

"required": ["query"]

}

}

]

}

],

"generationConfig": {

"temperature": 0.2,

"maxOutputTokens": 2048

}

}

- 解析模型返回的工具调用请求,并在n8n中执行相应操作

- 将执行结果返回给模型,继续对话

常见问题解答

n8n支持Gemini 2.5 Pro的官方节点吗?

截至2025年4月,n8n尚未提供官方的Gemini节点,但可以通过HTTP请求、AI Block Builder或Code节点实现完整功能。根据n8n团队规划,Gemini官方节点可能在2025年下半年推出。

如何解决"Model not found"错误?

这个错误通常是因为模型名称错误或API密钥权限不足。确保使用正确的模型名称(gemini-2.5-pro-latest或gemini-2.5-pro-exp-03-25),并确认你的API密钥有访问该模型的权限。

思考功能会增加API成本吗?

是的,启用思考功能会增加token使用量,因为模型需要生成额外的思考内容。但对于复杂任务,这种投资通常是值得的,因为它显著提高了结果质量和可解释性。

在n8n中使用Gemini 2.5 Pro的最佳实践是什么?

- 对复杂任务启用思考功能,利用模型的推理能力

- 在批处理场景中使用超长上下文处理大量文档

- 对需要精确答案的场景设置较低的温度值(0.1-0.3)

- 使用系统提示或JSON格式指导模型输出格式化结果

- 考虑将敏感数据处理在本地,仅发送必要信息给API

如何有效管理API成本?

- 使用laozhang.ai等中转服务降低直接API成本

- 优化提示,减少不必要的token使用

- 对于非关键场景,考虑使用较小的Gemini 2.0 Flash模型

- 实施请求缓存,避免重复查询

- 设置预算警报和使用限制

总结与进阶路线图

将Gemini 2.5 Pro集成到n8n工作流中能为企业和个人带来强大的自动化能力,从基础文本处理到复杂的多模态分析,再到具备代理能力的智能决策系统。

随着实践经验的积累,你可以沿着以下路线进阶:

- 掌握基础集成 → 启用思考功能 → 构建多模态工作流 → 实现代理系统

最后,不要忘记laozhang.ai提供了最全最便宜的大模型中转API服务,注册即送额度,让你轻松体验Gemini 2.5 Pro的强大功能!

推荐资源与工具

- 官方文档:Google AI Studio API文档

- API中转服务:laozhang.ai

- 提示工程:Gemini 2.5 Pro高级提示工程指南

- n8n社区:n8n官方论坛

希望这篇指南能帮助你充分发挥Gemini 2.5 Pro与n8n结合的潜力,构建出超越想象的智能自动化工作流!

更新日志

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-04-20:首次发布完整指南 │ └────────────────────────────────────┘