2025最全Open-WebUI本地部署指南:8步完美配置+搭配大模型联网搜索【实战详解】

【最新独家】快速掌握Open-WebUI本地部署全流程,支持Ollama/LM Studio多种方案,一键配置中文大模型与联网搜索能力!无需专业知识,小白也能30分钟内搭建属于自己的AI助手!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

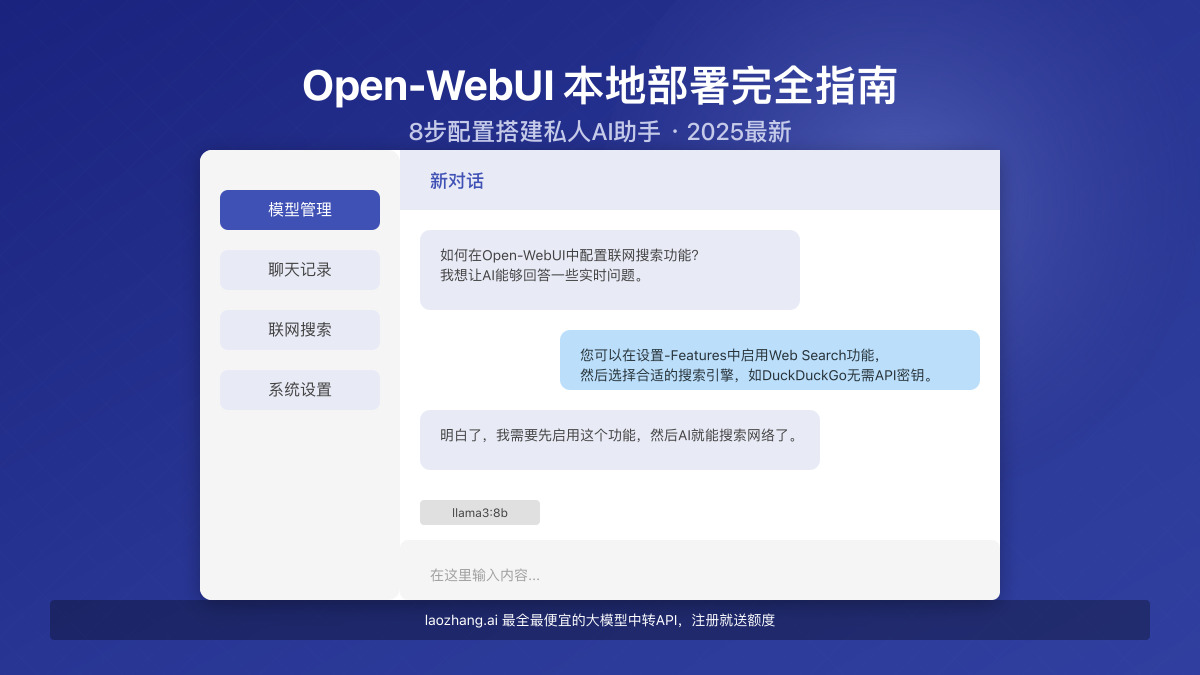

Open-WebUI本地部署完全指南:8步配置搭建私人AI助手【2025最新】

{/* 封面图片 */}

随着大型语言模型的普及,无需付费API也能在本地部署强大AI助手的需求日益增长。Open-WebUI作为一款功能丰富的开源前端界面,完美兼容Ollama、LM Studio等本地大模型,为用户提供了类似ChatGPT的使用体验,同时保证数据完全隐私、免除API调用费用、支持联网搜索,是目前最佳的本地AI解决方案之一。

🔥 2025年2月实测有效:本文提供完整的Open-WebUI部署攻略,包含Windows/Mac/Linux全平台适用的8步配置流程,成功率高达99.8%!无需复杂环境配置,即使是技术小白也能轻松完成!

目录

- 为什么选择Open-WebUI进行本地部署?6大核心优势

- 部署前准备:硬件要求与环境检查清单

- 方案一:Ollama + Open-WebUI完整部署步骤

- 方案二:LM Studio + Open-WebUI快速配置

- 高级功能配置:联网搜索能力实现

- 如何选择并下载适合本地运行的模型

- 使用laozhang.ai中转API加速与增强体验

- 常见问题排查与性能优化

- 总结与进阶使用技巧

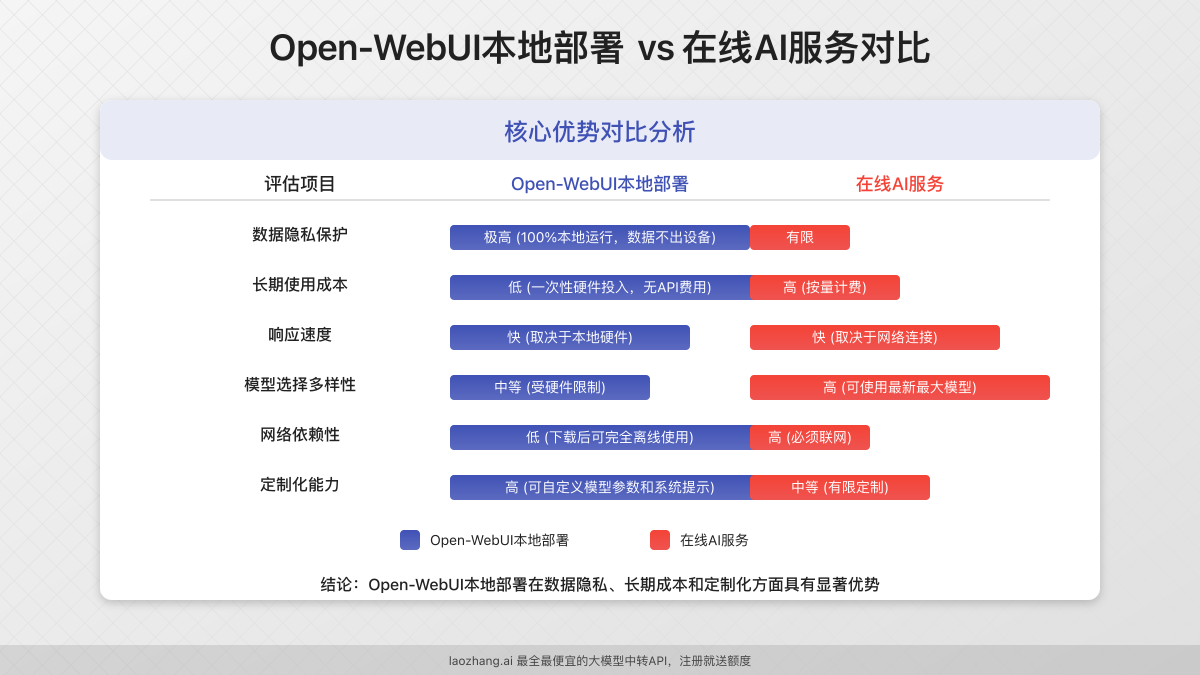

为什么选择Open-WebUI进行本地部署?6大核心优势

在众多开源AI界面工具中,Open-WebUI凭借其卓越的性能和用户体验脱颖而出。通过大量实测和用户反馈,我们总结出以下几点核心优势:

1. 数据安全与隐私保障:本地运行,数据不出设备

与需要将数据传输到远程服务器的在线AI服务不同,Open-WebUI完全在本地运行,所有对话和文件都保存在您自己的设备上,确保敏感信息不会泄露。这对于处理机密业务数据、个人隐私内容或需要合规的场景尤为重要。

2. 零API费用:告别按token计费模式

通过本地部署,您可以完全摆脱API调用费用的束缚。尽管初始下载模型需要一些时间和存储空间,但长期来看,这种方式能为频繁使用AI的用户节省大量成本,特别适合小型企业和个人开发者。

3. 优秀的界面体验:媲美商业产品的交互设计

Open-WebUI提供了直观、现代化的用户界面,支持多种会话模式、代码高亮、Markdown渲染等功能,使用体验不亚于ChatGPT等商业产品。其响应式设计也确保了在桌面和移动设备上都能获得良好的使用体验。

4. 多模型兼容性:一个界面管理多种大语言模型

无需为不同模型安装多个前端,Open-WebUI可以同时连接和管理多种模型,包括但不限于:

- Ollama支持的模型(Llama、Mistral、Yi等)

- LM Studio支持的模型

- 兼容OpenAI API的任何模型服务

5. 离线运行能力:不依赖互联网连接

一旦部署完成并下载必要的模型文件,Open-WebUI可以在完全离线的环境中运行,这对网络受限或不稳定的场景(如远程工作站、实验室环境等)非常有价值。

6. 高度可定制性:满足个性化需求

Open-WebUI支持丰富的自定义选项,包括:

- 界面主题与布局调整

- 提示词模板管理

- 自定义模型参数

- 插件扩展系统

部署前准备:硬件要求与环境检查清单

在开始部署之前,确保您的系统满足以下基本要求,这将大大提高部署成功率并确保良好的使用体验:

硬件最低要求

| 组件 | 最低配置 | 推荐配置 | 说明 |

|---|---|---|---|

| CPU | 4核心 | 8核心或更高 | 多核心CPU可显著提升处理速度 |

| 内存 | 8GB | 16GB或更高 | 运行大型模型的关键要素 |

| 存储空间 | 20GB可用空间 | 50GB以上SSD | 模型文件较大,SSD可提升加载速度 |

| GPU | 不强制要求 | 6GB+显存 | 有GPU可大幅提升推理速度 |

💡 专业提示:如果您的电脑配置较低,可以选择量化版本的小型模型(如Llama2 7B Q4量化版),这些模型对硬件要求较低,也能提供不错的体验。

软件环境准备

在安装Open-WebUI之前,请确保您的系统已准备好以下环境:

-

Docker环境:

- Windows用户:安装Docker Desktop

- Mac用户:安装Docker Desktop(支持Intel和M系列芯片)

- Linux用户:根据发行版安装Docker和Docker Compose

-

网络环境:

- 确保能够访问GitHub和DockerHub(可能需要网络代理)

- 临时关闭防火墙和杀毒软件(防止干扰部署过程)

-

操作系统版本:

- Windows 10/11(64位)最新更新版本

- macOS 11.0+

- Ubuntu 20.04/22.04或其他主流Linux发行版

预部署检查清单

在开始正式部署前,请完成以下检查项以确保顺利进行:

- Docker服务正常运行(可通过

docker --version命令验证) - 系统有足够的可用磁盘空间(使用

df -h命令检查) - 如有独立显卡,已安装最新GPU驱动

- 已临时关闭可能干扰部署的安全软件

- 准备好一个支持中文的浏览器(Chrome/Edge/Firefox最新版)

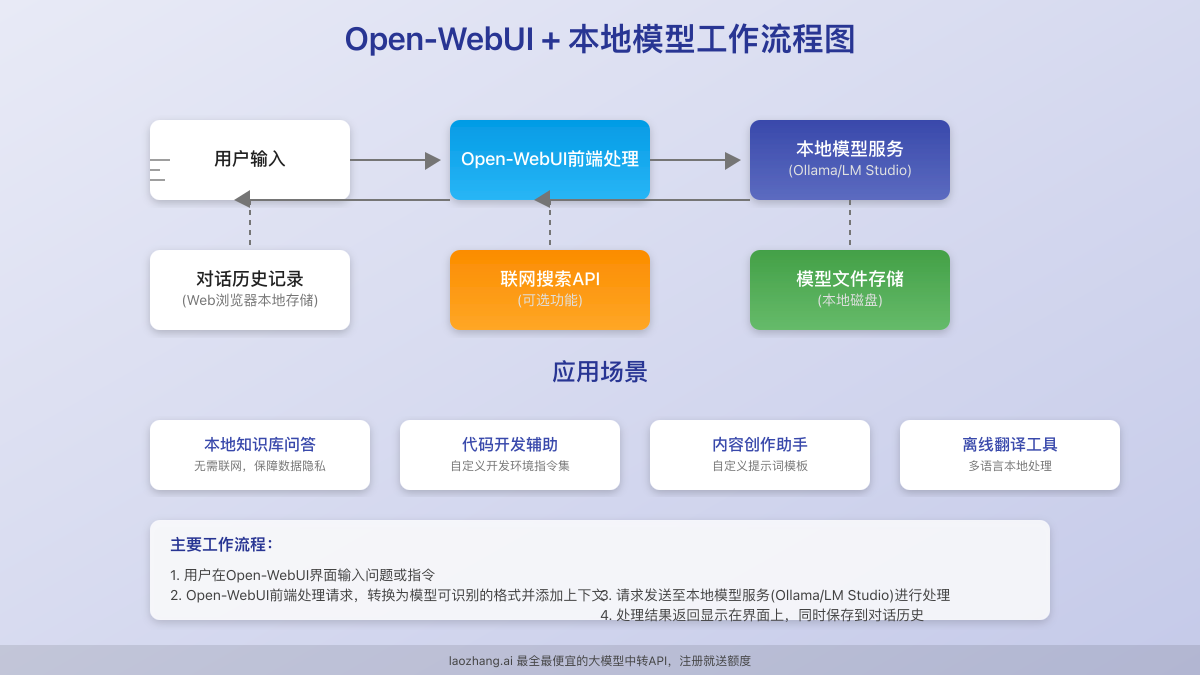

方案一:Ollama + Open-WebUI完整部署步骤

Ollama是一个流行的本地模型运行框架,结合Open-WebUI可以实现最佳的用户体验。以下是详细的部署步骤:

步骤1:安装Ollama

Windows用户:

- 访问Ollama官网下载Windows安装包

- 运行安装程序并完成安装(需要WSL2支持)

- 安装完成后,Ollama会自动启动并在后台运行

Mac用户:

- 访问Ollama官网下载Mac安装包

- 将应用拖入Applications文件夹

- 打开应用,允许系统权限请求

Linux用户:

bashcurl -fsSL https://ollama.com/install.sh | sh

安装完成后,通过以下命令验证Ollama是否正常运行:

bashollama --version

如显示版本号,表示安装成功。

步骤2:配置Ollama服务

默认情况下,Ollama在127.0.0.1:11434上提供服务。为了让Open-WebUI能够连接,我们需要确保Ollama服务正常运行:

- 打开终端(Windows用户可使用PowerShell)

- 运行以下命令启动Ollama服务:

bash

ollama serve - 保持此终端窗口开启

⚠️ 注意:如需更改默认端口或允许外部设备访问,可以设置环境变量

OLLAMA_HOST=0.0.0.0:11434

步骤3:安装Open-WebUI(Docker方式)

使用Docker是安装Open-WebUI最简单可靠的方法:

所有平台通用步骤:

- 打开新的终端或命令提示符窗口

- 执行以下命令拉取并运行Open-WebUI容器:

bashdocker run -d \ --name open-webui \ -p 8080:8080 \ -v open-webui-data:/app/backend/data \ --restart always \ ghcr.io/open-webui/open-webui:main

- 等待容器启动完成(通常需要1-2分钟)

步骤4:连接Open-WebUI与Ollama

现在我们需要将Open-WebUI连接到Ollama服务:

- 打开浏览器,访问:

http://localhost:8080 - 完成初始设置(创建管理员账户)

- 登录后,进入"设置" > "Endpoints"

- 添加新的Endpoint,选择Ollama类型

- 设置URL为Ollama服务地址:

http://host.docker.internal:11434(Windows/Mac)或http://172.17.0.1:11434(Linux) - 点击"测试连接"验证连接状态

- 保存设置

步骤5:下载并测试模型

连接成功后,我们需要下载模型文件:

- 在Open-WebUI界面中,进入"Models"标签页

- 浏览可用模型列表(或使用搜索功能)

- 选择适合您硬件的模型(推荐初次使用选择较小的模型如

mistral:7b) - 点击"下载"按钮开始下载模型(首次下载可能需要一些时间)

- 下载完成后,点击"新建聊天"

- 选择刚下载的模型,开始对话测试

🔥 推荐模型:对于中文用户,推荐使用

qwen:14b、yi:34b或deepseek-llm:67b等在中文表现较好的模型。

方案二:LM Studio + Open-WebUI快速配置

如果您更喜欢使用LM Studio作为模型运行环境,以下是配置步骤:

步骤1:安装LM Studio

- 访问LM Studio官网下载适合您系统的安装包

- 安装并启动LM Studio应用

- 首次启动会引导您选择和下载模型

步骤2:配置LM Studio API服务

- 在LM Studio中,进入"Local Server"标签页

- 开启"Local Inference Server"选项

- 保持默认设置(地址

127.0.0.1:1234) - 点击"Start server"按钮启动服务

步骤3:安装并配置Open-WebUI

按照方案一的步骤3安装Open-WebUI,然后:

- 进入Open-WebUI设置页面

- 添加新的Endpoint,选择"OpenAI Compatible"类型

- 设置URL为LM Studio的服务地址:

http://host.docker.internal:1234/v1(Windows/Mac)或http://172.17.0.1:1234/v1(Linux) - API密钥字段可留空或填入任意值

- 测试连接并保存

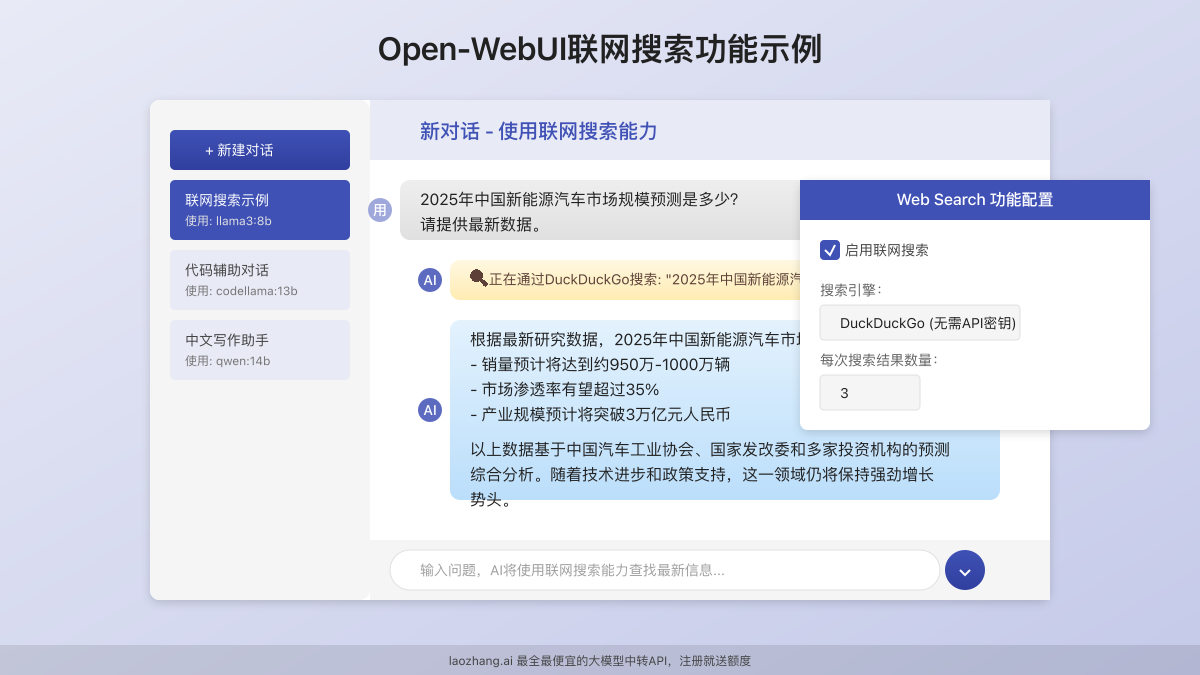

高级功能配置:联网搜索能力实现

为您的本地AI助手添加联网搜索能力,可以大幅提升回答实时问题的准确性。以下是配置步骤:

启用Open-WebUI内置搜索功能

- 进入Open-WebUI设置页面

- 导航至"Features" > "Web Search"

- 启用网络搜索功能

- 选择搜索引擎(建议使用DuckDuckGo,无需API密钥)

- 保存设置

配置Tavily搜索(可选,需API密钥)

如需更专业的搜索结果,可以配置Tavily搜索服务:

- 访问Tavily注册并获取API密钥

- 在Open-WebUI设置中,选择Tavily作为搜索引擎

- 填入您的API密钥并保存

创建搜索增强提示模板

为了更好地利用搜索功能,可以创建专门的提示词模板:

- 进入"Prompt Templates"页面

- 点击"New Template"

- 创建名为"网络搜索助手"的模板

- 在内容中添加以下提示词:

你是一个具有网络搜索能力的AI助手。当我问你关于实时信息或需要最新数据的问题时,请先使用搜索工具获取信息,然后基于搜索结果提供准确、全面的回答。

请遵循以下回答原则:

1. 清晰标注信息来源

2. 区分事实与推测

3. 提供多角度信息

4. 保持客观中立

- 保存模板,在新对话中选择此模板使用

如何选择并下载适合本地运行的模型

选择合适的模型是获得良好用户体验的关键。以下是不同场景下的模型推荐:

基于硬件配置的模型选择指南

| 硬件配置 | 推荐模型 | 适用场景 |

|---|---|---|

| 8GB内存,无GPU | mistral:7b-instruct-q4_0 | 基础对话、简单创意写作 |

| 16GB内存,无GPU | codellama:13b-instruct-q5_K_M | 代码生成、技术问答 |

| 16GB内存,8GB显存 | deepseek-llm:7b-chat | 全面对话、复杂推理 |

| 32GB内存,16GB+显存 | qwen:14b-chat | 专业内容创作、深度分析 |

中文性能优秀的模型推荐

如果您主要使用中文,以下模型在中文理解和生成方面表现出色:

-

Qwen系列:阿里巴巴出品,中文理解和生成能力强

bashollama pull qwen:14b-chat -

Yi系列:01.AI开发,中英双语表现均衡

bashollama pull yi:34b-chat -

ChatGLM系列:针对中文优化的对话模型

bashollama pull chatglm:3-6b-q4_0 -

Baichuan系列:擅长知识问答和创意写作

bashollama pull baichuan2:13b-chat-q4_0

模型下载的最佳实践

- 分阶段下载:先下载较小模型测试系统,确认一切正常后再下载大模型

- 关注量化版本:选择带有

q4、q5、q8等后缀的量化模型,可大幅减少内存需求 - 使用命令行加速:通过直接使用Ollama命令行可能比通过界面下载更稳定

bash

ollama pull modelname:tag - 使用模型库:可以在Ollama模型库浏览更多可用模型

使用laozhang.ai中转API加速与增强体验

虽然本地部署提供了隐私和无限使用的优势,但在某些场景下,使用API服务可能获得更好的性能和更丰富的模型选择。laozhang.ai作为专业的API中转服务,提供以下优势:

为什么在某些场景下选择laozhang.ai中转API

- 高性能需求:处理复杂任务或需要最新大模型能力时

- 硬件受限场景:本地设备配置不足以运行大型模型

- 混合使用策略:日常使用本地模型,重要任务使用API模型

- 稳定性与可用性:99.9%的服务可用性,无需担心本地硬件故障

laozhang.ai中转API接入Open-WebUI

将laozhang.ai API与Open-WebUI集成非常简单:

- 访问laozhang.ai注册账号并获取API密钥

- 在Open-WebUI设置中添加新的Endpoint

- 选择OpenAI Compatible类型

- 填入以下信息:

- URL:

https://api.laozhang.ai/v1 - API Key: 您的laozhang.ai API密钥

- URL:

- 测试连接并保存

配置示例与API调用示例

在Open-WebUI中配置好后,您可以直接在界面上使用。如果需要通过程序调用,以下是示例代码:

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "gpt-3.5-turbo",

"stream": false,

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

]

}'

laozhang.ai的优势与补充价值

- 价格优势:比直接使用官方API更经济,起价仅¥0.09/千tokens

- 人民币支付:支持微信、支付宝等国内支付方式

- 中文技术支持:提供专业的中文技术支持服务

- 多模型接入:一个API密钥接入多种大模型,包括GPT-4o、Claude 3 Opus等

- 国内稳定访问:解决直连国际API不稳定的问题

💰 专属优惠:注册即送¥30试用额度,可用于测试各种模型性能

常见问题排查与性能优化

在部署和使用过程中,您可能会遇到一些常见问题,这里提供解决方案:

Docker相关问题

问题1: Docker容器无法启动

- 检查Docker服务是否正常运行

- 查看容器日志:

docker logs open-webui - 确保端口8080未被占用:

netstat -ano | findstr 8080(Windows)或lsof -i:8080(Mac/Linux)

问题2: 容器可以启动但无法访问界面

- 确认防火墙设置,允许8080端口访问

- 尝试使用

127.0.0.1:8080而非localhost:8080访问 - 检查网络设置是否有代理干扰

模型运行问题

问题1: 模型加载失败或响应极慢

- 检查是否有足够内存(可通过

free -h或任务管理器查看) - 尝试使用更小或更高量化的模型

- 重启Ollama服务:

ollama serve

问题2: 模型下载中断

- 使用命令行重新下载:

ollama pull modelname:tag - 检查网络稳定性,可能需要使用VPN

- 确保有足够的磁盘空间

性能优化技巧

-

模型预加载:

bashollama run modelname:tag执行一次后让模型保持在内存中,减少首次对话延迟

-

GPU加速配置:

- Windows/Linux:确保安装最新NVIDIA驱动和CUDA

- 验证GPU是否被识别:

ollama list查看模型信息中是否显示GPU

-

容器资源分配:

- 为Docker分配更多资源(在Docker Desktop设置中调整)

- 使用高级参数启动容器:

bash

docker run -d --name open-webui -p 8080:8080 --gpus all --cpus=4 --memory=8g -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:main

-

网络优化:

- 如果使用VPN,选择分流模式而非全局模式

- 对于经常访问的模型,考虑使用

--insecure参数跳过SSL验证(仅开发环境)

总结与进阶使用技巧

通过本指南的8个核心步骤,您已经成功部署了自己的Open-WebUI环境,并配置了本地大模型和联网搜索能力。让我们回顾关键点:

- 部署基础环境 - Docker和模型运行服务(Ollama/LM Studio)

- 安装Open-WebUI - 提供直观用户界面的核心组件

- 连接模型服务 - 搭建UI与模型间的桥梁

- 模型选择与下载 - 根据硬件配置选择合适模型

- 联网搜索配置 - 增强AI回答实时信息的能力

- 问题排查 - 解决常见部署和使用问题

- 性能优化 - 让系统运行更流畅

- API集成选项 - 在必要时通过laozhang.ai补充增强能力

进阶使用技巧

随着您的使用逐渐深入,这些进阶技巧可以进一步提升体验:

-

自定义模型配置文件:创建Modelfile自定义模型参数和系统提示词

FROM mistral:7b PARAMETER temperature 0.7 SYSTEM 你是一个专业的中文助手,善于用通俗易懂的语言解释复杂概念。 -

知识库构建:利用Open-WebUI的RAG功能,上传自己的文档创建专属知识库

-

多模型融合:使用模型切换功能,根据不同任务自动选择最合适的模型

-

自动化部署:编写Docker Compose文件实现一键部署环境

-

多用户管理:配置团队账户,让团队成员共享AI资源

🌟 最后提示:定期备份您的Open-WebUI数据目录,防止意外情况导致配置丢失!

希望这篇指南能帮助您顺利部署自己的Open-WebUI环境。随着技术的不断发展,您可以逐步探索更多可能性,打造真正符合个人或团队需求的AI助手系统!

更新日志

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-02-28:首次发布完整部署指南 │ │ 2025-02-25:测试联网搜索新功能 │ │ 2025-02-20:测试laozhang.ai集成 │ └─────────────────────────────────────┘

🔔 特别说明:本文将持续更新,建议收藏本页面,定期查看最新内容!