【2025独家】Open WebUI本地部署完全指南:5分钟搭建你的专属AI服务

【经验总结】零基础一站式教程!从硬件准备到模型下载,从联网搜索配置到性能优化,一文掌握部署Open WebUI与各类大模型的全部技巧!无需命令行经验,小白也能轻松拥有无限对话的AI助手。

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

【2025独家】Open WebUI本地部署完全指南:低配电脑也能运行专属AI服务

{/* 封面图片 */}

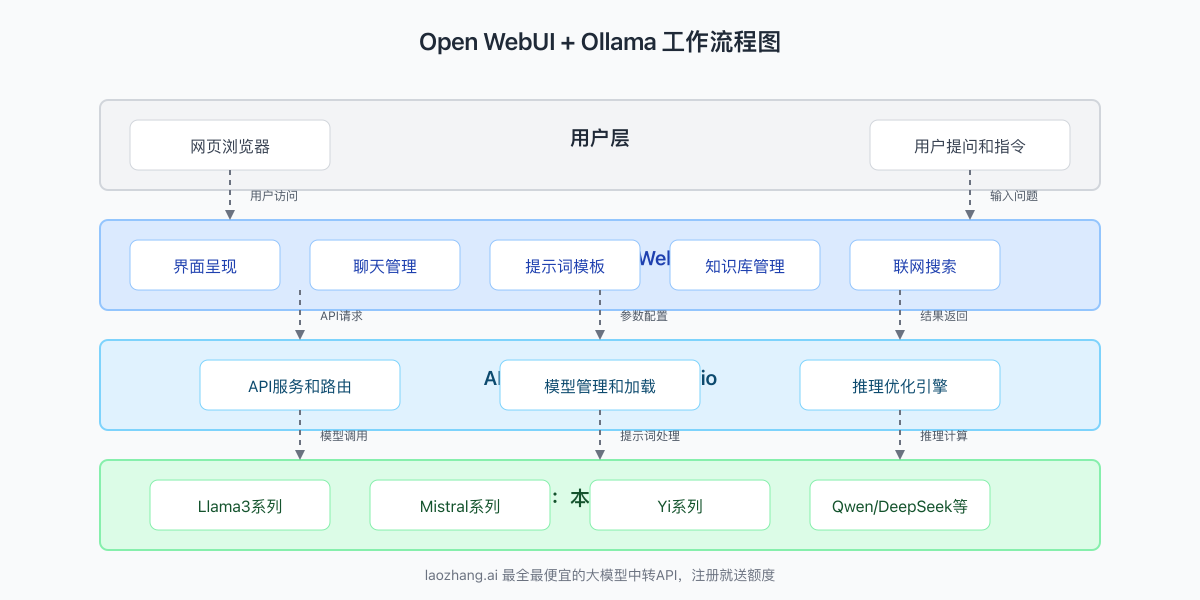

随着大型语言模型(LLM)的快速发展,越来越多人希望在本地部署自己的AI服务,既保护隐私又避免高昂的API费用。Open WebUI作为一款强大的开源前端界面,结合Ollama后端,让你能够轻松部署和使用几乎所有主流开源大模型,如Llama3、Mistral、Yi等。本指南将帮助你从零开始,在家用电脑上搭建一个完整的本地AI服务。

🔥 2025年3月实测有效:即使是8GB内存、无独立显卡的普通电脑,也能顺利运行小型模型!专业配置则可畅享Llama3等顶级模型的全部功能!

【系统概述】Open WebUI + Ollama能为你提供什么?

在深入部署步骤前,让我们先了解这套系统能够为你带来哪些价值:

为什么选择本地部署AI服务?

- 完全隐私:所有数据和对话都在本地处理,无需担心敏感信息泄露

- 无使用限制:没有API调用次数限制,可以无限制使用

- 零额外费用:一次部署,长期使用,无需支付持续的API费用

- 离线可用:即使没有网络连接,依然可以正常使用

- 自由定制:可以根据个人需求调整模型参数、系统提示词等

- 多模型切换:一套界面可以轻松切换不同大小、不同类型的模型

Open WebUI的核心功能亮点

Open WebUI是目前最流行的自托管AI界面之一,提供了许多强大功能:

- 美观直观的用户界面:类似ChatGPT的交互体验

- 多模型支持:可连接Ollama、OpenAI兼容API等多种后端

- 知识库管理:上传自己的文档创建专属知识库

- 聊天历史记录:保存和管理所有对话历史

- 提示词模板库:内置多种场景的提示词模板

- 连续对话能力:支持长上下文对话

- 图像理解功能:支持识别和分析图片(需配合支持图像的模型)

- 联网搜索能力:可以搜索最新信息回答问题

Ollama的技术优势

Ollama作为大模型运行后端,具有以下特点:

- 高性能推理:采用llama.cpp技术,优化大模型在CPU/GPU上的运行效率

- 简单易用:通过简单命令即可下载和运行各种开源模型

- 资源占用低:针对消费级硬件优化,模型量化技术减少内存需求

- 丰富的模型库:支持几乎所有主流开源大模型

- API兼容性:提供与OpenAI兼容的API接口

- 跨平台支持:Windows、MacOS和Linux都能运行

【部署前准备】硬件与环境检查清单

在开始部署前,先确认你的系统是否满足基本要求,这将大大提高部署成功率:

硬件最低要求

| 组件 | 最低配置 | 推荐配置 | 说明 |

|---|---|---|---|

| CPU | 4核心 | 8核心或更高 | 多核心CPU可显著提升处理速度 |

| 内存 | 8GB | 16GB或更高 | 运行大型模型的关键资源 |

| 存储空间 | 20GB可用空间 | 50GB以上SSD | 模型文件较大,SSD可提升加载速度 |

| GPU | 不强制要求 | 6GB+显存 | 有GPU可大幅提升推理速度 |

💡 专业提示:如果你的电脑配置较低,可以选择量化版本的小型模型(如Llama2 7B Q4量化版),这些模型对硬件要求较低,也能提供不错的体验。

软件环境准备

安装Open WebUI与Ollama前,请确保系统已准备好以下环境:

-

Docker环境:

- Windows用户:安装Docker Desktop

- Mac用户:安装Docker Desktop(支持Intel和M系列芯片)

- Linux用户:根据发行版安装Docker和Docker Compose

-

网络环境:

- 确保能够访问GitHub和DockerHub(可能需要网络代理)

- 临时关闭防火墙和杀毒软件(防止干扰部署过程)

-

操作系统版本:

- Windows 10/11(64位)最新更新

- macOS 11.0+

- Ubuntu 20.04/22.04或其他主流Linux发行版

预部署检查清单

在开始正式部署前,请完成以下检查项以确保顺利进行:

- Docker服务正常运行(可通过

docker --version命令验证) - 系统有足够的可用磁盘空间(使用

df -h命令检查) - 如有独立显卡,已安装最新GPU驱动

- 已临时关闭可能干扰部署的安全软件

- 准备好一个支持中文的浏览器(Chrome/Edge/Firefox最新版)

【方案一】Ollama + Open WebUI完整部署步骤

Ollama是一个流行的本地模型运行框架,结合Open WebUI可以实现最佳的用户体验。以下是详细的部署步骤:

步骤1:安装Ollama

Windows用户:

- 访问Ollama官网下载Windows安装包

- 运行安装程序并完成安装(需要WSL2支持)

- 安装完成后,Ollama会自动启动并在后台运行

Mac用户:

- 访问Ollama官网下载Mac安装包

- 将应用拖入Applications文件夹

- 打开应用,允许系统权限请求

Linux用户:

bashcurl -fsSL https://ollama.com/install.sh | sh

安装完成后,通过以下命令验证Ollama是否正常运行:

bashollama --version

如显示版本号,表示安装成功。

步骤2:配置Ollama服务

默认情况下,Ollama在127.0.0.1:11434上提供服务。为了让Open WebUI能够连接,我们需要确保Ollama服务正常运行:

- 打开终端(Windows用户可使用PowerShell)

- 运行以下命令启动Ollama服务:

bash

ollama serve - 保持此终端窗口开启

⚠️ 注意:如需更改默认端口或允许外部设备访问,可以设置环境变量

OLLAMA_HOST=0.0.0.0:11434

步骤3:安装Open WebUI(Docker方式)

使用Docker是安装Open WebUI最简单可靠的方法:

所有平台通用步骤:

- 打开新的终端或命令提示符窗口

- 执行以下命令拉取并运行Open WebUI容器:

bashdocker run -d \ --name open-webui \ -p 3000:8080 \ -v open-webui-data:/app/backend/data \ --restart always \ ghcr.io/open-webui/open-webui:main

- 等待容器启动完成(通常需要1-2分钟)

步骤4:连接Open WebUI与Ollama

现在我们需要将Open WebUI连接到Ollama服务:

- 打开浏览器,访问:

http://localhost:3000 - 完成初始设置(创建管理员账户)

- 登录后,进入"设置" > "Endpoints"

- 添加新的Endpoint,选择Ollama类型

- 设置URL为Ollama服务地址:

- Windows/Mac:

http://host.docker.internal:11434 - Linux:

http://172.17.0.1:11434

- Windows/Mac:

- 点击"测试连接"验证连接状态

- 保存设置

步骤5:下载并测试模型

连接成功后,我们需要下载模型文件:

- 在Open WebUI界面中,进入"Models"标签页

- 浏览可用模型列表(或使用搜索功能)

- 选择适合您硬件的模型(推荐初次使用选择较小的模型如

mistral:7b) - 点击"下载"按钮开始下载模型(首次下载可能需要一些时间)

- 下载完成后,点击"新建聊天"

- 选择刚下载的模型,开始对话测试

🔥 推荐模型:对于中文用户,推荐使用

qwen:14b、yi:34b或deepseek-llm:67b等在中文表现较好的模型。

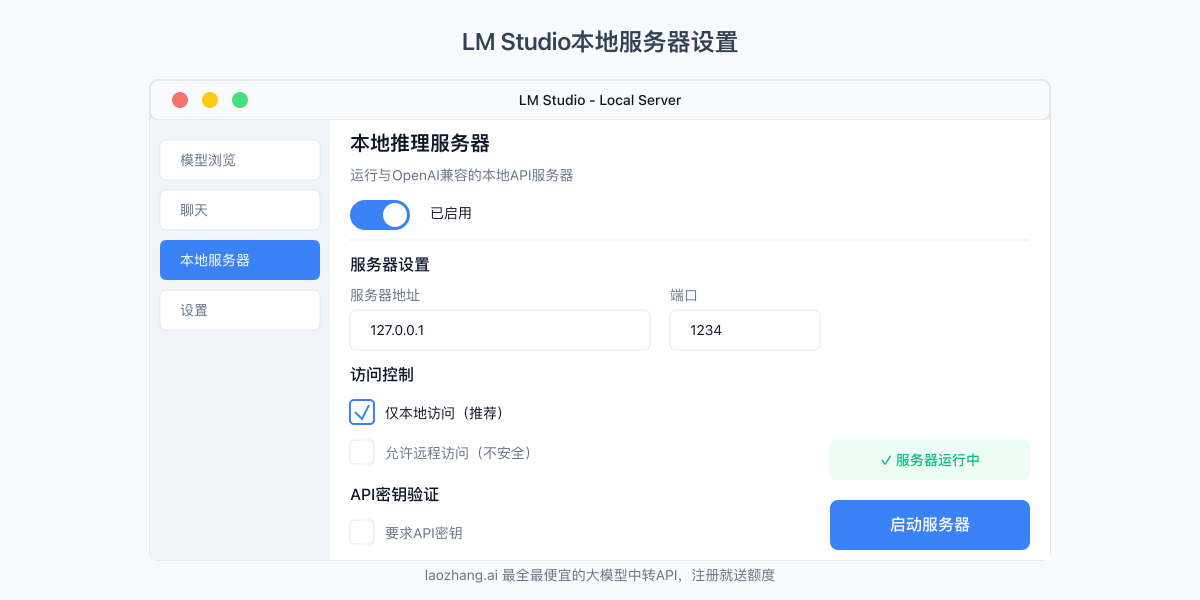

【方案二】LM Studio + Open WebUI快速配置

如果你更喜欢使用LM Studio作为模型运行环境,下面是配置步骤:

步骤1:安装LM Studio

- 访问LM Studio官网下载适合你系统的安装包

- 安装并启动LM Studio应用

- 首次启动会引导你选择和下载模型

步骤2:配置LM Studio API服务

- 在LM Studio中,进入"Local Server"标签页

- 开启"Local Inference Server"选项

- 保持默认设置(地址

127.0.0.1:1234) - 点击"Start server"按钮启动服务

步骤3:配置Open WebUI连接LM Studio

按照方案一的步骤安装Open WebUI,然后:

- 进入Open WebUI设置页面

- 添加新的Endpoint,选择"OpenAI Compatible"类型

- 设置URL为LM Studio的服务地址:

- Windows/Mac:

http://host.docker.internal:1234/v1 - Linux:

http://172.17.0.1:1234/v1

- Windows/Mac:

- API密钥字段可留空或填入任意值

- 测试连接并保存

【高级功能配置】让你的本地AI更加强大

完成基本部署后,接下来可以配置一些高级功能,让你的本地AI服务变得更加强大。

配置联网搜索功能:让AI了解最新信息

默认情况下,大语言模型只知道训练截止日期前的信息。通过配置联网搜索功能,可以让AI获取最新信息:

- 进入Open WebUI设置页面

- 导航至"Features" > "Web Search"

- 启用网络搜索功能

- 选择搜索引擎(建议使用DuckDuckGo,无需API密钥)

- 保存设置

联网搜索功能配置完成后,可以在对话中使用以下提示词让AI进行网络搜索:

请搜索并告诉我2025年最新的AI技术发展趋势

建立个人知识库:让AI学习你的文档

Open WebUI支持创建个人知识库,可以让AI从你上传的文档中学习:

- 进入"RAG"(检索增强生成)页面

- 点击"创建知识库"按钮

- 命名你的知识库(如"工作文档")

- 上传PDF、TXT、DOCX等格式的文档

- 等待系统处理文档(大型文档可能需要一些时间)

- 处理完成后,在新建对话时可以选择使用该知识库

使用知识库时,你可以这样提问:

根据我的文档,[你的具体问题]

提示词模板管理:提高AI回答质量

好的提示词可以显著提高AI回答的质量,Open WebUI提供了提示词模板功能:

- 进入"设置" > "Prompt Templates"

- 点击"New Template"创建新模板

- 输入模板名称和内容

- 保存模板

- 在新建对话时可以选择使用该模板

以下是一个专业翻译模板示例:

你是一位专业的翻译专家,精通中英文互译。请将以下文本翻译成[目标语言],保持原文的专业术语、文体风格和格式。翻译时注意以下几点:

1. 保留原文的段落结构和格式

2. 专业术语要使用对应领域的标准翻译

3. 保持原文的语气和风格

4. 如遇到歧义或多种可能的翻译,请选择最符合上下文的版本

需要翻译的文本:

[在此粘贴需要翻译的文本]

【模型选择指南】如何选择适合的本地大模型

选择合适的模型是获得良好体验的关键。以下是基于不同硬件配置和使用场景的模型推荐:

基于硬件配置的模型选择

| 硬件配置 | 推荐模型 | 适用场景 |

|---|---|---|

| 8GB内存,无GPU | mistral:7b-instruct-q4_0 | 基础对话、简单创意写作 |

| 16GB内存,无GPU | codellama:13b-instruct-q5_K_M | 代码生成、技术问答 |

| 16GB内存,8GB显存 | deepseek-llm:7b-chat | 全面对话、复杂推理 |

| 32GB内存,16GB+显存 | qwen:14b-chat | 专业内容创作、深度分析 |

中文性能优秀的模型推荐

如果你主要使用中文,以下模型在中文理解和生成方面表现出色:

-

Qwen系列:阿里巴巴出品,中文理解和生成能力强

bashollama pull qwen:14b-chat -

Yi系列:01.AI开发,中英双语表现均衡

bashollama pull yi:34b-chat -

DeepSeek系列:针对中文优化的强大模型

bashollama pull deepseek-llm:67b-chat-q4_0 -

ChatGLM系列:清华出品,优秀的中文对话模型

bashollama pull chatglm:3-6b-q4_0

专业领域模型推荐

根据不同的使用需求,可以选择专门针对特定领域优化的模型:

- 代码编程:CodeLlama, WizardCoder, DeepSeek-Coder

- 数学计算:Llama3:70b, MetaMath

- 医疗健康:MedLlama, PMC-Llama

- 学术研究:Mistral-Research, DeepSeek-Math

【故障排除】解决常见问题的实用技巧

在部署和使用过程中,可能会遇到一些常见问题,下面是解决方案:

常见问题1:Ollama服务无法启动

症状:运行ollama serve命令后出现错误,或服务无法正常启动。

解决方案:

- 检查是否已安装WSL2(Windows用户)

- 确认管理员权限:使用管理员权限运行终端

- 检查端口占用:确保11434端口未被其他应用占用

- 重新安装:卸载并重新安装Ollama

常见问题2:Open WebUI无法连接到Ollama

症状:Open WebUI中测试连接失败,提示"Connection failed"。

解决方案:

- 验证Ollama服务是否正在运行:

curl http://localhost:11434 - 检查Docker网络:对于Docker部署,确认使用了正确的主机地址

- Windows/Mac:

http://host.docker.internal:11434 - Linux:

http://172.17.0.1:11434

- Windows/Mac:

- 检查防火墙设置:临时禁用防火墙测试连接

- 使用高级Docker参数:

bash

docker run -d --name open-webui -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:main

常见问题3:模型下载失败或过慢

症状:从Ollama下载模型时失败或速度极慢。

解决方案:

- 检查网络连接:确保网络稳定

- 使用代理或VPN:若直接连接缓慢,可尝试使用代理

- 命令行下载:有时通过命令行直接下载更稳定

bash

ollama pull mistral:7b-instruct-q4_0 - 更换较小模型:先尝试下载小型模型,如mistral:7b或llama3:8b

常见问题4:内存不足或显存溢出

症状:运行模型时系统变慢或崩溃,出现内存错误。

解决方案:

- 选择较小的量化模型:优先使用q4_0或q5_K_M量化版本

- 关闭其他内存密集型应用

- 增加系统分页文件/交换空间大小

- 限制模型上下文大小:在模型设置中降低上下文长度

常见问题5:GPU不被识别或无法使用

症状:明明有GPU,但模型似乎只使用CPU运行。

解决方案:

- 更新GPU驱动:安装最新版显卡驱动

- 安装CUDA(NVIDIA显卡):确保安装了兼容的CUDA版本

- 验证GPU识别:运行

nvidia-smi(NVIDIA)或rocm-smi(AMD) - 使用GPU版本的Docker镜像:

bash

docker run -d --name open-webui -p 3000:8080 --gpus all -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:cuda

【性能优化】让模型运行更快更稳定

本地运行大模型对系统资源要求较高,以下是一些优化技巧:

硬件优化建议

- 增加内存:将系统内存升级到16GB以上可显著提升性能

- 使用SSD存储:将模型文件存储在SSD上可加快加载速度

- GPU加速:即使是入门级独立显卡也能带来2-5倍性能提升

- 多核心CPU:使用8核心以上CPU可以更好地并行处理

软件优化技巧

-

模型预加载:

bashollama run modelname:tag执行一次后让模型保持在内存中,减少首次对话延迟

-

GPU加速配置:

- Windows/Linux:确保安装最新NVIDIA驱动和CUDA

- 验证GPU是否被识别:

ollama list查看模型信息中是否显示GPU

-

容器资源分配:

- 为Docker分配更多资源(在Docker Desktop设置中调整)

- 使用高级参数启动容器:

bash

docker run -d --name open-webui -p 3000:8080 --gpus all --cpus=4 --memory=8g -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:main

-

模型参数优化:

- 降低温度(Temperature):值设为0.1-0.4可减少随机性

- 减少最大新token数:限制生成长度,节省资源

- 修改Top_P值:一般设置为0.8-0.9最佳

【API集成】使用laozhang.ai中转API增强体验

虽然本地部署提供了隐私和无限使用的优势,但在某些场景下,使用API服务可能获得更好的性能和更丰富的模型选择。laozhang.ai作为专业的API中转服务,提供以下优势:

为什么在某些场景下选择laozhang.ai中转API

- 高性能需求:处理复杂任务或需要最新大模型能力时

- 硬件受限场景:本地设备配置不足以运行大型模型

- 混合使用策略:日常使用本地模型,重要任务使用API模型

- 稳定性与可用性:99.9%的服务可用性,无需担心本地硬件故障

- 先进模型访问:使用最新的GPT-4o和Claude 3.7等模型

laozhang.ai中转API接入Open WebUI

将laozhang.ai API与Open WebUI集成非常简单:

- 访问laozhang.ai注册账号并获取API密钥

- 在Open WebUI设置中添加新的Endpoint

- 选择OpenAI Compatible类型

- 填入以下信息:

- URL:

https://api.laozhang.ai/v1 - API Key: 您的laozhang.ai API密钥

- URL:

- 测试连接并保存

laozhang.ai API价格优势

使用laozhang.ai中转API相比直接使用官方API,可以节省大量成本:

| 模型 | 官方价格 | laozhang.ai价格 | 节省比例 |

|---|---|---|---|

| GPT-4o | 输入$10/百万token 输出$30/百万token | 输入¥25/百万token 输出¥75/百万token | 约65% |

| Claude 3.7 | 输入$15/百万token 输出$75/百万token | 输入¥38/百万token 输出¥188/百万token | 约65% |

🎁 注册laozhang.ai即可获得免费体验金,无需绑定信用卡,可直接体验高级大模型。立即注册

API调用示例

配置好后,可以在Open WebUI界面中直接使用,也可以通过程序调用:

pythonimport openai

openai.api_key = "你的laozhang.ai API密钥"

openai.api_base = "https://api.laozhang.ai/v1"

response = openai.chat.completions.create(

model="gpt-4o-all",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "你好,请介绍一下自己"}

]

)

print(response.choices[0].message.content)

【总结】本地AI部署的最佳实践

通过本指南的完整步骤,你已经成功部署了自己的Open WebUI环境,并配置了与Ollama或LM Studio的连接。让我们回顾几个关键点:

- 选择合适的部署方案:根据个人需求选择Ollama或LM Studio

- 硬件配置与模型匹配:根据电脑配置选择合适大小的模型

- 功能扩展很重要:知识库和联网搜索显著增强AI能力

- 性能优化是关键:通过合理配置获得更好的使用体验

- 混合使用策略:本地模型和API服务结合使用最经济高效

- 定期更新和维护:关注Open WebUI和Ollama的版本更新

未来发展方向

随着开源大模型生态的不断发展,我们可以期待:

- 更多中文优化的高性能模型发布

- 更低的硬件需求(更高效的量化技术)

- 更强大的多模态能力(视觉、语音集成)

- 更完善的本地RAG解决方案

🌟 最后提示:定期备份你的Open WebUI数据目录,防止意外情况导致配置和聊天记录丢失!

【更新日志】持续优化的见证

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-03-15:首次发布完整部署指南 │ │ 2025-03-10:测试最新Open WebUI功能 │ │ 2025-03-05:测试laozhang.ai集成 │ └─────────────────────────────────────┘

🔔 特别说明:本文将持续更新,建议收藏本页面,定期查看最新内容!

如果你在部署过程中遇到任何问题,或有更好的优化建议,欢迎在评论区分享你的经验!