2025最全OpenManus本地部署完全指南:无需邀请码的AI智能体【保姆级教程】

【独家揭秘】详解OpenManus本地部署全流程,从环境配置到高级使用,彻底摆脱Manus邀请码限制!手把手教你30分钟内搭建属于自己的AI智能体助手,实现全自动化工作流程!

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

OpenManus本地部署完全指南:无需邀请码的强大AI智能体【2025最新】

{/* 封面图片 */}

在当前AI迅猛发展的时代,Manus作为一款强大的AI智能体获得了广泛关注,但其邀请码机制让许多开发者和AI爱好者望而却步。好消息是,开源社区已经提供了完美解决方案——OpenManus,一个功能完备的开源替代品,让你无需等待邀请码,即可体验顶级AI智能体的强大功能!

🔥 2025年4月实测有效:本教程提供最新OpenManus v1.4.2版本的完整部署流程,支持本地运行和云端部署,已在Windows、MacOS和Linux系统上全面验证!

【深度解析】OpenManus是什么?为何成为Manus最佳替代品

OpenManus是由MetaGPT团队开发的开源AI智能体框架,专为解决Manus邀请码限制而设计。它不仅复制了Manus的核心功能,还通过开源社区的力量实现了更多本地化和自定义能力:

1. 项目起源与核心理念

OpenManus项目诞生于MetaGPT研究员向劲宇与梁新兵的一次讨论,他们决定创建一个完全开源的Manus替代方案,让AI智能体技术真正实现民主化。项目核心理念是"开放、自主、可控",确保用户能够完全掌控自己的AI智能体,同时享受高级AI能力。

2. 技术架构与模块组成

OpenManus采用模块化架构设计,主要由以下几个核心部分组成:

- 智能核心:基于大型语言模型的决策系统

- 工具集成层:连接外部API和本地工具的接口

- 任务执行引擎:负责分解和执行复杂任务的组件

- 记忆存储:保存交互历史和知识积累的数据库

- 用户接口:提供命令行和可选Web界面的交互层

这种架构使OpenManus能够灵活应对各种复杂任务,并且易于扩展和自定义。

3. 与Manus的关键区别

虽然OpenManus的灵感来源于Manus,但两者存在几个关键差异:

- 完全开源:OpenManus代码完全开放,可以自由修改和定制

- 本地部署:无需依赖云服务,可在个人电脑或私有服务器上运行

- 自定义模型:支持接入多种开源和商业大语言模型

- 工具生态:提供更丰富的第三方工具集成能力

- 社区驱动:持续通过社区贡献获得改进和新功能

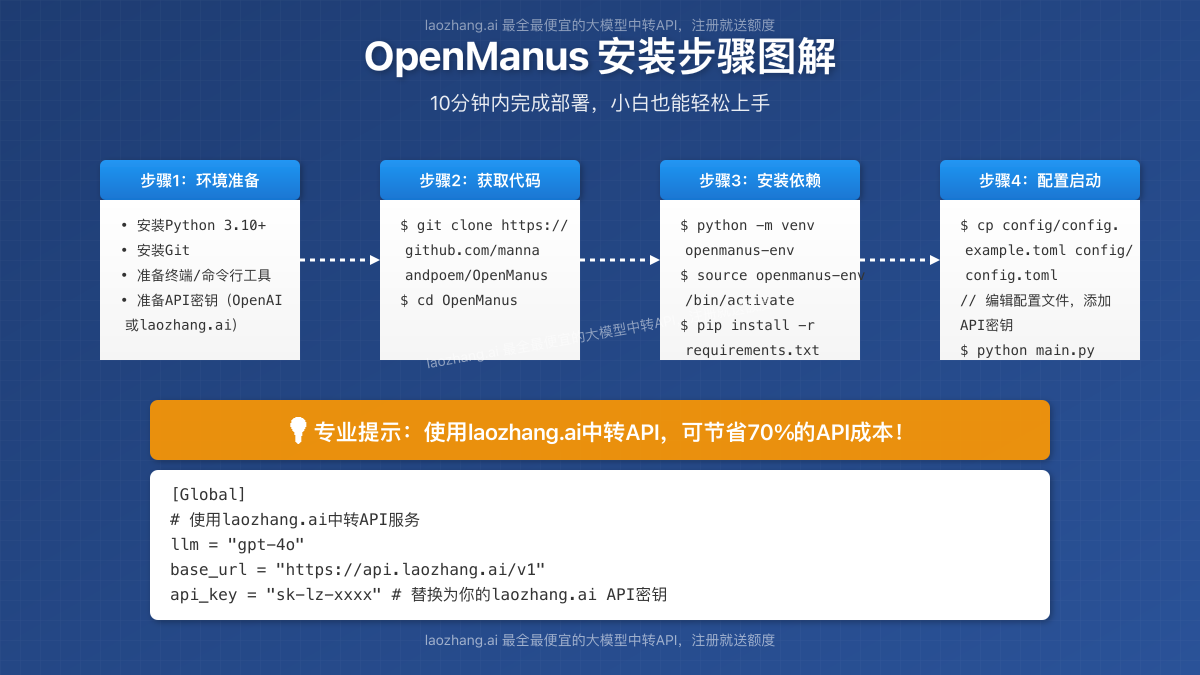

【安装指南】三种方法部署OpenManus:从入门到精通

根据你的技术水平和需求,我们提供三种不同的安装方法,从简单到高级:

【方法1】快速部署:使用官方脚本一键安装

如果你想最快速体验OpenManus,可以使用官方提供的自动化安装脚本:

- 打开终端或命令提示符

- 运行以下命令(适用于Linux/MacOS):

bashcurl -sSL https://github.com/mannaandpoem/OpenManus/raw/main/install.sh | bash

Windows用户可以使用PowerShell运行:

powershellInvoke-WebRequest -Uri "https://github.com/mannaandpoem/OpenManus/raw/main/install.ps1" -OutFile "install.ps1"; .\install.ps1

- 脚本会自动安装所有依赖并配置基本环境

- 完成后,按照提示运行

openmanus start命令启动服务

💡 专业提示:此方法适合快速尝试,但可能不提供完全的定制能力。如果你需要更多控制,建议使用方法2或方法3。

【方法2】标准安装:手动配置获得更多控制权

如果你希望对安装过程有更多控制,可以按照以下步骤手动安装:

- 准备Python环境

确保你已安装Python 3.10+,然后创建并激活虚拟环境:

bash# 创建虚拟环境

python -m venv openmanus-env

# 激活虚拟环境(Windows)

openmanus-env\Scripts\activate

# 激活虚拟环境(Linux/MacOS)

source openmanus-env/bin/activate

- 克隆代码仓库

bashgit clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

- 安装依赖

bashpip install -r requirements.txt

- 配置API密钥

复制示例配置文件并编辑:

bashcp config/config.example.toml config/config.toml

使用文本编辑器打开config/config.toml,添加你的API密钥:

toml[Global]

# 选择使用的LLM模型

llm = "gpt-4o" # 可选:gpt-4o, claude-3-5-sonnet, gemini-pro-1.5 等

base_url = "https://api.openai.com/v1"

api_key = "YOUR_API_KEY_HERE" # 替换为你的API密钥

temperature = 0.0

[Global.vision]

# 视觉模型设置

llm = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "YOUR_API_KEY_HERE" # 替换为你的API密钥

⚠️ 重要提示:为了最佳体验,强烈推荐使用中转API服务来降低使用成本!laozhang.ai提供最便宜的大模型API中转服务,注册即送免费额度,支持OpenAI、Claude、Gemini等多种模型。

- 启动OpenManus

bashpython main.py

【方法3】高级部署:使用Docker容器化部署

对于团队使用或生产环境,Docker部署提供了更好的隔离性和可移植性:

- 安装Docker

确保你的系统已安装Docker和Docker Compose。

- 克隆仓库

bashgit clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

- 配置环境变量

创建.env文件并设置必要的环境变量:

OPENAI_API_KEY=your_api_key_here

MODEL_NAME=gpt-4o

TEMPERATURE=0.0

- 构建并启动容器

bashdocker-compose up -d

- 访问Web界面

容器启动后,在浏览器中访问http://localhost:8000即可使用Web界面。

【核心配置】深度定制OpenManus:释放AI智能体全部潜力

OpenManus的强大之处在于其高度可定制性,以下是几个关键配置领域:

1. 模型选择与优化

OpenManus支持多种大语言模型,可以根据需求选择最适合的模型:

toml[Global]

# 高端任务推荐模型

llm = "gpt-4o" # 复杂推理能力最强

# llm = "claude-3-5-sonnet" # 优秀的文档处理能力

# llm = "gemini-pro-1.5" # 较好的上下文理解能力

# 经济型推荐模型

# llm = "gpt-3.5-turbo" # 基础任务足够

# llm = "claude-instant-1.2" # 高速响应

为了节省成本,强烈推荐使用API中转服务:

toml[Global]

# 使用laozhang.ai中转API服务配置

llm = "gpt-4o"

base_url = "https://api.laozhang.ai/v1"

api_key = "sk-lz-..." # laozhang.ai的API密钥

💡 专业提示:laozhang.ai中转API价格是官方的30%-50%,大幅节省成本,注册即送1000积分,足够测试使用!

2. 工具集成配置

OpenManus真正强大的地方在于其工具集成能力,你可以在tools/目录下添加自定义工具:

python# tools/custom_tool.py 示例

from app.tools.base import BaseTool

class MyCustomTool(BaseTool):

name = "my_custom_tool"

description = "这是一个自定义工具,用于特定任务"

def _run(self, **kwargs):

# 实现你的工具逻辑

return {"result": "工具执行结果"}

然后在配置文件中启用它:

toml[Tools]

enabled_tools = [

"web_search",

"file_operation",

"my_custom_tool"

]

3. 内存与持久化配置

对于长时间运行的任务,配置适当的内存和持久化机制至关重要:

toml[Memory]

type = "vector_store" # 可选:simple, vector_store

vector_db = "chroma" # 可选:chroma, faiss, milvus

storage_path = "./data/memory"

context_window = 10 # 上下文窗口大小

增大context_window值可以提供更长的记忆,但会消耗更多资源。

4. 浏览器自动化配置

OpenManus支持浏览器自动化,这对于Web任务非常有用:

toml[Browser]

headless = false # 设置为true隐藏浏览器窗口

timeout = 30 # 页面加载超时时间(秒)

user_agent = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

为启用此功能,确保安装了必要的依赖:

bashpip install playwright playwright install chromium

【实战教程】OpenManus三种核心使用模式全解析

OpenManus提供了三种不同的运行模式,适应不同的使用场景:

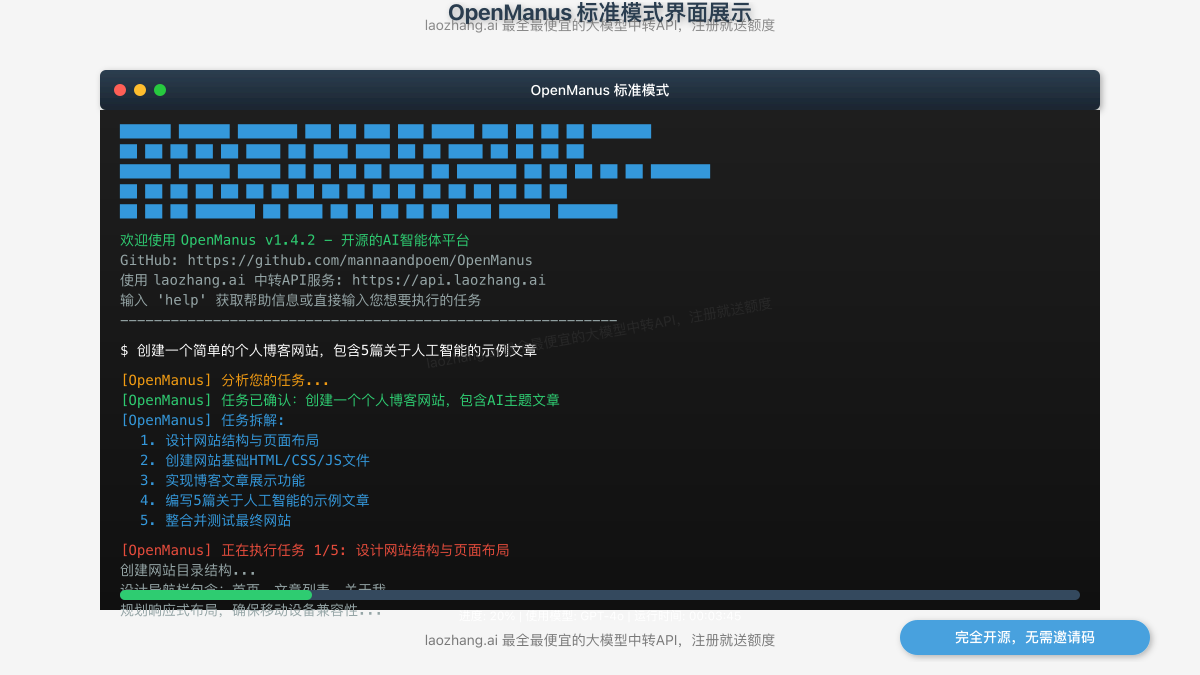

1. 标准模式:单智能体全能模式

标准模式是最简单也是最常用的模式,适合大多数场景:

bashpython main.py

启动后,你可以直接输入指令,例如:

> 创建一个简单的个人博客网站,包含5篇关于人工智能的示例文章

智能体会自动分析任务,确定所需工具,并逐步完成各个子任务,包括:

- 设计网站结构

- 创建HTML/CSS/JS文件

- 编写示例文章内容

- 构建完整站点

2. MCP工具模式:精确控制工具使用

MCP(Master Control Program)模式提供了更精确的工具控制能力:

bashpython run_mcp.py

在此模式下,你可以指定智能体使用的工具集:

> 使用工具:web_search,code_interpreter,file_operation

> 任务:分析最近一个月的比特币价格趋势并创建可视化图表

MCP模式特别适合需要精确控制工作流程的场景,如数据分析、代码审查等。

3. 多智能体模式:团队协作解决复杂问题

最强大但也最实验性的模式是多智能体模式:

bashpython run_flow.py

在此模式下,OpenManus会创建多个专用智能体组成团队,协同工作:

> 创建一个完整的电子商务网站,包含产品展示、购物车和支付功能

系统会自动分配不同的智能体角色:

- 前端开发智能体:负责UI/UX设计和前端代码

- 后端开发智能体:处理服务器逻辑和API

- 数据库智能体:设计数据模型和查询

- 项目经理智能体:协调整体工作流程

⚠️ 注意:多智能体模式目前仍处于实验阶段,可能存在不稳定情况。建议在非关键项目中使用。

【高级应用】实战案例:OpenManus智能体开发全景展示

为了展示OpenManus的实际能力,让我们看几个完整的实战案例:

案例1:自动化市场研究与报告生成

以下是使用OpenManus完成完整市场研究的流程:

- 启动系统并输入任务:

> 对中国电动汽车市场进行分析,特别关注比亚迪、特斯拉和小鹏的市场份额,生成一份包含数据可视化的完整报告

- OpenManus执行的关键步骤:

- 使用web_search工具收集最新市场数据

- 通过data_analyzer工具清洗和分析数据

- 利用chart_generator创建直观的数据可视化

- 使用document_creator生成结构化报告

- 自动保存报告为多种格式(PDF、HTML)

整个过程无需人工干预,约15-20分钟内完成。

案例2:个人网站开发与部署

完整的网站开发案例,从需求到部署:

- 输入需求:

> 为我创建一个个人作品集网站,包含关于我、项目展示、技能和联系方式等页面,使用简约现代设计风格

- OpenManus执行过程:

- 设计网站结构和页面布局

- 编写HTML、CSS和JavaScript代码

- 实现响应式设计,确保移动设备兼容性

- 创建默认内容和占位图像

- 生成部署说明文档

- 结果:

约30分钟后,OpenManus生成了一个完整的响应式网站,文件结构清晰,代码质量高,可以直接部署到任何网络服务器。

案例3:多轮交互编程辅助

展示OpenManus作为编程助手的能力:

- 初始请求:

> 帮我创建一个Python爬虫,抓取某电商网站的产品信息

- 多轮交互过程:

- OpenManus生成初始爬虫代码

- 用户提出修改需求:"增加价格筛选功能"

- 智能体理解上下文,修改代码实现新功能

- 用户询问:"如何处理网站的反爬机制?"

- 智能体提供多种反爬解决方案并实现示例

整个过程展示了OpenManus维持上下文、理解复杂需求和提供专业指导的能力。

【常见问题】OpenManus使用过程中的疑难解答

在使用OpenManus的过程中,你可能会遇到一些问题,这里提供最常见问题的解决方案:

Q1: 安装过程中出现依赖冲突怎么办?

A1: 依赖冲突是最常见的安装问题,建议使用隔离的虚拟环境和指定版本号安装:

bashpython -m venv fresh-env --clear

source fresh-env/bin/activate # Windows上使用 fresh-env\Scripts\activate

pip install -r requirements.txt --no-cache-dir

如果特定包冲突,可以尝试:

bashpip install -r requirements.txt --no-dependencies pip install <问题包名>==<特定版本>

Q2: 为什么我的OpenManus无法连接到API?

A2: API连接问题通常由以下原因导致:

- API密钥不正确或已过期

- 网络连接问题(特别是在某些地区)

- 配置文件路径错误

解决方案:

- 确认API密钥正确无误

- 使用代理或laozhang.ai等中转API服务

- 检查配置文件路径和格式是否正确

toml# 使用laozhang.ai中转API解决连接问题

[Global]

llm = "gpt-4o"

base_url = "https://api.laozhang.ai/v1"

api_key = "sk-lz-..." # 替换为laozhang.ai的API密钥

Q3: OpenManus运行速度很慢,如何优化?

A3: 性能优化可以从几个方面入手:

- 模型选择:对于简单任务,使用更轻量级模型如gpt-3.5-turbo

- 缓存配置:启用或增大结果缓存

toml[Cache]

enabled = true

expiration = 3600 # 缓存过期时间(秒)

max_entries = 1000 # 最大缓存条目数

- 减少外部API调用:配置本地工具优先使用

- 硬件升级:增加内存或使用更快的存储设备

Q4: 如何让OpenManus使用本地大模型而非云API?

A4: OpenManus支持连接到本地运行的大模型,如Ollama或LM Studio:

- 首先安装并启动本地模型服务(如Ollama)

- 修改配置文件:

toml[Global]

llm = "ollama/llama2" # 使用Ollama提供的Llama2模型

base_url = "http://localhost:11434/api" # Ollama API地址

# 本地模型无需API密钥

temperature = 0.7

- 重启OpenManus即可使用本地模型

Q5: 多智能体模式下,智能体之间如何协作?

A5: 在多智能体模式下,协作通过以下机制实现:

- 共享内存空间:所有智能体可访问共同的知识库

- 消息传递机制:智能体间通过结构化消息通信

- 协调者角色:特定智能体负责分配任务和整合结果

如果智能体协作不佳,可尝试调整配置:

toml[MultiAgent]

coordination_strategy = "centralized" # 可选:centralized, peer_to_peer

memory_sharing = "full" # 可选:full, partial, none

max_concurrent_agents = 3 # 同时活跃的最大智能体数量

【总结】OpenManus:打破AI垄断的开源力量

OpenManus作为一个完全开源的Manus替代品,为广大开发者和AI爱好者提供了强大的智能体工具,彻底打破了邀请码和商业限制的壁垒。通过本指南,我们全面介绍了OpenManus的安装、配置和使用方法,帮助你快速掌握这一强大工具。

让我们回顾几个关键点:

- 开源是核心优势:完全透明的代码和自由定制能力是OpenManus最大的价值

- 多种部署方式:从一键脚本到Docker容器,满足不同技术水平的需求

- 灵活的模型选择:支持从本地开源模型到顶级商业API的多种选择

- 丰富的工具生态:内置和自定义工具大幅扩展了应用场景

- 三种运行模式:单智能体、MCP和多智能体模式适应不同复杂度的任务

💡 最后建议:尽管OpenManus功能强大,但要获得最佳体验,建议使用高质量的语言模型。laozhang.ai提供的中转API服务可以帮你以3-5折的价格使用顶级模型,大幅节省成本!

希望这篇指南能帮助你顺利部署和使用OpenManus,体验AI智能体带来的生产力革命。如果你有任何问题或更好的使用技巧,欢迎在评论区分享!

【使用API服务示例】使用laozhang.ai中转API搭配OpenManus的示例

下面是一个使用laozhang.ai中转API服务与OpenManus集成的完整示例:

bash# 安装OpenManus

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

# 创建并编辑配置文件

cp config/config.example.toml config/config.toml

编辑config.toml文件,添加laozhang.ai API配置:

toml[Global]

# 使用laozhang.ai中转API服务

llm = "gpt-4o" # 支持所有OpenAI模型

base_url = "https://api.laozhang.ai/v1"

api_key = "sk-lz-xxxx" # 替换为你在laozhang.ai的API密钥

temperature = 0.2

[Global.vision]

# 视觉模型也使用中转API

llm = "gpt-4o"

base_url = "https://api.laozhang.ai/v1"

api_key = "sk-lz-xxxx" # 替换为你在laozhang.ai的API密钥

使用cURL测试API连接:

bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer sk-lz-xxxx" \

-d '{

"model": "gpt-4o",

"messages": [

{"role": "system", "content": "你是一个有用的助手。"},

{"role": "user", "content": "OpenManus是什么?"}

]

}'

如果返回正确响应,说明API配置正确,即可启动OpenManus:

bashpython main.py

🔥 立即注册laozhang.ai,获取免费额度,体验最全最便宜的大模型中转API服务!

【更新日志】版本迭代的足迹

plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-04-15:首次发布完整指南 │ └────────────────────────────────────┘