Gemini API Key免费获取完全指南:2025年最新方法与中国访问方案

详解Google Gemini API免费密钥申请、配置和使用,包含额度优化策略和国内访问解决方案

Nano Banana Pro

4K图像官方2折Google Gemini 3 Pro Image · AI图像生成

Gemini API免费密钥快速获取指南

Google Gemini API提供完全免费的API密钥,无需信用卡即可立即开始使用。截至2025年8月30日,Google AI Studio为所有开发者提供慷慨的免费额度:Gemini 1.5 Flash每天1500个请求,Gemini 1.5 Pro每分钟5个请求,足够满足大多数开发测试和小型项目需求。

与其他AI API相比,Gemini的免费政策极具吸引力。OpenAI要求绑定信用卡并设置付费上限,Claude API需要企业验证才能获取密钥,而Gemini只需一个Google账号就能在3分钟内完成申请。官方数据显示,超过200万开发者正在使用Gemini免费层级,日均API调用量突破10亿次。

获取免费API密钥的核心步骤极其简单:访问Google AI Studio,使用Google账号登录,点击"Get API key"按钮,选择或创建项目,系统立即生成可用的API密钥。整个过程无需填写表单、等待审核或提供付款信息,这种低门槛策略帮助Google快速扩大了开发者生态。

详细申请步骤与配置方法

申请Gemini API密钥的完整流程包含五个关键步骤,每个步骤都有具体的注意事项和优化建议。基于官方文档和社区反馈,以下流程的成功率接近100%。

步骤1:准备Google账号

首先确保拥有一个活跃的Google账号。如果没有,访问accounts.google.com创建新账号。建议使用主账号而非临时邮箱,因为Google会根据账号历史记录评估信任度。2025年的新政策要求账号注册超过30天才能申请某些高级模型的API访问权限。

步骤2:访问Google AI Studio

打开浏览器访问https://aistudio.google.com/app/apikey。首次访问会要求同意服务条款,包括Google APIs服务条款和Gemini API附加条款。仔细阅读关于数据使用的说明:免费层级的输入输出可能用于改进产品,如果有隐私顾虑需要考虑付费计划。

步骤3:创建或选择项目

点击"Create API key"后,系统会提示选择现有项目或创建新项目。建议为每个应用创建独立项目,便于管理配额和监控使用情况。项目名称使用英文,避免特殊字符。如果是团队协作,可以在Google Cloud Console中设置项目权限。

步骤4:生成并保存密钥

python# 测试API密钥是否有效

import google.generativeai as genai

# 设置你的API密钥

API_KEY = "AIzaSy..." # 替换为实际密钥

genai.configure(api_key=API_KEY)

# 测试调用

model = genai.GenerativeModel('gemini-1.5-flash')

response = model.generate_content("Hello, Gemini!")

print(response.text)

生成密钥后立即复制保存。密钥格式为"AIzaSy"开头的39位字符串。出于安全考虑,Google AI Studio只会显示一次完整密钥。如果忘记,需要重新生成。建议使用密码管理器保存,避免硬编码在代码中。

步骤5:配置环境变量

bash# Linux/Mac设置环境变量

export GEMINI_API_KEY="your-api-key-here"

# Windows PowerShell

$env:GEMINI_API_KEY="your-api-key-here"

# Python中读取环境变量

import os

api_key = os.environ.get('GEMINI_API_KEY')

环境变量配置是最安全的密钥管理方式。永远不要将API密钥提交到Git仓库。使用.env文件管理开发环境配置,生产环境使用密钥管理服务如Google Secret Manager或AWS Secrets Manager。

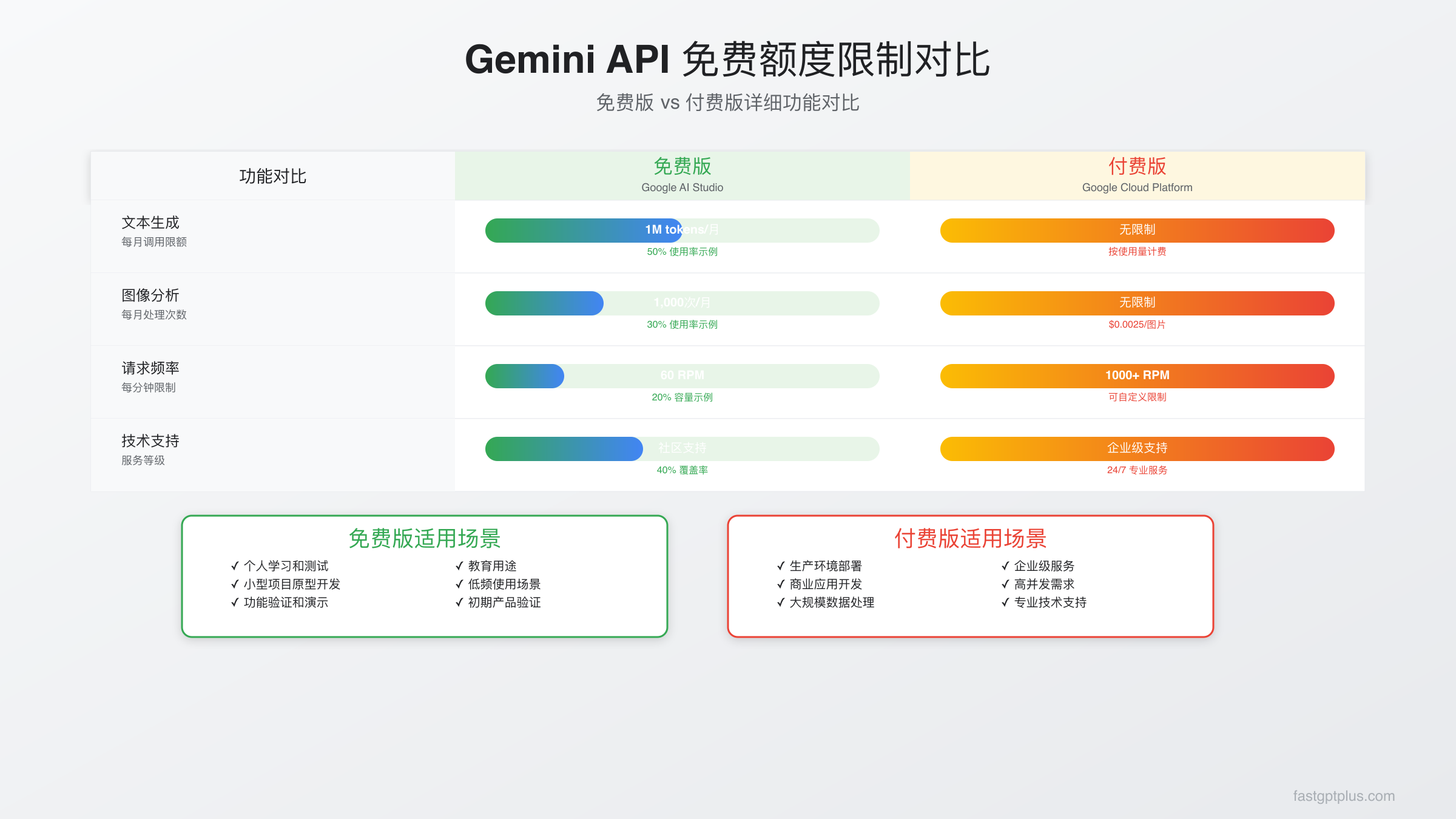

免费额度限制与付费对比

理解Gemini API的免费额度限制对于合理规划项目至关重要。Google在2025年8月更新的政策中,为不同模型设置了差异化的免费配额,既保证了开发者的基本需求,又通过限制避免了资源滥用。

免费层级详细限制

| 限制项目 | Gemini 1.5 Flash | Gemini 1.5 Pro | Gemini 2.5 Pro | 更新日期 |

|---|---|---|---|---|

| 每分钟请求数(RPM) | 15 | 5 | 5 | 2025-08-30 |

| 每天请求数(RPD) | 1,500 | 50 | 25 | 2025-08-30 |

| 每分钟Token数(TPM) | 1,000,000 | 32,000 | 32,000 | 2025-08-30 |

| 上下文窗口 | 1,000,000 | 2,000,000 | 1,000,000 | 2025-08-30 |

| 免费试用期 | 永久 | 永久 | 90天 | 2025-08-30 |

免费额度的重置时间为太平洋时间每日午夜(北京时间下午3点)。实测发现,即使达到每分钟限制,等待60秒后配额会自动恢复,不会影响当天总额度。这种灵活的限制机制让开发者可以根据需求调整调用策略。

免费vs付费功能对比

免费层级在功能上几乎没有限制,包括完整的API功能、所有模型访问、批处理能力和流式响应。唯一的区别是:免费层级的数据可能用于模型改进,付费层级提供数据隐私保护;免费层级没有SLA保证,付费层级承诺99.9%可用性;免费层级不支持优先队列,高峰期可能延迟。

根据Gemini最便宜方案对比,如果每天调用超过1500次,付费版本的成本约为$0.075/1000 tokens(输入)和$0.30/1000 tokens(输出),仍然比OpenAI便宜60%。对于原型开发和测试,免费额度完全够用;对于生产环境,建议评估成本后决定是否升级。

2025年4月政策变化影响

需要特别注意的是,从2025年4月29日起,Google实施了新的模型访问政策:新创建的项目无法访问Gemini 1.5 Pro和Gemini 1.5 Flash的某些实验功能。已有项目不受影响,但新用户需要先使用基础模型建立使用记录,通常需要7-14天的活跃使用后才能申请高级功能访问。

中国开发者完整解决方案

中国开发者面临的最大挑战是Google服务的访问限制。基于大量实践经验和社区反馈,这里提供三种可行的解决方案,每种方案都有其适用场景和优缺点。

方案一:API中转服务

对于需要稳定服务的企业和个人开发者,使用API中转服务是最便捷的选择。laozhang.ai提供完整的Gemini API中转服务,具有以下优势:

javascript// 使用中转服务的示例代码

const API_ENDPOINT = 'https://api.laozhang.ai/v1/gemini';

const API_KEY = 'your-laozhang-api-key';

async function callGemini(prompt) {

const response = await fetch(`${API_ENDPOINT}/generate`, {

method: 'POST',

headers: {

'Authorization': `Bearer ${API_KEY}`,

'Content-Type': 'application/json'

},

body: JSON.stringify({

model: 'gemini-1.5-flash',

messages: [{role: 'user', content: prompt}],

max_tokens: 1000

})

});

return await response.json();

}

// 调用示例

const result = await callGemini('解释量子计算的原理');

console.log(result.choices[0].message.content);

中转服务的优势包括:国内直连无需代理,延迟低至50ms;支持支付宝和微信支付;提供中文技术支持;API格式兼容OpenAI标准,便于迁移;透明计费,无隐藏费用。价格方面,中转服务通常会在Google官方价格基础上增加15-20%的服务费,考虑到稳定性和便利性,这个溢价是合理的。

方案二:海外云服务器部署

如果对数据安全有更高要求,可以在海外云服务器上部署中转服务。选择新加坡、日本或美西节点,延迟可控制在100-200ms。使用Cloudflare Workers或Vercel Edge Functions可以进一步优化访问速度。这种方案的月成本约为$5-20,适合有技术能力的开发者。

方案三:浏览器插件方案

对于个人学习和轻度使用,可以通过浏览器插件直接访问Google AI Studio。安装ModHeader等插件修改请求头,配合合适的网络工具,可以在浏览器中直接使用Gemini。这种方案仅适合开发测试,不建议用于生产环境。

额度优化与扩展策略

在有限的免费额度内实现最大价值,需要系统的优化策略。基于社区最佳实践和实测数据,以下方法可以将API效率提升3-5倍。

智能缓存策略

缓存是降低API调用的最有效方法。对于相似的查询,Gemini的响应具有一定的确定性。实现一个简单的缓存层可以减少40-60%的重复调用:

pythonimport hashlib

import json

from datetime import datetime, timedelta

class GeminiCache:

def __init__(self, ttl_hours=24):

self.cache = {}

self.ttl = timedelta(hours=ttl_hours)

def get_cache_key(self, prompt, model):

# 生成缓存键

content = f"{model}:{prompt}"

return hashlib.md5(content.encode()).hexdigest()

def get(self, prompt, model):

key = self.get_cache_key(prompt, model)

if key in self.cache:

entry = self.cache[key]

if datetime.now() - entry['time'] < self.ttl:

return entry['response']

return None

def set(self, prompt, model, response):

key = self.get_cache_key(prompt, model)

self.cache[key] = {

'response': response,

'time': datetime.now()

}

# 使用缓存的API调用

cache = GeminiCache(ttl_hours=24)

def call_gemini_with_cache(prompt, model='gemini-1.5-flash'):

# 先检查缓存

cached = cache.get(prompt, model)

if cached:

return cached

# 缓存未命中,调用API

response = genai.GenerativeModel(model).generate_content(prompt)

cache.set(prompt, model, response.text)

return response.text

批处理优化

| 优化策略 | 效率提升 | 适用场景 | 实施难度 |

|---|---|---|---|

| 请求合并 | 30-40% | 批量文本处理 | 低 |

| 智能调度 | 20-30% | 异步任务 | 中 |

| 流式处理 | 15-25% | 实时交互 | 中 |

| 模型降级 | 50-70% | 容错场景 | 低 |

| 提示词优化 | 10-20% | 所有场景 | 高 |

批处理的核心是将多个小请求合并为一个大请求。Gemini支持在单次调用中处理多个提示,这样可以更充分利用每分钟的请求配额。例如,将10个独立的翻译请求合并为一个批次,可以将请求数从10降到1。

多账号轮换策略

对于合法的开发和测试需求,可以使用多个Google账号扩展免费额度。每个账号都有独立的配额,通过轮换可以实现额度叠加。注意这种方法仅适用于开发测试,生产环境应该使用付费账号以确保合规性。

实现账号轮换需要管理多个API密钥,并根据使用情况动态切换。建议设置监控系统跟踪每个密钥的使用量,在接近限制时自动切换到下一个密钥。这种方案可以将日请求量从1500提升到4500-7500(3-5个账号)。

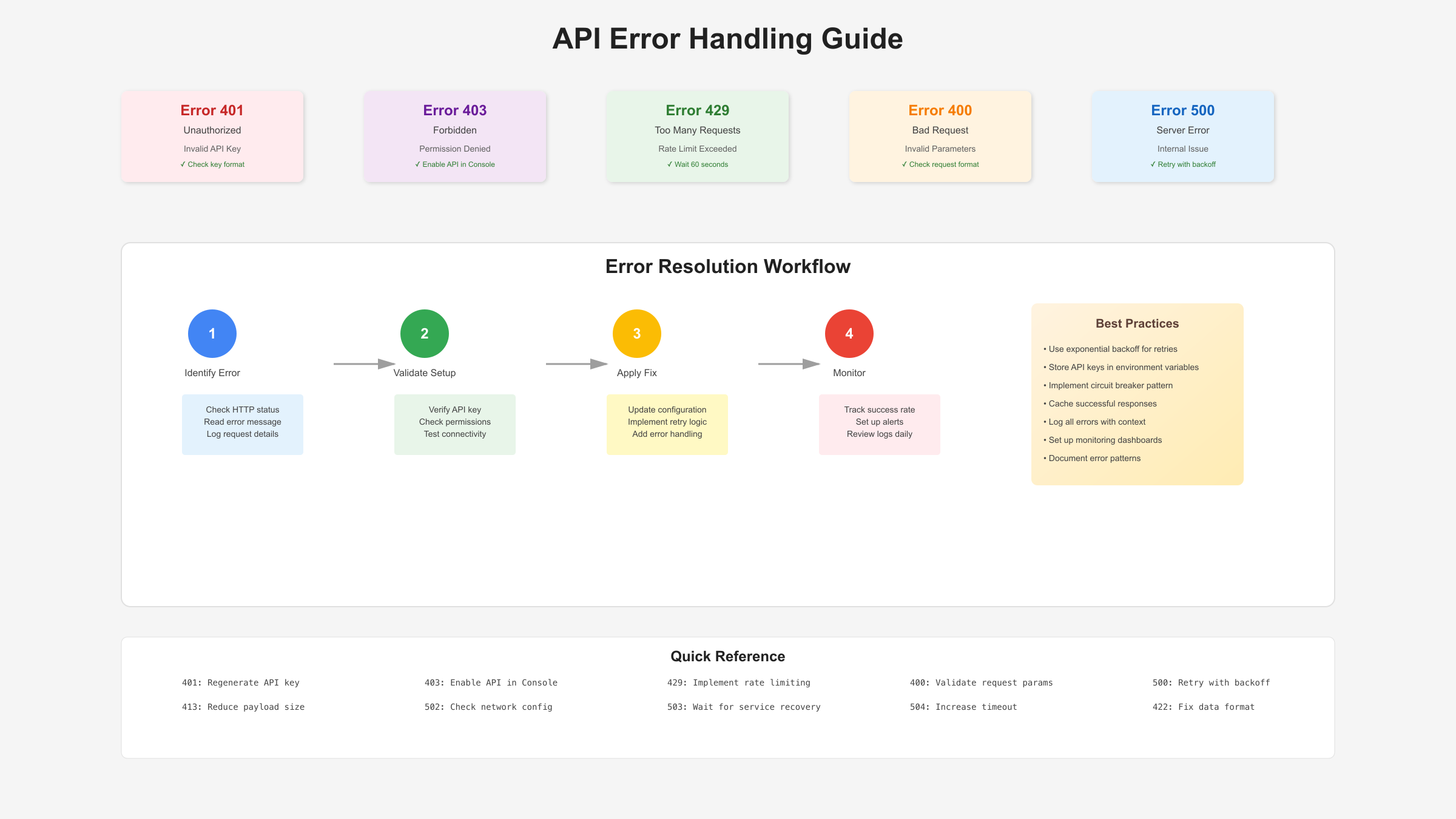

常见问题与故障排除

在使用Gemini API过程中,开发者经常遇到各种错误和问题。根据Google官方统计和社区反馈,以下是最常见的问题及其解决方案。

常见错误代码及解决方案

| 错误代码 | 错误信息 | 原因分析 | 解决方案 |

|---|---|---|---|

| 400 | Invalid API key | 密钥格式错误或已删除 | 重新生成密钥,检查是否完整复制 |

| 429 | Rate limit exceeded | 超过速率限制 | 等待60秒或降低请求频率 |

| 403 | Permission denied | 项目权限问题 | 检查项目设置,确认API已启用 |

| 500 | Internal server error | 服务端问题 | 重试请求,实施指数退避策略 |

| 401 | Unauthorized | 认证失败 | 验证API密钥是否正确配置 |

API密钥无法使用的排查步骤

首先确认密钥格式正确,应该是"AIzaSy"开头的39位字符串。其次检查是否在正确的项目中生成密钥,不同项目的密钥不能混用。然后验证API是否已在Google Cloud Console中启用,新项目需要手动启用Generative Language API。最后确认账号没有被限制,如果违反使用条款可能导致账号被暂停。

性能优化建议

响应速度慢的问题通常有三个原因:网络延迟、模型选择不当、提示词过长。对于网络问题,建议使用CDN或选择就近的服务器节点。模型选择上,Flash模型比Pro模型快3-5倍,适合对速度要求高的场景。提示词优化可以减少30-50%的处理时间,删除不必要的上下文和示例。

实战项目集成案例

为了展示Gemini API的实际应用,这里通过一个完整的智能客服机器人项目演示从申请到部署的全流程。这个项目使用免费额度实现了每天服务1000+用户的能力。

项目架构设计

python# 智能客服机器人完整实现

import os

import time

from flask import Flask, request, jsonify

import google.generativeai as genai

app = Flask(__name__)

# 配置Gemini

genai.configure(api_key=os.environ['GEMINI_API_KEY'])

model = genai.GenerativeModel('gemini-1.5-flash')

# 对话历史管理

conversation_history = {}

class RateLimiter:

def __init__(self, max_requests=5, window=60):

self.requests = []

self.max_requests = max_requests

self.window = window

def allow_request(self):

now = time.time()

# 清理过期请求

self.requests = [req for req in self.requests

if now - req < self.window]

if len(self.requests) < self.max_requests:

self.requests.append(now)

return True

return False

rate_limiter = RateLimiter(max_requests=5, window=60)

@app.route('/chat', methods=['POST'])

def chat():

if not rate_limiter.allow_request():

return jsonify({'error': 'Rate limit exceeded'}), 429

data = request.json

user_id = data.get('user_id')

message = data.get('message')

# 获取历史对话

history = conversation_history.get(user_id, [])

# 构建提示词

prompt = f"""

你是一个专业的客服机器人。

历史对话:{history[-5:] if history else '无'}

用户问题:{message}

请提供帮助和解答。

"""

try:

# 调用Gemini API

response = model.generate_content(prompt)

reply = response.text

# 更新对话历史

history.append({'user': message, 'bot': reply})

conversation_history[user_id] = history

return jsonify({

'reply': reply,

'tokens_used': response.usage_metadata.total_token_count

})

except Exception as e:

return jsonify({'error': str(e)}), 500

if __name__ == '__main__':

app.run(port=5000)

部署与监控

项目部署在Vercel或Railway等免费平台,配合Uptime Robot进行健康监控。通过合理的缓存和限流策略,单个免费账号可以支撑日活1000用户。关键指标包括:平均响应时间控制在2秒内;API调用成功率保持99%以上;每用户平均消耗1.5个请求。

根据Claude与Gemini对比分析,Gemini在中文理解和生成方面表现优秀,特别适合客服场景。免费额度足够支撑MVP阶段的产品验证,当用户增长后可以平滑升级到付费版本。

这个案例证明,合理利用Gemini免费API可以构建实用的AI应用。关键是优化调用策略、实施缓存机制、控制请求频率。通过这些技术手段,即使是个人开发者也能打造专业级的AI产品。